هل تواجه صعوبة في تقييم وتحسين مسارات نماذج اللغة الكبيرة (LLM) الخاصة بك؟ إليك LangWatch، منصة رائدة تجعل من السهل مراقبة وتقييم وضبط سير عمل نماذج اللغة الكبيرة المخصصة لديك. في هذا الدليل، سنتعمق في ماهية LangWatch، ولماذا هي رائعة، وكيفية تثبيتها واستخدامها لتعزيز مشاريع الذكاء الاصطناعي الخاصة بك. سنستعرض إعداد روبوت دردشة بسيط، ودمج LangWatch، واختباره بسؤال نموذجي — كل ذلك مع الحفاظ على سهولة المتابعة. هيا بنا نبدأ!

هل تريد منصة متكاملة وشاملة لفريق المطورين لديك للعمل معًا بأقصى قدر من الإنتاجية؟

Apidog يلبي جميع متطلباتك، ويحل محل Postman بسعر أكثر معقولية!

ما هو LangWatch ولماذا يجب أن تهتم به؟

LangWatch هي منصتك المفضلة لمعالجة مشكلة تقييم نماذج اللغة الكبيرة (LLM) المعقدة. على عكس النماذج التقليدية ذات المقاييس القياسية مثل درجة F1 للتصنيف، أو BLEU للترجمة، أو ROUGE للتلخيص، فإن نماذج اللغة الكبيرة التوليدية غير حتمية ويصعب تحديدها بدقة. بالإضافة إلى ذلك، تمتلك كل شركة بياناتها الخاصة، ونماذجها المضبوطة بدقة، ومسارات عملها المخصصة، مما يجعل التقييم أمرًا صعبًا. هنا تبرز LangWatch!

يتيح لك LangWatch ما يلي:

- التجربة والتحسين: اختبر وحسّن مسارات عمل نماذج اللغة الكبيرة الخاصة بك بسهولة.

- مراقبة الأداء: تتبع سلوك الذكاء الاصطناعي الخاص بك في الوقت الفعلي.

- تقييم النتائج: استخدم مجموعات البيانات والمقيِّمين لقياس الدقة والجودة.

- دعم مسارات العمل المخصصة: يعمل مع بياناتك ونماذجك الفريدة.

سواء كنت تقوم ببناء روبوت دردشة، أو أداة ترجمة، أو تطبيق ذكاء اصطناعي مخصص، يساعدك LangWatch على ضمان تقديم نموذج اللغة الكبيرة الخاص بك لنتائج ممتازة. هل أنت مستعد لرؤيته في العمل؟ دعنا نثبت ونستخدم LangWatch!

دليل خطوة بخطوة لتثبيت واستخدام LangWatch

المتطلبات الأساسية

قبل أن نبدأ، ستحتاج إلى:

- Python 3.8+: لتشغيل المشروع (python.org).

- حساب LangWatch: سجل في app.langwatch.ai.

- مفتاح OpenAI API: لعرض روبوت الدردشة التوضيحي (احصل عليه من platform.openai.com).

- محرر أكواد: VS Code، PyCharm، أو بيئة التطوير المتكاملة المفضلة لديك.

- Git و Docker: اختياري، لإعداد LangWatch محليًا.

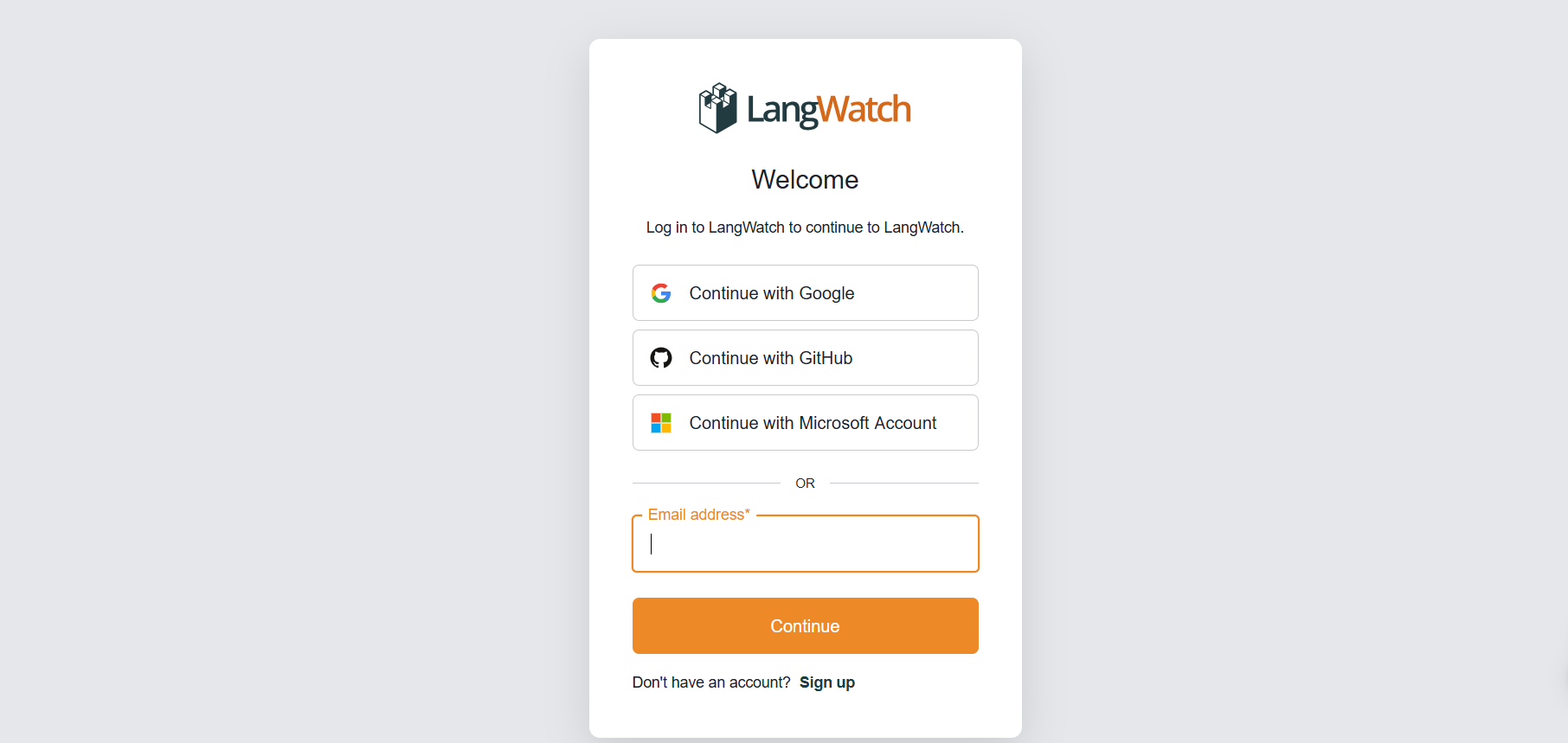

الخطوة 1: التسجيل في LangWatch

إنشاء حساب:

- توجه إلى app.langwatch.ai وسجل للحصول على حساب مجاني.

- سيتم إنشاء مشروع افتراضي باسم “AI Bites” لك. سنستخدمه في هذا البرنامج التعليمي، ولكن يمكنك إنشاء مشروع جديد إذا كنت تفضل ذلك.

الحصول على مفتاح API الخاص بك:

- في لوحة تحكم LangWatch، انتقل إلى Project Settings (إعدادات المشروع) للعثور على

LANGWATCH_API_KEYالخاص بك. ستحتاج إليه لاحقًا.

الخطوة 2: إعداد مشروع بايثون باستخدام LangWatch

لنقم بإنشاء مشروع بايثون ودمج LangWatch لتتبع روبوت دردشة بسيط.

- إنشاء مجلد للمشروع:

- أنشئ دليلًا جديدًا (مثل

langwatch-demo) وانتقل إليه:

mkdir langwatch-demo

cd langwatch-demo

2. إعداد بيئة افتراضية:

- أنشئ بيئة افتراضية وقم بتنشيطها للحفاظ على التبعيات معزولة:

python -m venv venv

source venv/bin/activate # On Windows: venv\Scripts\activate

3. تثبيت LangWatch والتبعيات:

- ثبت LangWatch و Chainlit (لواجهة مستخدم روبوت الدردشة):

pip install langwatch chainlit openai

4. إنشاء كود روبوت الدردشة:

- أنشئ ملفًا باسم

app.pyوالصق هذا الكود لبناء روبوت دردشة بسيط باستخدام نموذج GPT-4o-mini من OpenAI:

import os

import chainlit as cl

import asyncio

from openai import AsyncClient

openai_client = AsyncClient() # Assumes OPENAI_API_KEY is set in environment

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

5. تعيين مفتاح OpenAI API الخاص بك:

- أضف مفتاح OpenAI API الخاص بك كمتغير بيئة:

export OPENAI_API_KEY="your-openai-api-key" # On Windows: set OPENAI_API_KEY=your-openai-api-key

6. تشغيل روبوت الدردشة:

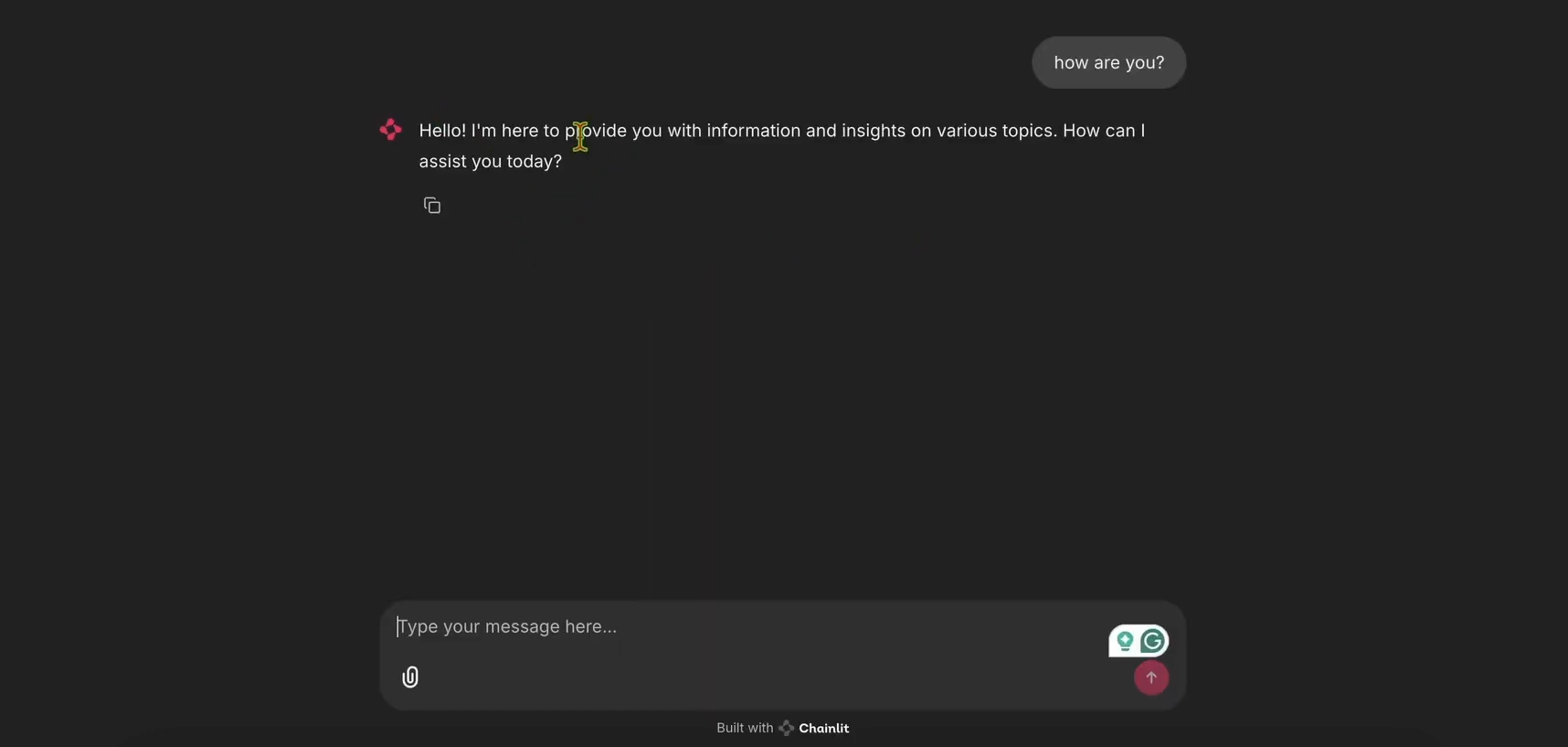

- ابدأ تطبيق Chainlit:

chainlit run app.py

- افتح http://localhost:8000 لرؤية واجهة مستخدم روبوت الدردشة. جربه للتأكد من أنه يعمل!

الخطوة 3: دمج LangWatch للتتبع

الآن، دعنا نضيف LangWatch لتتبع رسائل روبوت الدردشة.

- تعديل

app.pyلـ LangWatch:

- حدّث

app.pyلتضمين LangWatch وأضف المزيّن@langwatch.trace()إلى الدالةmain:

import os

import chainlit as cl

import asyncio

import langwatch

from openai import AsyncClient

openai_client = AsyncClient()

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

@langwatch.trace()

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

2. اختبار التكامل:

- أعد تشغيل تطبيق Chainlit:

chainlit run app.py

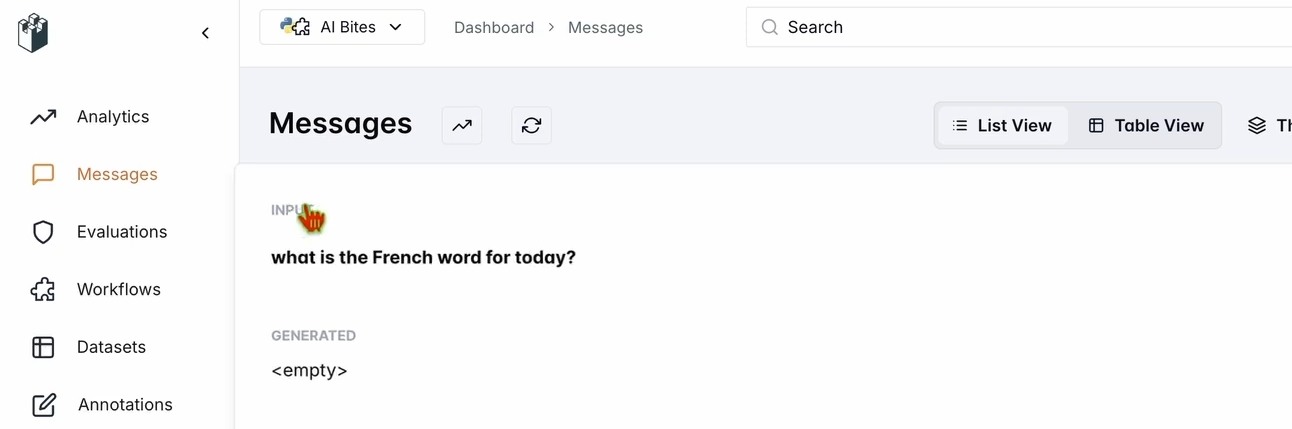

- في واجهة مستخدم روبوت الدردشة، اسأل: "ما هي الكلمة الفرنسية لليوم؟"

- تحقق من لوحة تحكم LangWatch الخاصة بك:

- انتقل إلى app.langwatch.ai.

- حدد Messages (الرسائل) من الشريط الجانبي الأيسر.

- تأكد من تتبع سؤالك واستجابة روبوت الدردشة (مثل "Aujourd’hui! 🇫🇷😊").

الخطوة 4: إعداد سير عمل لتقييم روبوت الدردشة الخاص بك

لنقم بإنشاء مجموعة بيانات ومقيّم في LangWatch لتقييم أداء روبوت الدردشة.

- إنشاء مجموعة بيانات:

- في لوحة تحكم LangWatch، انتقل إلى Datasets (مجموعات البيانات) وانقر على New Dataset (مجموعة بيانات جديدة).

- أضف مجموعة بيانات بسيطة تحتوي على سؤال وإجابة واحدة على الأقل. على سبيل المثال:

| السؤال | الإجابة المتوقعة |

|---|---|

| ما هي الكلمة الفرنسية لليوم؟ | Aujourd’hui |

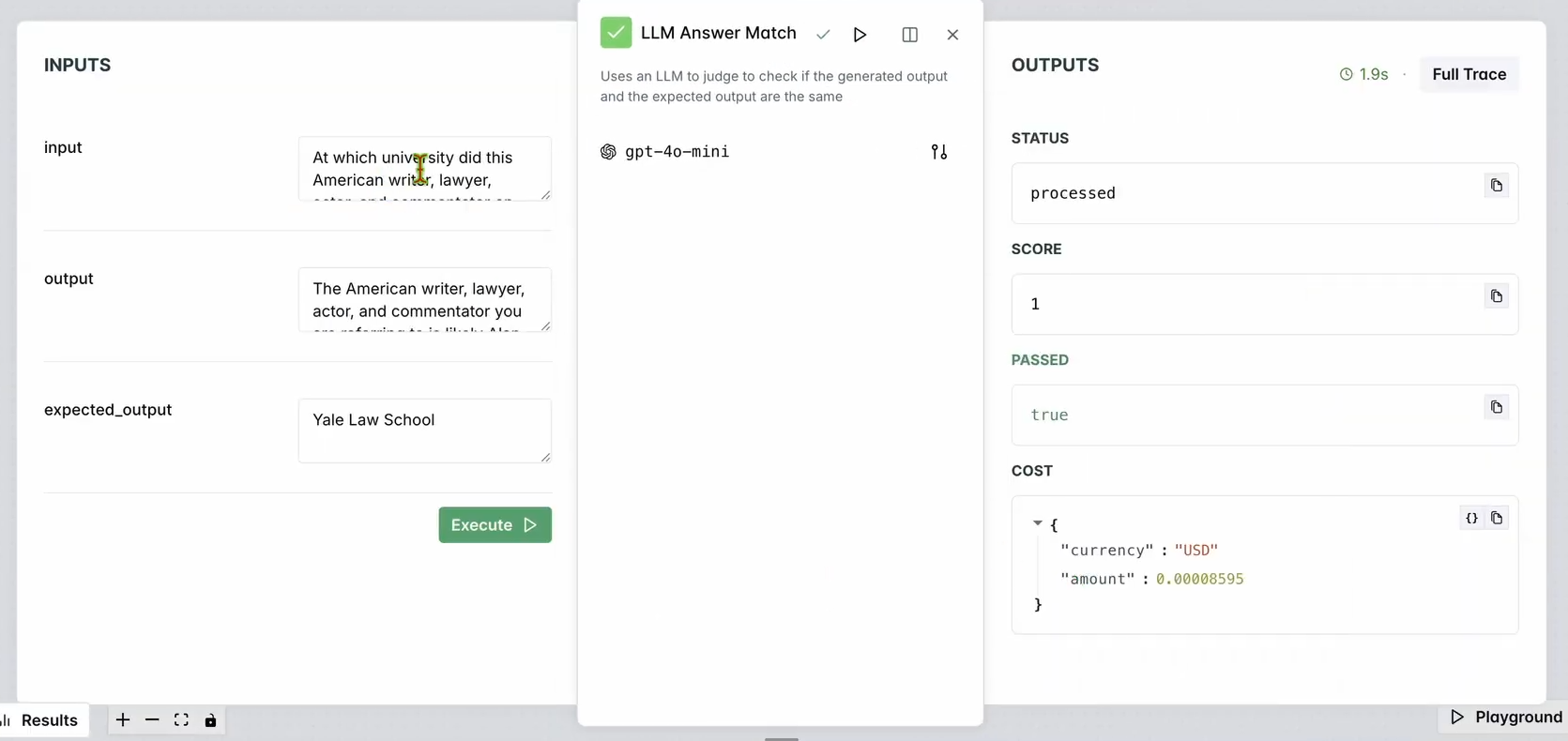

2. إعداد مقيّم:

- انتقل إلى Evaluators (المقيّمون) في لوحة تحكم LangWatch.

- اسحب مقيّم LLM Answer Match (مطابقة إجابة LLM) إلى مساحة العمل.

- قم بتهيئته:

- اضبط Input Question (سؤال الإدخال) على أسئلة الإدخال الخاصة بقاعدة بياناتك (مثل "ما هي الكلمة الفرنسية لليوم؟").

- اضبط Expected Output (الإخراج المتوقع) أيضًا على استجابات قاعدة بياناتك (مثل "Aujourd’hui").

- اختياريًا، قم بتغيير نموذج LLM الخاص بالمقيّم (مثل Llama، Gemini، أو Claude Sonnet) للتنوع.

3. تشغيل المقيّم:

- انقر على Run Workflow Until Here (تشغيل سير العمل حتى هنا) لاختبار المقيّم.

- تحقق من النتائج للتأكد من أن استجابة روبوت الدردشة تتطابق مع الإخراج المتوقع.

يجب أن ترى شيئًا كهذا:

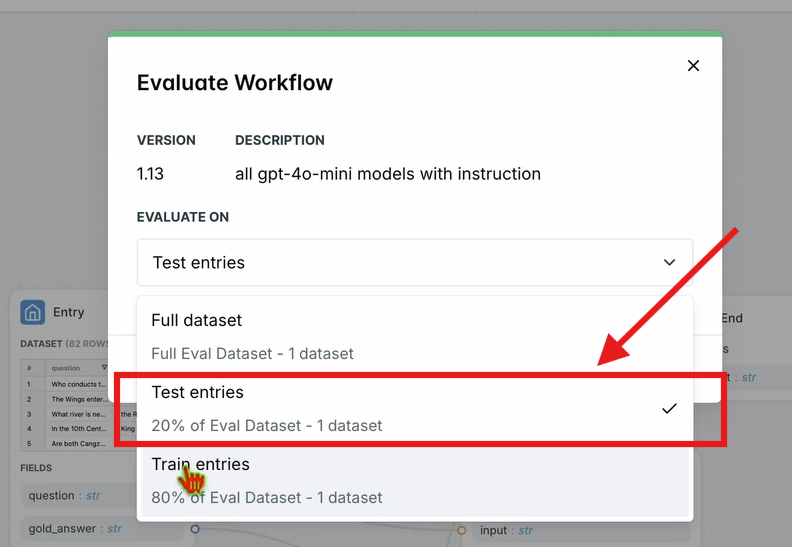

4. تقييم سير العمل:

- في شريط التنقل العلوي، انقر على Evaluate Workflow (تقييم سير العمل) وحدد Test Entries (إدخالات الاختبار).

- يقوم هذا بتقييم سير العمل بأكمله مقابل مجموعة البيانات الخاصة بك. ستظهر النتائج بعد وقت قصير من المعالجة.

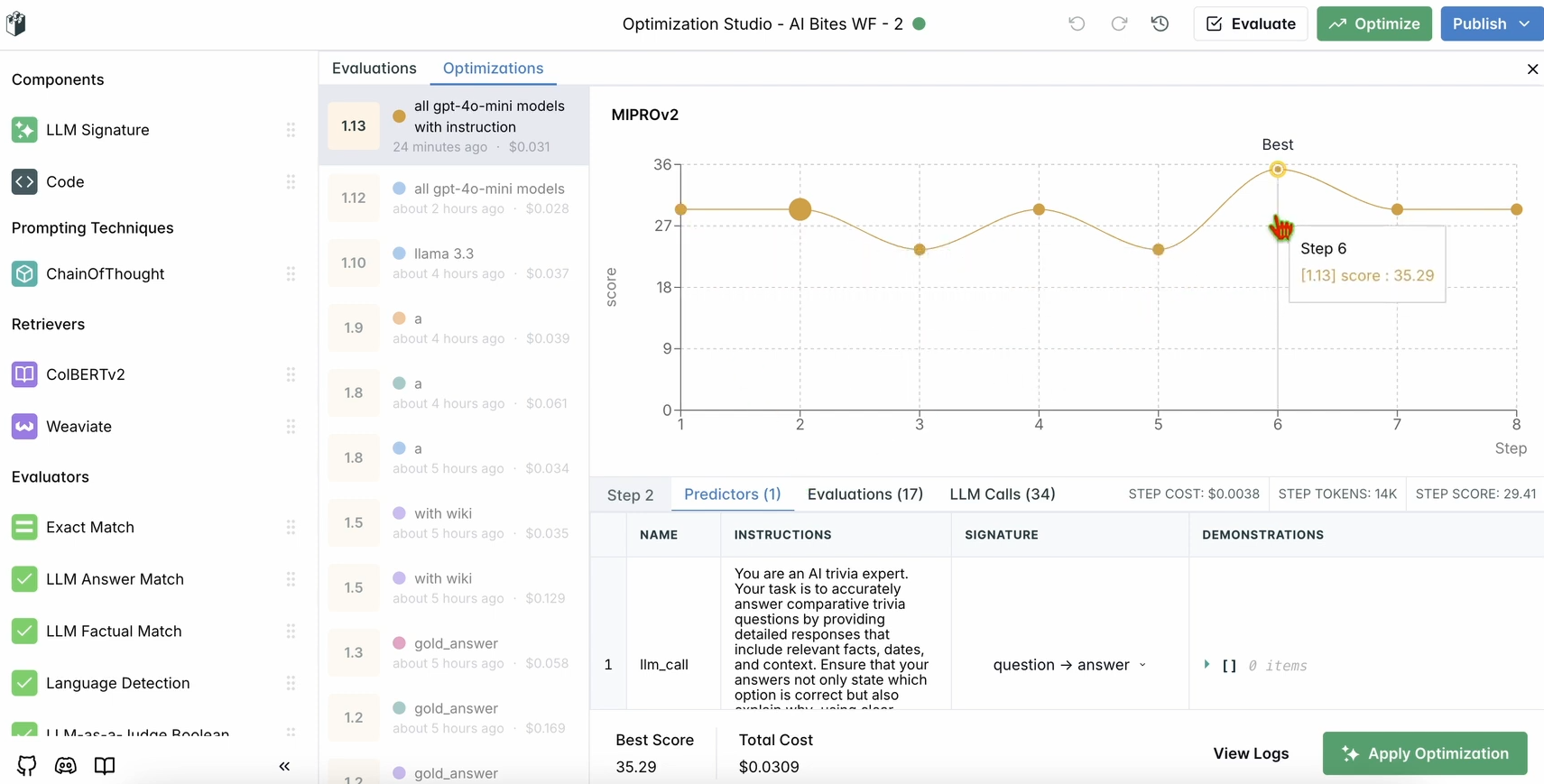

الخطوة 5: تحسين سير عملك

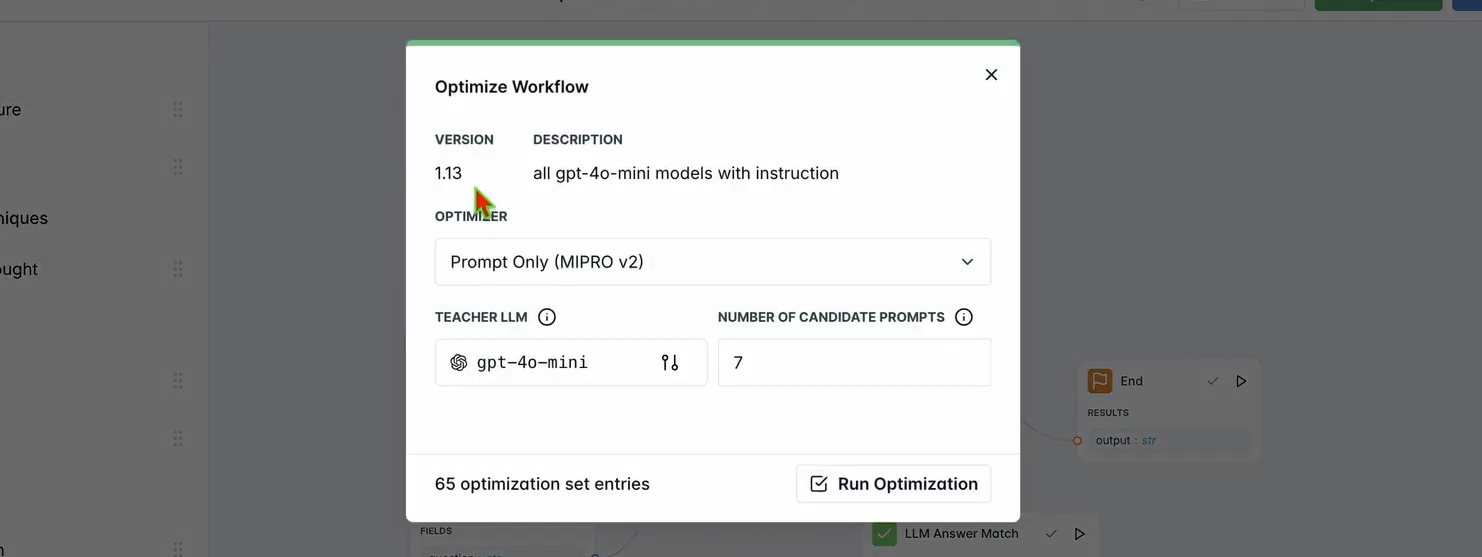

بمجرد اكتمال التقييم، دعنا نحسّن أداء روبوت الدردشة.

1. تشغيل التحسين:

- في لوحة تحكم LangWatch، انقر على Optimize (تحسين) في شريط التنقل العلوي.

- حدد Prompt Only (الموجه فقط) لضبط موجه روبوت الدردشة بدقة.

- انتظر بضع دقائق حتى يكتمل التحسين.

2. التحقق من التحسينات:

- راجع النتائج المحسّنة في لوحة التحكم. يجب أن ترى دقة أو جودة استجابة محسّنة بناءً على اقتراحات LangWatch.

الخطوة 6: إعداد LangWatch محلي اختياري

هل تريد تشغيل LangWatch محليًا للاختبار باستخدام بيانات حساسة؟ اتبع هذه الخطوات:

- استنساخ المستودع:

git clone https://github.com/langwatch/langwatch.git

cd langwatch

2. إعداد البيئة:

- انسخ ملف البيئة المثال:

cp langwatch/.env.example langwatch/.env

3. التشغيل باستخدام Docker:

- ابدأ خادم LangWatch:

docker compose up -d --wait --build

4. الوصول إلى لوحة التحكم:

- افتح http://localhost:5560 للدخول إلى تدفق إعداد LangWatch.

- اتبع الإرشادات لإعداد نسختك المحلية.

ملاحظة: إعداد Docker مخصص للاختبار فقط وغير قابل للتوسع للإنتاج. للإنتاج، استخدم LangWatch Cloud أو Enterprise On-Premises.

لماذا تستخدم LangWatch؟

يحل LangWatch لغز تقييم نماذج اللغة الكبيرة (LLM) من خلال توفير منصة موحدة لمراقبة وتقييم وتحسين مسارات عمل الذكاء الاصطناعي الخاصة بك. سواء كنت تقوم بتعديل الموجهات، أو تحليل الأداء، أو التأكد من أن روبوت الدردشة الخاص بك يقدم إجابات دقيقة (مثل “Aujourd’hui” لكلمة “today” بالفرنسية)، فإن LangWatch يجعل الأمر سهلاً. يعني تكامله مع بايثون وأدوات مثل Chainlit وOpenAI أنه يمكنك البدء في تتبع وتحسين تطبيقات LLM الخاصة بك في دقائق.

على سبيل المثال، يستجيب روبوت الدردشة التجريبي الخاص بنا الآن بانفجارات شبيهة بالتغريدات مع الرموز التعبيرية، ويساعد LangWatch على ضمان دقته وتحسينه. هل تريد التوسع؟ أضف المزيد من الأسئلة إلى مجموعة البيانات الخاصة بك أو جرب نماذج LLM مختلفة في المقيّم.

الخاتمة

ها قد وصلت! لقد تعلمت ما هو LangWatch، وكيفية تثبيته، وكيفية استخدامه لمراقبة وتحسين روبوت الدردشة. من إعداد مشروع بايثون إلى تتبع الرسائل وتقييم الأداء باستخدام مجموعة بيانات، يمكّنك LangWatch من التحكم في مسارات عمل نماذج اللغة الكبيرة الخاصة بك. أظهر سؤالنا التجريبي — "ما هي الكلمة الفرنسية لليوم؟" — مدى سهولة تتبع استجابات الذكاء الاصطناعي وتحسينها.

هل أنت مستعد لرفع مستوى لعبتك في مجال الذكاء الاصطناعي؟ توجه إلى app.langwatch.ai، سجل، وابدأ في التجربة مع LangWatch اليوم.

هل تريد منصة متكاملة وشاملة لفريق المطورين لديك للعمل معًا بأقصى قدر من الإنتاجية؟

Apidog يلبي جميع متطلباتك، ويحل محل Postman بسعر أكثر معقولية!