تعالج نماذج gpt-oss-safeguard من OpenAI هذه الحاجة من خلال تمكين الاستدلال القائم على السياسات لمهام التصنيف. يدمج المهندسون هذه النماذج لتصنيف المحتوى الذي ينشئه المستخدمون، واكتشاف الانتهاكات، والحفاظ على سلامة المنصة.

فهم GPT-OSS-Safeguard: الميزات والقدرات

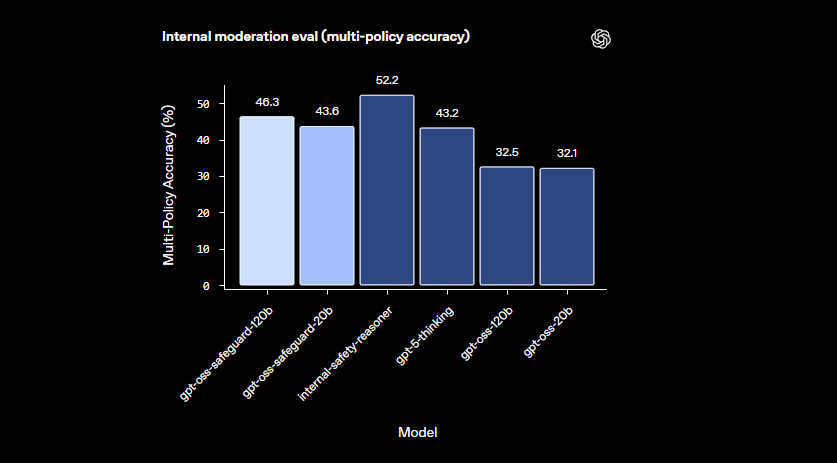

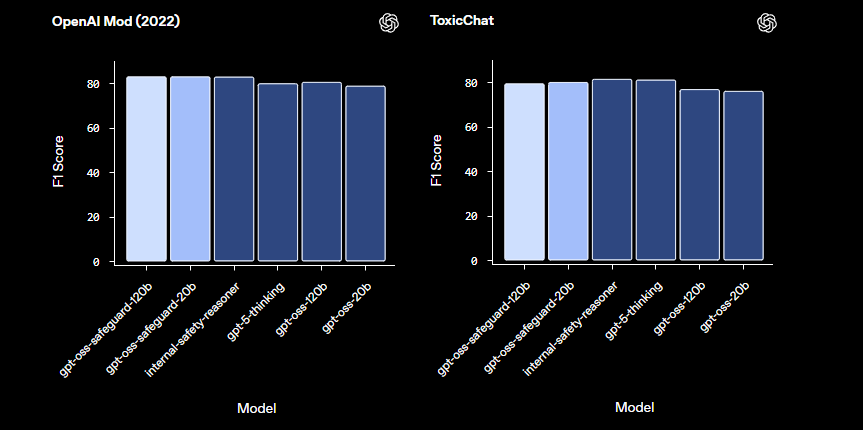

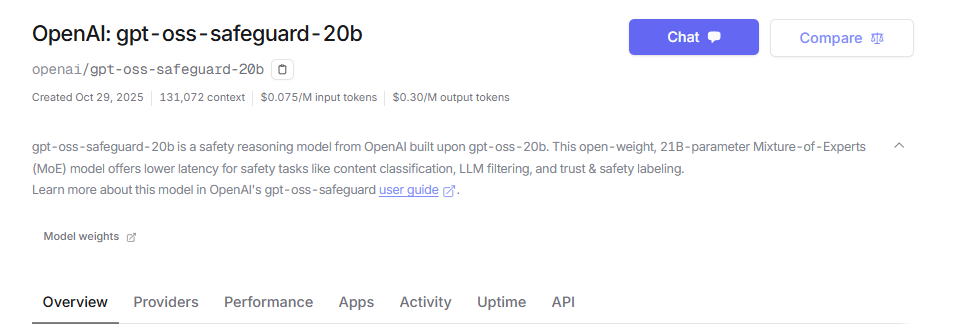

طور مهندسو OpenAI نماذج gpt-oss-safeguard كنماذج استدلال مفتوحة الوزن مصممة خصيصًا لتصنيف السلامة. يقومون بضبط هذه النماذج من أساس gpt-oss، ويطلقونها بموجب ترخيص Apache 2.0. يقوم المطورون بتنزيل النماذج من Hugging Face ونشرها بحرية. تتضمن التشكيلة gpt-oss-safeguard-20b و gpt-oss-safeguard-120b، حيث تشير الأرقام إلى مقاييس المعلمات.

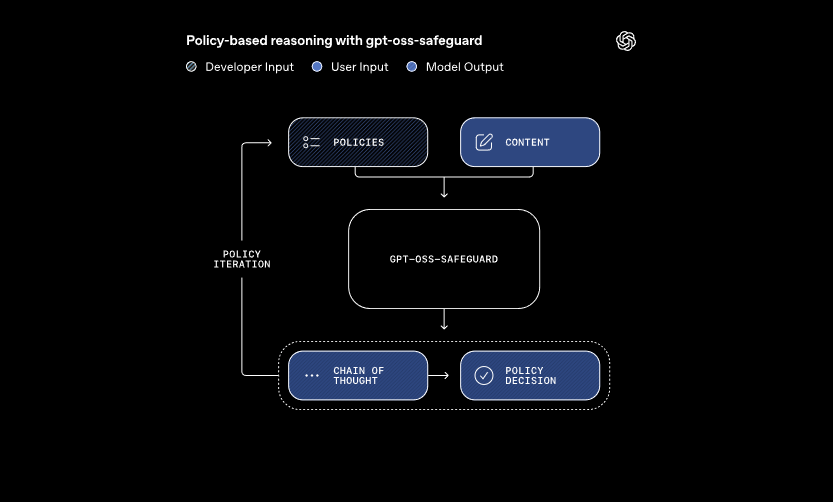

تعالج هذه النماذج مدخلين أساسيين: سياسة يحددها المطور والمحتوى المراد تقييمه. يطبق النظام استدلال "سلسلة التفكير" لتفسير السياسة وتصنيف المحتوى. على سبيل المثال، يحدد ما إذا كانت رسالة المستخدم تنتهك قواعد الغش في منتديات الألعاب. يسمح هذا النهج بتحديثات السياسة الديناميكية دون إعادة التدريب، وهو ما تتطلبه المصنفات التقليدية.

علاوة على ذلك، يدعم gpt-oss-safeguard سياسات متعددة في وقت واحد. يقوم المطورون بإدخال عدة قواعد في استدعاء استدلال واحد، ويقوم النموذج بتقييم المحتوى مقابل جميع هذه القواعد. تعمل هذه الإمكانية على تبسيط سير العمل للمنصات التي تتعامل مع مخاطر متنوعة، مثل المعلومات المضللة أو الكلام الضار. ومع ذلك، قد ينخفض الأداء قليلاً مع إضافة سياسات، لذلك تقوم الفرق باختبار التكوينات بدقة.

تتفوق النماذج في المجالات الدقيقة حيث تتعثر المصنفات الأصغر. إنها تتعامل مع الأضرار الناشئة من خلال التكيف مع السياسات المنقحة بسرعة. بالإضافة إلى ذلك، يوفر مخرج "سلسلة التفكير" الشفافية — حيث يراجع المطورون مسار الاستدلال لتدقيق القرارات. تثبت هذه الميزة أنها لا تقدر بثمن لفرق الامتثال التي تتطلب ذكاءً اصطناعيًا قابلاً للتفسير.

مقارنة بنماذج السلامة الجاهزة مثل LlamaGuard، يقدم gpt-oss-safeguard تخصيصًا أكبر. إنه يتجنب التصنيفات الثابتة، مما يمكّن المؤسسات من تحديد عتباتها الخاصة. وبالتالي، فإن التكامل يناسب مهندسي الثقة والسلامة الذين يبنون خطوط أنابيب إشراف قابلة للتطوير. الآن بعد أن فهمنا الأساسيات، دعنا ننتقل إلى إعداد البيئة.

إعداد بيئتك للوصول إلى واجهة برمجة تطبيقات GPT-OSS-Safeguard

يبدأ المطورون بإعداد أنظمتهم لتشغيل gpt-oss-safeguard. نظرًا لأن النماذج مفتوحة الوزن، يمكنك نشرها محليًا أو عبر موفري الاستضافة. تتسع هذه المرونة لإعدادات الأجهزة المختلفة، من الأجهزة الشخصية إلى الخوادم السحابية.

أولاً، قم بتثبيت التبعيات الضرورية. يعمل Python 3.10 أو أعلى كأساس. استخدم pip لإضافة مكتبات مثل Hugging Face Transformers: pip install transformers. للاستدلال المسرع، قم بتضمين torch مع دعم CUDA إذا كنت تمتلك وحدة معالجة رسومات متوافقة. يقوم المهندسون الذين لديهم أجهزة NVIDIA بتمكين هذا لمعالجة أسرع.

بعد ذلك، قم بتنزيل النماذج من Hugging Face. قم بالوصول إلى المجموعة. اختر gpt-oss-safeguard-20b لاحتياجات الموارد الأخف أو gpt-oss-safeguard-120b للحصول على دقة فائقة. يسترجع الأمر transformers-cli download openai/gpt-oss-safeguard-20b الملفات.

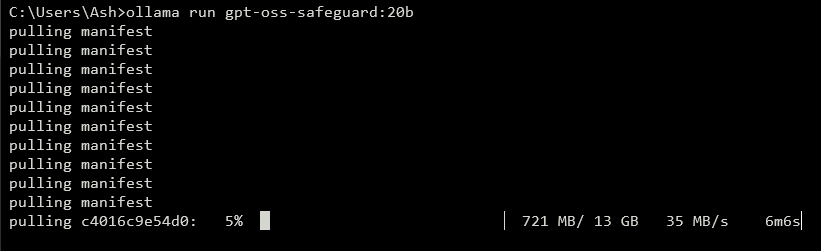

لكشف واجهة برمجة تطبيقات (API)، قم بتشغيل خادم محلي. تتعامل أدوات مثل vLLM مع هذا بكفاءة. قم بتثبيت vLLM باستخدام pip install vllm. ثم، قم بتشغيل الخادم: vllm serve openai/gpt-oss-safeguard-20b. يبدأ هذا الأمر نقطة نهاية متوافقة مع OpenAI على http://localhost:8000/v1. وبالمثل، يبسط Ollama النشر: ollama run gpt-oss-safeguard:20b. ويوفر واجهات برمجة تطبيقات REST للتكامل.

للاختبار المحلي، يقدم LM Studio واجهة سهلة الاستخدام. قم بتنفيذ lms get openai/gpt-oss-safeguard-20b لجلب النموذج. يحاكي البرنامج واجهة برمجة تطبيقات OpenAI's Chat Completions، مما يسمح بانتقالات سلسة للتعليمات البرمجية إلى الإنتاج.

الخيارات المستضافة تزيل مخاوف الأجهزة. يدعم موفرون مثل Groq نموذج gpt-oss-safeguard-20b من خلال واجهة برمجة التطبيقات الخاصة بهم. قم بالتسجيل في https://console.groq.com، وقم بإنشاء مفتاح API، واستهدف النموذج في الطلبات. تبدأ الأسعار من 0.075 دولار لكل مليون رمز إدخال. OpenRouter يستضيفه أيضًا.

بمجرد الإعداد، تحقق من التثبيت. أرسل طلب اختبار عبر curl: curl http://localhost:8000/v1/chat/completions -H "Content-Type: application/json" -d '{"model": "openai/gpt-oss-safeguard-20b", "messages": [{"role": "system", "content": "Test policy"}, {"role": "user", "content": "Test content"}]}'. تؤكد الاستجابة الناجحة الجاهزية. بعد تكوين البيئة، تقوم بصياغة السياسات بعد ذلك.

صياغة سياسات فعالة لـ GPT-OSS-Safeguard

تشكل السياسات العمود الفقري لعمليات gpt-oss-safeguard. يكتبها المطورون كأوامر منظمة توجه التصنيف. تعمل السياسة المصممة جيدًا على زيادة قوة استدلال النموذج، مما يضمن مخرجات دقيقة وقابلة للتفسير.

قم بهيكلة سياستك بأقسام مميزة. ابدأ بالتعليمات، مع تحديد مهام النموذج. على سبيل المثال، وجهه لتصنيف المحتوى على أنه ينتهك (1) أو آمن (0). اتبع ذلك بالتعريفات، لتوضيح المصطلحات الرئيسية مثل "اللغة اللاإنسانية". ثم، حدد المعايير للانتهاكات والمحتوى الآمن. أخيرًا، قم بتضمين الأمثلة — قدم 4-6 حالات على الحدود مصنفة وفقًا لذلك.

استخدم صيغة المبني للمعلوم في السياسات: "وضع علامة على المحتوى الذي يروج للعنف" بدلاً من البدائل السلبية. حافظ على دقة اللغة؛ تجنب الغموض مثل "غير آمن بشكل عام". إذا نشأت تعارضات بين القواعد، فحدد الأسبقية بوضوح. لسيناريوهات السياسات المتعددة، قم بدمجها في رسالة النظام.

تحكم في عمق الاستدلال عبر معلمة "reasoning_effort": اضبطها على "high" للحالات المعقدة أو "low" للسرعة. يفصل تنسيق التناغم، المدمج في gpt-oss-safeguard، الاستدلال عن المخرج النهائي. يضمن هذا استجابات API نظيفة مع الحفاظ على مسارات التدقيق.

قم بتحسين طول السياسة حوالي 400-600 رمز. السياسات الأقصر تخاطر بالتبسيط المفرط، بينما قد تربك السياسات الأطول النموذج. اختبر بشكل متكرر: صنف محتوى عينة وقم بتحسينه بناءً على المخرجات. تساعد أدوات مثل عدادات الرموز في Hugging Face هنا.

بالنسبة لتنسيقات الإخراج، اختر ثنائيًا للتبسيط: Return exactly 0 or 1. أضف مبررًا للعمق: {"violation": 1, "rationale": "Explanation here"}. يتكامل هيكل JSON هذا بسهولة مع الأنظمة اللاحقة. بينما تقوم بتحسين السياسات، انتقل إلى تنفيذ واجهة برمجة التطبيقات.

تنفيذ استدعاءات API باستخدام GPT-OSS-Safeguard

يتفاعل المطورون مع gpt-oss-safeguard من خلال نقاط نهاية متوافقة مع OpenAI. سواء كانت محلية أو مستضافة، تتبع العملية أنماط إكمال الدردشة القياسية.

قم بإعداد عميلك. في Python، استورد OpenAI: from openai import OpenAI. قم بالتهيئة باستخدام عنوان URL الأساسي والمفتاح: client = OpenAI(base_url="http://localhost:8000/v1", api_key="dummy") للمحلي، أو قيم خاصة بالمزود.

قم بإنشاء الرسائل. يحمل دور النظام السياسة: {"role": "system", "content": "Your detailed policy here"}. يحتوي دور المستخدم على المحتوى: {"role": "user", "content": "Content to classify"}.

استدعِ واجهة برمجة التطبيقات: completion = client.chat.completions.create(model="openai/gpt-oss-safeguard-20b", messages=messages, max_tokens=500, temperature=0.0). تضمن درجة الحرارة عند 0 مخرجات حتمية لمهام السلامة.

حلل الاستجابة: result = completion.choices[0].message.content. للمخرجات المنظمة، استخدم تحليل JSON. يعزز Groq هذا من خلال التخزين المؤقت للمطالبات — أعد استخدام السياسات عبر الاستدعاءات لخفض التكاليف بنسبة 50%.

تعامل مع البث للحصول على تعليقات في الوقت الفعلي: اضبط stream=True وكرر عبر الأجزاء. يناسب هذا الإشراف عالي الحجم.

ادمج الأدوات إذا لزم الأمر، على الرغم من أن gpt-oss-safeguard يركز على التصنيف. حدد الوظائف في معلمة tools للحصول على قدرات موسعة، مثل جلب البيانات الخارجية.

راقب استخدام الرموز: يتضمن الإدخال السياسة بالإضافة إلى المحتوى، وتضيف المخرجات الاستدلال. حدد max_tokens لمنع تجاوز السعة. بعد إتقان الاستدعاءات، استكشف الأمثلة.

الميزات المتقدمة في واجهة برمجة تطبيقات GPT-OSS-Safeguard

يقدم gpt-oss-safeguard أدوات متقدمة للتحكم الدقيق. يعيد التخزين المؤقت للمطالبات على Groq استخدام السياسات، مما يقلل من زمن الوصول والتكاليف.

اضبط reasoning_effort في رسالة النظام: "Reasoning: high" للتحليل العميق. يتعامل هذا مع المحتوى الغامض بشكل أفضل.

استفد من نافذة السياق البالغة 128 ألفًا للمحادثات أو المستندات الطويلة. قم بتغذية المحادثات بأكملها للتصنيف الشامل.

ادمج مع الأنظمة الأكبر: وجه المخرجات إلى قوائم انتظار التصعيد أو التسجيل. استخدم webhooks للتنبيهات في الوقت الفعلي.

قم بضبط دقيق إضافي إذا لزم الأمر، على الرغم من أن الأساس يتفوق في اتباع السياسات. ادمج مع نماذج أصغر للتصفية المسبقة، مما يحسن الحوسبة.

المسائل الأمنية: قم بتأمين مفاتيح API وراقب حقن المطالبات. تحقق من صحة المدخلات لمنع الاستغلال.

التوسع: انشر على مجموعات باستخدام vLLM لتحقيق إنتاجية عالية. يقدم موفرون مثل Groq أكثر من 1000 رمز في الثانية.

ترفع هذه الميزات gpt-oss-safeguard من مصنف أساسي إلى أداة مؤسسية. ومع ذلك، اتبع أفضل الممارسات للحصول على أفضل النتائج.

أفضل الممارسات والتحسين لـ GPT-OSS-Safeguard

يقوم المهندسون بتحسين gpt-oss-safeguard عن طريق تكرار السياسات. اختبر باستخدام مجموعات بيانات متنوعة، وقياس الدقة عبر مقاييس مثل F1-score.

وازن حجم النموذج: استخدم 20b للسرعة، 120b للدقة. قم بتكميم الأوزان لتقليل استهلاك الذاكرة.

راقب الأداء: سجل مسارات الاستدلال للتدقيقات. اضبط درجة الحرارة بشكل ضئيل — 0.0 يناسب الاحتياجات الحتمية.

تعامل مع القيود: قد يواجه النموذج صعوبة في المجالات المتخصصة للغاية؛ استكمل ببيانات المجال.

ضمان الاستخدام الأخلاقي: قم بمواءمة السياسات مع اللوائح. تجنب التحيزات عن طريق تنويع الأمثلة.

التحديث بانتظام: مع تطور OpenAI لـ gpt-oss-safeguard، قم بدمج التحسينات.

إدارة التكلفة: لواجهات برمجة التطبيقات المستضافة، تتبع إنفاق الرموز. تقلل عمليات النشر المحلية النفقات.

من خلال تطبيق هذه الممارسات، يمكنك زيادة الكفاءة. باختصار، يمكّن gpt-oss-safeguard أنظمة سلامة قوية.

الخاتمة: دمج GPT-OSS-Safeguard في سير عملك

يستفيد المطورون من gpt-oss-safeguard لبناء مصنفات سلامة قابلة للتكيف. من الإعداد إلى الاستخدام المتقدم، يزودك هذا الدليل بالمعرفة التقنية. قم بتنفيذ السياسات، ونفذ استدعاءات API، وحسنها لتلبية احتياجاتك. مع تطور المنصات، يتكيف gpt-oss-safeguard بسلاسة، مما يضمن بيئات آمنة.