مرحباً، يا عشاق الذكاء الاصطناعي! استعدوا لأن Open AI أطلقت للتو قنبلة مع نموذجها الجديد مفتوح الوزن، GPT-OSS-120B، وهو يثير ضجة في مجتمع الذكاء الاصطناعي. تم إصدار هذا النموذج القوي بموجب ترخيص Apache 2.0، وهو مصمم لمهام التفكير والبرمجة والمهام الوكيلية، وكل ذلك أثناء تشغيله على وحدة معالجة رسوميات واحدة (GPU). في هذا الدليل، سنتعمق في ما يجعل GPT-OSS-120B مميزًا، ومعاييره البارزة، وتسعيره المعقول، وكيف يمكنك استخدامه عبر واجهة برمجة تطبيقات OpenRouter. دعونا نستكشف هذه الجوهرة مفتوحة المصدر ونبدأ في البرمجة بها في وقت قصير!

هل تريد منصة متكاملة وشاملة لفريق المطورين لديك للعمل معًا بأقصى إنتاجية؟

Apidog يلبي جميع متطلباتك، ويحل محل Postman بسعر أكثر بكثير!

ما هو GPT-OSS-120B؟

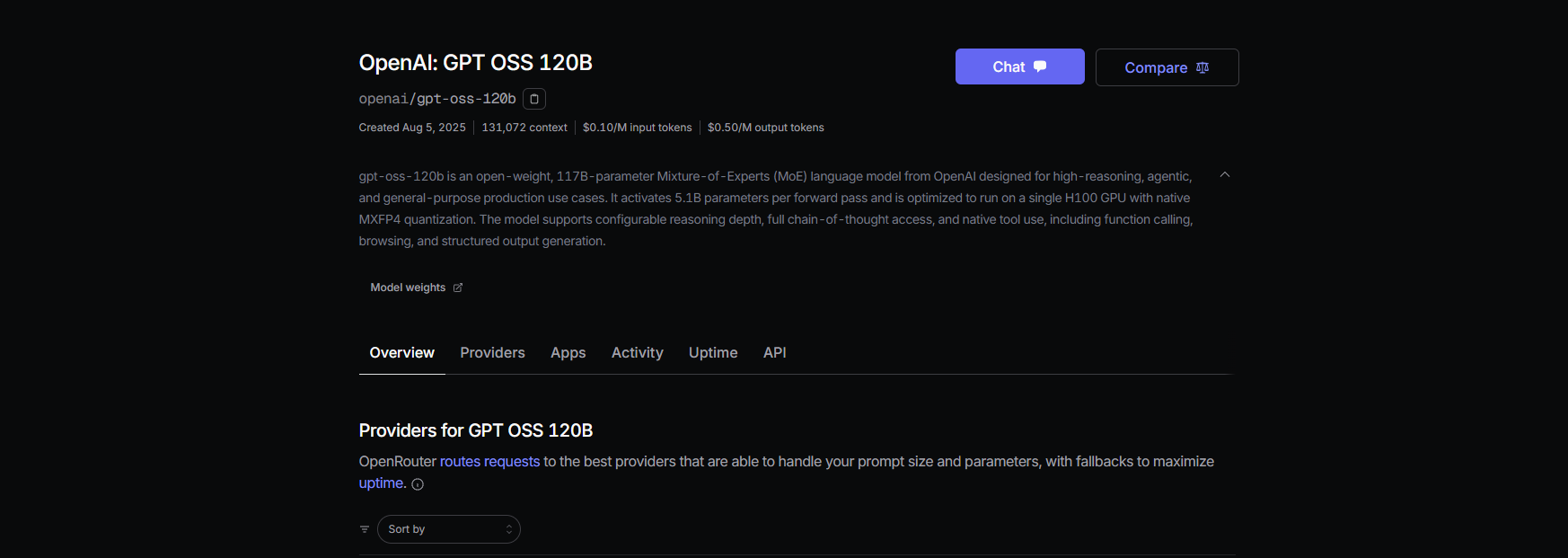

إن GPT-OSS-120B من Open AI هو نموذج لغوي يضم 117 مليار معلمة (مع 5.1 مليار معلمة نشطة لكل رمز)، وهو جزء من سلسلة GPT-OSS الجديدة مفتوحة الوزن، إلى جانب النموذج الأصغر GPT-OSS-20B. تم إصداره في 5 أغسطس 2025، وهو نموذج "مزيج من الخبراء" (MoE) مُحسّن للكفاءة، ويعمل على وحدة معالجة رسوميات NVIDIA H100 واحدة أو حتى على أجهزة المستهلك مع تقنية MXFP4 quantization. لقد تم تصميمه لمهام مثل التفكير المعقد، وتوليد الأكواد، واستخدام الأدوات، مع نافذة سياق ضخمة تبلغ 128 ألف رمز – تخيل 300-400 صفحة من النص! بموجب ترخيص Apache 2.0، يمكنك تخصيصه أو نشره أو حتى تسويقه تجاريًا، مما يجعله حلمًا للمطورين والشركات التي تتوق إلى التحكم والخصوصية.

المعايير: كيف يقارن GPT-OSS-120B؟

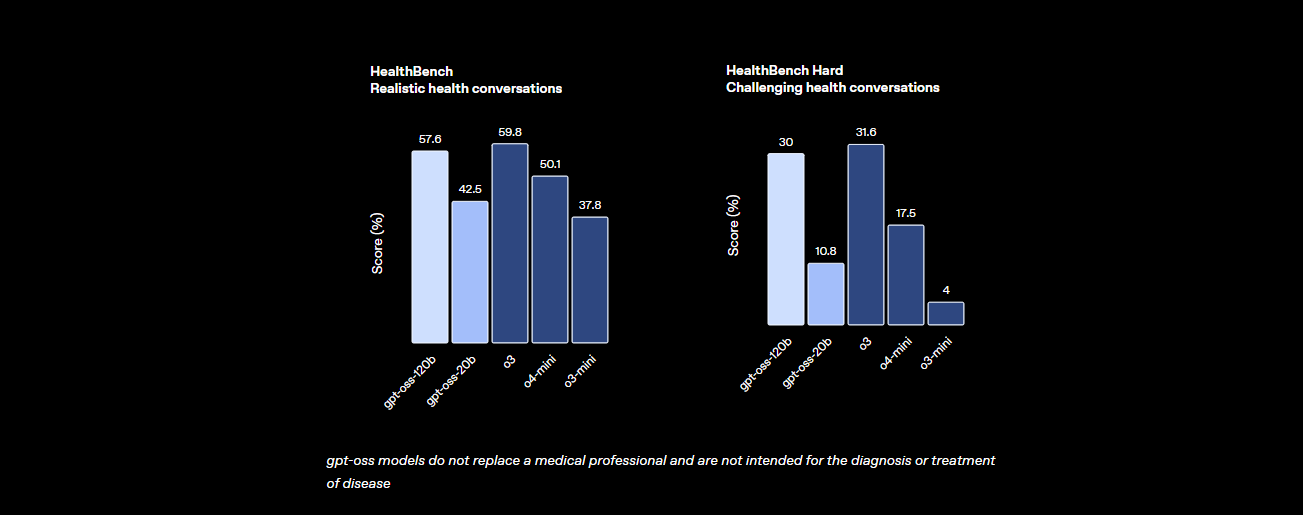

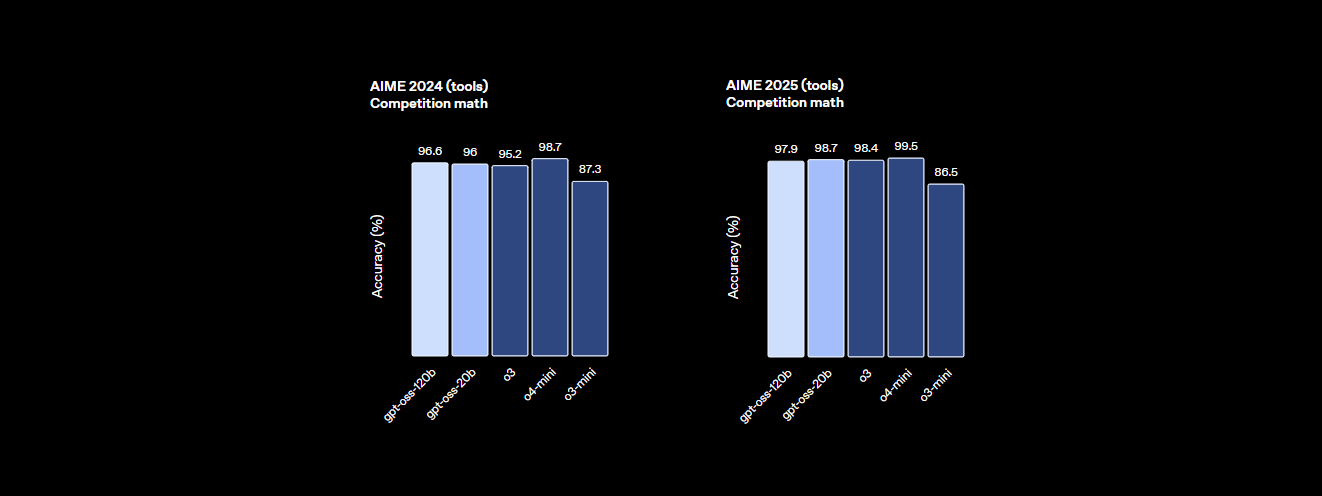

إن GPT-OSS-120B لا يستهان به عندما يتعلق الأمر بالأداء. تُظهر معايير Open AI أنه منافس جاد للنماذج الاحتكارية مثل o4-mini الخاص بهم وحتى Claude 3.5 Sonnet. إليك التفاصيل:

- قوة التفكير: يحقق 94.2% في MMLU (فهم اللغة متعدد المهام الضخم)، وهو أقل بقليل من 95.1% لـ GPT-4، ويحقق 96.6% في مسابقات AIME للرياضيات، متفوقًا على العديد من النماذج المغلقة.

- براعة البرمجة: في Codeforces، يتمتع بتقييم Elo يبلغ 2622، ويحقق معدل نجاح 87.3% في HumanEval لتوليد الأكواد، مما يجعله أفضل صديق للمبرمج.

- الصحة واستخدام الأدوات: يتجاوز o4-mini في HealthBench للاستفسارات المتعلقة بالصحة ويتفوق في المهام الوكيلية مثل TauBench، بفضل قدراته على التفكير المتسلسل (CoT) واستدعاء الأدوات.

- السرعة: على وحدة معالجة رسوميات H100، يعالج 45 رمزًا في الثانية، بينما يصل مزودون مثل Cerebras إلى 3,000 رمز/ثانية للاحتياجات ذات الحجم الكبير. يقدم OpenRouter حوالي 500 رمز/ثانية، متفوقًا على العديد من النماذج المغلقة.

تُظهر هذه الإحصائيات أن GPT-OSS-120B يكاد يتساوى مع النماذج الاحتكارية عالية المستوى بينما هو مفتوح المصدر وقابل للتخصيص. إنه وحش في الرياضيات والبرمجة وحل المشكلات العامة، مع تضمين الأمان من خلال الضبط الدقيق العدائي للحفاظ على المخاطر منخفضة.

التسعير: معقول وشفاف

أحد أفضل الأجزاء حول GPT-OSS-120B؟ إنه فعال من حيث التكلفة، خاصة مقارنة بالنماذج الاحتكارية. إليك كيفية تفصيل الأسعار عبر المزودين الرئيسيين، بناءً على البيانات الحديثة لنافذة سياق بحجم 131 ألف رمز:

- النشر المحلي: قم بتشغيله على أجهزتك الخاصة (مثل وحدة معالجة رسوميات H100 أو إعداد بذاكرة فيديو 80 جيجابايت) بتكلفة API صفرية. يكلف إعداد GMKTEC EVO-X2 حوالي 2000 يورو ويستهلك أقل من 200 واط، وهو مثالي للشركات الصغيرة التي تعطي الأولوية للخصوصية.

- Baseten: 0.10 دولار/مليون رمز إدخال، 0.50 دولار/مليون رمز إخراج. زمن الاستجابة: 0.20 ثانية، الإنتاجية: 491.1 رمز/ثانية. أقصى إخراج: 131 ألف رمز.

- Fireworks: 0.15 دولار/مليون رمز إدخال، 0.60 دولار/مليون رمز إخراج. زمن الاستجابة: 0.56 ثانية، الإنتاجية: 258.9 رمز/ثانية. أقصى إخراج: 33 ألف رمز.

- Together: 0.15 دولار/مليون رمز إدخال، 0.60 دولار/مليون رمز إخراج. زمن الاستجابة: 0.28 ثانية، الإنتاجية: 131.1 رمز/ثانية. أقصى إخراج: 131 ألف رمز.

- Parasail: 0.15 دولار/مليون رمز إدخال، 0.60 دولار/مليون رمز إخراج (FP4 quantization). زمن الاستجابة: 0.40 ثانية، الإنتاجية: 94.3 رمز/ثانية. أقصى إخراج: 131 ألف رمز.

- Groq: 0.15 دولار/مليون رمز إدخال، 0.75 دولار/مليون رمز إخراج. زمن الاستجابة: 0.24 ثانية، الإنتاجية: 1,065 رمز/ثانية. أقصى إخراج: 33 ألف رمز.

- Cerebras: 0.25 دولار/مليون رمز إدخال، 0.69 دولار/مليون رمز إخراج. زمن الاستجابة: 0.42 ثانية، الإنتاجية: 1,515 رمز/ثانية. أقصى إخراج: 33 ألف رمز. مثالي للاحتياجات عالية السرعة، حيث يصل إلى 3,000 رمز/ثانية في بعض الإعدادات.

مع GPT-OSS-120B، تحصل على أداء عالٍ بجزء بسيط من تكلفة GPT-4 (حوالي 20.00 دولار/مليون رمز)، مع مزودين مثل Groq و Cerebras الذين يقدمون إنتاجية فائقة السرعة للتطبيقات في الوقت الفعلي.

كيفية استخدام GPT-OSS-120B مع Cline عبر OpenRouter

هل ترغب في تسخير قوة GPT-OSS-120B لمشاريع البرمجة الخاصة بك؟ بينما لا يدعم Claude Desktop و Claude Code التكامل المباشر مع نماذج OpenAI مثل GPT-OSS-120B بسبب اعتمادها على نظام Anthropic البيئي، يمكنك بسهولة استخدام هذا النموذج مع Cline، وهو إضافة مجانية ومفتوحة المصدر لـ VS Code، عبر واجهة برمجة تطبيقات OpenRouter. بالإضافة إلى ذلك، قامت Cursor مؤخرًا بتقييد خيار إحضار مفتاحك الخاص (BYOK) للمستخدمين غير المحترفين، مما يقفل ميزات مثل وضعي الوكيل والتحرير خلف اشتراك شهري بقيمة 20 دولارًا، مما يجعل Cline بديلاً أكثر مرونة لمستخدمي BYOK. إليك كيفية إعداد GPT-OSS-120B مع Cline و OpenRouter، خطوة بخطوة.

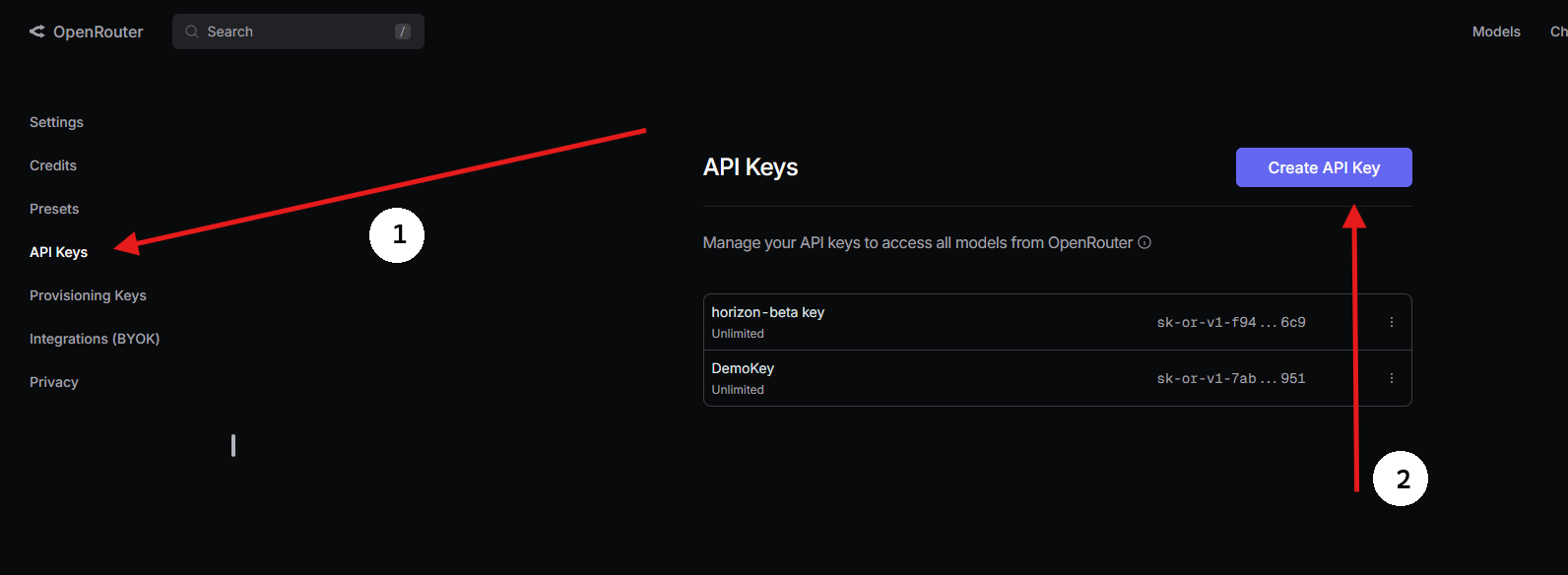

الخطوة 1: الحصول على مفتاح API لـ OpenRouter

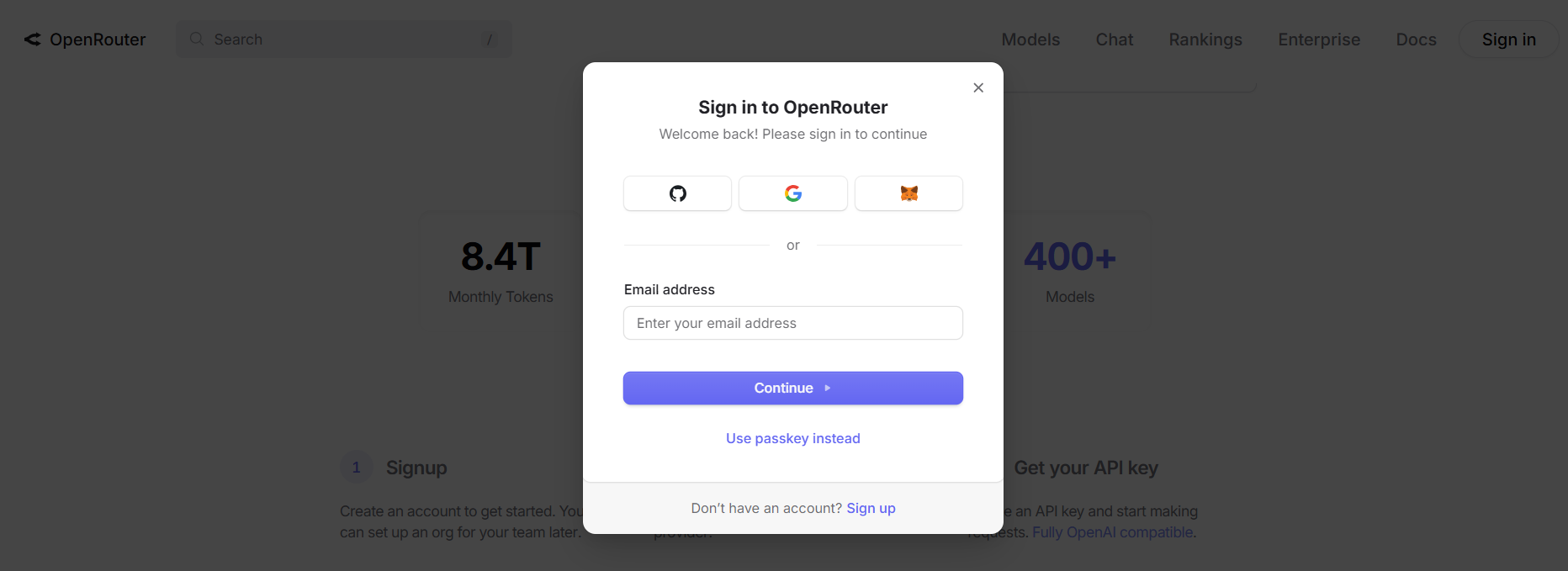

- التسجيل في OpenRouter:

- قم بزيارة openrouter.ai وأنشئ حسابًا مجانيًا باستخدام Google أو GitHub.

2. العثور على GPT-OSS-120B:

- في علامة التبويب النماذج، ابحث عن “gpt-oss-120b” واختره.

3. توليد مفتاح API:

- انتقل إلى قسم المفاتيح، انقر على إنشاء مفتاح API، سمّه (على سبيل المثال، “GPT-OSS-Cursor”)، وانسخه. احفظه بأمان.

الخطوة 2: استخدام Cline في VS Code مع BYOK

للوصول غير المقيد إلى BYOK، يعد Cline (إضافة مفتوحة المصدر لـ VS Code) بديلاً رائعًا لـ Cursor. يدعم GPT-OSS-120B عبر OpenRouter دون قيود على الميزات. إليك كيفية إعداده:

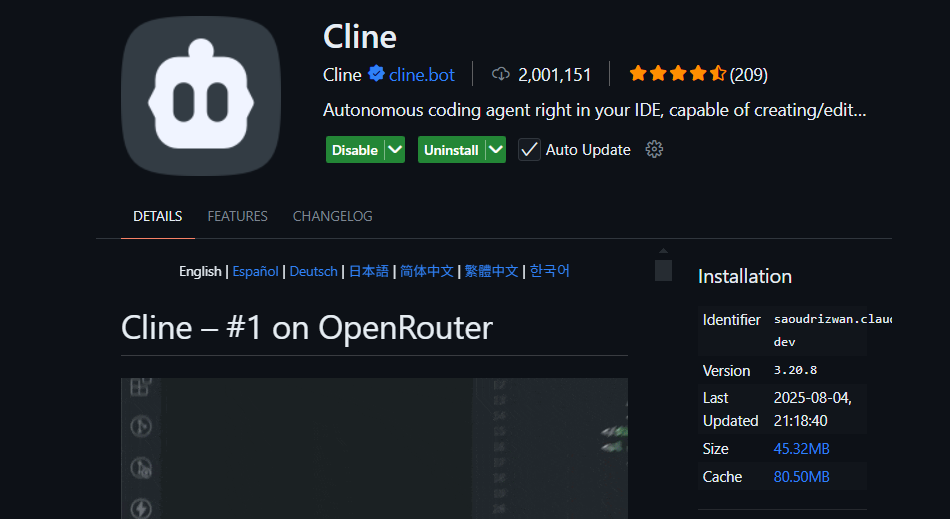

- تثبيت Cline:

- افتح VS Code (code.visualstudio.com).

- انتقل إلى لوحة الإضافات (

Ctrl+Shift+XأوCmd+Shift+X). - ابحث عن “Cline” وقم بتثبيته (بواسطة nickbaumann98، github.com/cline/cline).

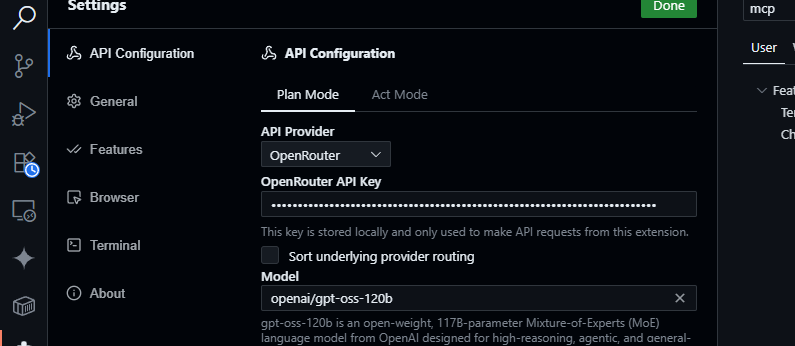

2. تكوين OpenRouter:

- افتح لوحة Cline (انقر على أيقونة Cline في شريط الأنشطة).

- انقر على أيقونة الترس في لوحة Cline.

- اختر OpenRouter كمزود.

- الصق مفتاح API الخاص بـ OpenRouter.

- اختر

openai/gpt-oss-120bكنموذج.

3. حفظ واختبار:

- احفظ الإعدادات. في لوحة دردشة Cline، جرب:

أنشئ دالة JavaScript لتحليل بيانات JSON.

- توقع استجابة مثل:

function parseJSON(data) {

try {

return JSON.parse(data);

} catch (e) {

console.error("Invalid JSON:", e.message);

return null;

}

}

- اختبر استعلامات قاعدة الأكواد:

لخص src/api/server.js

- سيقوم Cline بتحليل مشروعك وإرجاع ملخص، مستفيدًا من نافذة سياق GPT-OSS-120B التي تبلغ 128 ألف رمز.

لماذا Cline بدلاً من Cursor أو Claude؟

- لا يوجد تكامل مع Claude: Claude Desktop و Claude Code مقتصران على نماذج Anthropic (مثل Claude 3.5 Sonnet) ولا يدعمان نماذج OpenAI مثل GPT-OSS-120B بسبب قيود النظام البيئي.

- قيود BYOK في Cursor: حظر Cursor الأخير لخيار BYOK للمستخدمين غير المحترفين يعني أنه لا يمكنك الوصول إلى وضعي الوكيل أو التحرير بدون اشتراك شهري بقيمة 20 دولارًا، حتى مع مفتاح API صالح لـ OpenRouter. Cline ليس لديه مثل هذه القيود، ويوفر وصولاً كاملاً للميزات مجانًا باستخدام مفتاح API الخاص بك.

- الخصوصية والتحكم: يرسل Cline الطلبات مباشرة إلى OpenRouter، متجاوزًا خوادم الطرف الثالث (على عكس توجيه Cursor عبر AWS)، مما يعزز الخصوصية.

نصائح استكشاف الأخطاء وإصلاحها

- مفتاح API غير صالح؟ تحقق من مفتاحك في لوحة تحكم OpenRouter وتأكد من أنه نشط.

- النموذج غير متاح؟ تحقق من قائمة نماذج OpenRouter للبحث عن openai/gpt-oss-120b. إذا كان مفقودًا، جرب مزودين مثل Fireworks AI أو اتصل بدعم OpenRouter.

- استجابات بطيئة؟ تأكد من استقرار اتصالك بالإنترنت. للحصول على أداء أسرع، فكر في نماذج أخف مثل GPT-OSS-20B.

- أخطاء Cline؟ قم بتحديث Cline عبر لوحة الإضافات وتحقق من السجلات في لوحة الإخراج في VS Code.

لماذا تستخدم GPT-OSS-120B؟

يُعد نموذج GPT-OSS-120B تغييرًا جذريًا للمطورين والشركات، حيث يقدم مزيجًا مقنعًا من الأداء والمرونة وفعالية التكلفة. إليك سبب تميزه:

- حرية المصدر المفتوح: مرخص بموجب Apache 2.0، يمكنك ضبط GPT-OSS-120B أو نشره أو تسويقه تجاريًا دون قيود، مما يمنحك تحكمًا كاملاً في سير عمل الذكاء الاصطناعي الخاص بك.

- توفير التكاليف: قم بتشغيله محليًا على وحدة معالجة رسوميات H100 واحدة أو أجهزة المستهلك (ذاكرة فيديو 80 جيجابايت) بتكلفة API صفرية. عبر OpenRouter، التسعير تنافسي للغاية بحوالي 0.50 دولار/مليون رمز إدخال و 2.00 دولار/مليون رمز إخراج، وهو جزء صغير من تكلفة GPT-4 التي تبلغ حوالي 20.00 دولار/مليون رمز، مما يوفر ما يصل إلى 90% من التوفير للمستخدمين الكثيفين. كما يحافظ مزودون آخرون مثل Groq (0.15 دولار/مليون إدخال، 0.75 دولار/مليون إخراج) و Cerebras (0.25 دولار/مليون إدخال، 0.69 دولار/مليون إخراج) على التكاليف منخفضة.

- الأداء: يحقق شبه تكافؤ مع o4-mini من OpenAI، حيث يسجل 94.2% في MMLU، و 96.6% في رياضيات AIME، و 87.3% في HumanEval للبرمجة. نافذة سياقه التي تبلغ 128 ألف رمز (300-400 صفحة) تتعامل مع قواعد أكواد أو مستندات ضخمة بسهولة.

- التفكير المتسلسل (CoT): تتيح لك الشفافية الكاملة لنموذج CoT رؤية تفكيره خطوة بخطوة، مما يسهل تصحيح الأخطاء في المخرجات واكتشاف التحيزات أو الأخطاء. يمكنك ضبط جهد التفكير (منخفض، متوسط، عالٍ) عبر أوامر النظام (على سبيل المثال، "Reasoning: high") لمهام مثل الرياضيات المعقدة أو البرمجة، مما يوازن بين السرعة والعمق. يساعد تصميم CoT غير الخاضع للإشراف هذا الباحثين في مراقبة سلوك النموذج دون إشراف مباشر، مما يعزز الثقة والأمان.

- القدرات الوكيلية: الدعم الأصلي لاستخدام الأدوات، مثل تصفح الويب وتنفيذ كود بايثون، يجعله مثاليًا لسير العمل الوكيلي. يمكنه ربط استدعاءات أدوات متعددة (على سبيل المثال، 28 عملية بحث متتالية على الويب في عرض توضيحي) للمهام المعقدة مثل تجميع البيانات أو الأتمتة.

- الخصوصية: استضفه محليًا (على سبيل المثال، عبر Dell Enterprise Hub) للتحكم الكامل في البيانات، وهو مثالي للمؤسسات أو المستخدمين المهتمين بالخصوصية.

- المرونة: متوافق مع OpenRouter، Fireworks AI، Cerebras، والإعدادات المحلية مثل Ollama أو LM Studio، ويعمل على أجهزة متنوعة، من وحدات معالجة الرسوميات RTX إلى Apple Silicon.

تُبرز الضجة المجتمعية على X سرعته (تصل إلى 1,515 رمزًا/ثانية على Cerebras) وبراعته في البرمجة، حيث يحب المطورون قدرته على التعامل مع المشاريع متعددة الملفات وطبيعته مفتوحة الوزن للتخصيص. سواء كنت تقوم ببناء وكلاء ذكاء اصطناعي أو ضبط دقيق لمهام متخصصة، فإن GPT-OSS-120B يقدم قيمة لا مثيل لها.

الخاتمة

إن GPT-OSS-120B من Open AI هو نموذج ثوري مفتوح الوزن، يمزج بين الأداء الرفيع والنشر الفعال من حيث التكلفة. معاييره تنافس النماذج الاحتكارية، وتسعيره مناسب للميزانية، ومن السهل دمجه مع Cursor أو Cline عبر واجهة برمجة تطبيقات OpenRouter. سواء كنت تقوم بالبرمجة، تصحيح الأخطاء، أو التفكير في مشاكل معقدة، فإن هذا النموذج يقدم المطلوب. جربه، جرب نافذة سياقه التي تبلغ 128 ألف رمز، وأخبرنا بحالات استخدامك الرائعة في التعليقات—أنا أستمع باهتمام!

لمزيد من التفاصيل، تحقق من المستودع على github.com/openai/gpt-oss أو إعلان Open AI على openai.com.

هل تريد منصة متكاملة وشاملة لفريق المطورين لديك للعمل معًا بأقصى إنتاجية؟

Apidog يلبي جميع متطلباتك، ويحل محل Postman بسعر أكثر بكثير!