يتطلب المطورون الذين يبنون تطبيقات ذكية بشكل متزايد نماذج تتعامل مع أنواع بيانات متنوعة دون المساس بالسرعة أو الدقة. يلبي GLM-4.6V هذه الحاجة بشكل مباشر. تُصدر Z.ai هذه السلسلة كنموذج لغوي كبير متعدد الوسائط مفتوح المصدر، يمزج النصوص والصور ومقاطع الفيديو والملفات في تفاعلات سلسة. يُمكّنك واجهة برمجة التطبيقات (API) من دمج هذه القدرات مباشرة في مشاريعك، سواء لتحليل المستندات أو لعملاء البحث المرئي.

عندما ندرس بنية GLM-4.6V وطرق الوصول والتسعير، سترى كيف يتفوق على أقرانه في معايير الأداء. علاوة على ذلك، ستساعدك نصائح التكامل مع أدوات مثل Apidog على النشر بشكل أسرع. لنبدأ بالتصميم الأساسي للنموذج.

فهم بنية GLM-4.6V وقدراته الأساسية

صمم مهندسو Z.ai نموذج GLM-4.6V لمعالجة المدخلات متعددة الوسائط بشكل أصلي، وإخراج استجابات نصية منظمة. تتضمن هذه السلسلة من النماذج نسختين: GLM-4.6V الرائد (106 مليار معلمة) للمهام عالية الأداء و GLM-4.6V-Flash (9 مليار معلمة) للنشر الفعال على الأجهزة المحلية. يدعم كلاهما نافذة سياق بحجم 128 ألف توكن، مما يتيح تحليل مستندات واسعة النطاق - تصل إلى 150 صفحة - أو مقاطع فيديو تستغرق ساعة واحدة في تمريرة واحدة.

في جوهره، يشتمل GLM-4.6V على مشفر بصري متوافق مع بروتوكولات السياق الطويل. يضمن هذا التوافق احتفاظ النموذج بالتفاصيل الدقيقة عبر المدخلات. على سبيل المثال، يتعامل مع تسلسلات النص والصور المتشابكة، ويربط الاستجابات بعناصر بصرية محددة مثل إحداثيات الكائنات في الصور. ويميزه الاستدعاء الأصلي للوظائف؛ حيث يستدعي المطورون الأدوات مباشرة باستخدام معلمات الصور، ويفسر النموذج حلقات التغذية الراجعة المرئية.

علاوة على ذلك، يعزز التعلم المعزز استدعاء الأدوات. يتعلم النموذج ربط الإجراءات، مثل الاستعلام عن أداة بحث باستخدام لقطة شاشة والاستدلال على النتائج. يؤدي هذا إلى سير عمل شامل، من الإدراك إلى اتخاذ القرار. ونتيجة لذلك، تكتسب التطبيقات استقلالية دون معالجة لاحقة هشة.

عملياً، تترجم هذه الميزات إلى معالجة قوية للبيانات الواقعية. يتفوق النموذج في إنشاء النصوص الغنية، ويولد مخرجات صور-نص متشابكة للتقارير أو الرسوم البيانية المعلوماتية. كما يدعم بروتوكول سياق النموذج الموسع (MCP)، مما يسمح بمدخلات متعددة الوسائط تعتمد على عناوين URL للمعالجة القابلة للتوسع.

المقاييس والأداء: قياس GLM-4.6V مقابل أقرانه

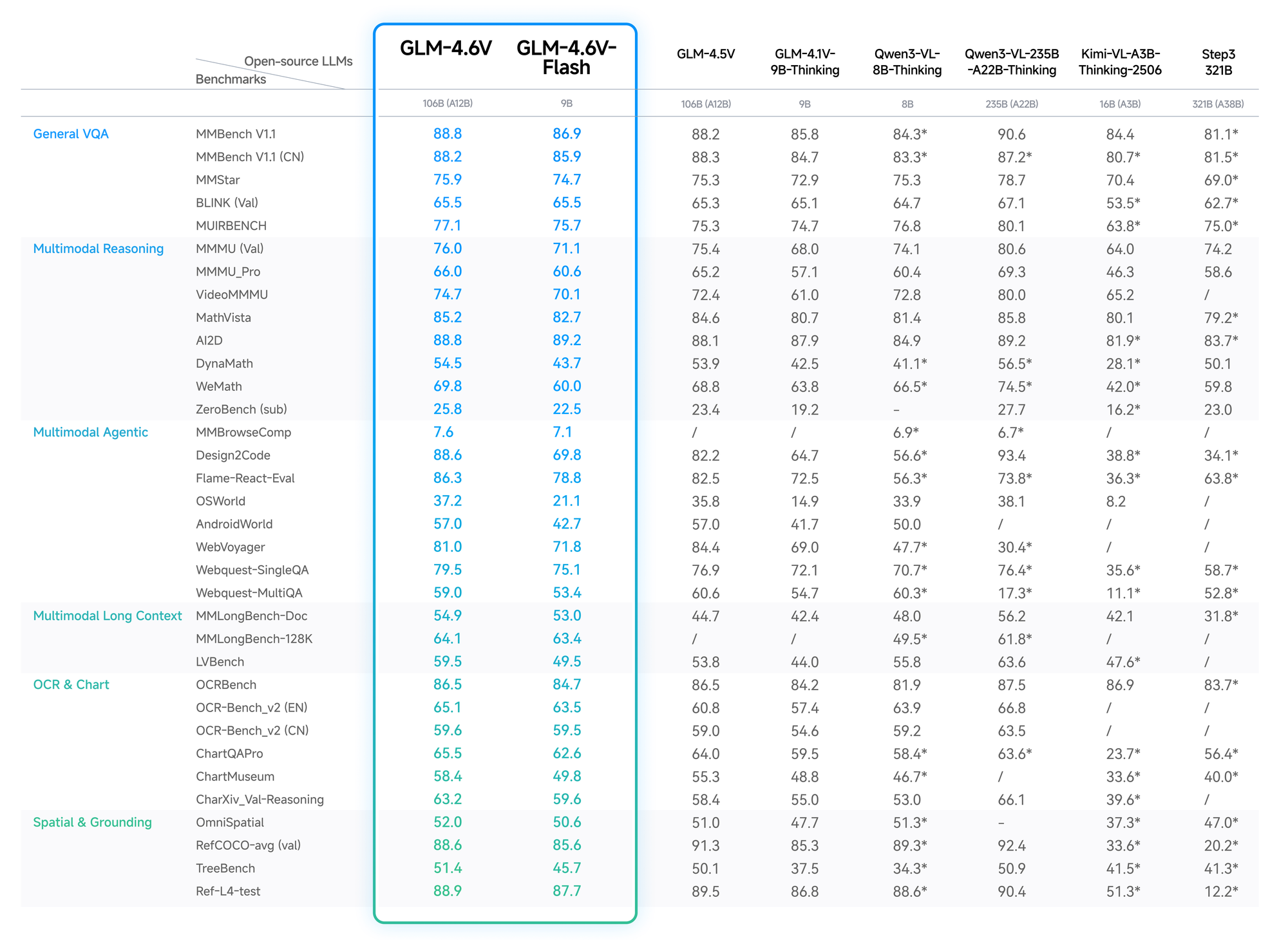

تؤكد البيانات الكمية تفوق GLM-4.6V. في MMBench، يسجل 82.5% في أسئلة وأجوبة متعددة الوسائط، متفوقًا على LLaVA-1.6 بأربع نقاط. ويكشف MathVista عن دقة 68% في المعادلات البصرية، بفضل المشفرات المحاذية.

تُظهر اختبارات OCRBench نسبة 91% لاستخراج النص من الصور المشوهة، متجاوزة GPT-4V في التصنيفات مفتوحة المصدر. تصل تقييمات السياق الطويل، مثل Video-MME، إلى 75% لمقاطع الفيديو التي تستغرق ساعة، مع الاحتفاظ بالتفاصيل عبر الإطارات.

تضحي نسخة Flash بدقة طفيفة (انخفاض بنسبة 2-3%) من أجل تسريع 5x، وهو مثالي للتطبيقات في الوقت الفعلي. تفصل مدونة Z.ai هذه التفاصيل، مع إعدادات قابلة للتكرار على Hugging Face.

وبالتالي، يختار المطورون GLM-4.6V للحصول على أداء موثوق وفعال من حيث التكلفة.

الميزات الرئيسية لسلسلة نماذج GLM-4.6V

يحتوي GLM-4.6V على ميزات متقدمة ترتقي بالذكاء الاصطناعي متعدد الوسائط. أولاً، تغطي وسائل الإدخال الخاصة به النصوص والصور ومقاطع الفيديو والملفات، مع تركيز المخرجات على توليد النصوص بدقة. يقدر المطورون المرونة: قم بتحميل ملف PDF مالي، ويستخرج النموذج الجداول، ويستنتج الاتجاهات، ويقترح التصورات.

يمثل الاستخدام الأصيل للأداة تقدمًا كبيرًا. على عكس النماذج التقليدية التي تتطلب تنسيقًا خارجيًا، يدمج GLM-4.6V استدعاء الوظائف. يمكنك تحديد الأدوات في الطلبات - على سبيل المثال، أداة قص للصور - ويمرر النموذج البيانات المرئية كمعلمات. ثم يفهم النتائج، ويكرر إذا لزم الأمر. وهذا يغلق الحلقة لمهام مثل البحث المرئي عبر الويب: التعرف على النية من صورة استعلام، وتخطيط الاسترجاع، ودمج النتائج، وإخراج رؤى منطقية.

بالإضافة إلى ذلك، تُمكّن نافذة السياق بحجم 128 ألف توكن من التحليل طويل الأمد. قم بمعالجة 200 شريحة من عرض تقديمي؛ يلخص النموذج الموضوعات الرئيسية مع تحديد الأوقات لأحداث الفيديو، مثل الأهداف في مباراة كرة القدم. لتطوير الواجهة الأمامية، فإنه يكرر واجهات المستخدم من لقطات الشاشة، ويُخرج رمز HTML/CSS/JS دقيقًا بالبكسل. تتبع تعديلات اللغة الطبيعية، مما يحسن النماذج الأولية بشكل تفاعلي.

تُحسِّن نسخة Flash من زمن الاستجابة. بمعاملات تبلغ 9 مليار، تعمل على الأجهزة الاستهلاكية عبر محركات استدلال vLLM أو SGLang. تتوفر الأوزان على Hugging Face لتتيح الضبط الدقيق، على الرغم من أن المجموعة تركز على النماذج الأساسية بدون إحصائيات واسعة النطاق حتى الآن. بشكل عام، تضع هذه الميزات GLM-4.6V كعمود فقري متعدد الاستخدامات للوكلاء في ذكاء الأعمال أو الأدوات الإبداعية.

كيفية الوصول إلى واجهة برمجة تطبيقات GLM-4.6V: إعداد خطوة بخطوة

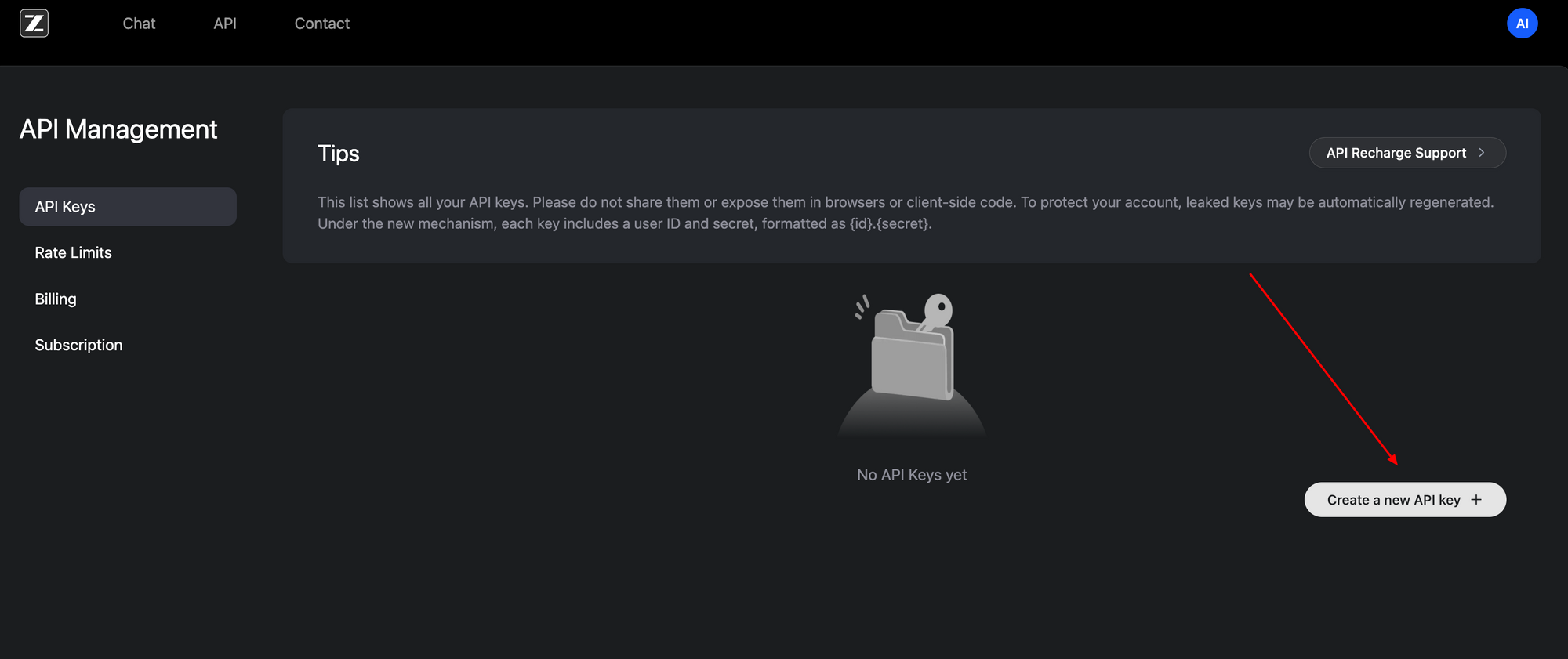

يعد الوصول إلى واجهة برمجة تطبيقات GLM-4.6V أمرًا مباشرًا، بفضل واجهتها المتوافقة مع OpenAI. ابدأ بالتسجيل في بوابة المطورين Z.ai (z.ai). قم بإنشاء مفتاح API ضمن لوحة تحكم حسابك - يعمل رمز Bearer هذا على مصادقة جميع الطلبات.

تقع نقطة النهاية الأساسية على https://api.z.ai/api/paas/v4/chat/completions. استخدم طريقة POST مع حمولات JSON. تتضمن رؤوس المصادقة Authorization: Bearer <your-api-key> و Content-Type: application/json. هيكل مصفوفة الرسائل المحادثات، ويدعم المحتوى متعدد الوسائط.

على سبيل المثال، أرسل عنوان URL للصورة جنبًا إلى جنب مع المطالبات النصية. تحدد الحمولة "model": "glm-4.6v" أو "glm-4.6v-flash". قم بتمكين خطوات التفكير باستخدام "thinking": {"type": "enabled"} لتتبع الاستدلال الشفاف. يضيف وضع التدفق "stream": true للاستجابات في الوقت الفعلي عبر أحداث مرسلة من الخادم.

إليك مثال على التكامل الأساسي لـ Python باستخدام مكتبة requests:

import requests

import json

url = "https://api.z.ai/api/paas/v4/chat/completions"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

payload = {

"model": "glm-4.6v",

"messages": [

{

"role": "user",

"content": [

{

"type": "image_url",

"image_url": {"url": "https://example.com/image.jpg"}

},

{"type": "text", "text": "Describe the key elements in this image and suggest improvements."}

]

}

],

"thinking": {"type": "enabled"}

}

response = requests.post(url, headers=headers, data=json.dumps(payload))

print(response.json())

يجلب هذا الرمز وصفًا مع المنطق. لمقاطع الفيديو أو الملفات، قم بتوسيع مصفوفة المحتوى بالمثل — تعمل عناوين URL أو ترميزات base64. تنطبق حدود المعدل بناءً على خطتك؛ راقبها عبر لوحة التحكم.

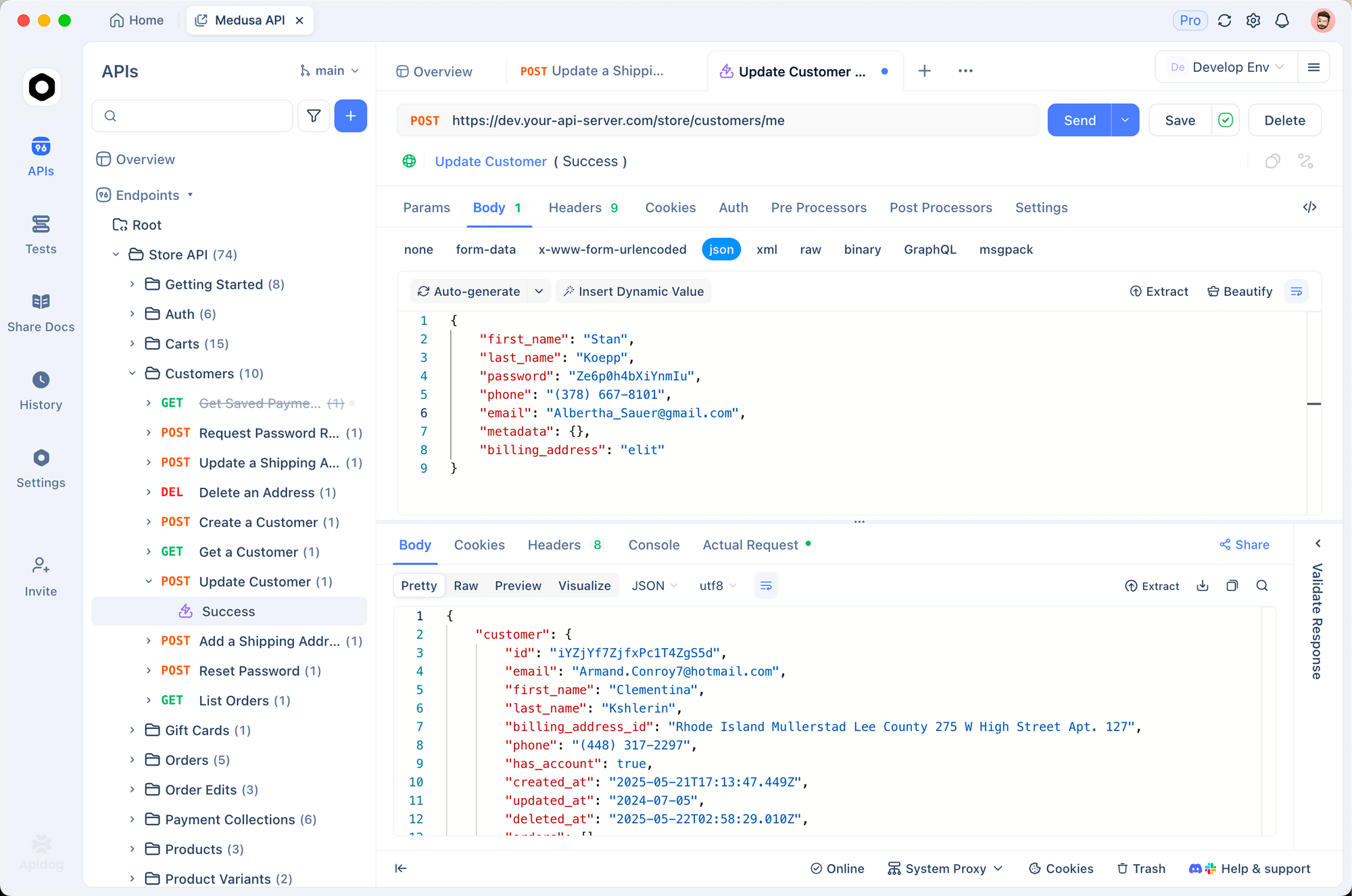

يعزز Apidog هذه العملية. استورد مواصفات OpenAPI من وثائق Z.ai إلى Apidog، ثم قم بمحاكاة الطلبات بصريًا. اختبر استدعاءات الوظائف بدون رمز، وتحقق من الحمولات قبل الإنتاج. ونتيجة لذلك، تكرر بشكل أسرع، وتلتقط الأخطاء مبكرًا.

الوصول المحلي يكمل استخدام السحابة. قم بتنزيل الأوزان من مجموعة GLM-4.6V في Hugging Face واخدمها عبر الأطر المتوافقة. يناسب هذا الإعداد التطبيقات الحساسة للخصوصية، على الرغم من أنه يتطلب موارد GPU لنموذج 106B.

تفصيل الأسعار: التوسع الفعال من حيث التكلفة مع GLM-4.6V

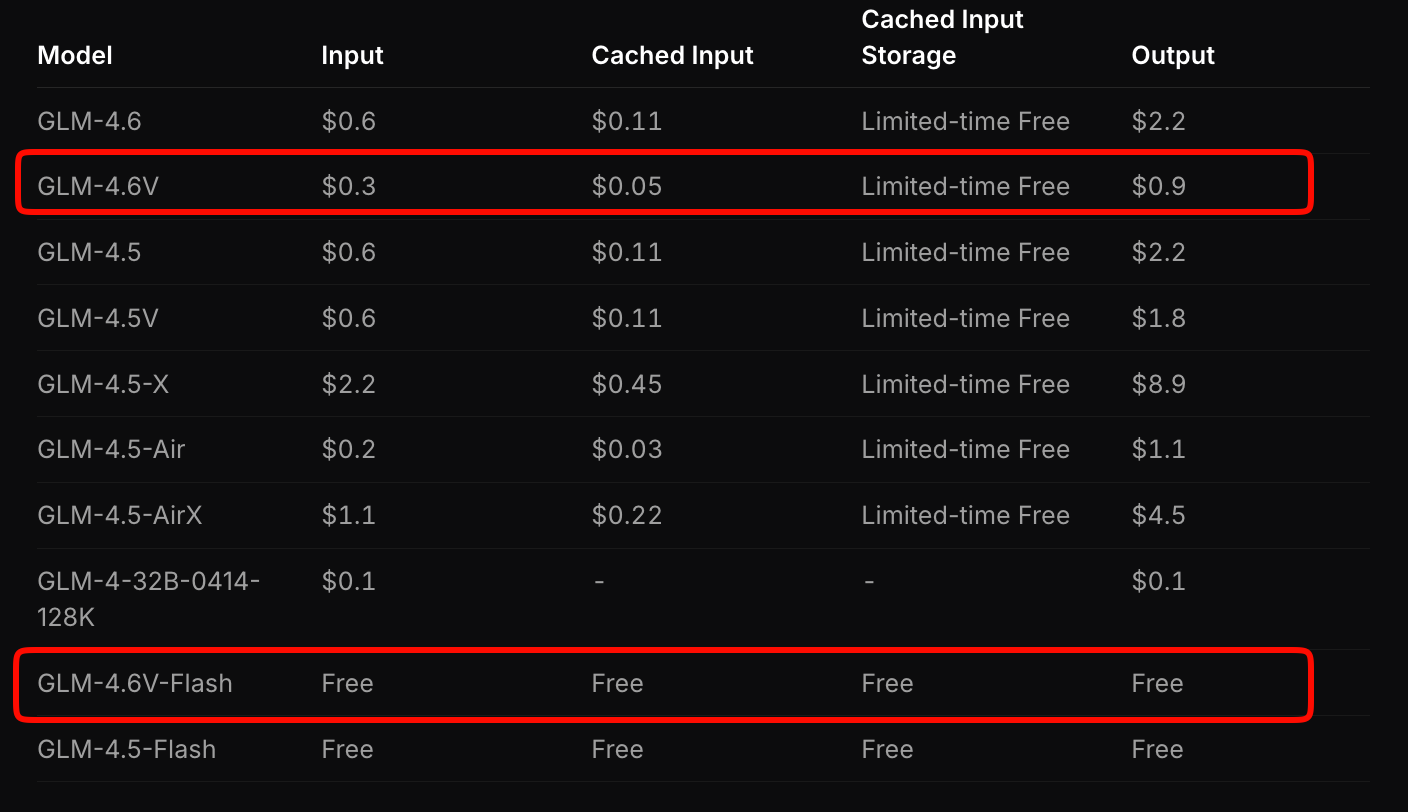

تُصمم Z.ai تسعير GLM-4.6V لتحقيق التوازن بين سهولة الوصول والأداء. يتقاضى النموذج الرائد 0.6 دولار لكل مليون توكن إدخال و 0.9 دولار لكل مليون توكن إخراج. يراعي هذا النموذج المتدرج تعقيد الوسائط المتعددة — تستهلك الصور ومقاطع الفيديو التوكنات بناءً على الدقة والطول.

على النقيض، يقدم GLM-4.6V-Flash وصولاً مجانيًا، وهو مثالي للنماذج الأولية أو عمليات النشر على الأجهزة الطرفية. لا تنطبق رسوم التوكنات، على الرغم من أن تكاليف الاستدلال مرتبطة بأجهزتك. يقدم عرض ترويجي لفترة محدودة ثلاثة أضعاف حصص الاستخدام بسُبع التكلفة للطبقات المدفوعة، مما يجعل التجربة ميسورة التكلفة.

قارن هذا بالمنافسين: يتجاوز GLM-4.6V واجهات برمجة التطبيقات متعددة الوسائط المماثلة بنسبة 20-30% مع تقديم معايير أداء متفوقة. للتطبيقات عالية الحجم، احسب التكاليف عبر أداة تقدير Z.ai. أدخل عبء عمل نموذجي - على سبيل المثال، 100 تحليل يومي للمستندات - وسيقوم بتقدير النفقات الشهرية.

علاوة على ذلك، تخفف الأوزان مفتوحة المصدر التكاليف طويلة الأجل. قم بضبط نموذجك على بياناتك لتقليل الاعتماد على استدعاءات السحابة. بشكل عام، يُمكّن هذا التسعير الشركات الناشئة من التوسع دون قيود الميزانية.

دمج GLM-4.6V API مع Apidog: تحسين سير العمل العملي

Apidog يحول تكامل GLM-4.6V من العمل اليدوي الشاق إلى تعاون فعال. كعميل API وأداة تصميم، يستورد مواصفات Z.ai، ويولد قوالب الطلبات تلقائيًا. يمكنك سحب وإفلات حمولات الوسائط المتعددة، ومعاينة الاستجابات، وتصديرها إلى مقتطفات رمز في Python أو Node.js أو cURL.

ابدأ بإنشاء مشروع جديد في Apidog. الصق عنوان URL لنقطة النهاية وقم بالمصادقة باستخدام مفتاحك. لمهمة التأسيس البصري، قم بإنشاء طلب: أضف نوع image_url، أدخل إحداثيات المطالبة، واضغط على إرسال. يقوم Apidog بتصور المخرجات، مع إبراز خطوات التفكير.

يبرز التعاون هنا. شارك المجموعات مع الفرق؛ تحكم في إصدار نقاط النهاية أثناء إضافة الأدوات. تضمن متغيرات البيئة الأمان للمفاتيح عبر بيئات التطوير والاختبار والإنتاج. وبالتالي، تقصر دورات النشر - اختبر سلسلة وكلاء كاملة في دقائق.

امتدادًا للمراقبة: يسجل Apidog زمن الوصول والأخطاء، ويحدد الاختناقات في تدفقات الوسائط المتعددة. قم بإقرانه مع GLM-4.6V-Flash للاختبارات المحلية المجانية، ثم قم بالتوسع إلى السحابة. يبلغ المطورون عن تسريع النماذج الأولية بنسبة 40% باستخدام هذه الأدوات.

حالات الاستخدام الواقعية: تطبيق GLM-4.6V في الإنتاج

يتألق GLM-4.6V في الصناعات كثيفة المستندات. يقوم المحللون الماليون بتحميل التقارير؛ ويقوم النموذج بتحليل الرسوم البيانية، وحساب النسب، وتوليد ملخصات تنفيذية مع مرئيات مضمنة. لقد خفضت إحدى الشركات وقت التحليل من ساعات إلى دقائق، مستفيدة من سياق 128 ألف توكن للتقارير السنوية.

في التجارة الإلكترونية، تنشط وكلاء البحث المرئي. يقوم العملاء بتحميل صور المنتجات؛ ويقوم GLM-4.6V بتخطيط الاستعلامات، واسترجاع المطابقات، والاستدلال على السمات مثل متغيرات الألوان. وهذا يعزز التحويل بنسبة 15%، وفقًا للمتبنين الأوائل.

تُسرّع فرق الواجهة الأمامية عملية بناء النماذج الأولية. أدخل لقطة شاشة؛ واحصل على رمز قابل للتحرير. كرر باستخدام مطالبات مثل "أضف شريط تنقل متجاوبًا." تقلل دقة النموذج على مستوى البكسل من المراجعات، مما يقلل وقت التصميم إلى النشر إلى النصف.

تستفيد منصات الفيديو من الاستدلال الزمني. تلخيص المحاضرات مع الطوابع الزمنية أو اكتشاف الأحداث في لقطات المراقبة. يتكامل الاستخدام الأصيل للأداة مع قواعد البيانات، ويقوم بالإبلاغ عن الشذوذ تلقائيًا.

تُظهر هذه الحالات تعدد استخدامات GLM-4.6V. ومع ذلك، يعتمد النجاح على هندسة المطالبات - صياغة تعليمات واضحة لزيادة الدقة.

التحديات وأفضل الممارسات لاستخدام واجهة برمجة تطبيقات GLM-4.6V

على الرغم من نقاط القوة، تواجه النماذج متعددة الوسائط عقبات. تؤدي المدخلات عالية الدقة إلى تضخيم عدد الرموز المميزة، مما يزيد التكاليف — قم بضغط الصور إلى 512x512 بكسل أولاً. يؤدي تجاوز السياق إلى خطر الهلوسة؛ قم بتقسيم مقاطع الفيديو الطويلة إلى أجزاء.

تخفف أفضل الممارسات هذه المشاكل. استخدم وضع التفكير لتصحيح الأخطاء؛ فهو يكشف الخطوات الوسيطة. تحقق من مخرجات الأداة باستخدام التأكيدات في التعليمات البرمجية الخاصة بك. لمستخدمي Apidog، قم بإعداد اختبارات آلية على نقاط النهاية لفرض المخططات.

راقب الحصص عن كثب — يتجنب Flash المجاني المفاجآت، لكن الطبقات المدفوعة تتطلب وضع ميزانية. أخيرًا، قم بضبط النموذج على بيانات المجال عبر الأوزان المفتوحة لتعزيز التحديد.

الخاتمة: ارتقِ بمشاريعك مع GLM-4.6V اليوم

يعيد GLM-4.6V تعريف الذكاء الاصطناعي متعدد الوسائط من خلال الأدوات الأصلية والسياق الواسع وإمكانية الوصول المفتوحة. تتكامل واجهة برمجة التطبيقات الخاصة به، والمُسعّرة بشكل تنافسي عند 0.6 دولار لكل مليون رمز إدخال للنموذج الكامل ومجانية لـ Flash، بسلاسة مع منصات مثل Apidog. من وكلاء المستندات إلى مولدات واجهة المستخدم، يدفع الابتكار.

طبق هذه الرؤى الآن: احصل على مفتاح API الخاص بك، اختبر في Apidog، وابدأ البناء. مستقبل الذكاء الاصطناعي يفضل أولئك الذين يستغلون هذه الإمكانات مبكرًا. ما هو التطبيق الذي ستقوم بتحويله بعد ذلك؟