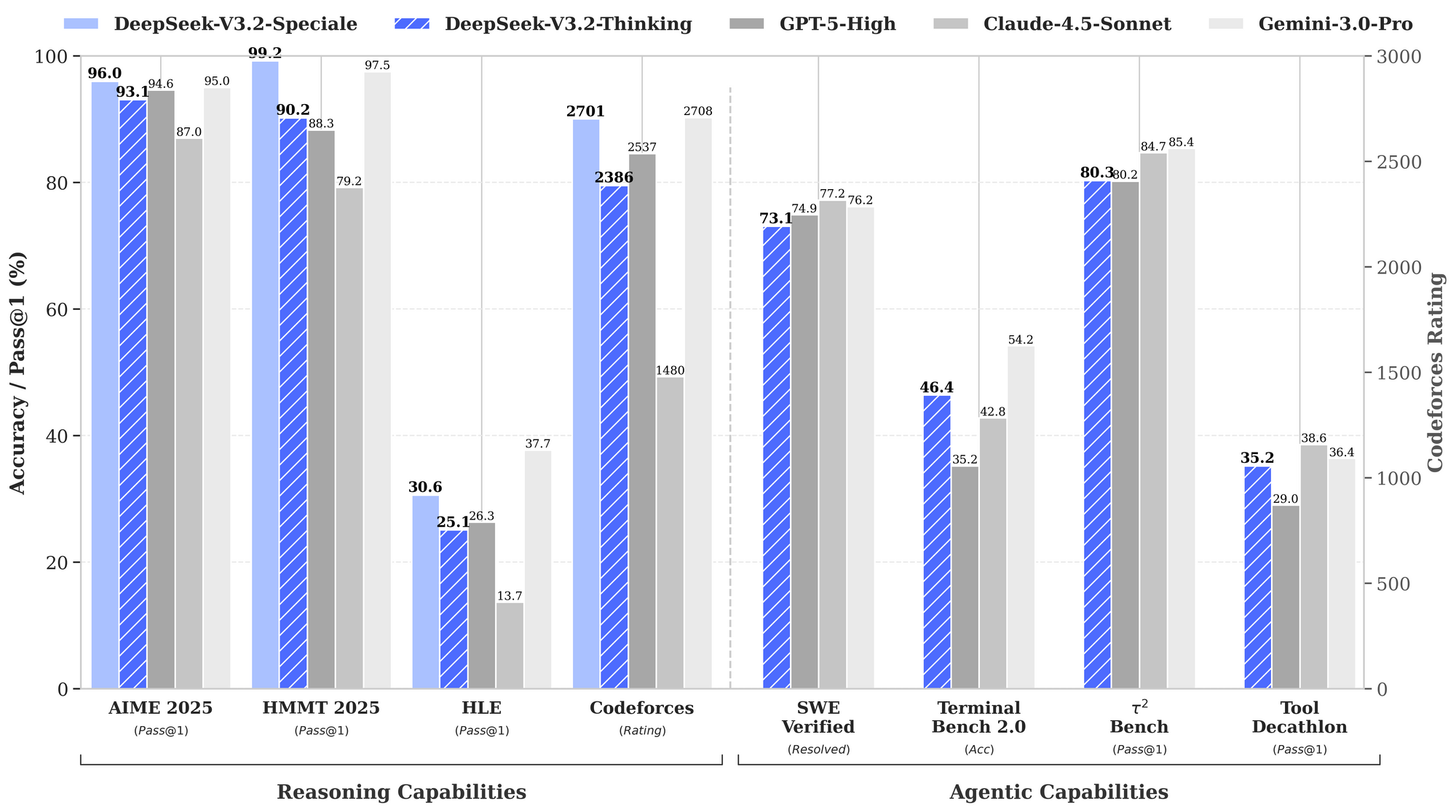

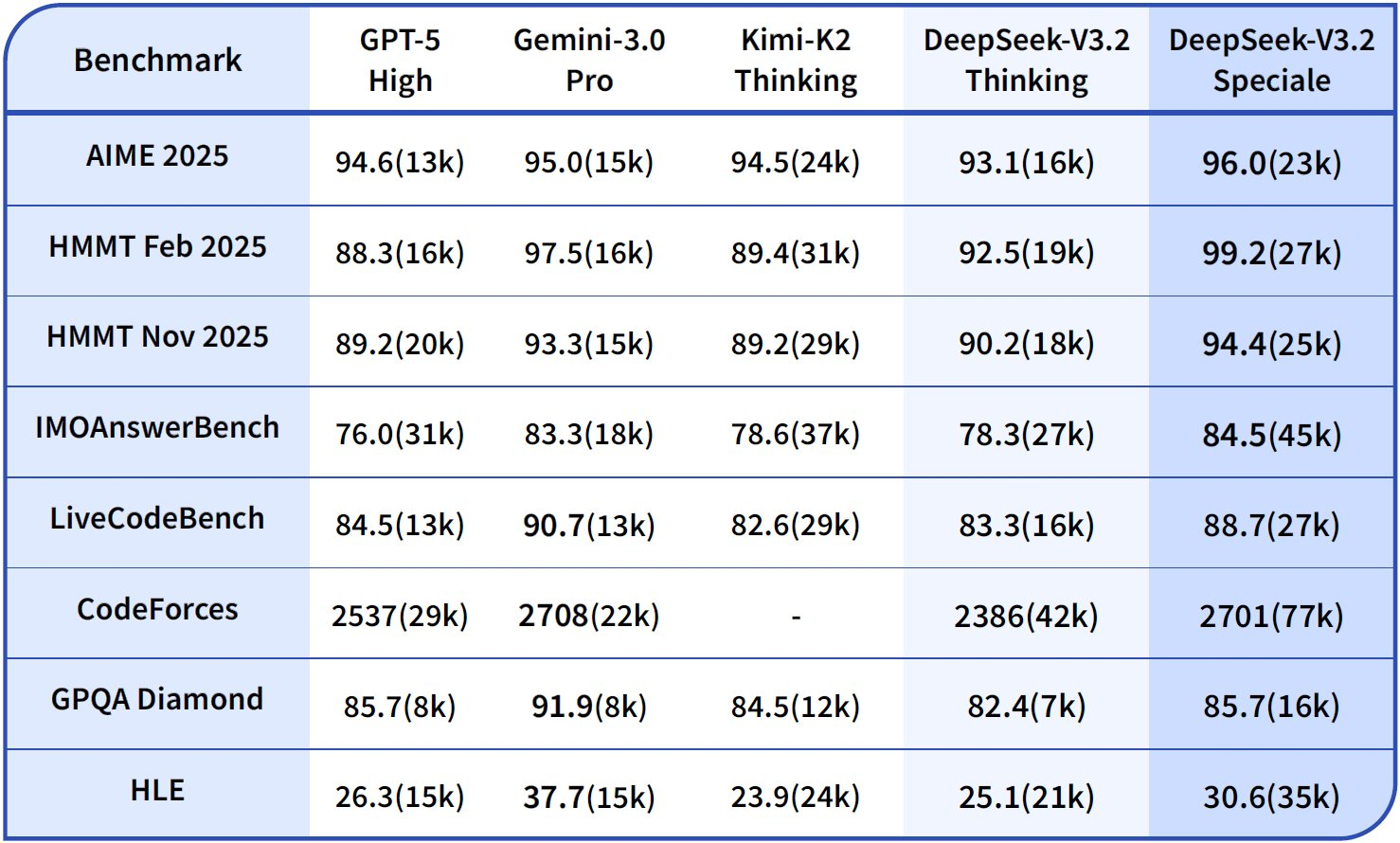

يبحث المطورون عن أدوات تعزز الإنتاجية دون إدخال تعقيدات غير ضرورية. يبرز DeepSeek-V3.2 و DeepSeek-V3.2-Speciale كنماذج قوية مفتوحة المصدر محسّنة للمهام المنطقية والمهام الوكيلية (agentic tasks)، مقدمين بديلاً جذابًا للأنظمة الاحتكارية. تتفوق هذه النماذج في توليد الأكواد وحل المشكلات ومعالجة السياقات الطويلة، مما يجعلها مثالية للدمج في بيئات البرمجة القائمة على الطرفية مثل Claude Code.

فهم DeepSeek-V3.2: محطة قوية مفتوحة المصدر لمهام الاستدلال

يقدّر المطورون النماذج مفتوحة المصدر لشفافيتها ومرونتها. يبرز DeepSeek-V3.2 كنموذج لغوي كبير (LLM) يركز على الاستدلال أولاً، ويعطي الأولوية للاستنتاج المنطقي، وتوليف الأكواد، والقدرات الوكيلية (agentic capabilities). تم إصدار هذا النموذج بموجب ترخيص MIT، ويبني على التكرارات السابقة مثل DeepSeek-V3.1، ويتضمن تطورات في آليات الانتباه المتباعد (sparse attention) للتعامل مع السياقات الممتدة حتى 128,000 توكن.

يمكنك الوصول إلى DeepSeek-V3.2 بشكل أساسي عبر Hugging Face، حيث يستضيف المستودع على deepseek-ai/DeepSeek-V3.2 أوزان النموذج وملفات التكوين وتفاصيل موزع التوكن (tokenizer). لتحميل النموذج محليًا، قم بتثبيت مكتبة Transformers عبر pip ونفّذ سكريبتًا بسيطًا:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

model_name = "deepseek-ai/DeepSeek-V3.2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype=torch.float16, device_map="auto")

# Example inference

inputs = tokenizer("Write a Python function to compute Fibonacci sequence:", return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=100)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

يتطلب هذا الإعداد وحدة معالجة رسومات (GPU) بسعة 16 جيجابايت من ذاكرة الوصول العشوائي (VRAM) على الأقل للاستدلال الفعال، على الرغم من أن تقنيات التكميم (quantization) عبر مكتبات مثل bitsandbytes تقلل من استهلاك الذاكرة. يستخدم تصميم DeepSeek-V3.2 بنية "مزيج الخبراء" (mixture-of-experts - MoE) مع 236 مليار معلمة، ويقوم بتفعيل مجموعة فرعية فقط لكل توكن لتحسين الحسابات. وبالتالي، فإنه يحقق إنتاجية عالية على أجهزة المستهلك مع الحفاظ على أداء تنافسي.

غالبًا ما يتطلب الانتقال من التجريب المحلي إلى الاستخدام على نطاق الإنتاج الوصول عبر واجهة برمجة التطبيقات (API). يوفر هذا التحول قابلية التوسع دون إدارة الأجهزة، مما يمهد الطريق لعمليات الدمج مثل Claude Code.

DeepSeek-V3.2-Speciale: قدرات معززة لسير العمل الوكيلي المتقدم

بينما يقدم DeepSeek-V3.2 فائدة واسعة، يقوم DeepSeek-V3.2-Speciale بتحسين هذه الأسس لتلبية المتطلبات المتخصصة. هذه النسخة، المضبطة للاستدلال على مستوى المسابقات والمحاكاة عالية المخاطر، تدفع الحدود في الرياضيات ومسابقات البرمجة ومهام الوكيل متعددة الخطوات. وهو متاح عبر مستودع Hugging Face على deepseek-ai/DeepSeek-V3.2-Speciale، ويشارك البنية الأساسية لـ MoE ولكنه يدمج تعديلات إضافية بعد التدريب لزيادة الدقة.

يتم تحميل DeepSeek-V3.2-Speciale بطريقة مماثلة:

model_name = "deepseek-ai/DeepSeek-V3.2-Speciale"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype=torch.bfloat16, device_map="auto")

يماثل عدد معلماته النموذج الأساسي، ومع ذلك، فإن التحسينات في الانتباه المتباعد (DeepSeek Sparse Attention - DSA) تؤدي إلى استدلال أسرع بنسبة تصل إلى 50% على التسلسلات الطويلة. يستخدم DSA تباعدًا دقيقًا، مما يحافظ على الجودة مع تقليل التعقيد التربيعي في طبقات الانتباه.

عمليًا، يتألق DeepSeek-V3.2-Speciale في السيناريوهات التي تتطلب استدلالًا متسلسلًا، مثل تحسين الخوارزميات للبرمجة التنافسية. على سبيل المثال، اطلب منه: "حل مشكلة LeetCode الصعبة هذه: [الوصف]. اشرح طريقتك خطوة بخطوة." يقوم النموذج بإخراج حلول منظمة مع تحليل تعقيد الوقت، وغالبًا ما يتفوق على النماذج العامة بنسبة 15-20% في الحالات الحرجة.

ومع ذلك، تتطلب التشغيلات المحلية موارد أكثر — يوصى بـ 24 جيجابايت+ VRAM للدقة الكاملة. للإعدادات الأخف، طبق التكميم 4 بت:

from transformers import BitsAndBytesConfig

quant_config = BitsAndBytesConfig(load_in_4bit=True)

model = AutoModelForCausalLM.from_pretrained(model_name, quantization_config=quant_config)

يحافظ هذا التكوين على 90% من الدقة الأصلية بينما يخفض استخدام الذاكرة إلى النصف. كما هو الحال مع النموذج الأساسي، قم بتمكين أوضاع التفكير للاستفادة من آثار ما وراء المعرفة (metacognitive traces)، حيث يقوم بتصحيح الافتراضات ذاتيًا أثناء الاستدلال.

يتيح الوصول مفتوح المصدر التخصيص، ولكن للبيئات التعاونية أو الموسعة، توفر نقاط نهاية واجهة برمجة التطبيقات الموثوقية. بعد ذلك، دعنا ندرس كيفية ربط هذه النماذج بالتفاعلات المستندة إلى السحابة.

الوصول إلى DeepSeek API: تكامل سلس للتطوير القابل للتطوير

تزدهر النماذج مفتوحة المصدر مثل DeepSeek-V3.2 وDeepSeek-V3.2-Speciale في الإعدادات المحلية، ولكن الوصول عبر واجهة برمجة التطبيقات يفتح تطبيقات أوسع. توفر منصة DeepSeek واجهة متوافقة، تدعم OpenAI وAnthropic SDKs لترحيل سهل.

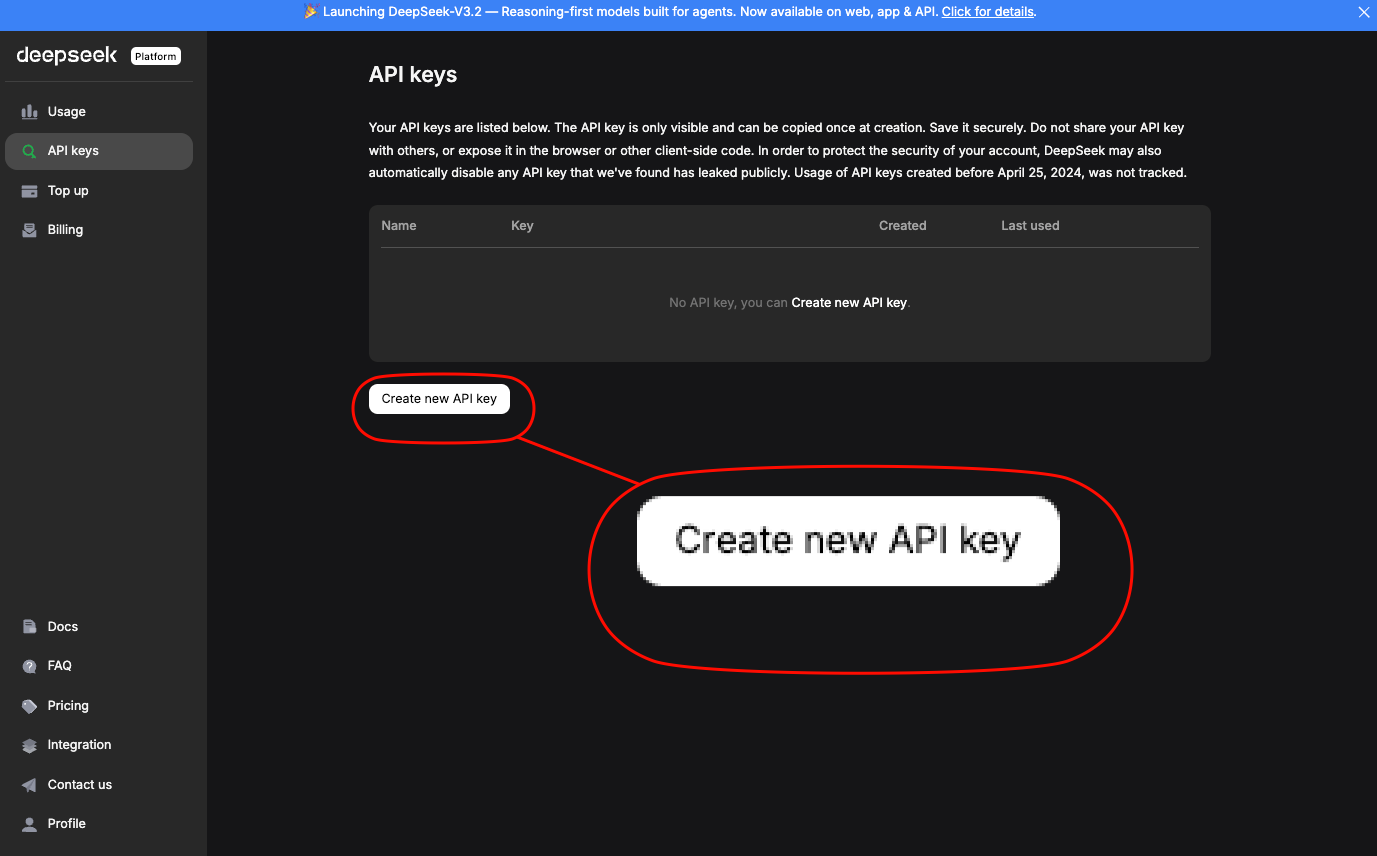

سجّل للحصول على مفتاح API في platform.deepseek.com.

توفر لوحة التحكم تحليلات الاستخدام وضوابط الفوترة. استدعِ النماذج عبر نقاط النهاية القياسية؛ لـ DeepSeek-V3.2، استخدم الاسم المستعار deepseek-chat. يتطلب DeepSeek-V3.2-Speciale عنوان URL أساسي محدد: https://api.deepseek.com/v3.2_speciale_expires_on_20251215 — لاحظ أن هذا التوجيه المؤقت ينتهي في 15 ديسمبر 2025.

يوضح طلب curl أساسي الوصول:

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $DEEPSEEK_API_KEY" \

-d '{

"model": "deepseek-chat",

"messages": [{"role": "user", "content": "Generate a REST API endpoint in Node.js for user authentication."}],

"max_tokens": 500,

"temperature": 0.7

}'

يعيد هذا استجابة JSON مع كود مُنشأ، بما في ذلك معالجة الأخطاء وتكامل JWT. للتوافق مع Anthropic — وهو أمر أساسي لـ Claude Code — قم بتعيين عنوان URL الأساسي إلى https://api.deepseek.com/anthropic واستخدم حزمة Python SDK الخاصة بـ anthropic:

import anthropic

client = anthropic.Anthropic(base_url="https://api.deepseek.com/anthropic", api_key="your_deepseek_key")

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

messages=[{"role": "user", "content": "Explain quantum entanglement in code terms."}]

)

print(message.content[0].text)

تضمن هذه التوافقية استبدالًا مباشرًا. تبلغ حدود المعدل 10,000 توكن في الدقيقة للمستويات القياسية، قابلة للتطوير عبر خطط المؤسسات.

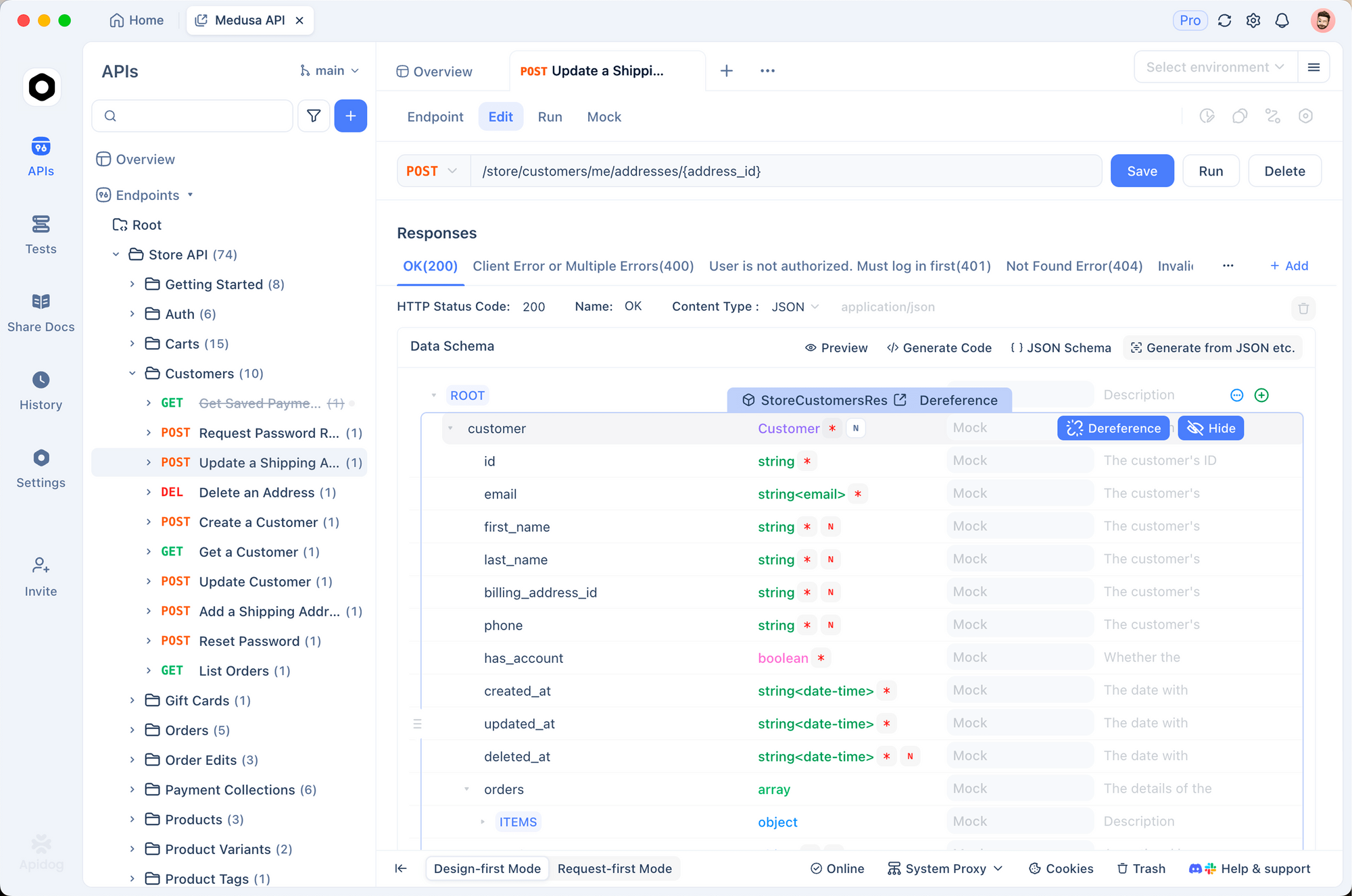

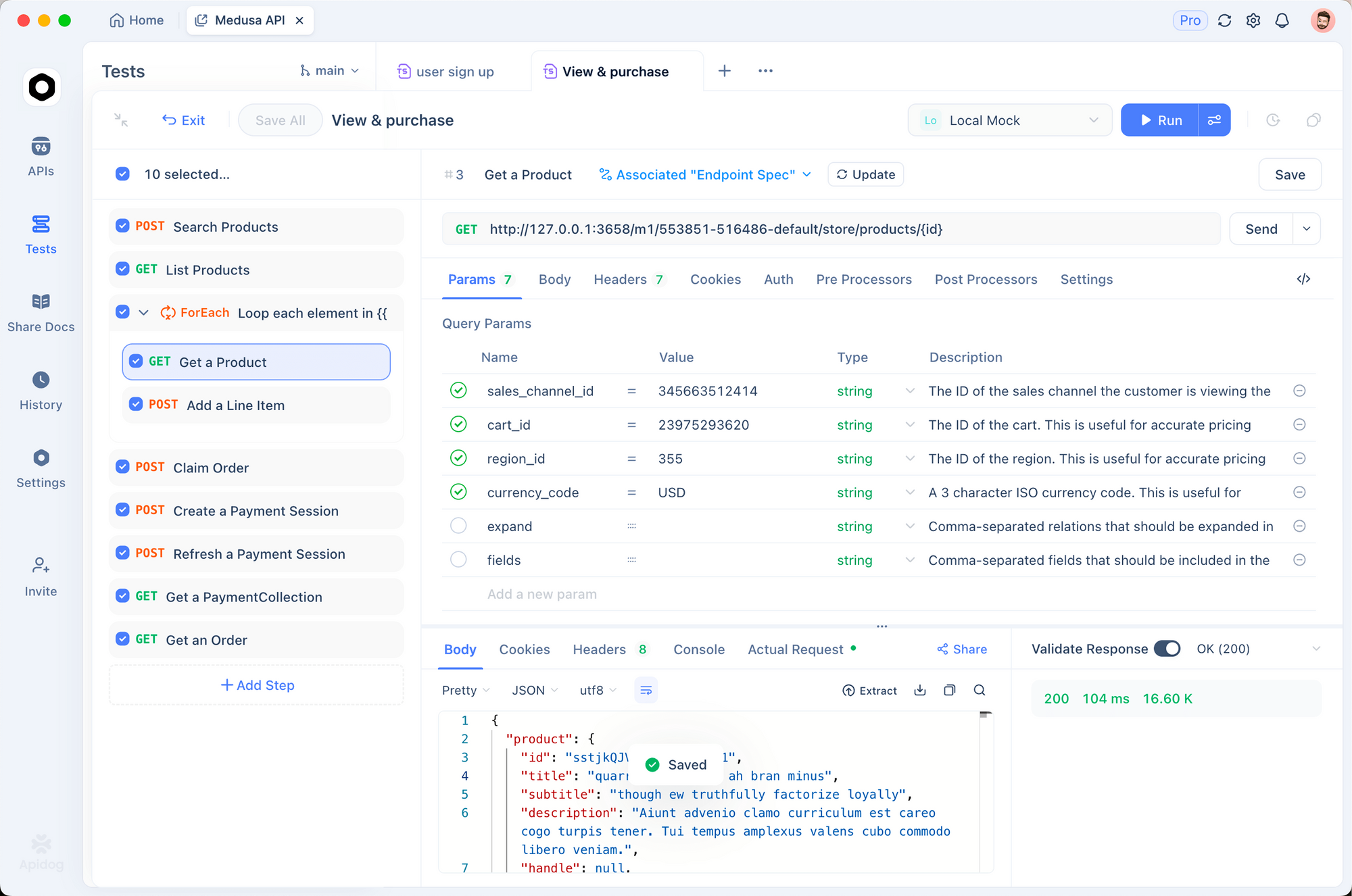

استخدم Apidog لإنشاء نماذج أولية لهذه الاستدعاءات. قم باستيراد مواصفات OpenAPI من وثائق DeepSeek إلى Apidog، ثم قم بمحاكاة الطلبات مع حمولات متغيرة. تقوم هذه الأداة تلقائيًا بإنشاء مجموعات اختبار، والتحقق من صحة الاستجابات مقابل المخططات — وهو أمر ضروري لضمان توافق مخرجات النموذج مع معايير قاعدة التعليمات البرمجية الخاصة بك.

بعد تأمين الوصول إلى واجهة برمجة التطبيقات، قم بدمج نقاط النهاية هذه في أدوات التطوير. يستفيد Claude Code، على وجه الخصوص، من هذا الإعداد، كما هو موضح أدناه.

تحليل الأسعار: استراتيجيات فعالة من حيث التكلفة لاستخدام DeepSeek API

يقدر المطورون المهتمون بالميزانية التكاليف المتوقعة. يكافئ نموذج تسعير DeepSeek التوجيه الفعال والتخزين المؤقت، مما يؤثر بشكل مباشر على جلسات Claude Code.

حلل البنية: تنطبق عمليات الوصول إلى ذاكرة التخزين المؤقت (Cache hits) على السوابق المتكررة، وهو أمر مثالي للبرمجة التكرارية حيث تقوم بتحسين التوجيهات عبر الجلسات. تُفرض رسوم كاملة على عمليات الفشل (Misses) وفقًا لأسعار الإدخال، لذا قم بتنظيم المحادثات لتحقيق أقصى قدر من إعادة الاستخدام. تتناسب المخرجات خطيًا مع طول التوليد — قم بتحديد max_tokens للتحكم في النفقات.

| Model Variant | Input Cache Hit ($/1M Tokens) | Input Cache Miss ($/1M Tokens) | Output ($/1M Tokens) | Context Length |

|---|---|---|---|---|

| DeepSeek-V3.2 | 0.028 | 0.28 | 0.42 | 128K |

| DeepSeek-V3.2-Speciale | 0.028 | 0.28 | 0.42 | 128K |

يتفاوض مستخدمو الشركات على خصومات كبيرة، لكن المستويات المجانية تقدم مليون توكن شهريًا للاختبار. راقب عبر لوحة التحكم؛ ادمج التسجيل في Claude Code لتتبع استخدام التوكنات:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=$DEEPSEEK_API_KEY

claude --log-tokens

يعرض هذا الأمر مقاييس بعد الجلسة، مما يساعد على تحسين المطالبات. بالنسبة للترميز طويل السياق، يحافظ DSA في إصدارات V3.2 على استقرار التكاليف حتى عند 100 ألف+ توكن، على عكس النماذج الكثيفة التي تتصاعد تربيعيًا.

دمج DeepSeek-V3.2 و V3.2-Speciale في Claude Code: إعداد خطوة بخطوة

يُحدث Claude Code ثورة في التطوير المعتمد على الطرفية كأداة وكيلية من Anthropic. إنه يفسر أوامر اللغة الطبيعية، وينفذ عمليات git، ويشرح قواعد الأكواد، ويؤتمت الروتينات — كل ذلك داخل بيئة الشل الخاصة بك. من خلال توجيه الطلبات إلى نماذج DeepSeek، تستفيد من الاستدلال الفعال من حيث التكلفة دون التضحية بواجهة Claude Code البديهية.

ابدأ بالمتطلبات الأساسية: قم بتثبيت Claude Code عبر pip (pip install claude-code) أو من GitHub anthropics/claude-code. تأكد من وجود Node.js و git في مسار (PATH) نظامك.

قم بتكوين متغيرات البيئة للتوافق مع DeepSeek:

export ANTHROPIC_BASE_URL="https://api.deepseek.com/anthropic"

export ANTHROPIC_API_KEY="sk-your_deepseek_key_here"

export ANTHROPIC_MODEL="deepseek-chat" # لـ V3.2

export ANTHROPIC_SMALL_FAST_MODEL="deepseek-chat"

export API_TIMEOUT_MS=600000 # 10 دقائق للاستدلال الطويل

export CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC=1 # تحسين لـ API

بالنسبة لـ DeepSeek-V3.2-Speciale، ألحق القاعدة المخصصة: export ANTHROPIC_BASE_URL="https://api.deepseek.com/v3.2_speciale_expires_on_20251215/anthropic". تحقق من الإعداد عن طريق تشغيل claude --version؛ سيكتشف نقطة النهاية تلقائيًا.

قم بتشغيل Claude Code في دليل مشروعك:

cd /path/to/your/repo

claude

تفاعل عبر الأوامر. لتوليد الكود: "/generate Implement a binary search tree in C++ with AVL balancing." يقوم DeepSeek-V3.2 بمعالجة هذا، ويخرج الملفات مع الشروحات. يتم تنشيط وضع التفكير الخاص به ضمنيًا للمهام المعقدة، ويتتبع المنطق قبل الكود.

تعامل مع سير عمل الوكيل: "/agent Debug this failing test suite and suggest fixes." يقوم النموذج بتحليل تتبعات المكدس (stack traces)، ويقترح التصحيحات، ويلتزم عبر git — كل ذلك مدعومًا بنتيجة DeepSeek البالغة 84.8% على SWE-Bench. يبرز استخدام الأدوات المتوازية هنا؛ حدد "/use-tool pytest" لتنفيذ الاختبارات مباشرة.

خصص باستخدام الإضافات. قم بتوسيع ملف تكوين YAML الخاص بـ Claude Code (~/.claude-code/config.yaml) لإعطاء الأولوية لـ DeepSeek للمطالبات التي تتطلب الكثير من التفكير:

models:

default: deepseek-chat

fallback: deepseek-chat # بالنسبة لـ V3.2-Speciale، تجاوز لكل جلسة

reasoning_enabled: true

max_context: 100000 # استفد من نافذة 128K

اختبر عمليات الدمج باستخدام Apidog. قم بتصدير جلسات Claude Code كملفات HAR، واستوردها إلى Apidog، وقم بإعادة تشغيلها مقابل نقاط نهاية DeepSeek. يتحقق هذا من زمن الاستجابة (عادةً <2 ثانية لـ 1K توكن) ومعدلات الأخطاء، مما يحسن المطالبات للإنتاج.

استكشف المشكلات الشائعة وإصلاحها: إذا فشلت المصادقة، أعد إنشاء مفتاح API الخاص بك. بالنسبة لحدود التوكنات، قم بتقسيم قواعد الأكواد الكبيرة باستخدام "/summarize repo structure first." تضمن هذه التعديلات التشغيل السلس.

التقنيات المتقدمة: الاستفادة من DeepSeek في Claude Code لتحقيق الأداء الأمثل

بالإضافة إلى الأساسيات، يستغل المستخدمون المتقدمون نقاط قوة DeepSeek. قم بتمكين سلسلة التفكير (CoT) بشكل صريح: "/think Solve this dynamic programming problem: [details]." ينشئ V3.2-Speciale آثارًا معرفية ذاتية، ويصحح نفسه عبر محاكاة مونت كارلو شبه العشوائية في النص — مما يعزز الدقة إلى 94.6% في HMMT.

لعمليات التحرير متعددة الملفات، استخدم "/edit --files main.py utils.py Add logging decorators." يتنقل الوكيل بين التبعيات، ويطبق التغييرات بشكل ذري. تظهر المقاييس نجاحًا بنسبة 80.3% في Terminal-Bench 2.0، متجاوزًا Gemini-3.0-Pro.

دمج الأدوات الخارجية: قم بتكوين "/tool npm run build" للتحقق بعد التوليد. تضمن معيار استخدام الأدوات الخاص بـ DeepSeek (84.7%) تنسيقًا موثوقًا به.

راقب الأخلاقيات: يتوافق DeepSeek مع السلامة عبر RLHF، ولكن قم بمراجعة المخرجات بحثًا عن الانحيازات في افتراضات الكود. استخدم التحقق من مخططات Apidog لفرض أنماط آمنة، مثل تنقية الإدخال.

التوسع إلى فرق: شارك التكوينات عبر مستودعات ملفات النقاط (dotfiles repos). في CI/CD، قم بتضمين نصوص Claude Code مع DeepSeek لمراجعات طلبات السحب (PR reviews) التلقائية — مما يقلل وقت المراجعة بنسبة 40%.

تطبيقات واقعية: DeepSeek-Powered Claude Code في العمل

لنفترض مشروع تقنية مالية: "/generate Secure API for transaction processing using GraphQL." يقوم DeepSeek-V3.2 بإخراج المخطط (schema)، والمُحلِّلات (resolvers)، وبرمجيات تحديد المعدل الوسيطة (rate-limiting middleware)، والتي تم التحقق من صحتها مقابل معايير OWASP.

في مسارات التعلم الآلي (ML pipelines): "/agent Optimize this PyTorch model for edge deployment." يقوم بإعادة هيكلة للكمي (quantization)، ويختبر على أجهزة محاكاة، ويوثق المفاضلات.

تُظهر هذه الحالات مكاسب في الإنتاجية بمقدار 2-3 مرات، مدعومة بتقارير المستخدمين على قضايا GitHub.

الخلاصة

يحوّل DeepSeek-V3.2 و DeepSeek-V3.2-Speciale Claude Code إلى محطة قوية تركز على الاستدلال. من التحميل مفتوح المصدر إلى قابلية التوسع المدفوعة بواجهة برمجة التطبيقات، تقدم هذه النماذج أداءً رائدًا وفقًا للمعايير بتكلفة زهيدة. طبق الخطوات الموضحة — بدءًا من Apidog لإنشاء نماذج أولية لواجهة برمجة التطبيقات — وشاهد سير عمل مبسطًا.

جرّب اليوم: قم بإعداد بيئتك، وشغّل أمرًا نموذجيًا، وكرر. لا يؤدي هذا التكامل إلى تسريع التطوير فحسب، بل يعزز فهمًا أعمق للكود من خلال الاستدلال الشفاف. مع تطور الذكاء الاصطناعي، تضمن أدوات مثل هذه بقاء المطورين في الطليعة.