تواصل DeepSeek تطوير نماذج اللغة الكبيرة من خلال إصدارات تُعطي الأولوية للتفكير والكفاءة. يمكن للمهندسين والباحثين الآن الوصول إلى DeepSeek-V3.2 و DeepSeek-V3.2-Speciale، وهي نماذج تتفوق في حل المشكلات المعقدة وسير العمل الذكي. تندمج هذه الأدوات بسلاسة في التطبيقات، لكن المطورين غالبًا ما يواجهون تحديات في الإعداد والمصادقة والتحسين. يقدم هذا المقال دليلاً تقنيًا خطوة بخطوة للاستفادة من هذه النماذج بفعالية.

button

فهم DeepSeek-V3.2: الأساس مفتوح المصدر للتفكير المتقدم

يقوم المطورون ببناء أنظمة ذكاء اصطناعي قوية على نماذج مفتوحة المصدر لأنها توفر الشفافية والتخصيص والتحسينات المدفوعة بالمجتمع. يُعد DeepSeek-V3.2 الخلف الرسمي لنسخة V3.2-Exp التجريبية، والتي أصدرتها DeepSeek سابقًا لاختبار آليات الانتباه المتناثرة. يُنشط هذا النموذج 37 مليار معلمة من إجمالي 671 مليار في بنيته المعمارية "مزيج الخبراء" (MoE)، وقد تم تدريبه على 14.8 تريليون رمز عالي الجودة. يُمكّن هذا النطاق DeepSeek-V3.2 من التعامل مع مهام متنوعة، بدءًا من توليد اللغة الطبيعية وحتى البراهين الرياضية المعقدة.

يكمن الابتكار الأساسي للنموذج في آلية DeepSeek Sparse Attention (DSA)، وهي آلية دقيقة تقلل من الحمل الحسابي أثناء الاستدلال، خاصةً للسياقات الطويلة التي تصل إلى 128,000 رمز. يقدر المهندسون ذلك لأنه يحافظ على جودة المخرجات مع تقليل وقت الاستجابة — وهو أمر بالغ الأهمية للتطبيقات في الوقت الفعلي مثل روبوتات الدردشة أو مساعدي الأكواد. علاوة على ذلك، يدمج DeepSeek-V3.2 أوضاع "التفكير"، حيث يولد النموذج خطوات استدلال وسيطة قبل المخرجات النهائية، مما يعزز الدقة في المقاييس المعيارية مثل AIME 2025 و HMMT 2025.

يمكنك الوصول إلى النسخة مفتوحة المصدر على Hugging Face عبر deepseek-ai/DeepSeek-V3.2. يقوم المطورون بتنزيل الأوزان والتكوينات مباشرة، مما يتيح النشر المحلي على مجموعات وحدات معالجة الرسوميات (GPU). على سبيل المثال، استخدم مكتبة Transformers لتحميل النموذج:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

model_name = "deepseek-ai/DeepSeek-V3.2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.bfloat16,

device_map="auto"

)

prompt = "Solve this equation: x^2 + 3x - 4 = 0"

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=200, do_sample=False)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(response)

يهيئ مقتطف الشفرة هذا النموذج بدقة bfloat16 لتحقيق الكفاءة على وحدات معالجة الرسوميات (GPUs) الحديثة من NVIDIA. ومع ذلك، تتطلب التشغيلات المحلية أجهزة قوية — يُوصى بما لا يقل عن 8 وحدات معالجة رسوميات A100 للدقة الكاملة. ونتيجة لذلك، تختار العديد من الفرق الإصدارات الكمية عبر مكتبات مثل bitsandbytes لتناسب أجهزة المستهلك.

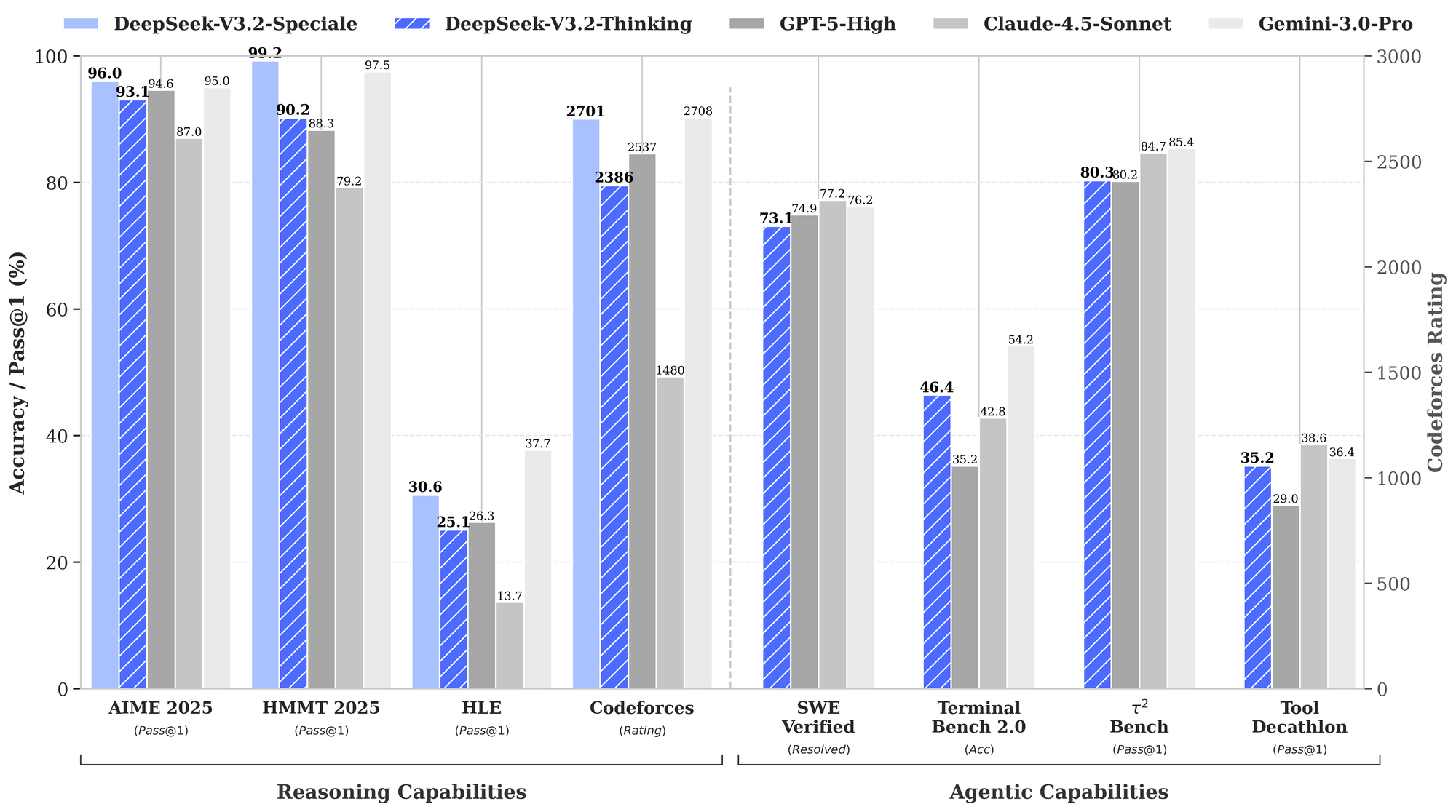

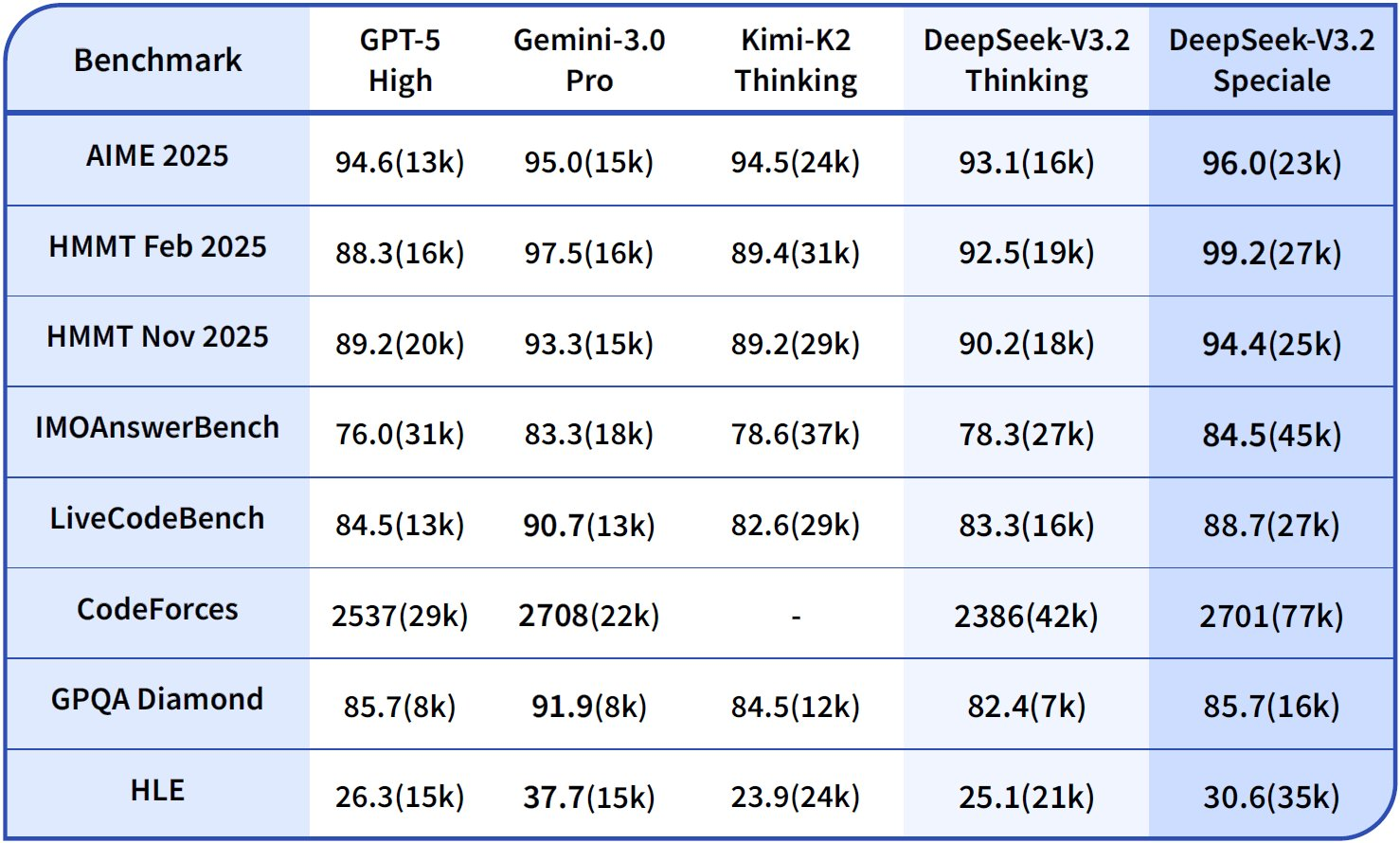

تُبرز المقاييس المعيارية نقاط قوة DeepSeek-V3.2. ففي مهام التفكير، يحقق 93.1% في اختبار AIME 2025 (pass@1)، متجاوزًا نسبة 90.2% لـ GPT-5-High. وبالنسبة للقدرات الذكية (agentic capabilities)، يحل 2,537 مشكلة في SWE-Bench Verified، متفوقًا بفارق ضئيل على Claude-4.5-Sonnet الذي حل 2,536 مشكلة. تضع هذه المقاييس DeepSeek-V3.2 كـ "مُشغل يومي" متوازن لبيئات الإنتاج، حيث تكتسب سرعة الاستدلال أهمية تُماثل أهمية الذكاء الخام.

علاوة على ذلك، يدعم النموذج امتدادات متعددة الوسائط في التحديثات المستقبلية، لكن الإصدارات الحالية تركز على الاستدلال النصي. يقوم المهندسون بضبطه بدقة على مجموعات بيانات خاصة بالمجال باستخدام محولات LoRA، مع الحفاظ على القدرات الأساسية أثناء التكيف مع مجالات متخصصة مثل التحليل القانوني أو المحاكاة العلمية. ونتيجة لذلك، يُمكّن الوصول مفتوح المصدر من النماذج الأولية السريعة دون التقيد بمورد واحد.

استكشاف DeepSeek-V3.2-Speciale: مُحسّن لأداء التفكير الأقصى

بينما يوفر DeepSeek-V3.2 فائدة واسعة، يستهدف DeepSeek-V3.2-Speciale السيناريوهات التي تتطلب أقصى عمق معرفي. يدفع هذا المتغير حدود التفكير، منافسًا Gemini-3.0-Pro في المسابقات النخبوية. يحقق نتائج الميدالية الذهبية في IMO 2025، CMO، نهائيات ICPC العالمية، و IOI 2025 — إنجازات تتطلب تسلسلًا منطقيًا دقيقًا وحل المشكلات بشكل إبداعي.

يعتمد DeepSeek-V3.2-Speciale على نفس أساس MoE ولكنه يدمج مراحل تعلم التعزيز المحسّنة من ردود الفعل البشرية (RLHF)، مع التركيز على السلوكيات الذكية. على عكس النموذج الأساسي، فإنه يولد عمليات تفكير داخلية أطول، والتي تستهلك المزيد من الرموز ولكنها تحقق دقة فائقة في مهام مثل استخدام الأدوات في بيئات متعددة الخطوات. على سبيل المثال، يقوم بتجميع بيانات التدريب عبر أكثر من 1,800 عالم محاكاة وأكثر من 85,000 تعليمات، مما يتيح التعامل القوي مع السيناريوهات غير المرئية.

شاهد بطاقة النموذج على Hugging Face عبر deepseek-ai/DeepSeek-V3.2-Speciale. يتم التنزيل باتباع عملية مماثلة:

model_name = "deepseek-ai/DeepSeek-V3.2-Speciale"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.bfloat16,

trust_remote_code=True,

device_map="auto"

)

prompt = "Prove that the sum of angles in a triangle is 180 degrees."

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=500, temperature=0.1)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(response)

لاحظ علامة trust_remote_code=True، حيث تستخدم Speciale تطبيقات انتباه مخصصة. يتطلب هذا الإعداد ذاكرة VRAM أكبر — تصل إلى 1 تيرابايت للاستدلال غير الكمي — مما يجعله مثاليًا لمختبرات الأبحاث بدلاً من الأجهزة الطرفية.

تُبرز بيانات الأداء تفوقه. يوضح الرسم البياني للمقاييس المعيارية DeepSeek-V3.2-Speciale (الأشرطة الزرقاء) يتصدر في التفكير: 99.0% في HMMT 2025 (pass@1) مقابل 97.5% لـ GPT-5-High، ودقة 84.8% في Codeforces (التقييم) مقابل 84.7% لـ Claude-4.5-Sonnet. في المجالات الذكية، يتفوق في Terminal-Bench v0.2 (بنسبة دقة 84.3%) واستخدام الأدوات (pass@1)، غالبًا بفروق ضئيلة تتراكم في العمليات المتسلسلة. ومع ذلك، فإن استخدام الرموز الأعلى — ما يصل إلى 50% أكثر من V3.2 — يستلزم هندسة سريعة دقيقة للتحكم في التكاليف.

نظرًا لأن Speciale يفتقر إلى استخدام الأدوات الأصلي في إصداره الأولي، يقوم المطورون بربطه بواجهات برمجة تطبيقات خارجية لوكلاء هجينين. يبرز هذا النهج في التقييمات، حيث يتفوق على أقرانه في أكثر من 85 ألف معيار تعليمي. بشكل عام، يناسب DeepSeek-V3.2-Speciale التطبيقات عالية المخاطر، مثل إثبات النظريات الآلي أو محاكاة التخطيط الاستراتيجي.

الانتقال من المصدر المفتوح إلى واجهة برمجة التطبيقات (API): لماذا يعد الوصول المستضاف مهمًا

توفر عمليات النشر المحلية التحكم، ومع ذلك فإن التوسع يُدخل تعقيدات مثل توفير الأجهزة وصيانتها. يتجه المطورون إلى واجهات برمجة التطبيقات (APIs) للوصول الفوري، واقتصاد الدفع حسب الاستخدام، والبنية التحتية المدارة. توفر DeepSeek نقاط نهاية مستضافة لكل من V3.2 و V3.2-Speciale، مما يضمن التوافق مع واجهات على غرار OpenAI. يُسرّع هذا التحول من عملية النماذج الأولية، حيث تتجاوز الفرق عقبات الإعداد وتركز على التكامل.

علاوة على ذلك، يفتح الوصول إلى واجهة برمجة التطبيقات ميزات المؤسسات، مثل تحديد المعدل والتخزين المؤقت، مما يحسن أحمال الإنتاج. على سبيل المثال، تقلل عمليات التخزين المؤقت تكاليف الإدخال بشكل كبير، مما يجعل الاستعلامات المتكررة اقتصادية. ونتيجة لذلك، تعتمد الشركات الناشئة والمؤسسات نقاط النهاية هذه لعمليات النشر الحساسة للتكلفة.

الوصول إلى واجهة برمجة تطبيقات DeepSeek: إعداد خطوة بخطوة

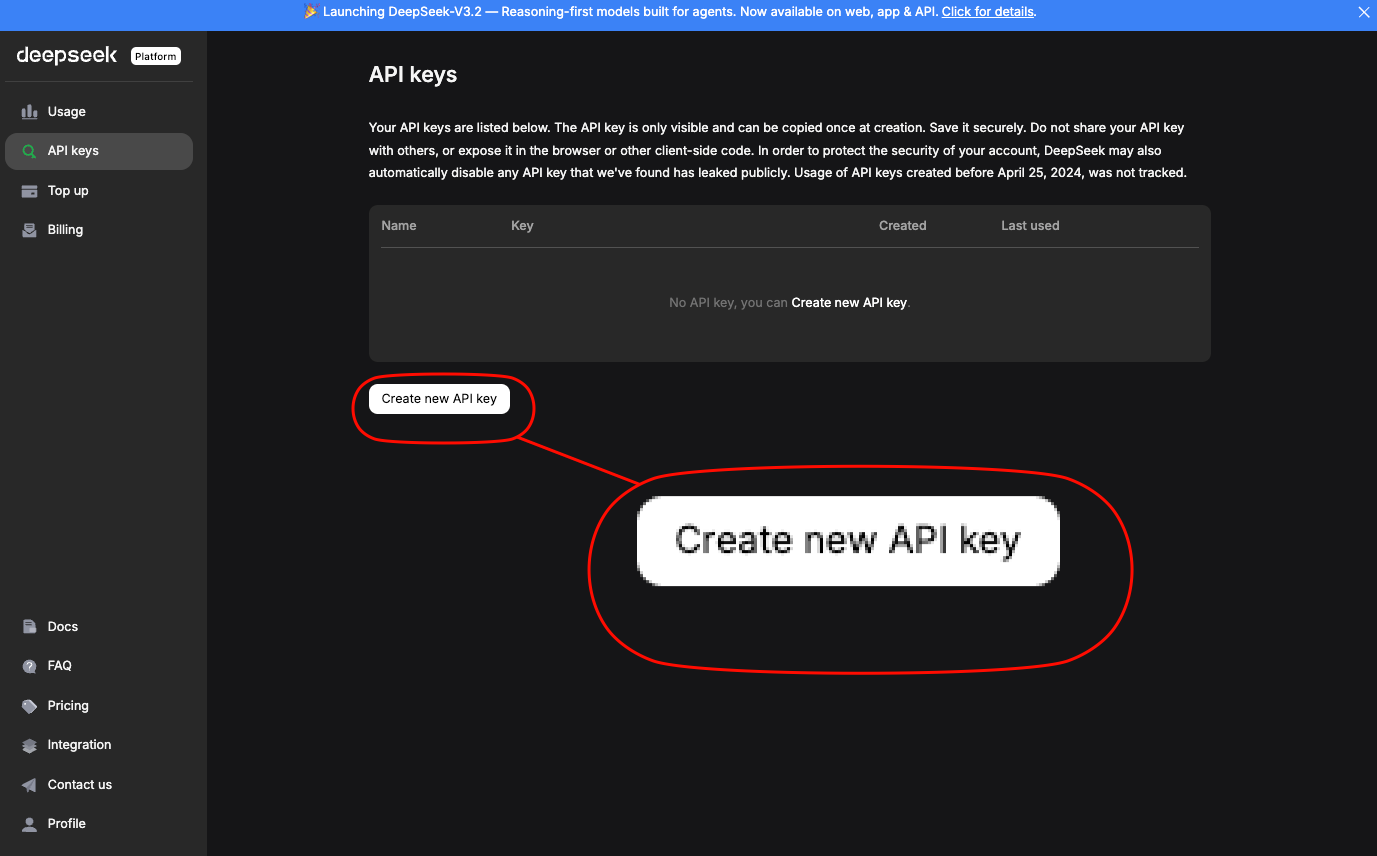

يصل المهندسون إلى واجهة برمجة تطبيقات DeepSeek عبر المنصة الرسمية. أولاً، أنشئ حسابًا وقم بإنشاء مفتاح API ضمن قسم "مفاتيح API". يُصادق هذا المفتاح الطلبات عبر ترويسة Authorization: Bearer YOUR_API_KEY.

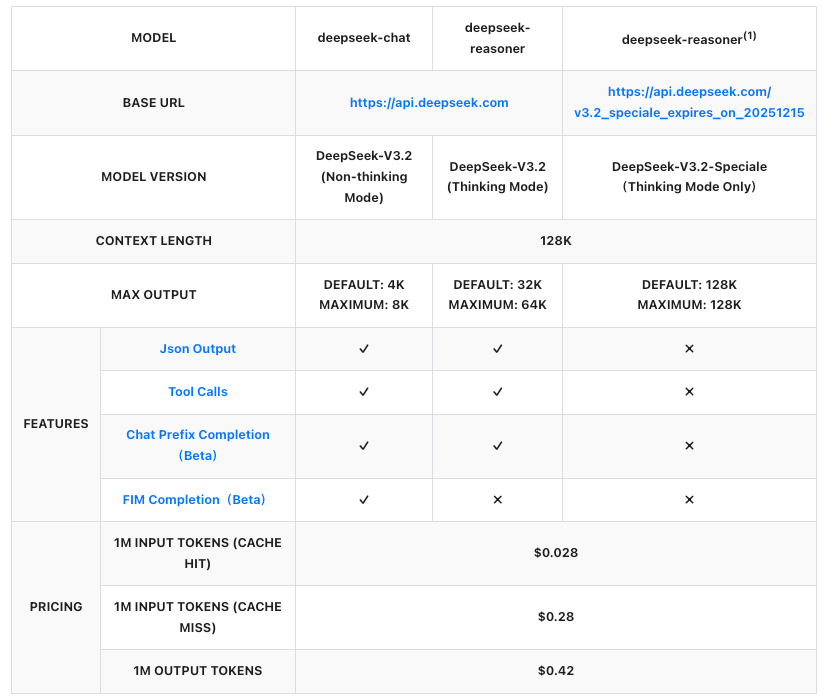

عنوان URL الأساسي هو https://api.deepseek.com/v1. لنموذج DeepSeek-V3.2، استخدم معرّف النموذج deepseek-v3.2. يعمل DeepSeek-V3.2-Speciale على نقطة نهاية مؤقتة: https://api.deepseek.com/v3.2_speciale_expires_on_20251215، وهي متاحة حتى 15 ديسمبر 2025، الساعة 15:59 بالتوقيت العالمي المنسق (UTC). بعد هذا التاريخ، ستندمج ضمن العروض القياسية.

قم بتثبيت حزمة OpenAI SDK للتبسيط:

pip install openai

ثم، قم بتكوين عميل:

from openai import OpenAI

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.deepseek.com/v1"

)

أرسل طلب إكمال لـ DeepSeek-V3.2:

response = client.chat.completions.create(

model="deepseek-v3.2",

messages=[

{"role": "system", "content": "You are a helpful assistant focused on reasoning."},

{"role": "user", "content": "Explain quantum entanglement in simple terms."}

],

max_tokens=300,

temperature=0.7

)

print(response.choices[0].message.content)

بالنسبة لـ DeepSeek-V3.2-Speciale، قم بتعديل base_url والنموذج:

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.deepseek.com/v3.2_speciale_expires_on_20251215"

)

response = client.chat.completions.create(

model="deepseek-v3.2-speciale",

messages=[{"role": "user", "content": "Solve: Integrate e^x sin(x) dx."}],

max_tokens=500

)

تُرجع هذه الاستدعاءات استجابات JSON مع إحصائيات الاستخدام، بما في ذلك رموز المطالبة والإكمال. تعامل مع الأخطاء عبر كتل try-except، وتحقق من حدود المعدل (مثل 10,000 طلب في الدقيقة لـ V3.2).

بالإضافة إلى ذلك، قم بتمكين أوضاع التفكير عن طريق إضافة /thinking إلى اسم النموذج، على سبيل المثال، deepseek-v3.2/thinking. يؤدي هذا إلى تشغيل التفكير خطوة بخطوة، وهو مثالي لتصحيح الأخطاء في الاستعلامات المعقدة.

تسعير واجهة برمجة التطبيقات (API): توسيع نطاق فعال من حيث التكلفة لـ DeepSeek-V3.2 و Speciale

تشكل نماذج التسعير حجر الزاوية في اعتماد واجهات برمجة التطبيقات، وتقوم DeepSeek ببنائها بشفافية لكل مليون رمز. تتبع كلا النموذجين نفس الأسعار، وتُحاسب على الإدخال (نجاح/فشل التخزين المؤقت) والإخراج. تُطبق نجاحات التخزين المؤقت على البادئات المتكررة داخل الجلسات، مما يقلل التكاليف لسير العمل التكراري.

تمثل هذه الأرقام تخفيضات تزيد عن 50% عن الإصدارات السابقة، مما يجعل DeepSeek منافسًا لواجهات برمجة التطبيقات الاحتكارية. على سبيل المثال، تبلغ تكلفة إنشاء استجابة بـ 1000 رمز على مطالبة بـ 500 رمز (فشل التخزين المؤقت) حوالي 0.00035 دولار — وهو مبلغ ضئيل لمعظم حالات الاستخدام. تتفاوض الشركات على خطط مخصصة لكميات أكبر، لكن نظام الدفع حسب الاستخدام يناسب المطورين.

نتيجة لذلك، تتوقع الفرق النفقات باستخدام مقدّرات الرموز في لوحة تحكم DeepSeek. ضع في اعتبارك استهلاك Speciale الأعلى للرموز؛ فقد يؤدي استعلام كثيف التفكير إلى مضاعفة التكاليف ولكنه يزيد الدقة أربع مرات في المقاييس المعيارية مثل Tau² (29.0% pass@1 لـ Speciale مقابل 25.1% لـ V3.2).

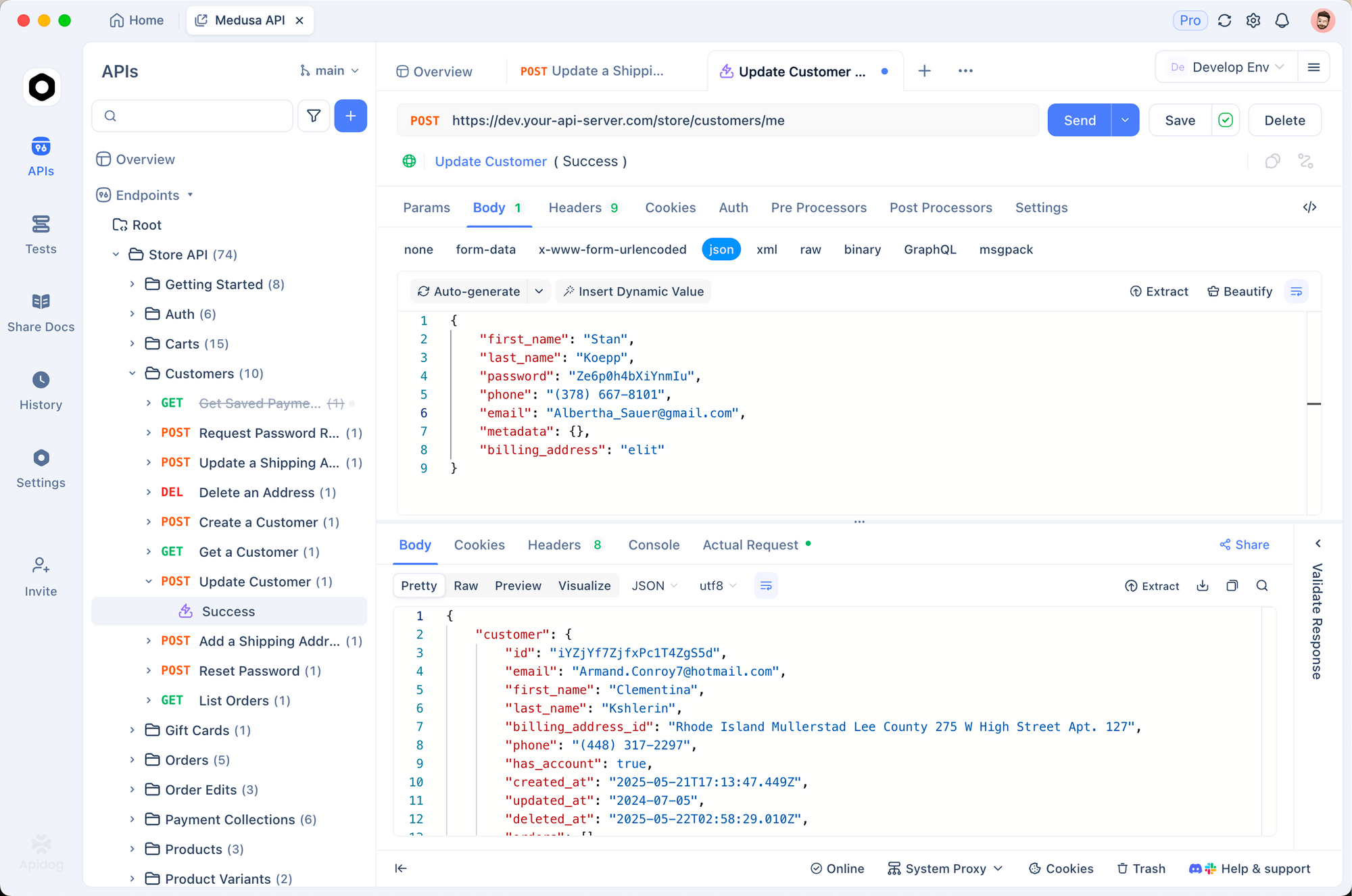

الدمج مع Apidog: اختبار وتوثيق واجهة برمجة التطبيقات (API) بكفاءة

يقوم المطورون بتبسيط سير العمل باستخدام أدوات مثل Apidog، التي تصمم وتختبر وتوثق واجهات برمجة التطبيقات بدون الحاجة إلى التعليمات البرمجية. قم باستيراد مفتاح API الخاص بـ DeepSeek إلى متغيرات بيئة Apidog، ثم أنشئ مجموعة طلبات جديدة لنقاط نهاية V3.2 و Speciale.

أنشئ طلب POST إلى /chat/completions:

- الترويسات (Headers):

Authorization: Bearer {{api_key}}،Content-Type: application/json - الجسم (Body): حمولة JSON تتضمن النموذج والرسائل والمعلمات.

قم بتشغيل الاختبارات في واجهة Apidog، التي تولد الاستجابات والتأكيدات تلقائيًا. على سبيل المثال، تحقق من أن إخراج Speciale يتجاوز 200 رمز في المطالبات الرياضية. علاوة على ذلك، يُصدّر Apidog مواصفات OpenAPI، مما يُسهل تسليم العمل بين الفرق.

يقلل هذا التكامل وقت تصحيح الأخطاء بنسبة 40%، حيث تبرز الفروق المرئية التناقضات. وتقوم الفرق أيضًا بمحاكاة الاستجابات للتطوير دون اتصال بالإنترنت، مما يضمن المتانة قبل النشر المباشر.

التقنيات المتقدمة: استخدام الأدوات وسير العمل الذكي

يقدم DeepSeek-V3.2 التفكير في استخدام الأدوات، مزجًا بين الاستدلال الداخلي والمكالمات الخارجية. حدد الأدوات في حمولة واجهة برمجة التطبيقات (API):

tools = [

{

"type": "function",

"function": {

"name": "calculator",

"description": "Perform basic math",

"parameters": {

"type": "object",

"properties": {"expression": {"type": "string"}}

}

}

}

]

response = client.chat.completions.create(

model="deepseek-v3.2",

messages=[{"role": "user", "content": "What is 15% of 250?"}],

tools=tools,

tool_choice="auto"

)

يقوم النموذج بالتفكير خطوة بخطوة، ثم يستدعي الأداة إذا لزم الأمر. Speciale، الذي لا يحتوي حاليًا على أدوات، يتكامل جيدًا كعراف للتفكير في سلاسل النماذج المتعددة.

بالنسبة للوكلاء، قم بالتنسيق عبر LangChain: قم بتضمين استدعاءات DeepSeek في وكلاء يوجهون المهام ديناميكيًا. يحل هذا الإعداد 73.1% من مشكلات SWE-Bench Verified، وفقًا للمقاييس المعيارية.

أفضل الممارسات للنشر في بيئة الإنتاج

قم بتحسين المطالبات باستخدام قوالب "سلسلة التفكير" للاستفادة من أوضاع التفكير. راقب استخدام الرموز عبر بيانات API الوصفية، ونفّذ إجراءات احتياطية للحدود القصوى للميزانية. قم بالتوسع باستخدام عملاء غير متزامنين في بايثون للتطبيقات عالية الإنتاجية.

يتطلب الأمان تدوير المفاتيح وقوائم IP البيضاء. أخيرًا، قم بالتقييم بشكل متكرر مقابل المقاييس المعيارية مثل تلك الواردة في التقرير التقني، مع تعديل المعاملات الفائقة لتناسب المجال.

الخاتمة: استغل قوة DeepSeek اليوم

يعيد DeepSeek-V3.2 و DeepSeek-V3.2-Speciale تعريف التفكير المتاح للذكاء الاصطناعي. من مرونة المصدر المفتوح إلى كفاءة واجهة برمجة التطبيقات، تمكّن هذه النماذج المطورين من بناء وكلاء أكثر ذكاءً. ابدأ بالتجارب المحلية، وانتقل إلى نقاط النهاية المستضافة، وادمج Apidog لإجراء اختبار سلس. مع تطور المعايير، يعد مسار DeepSeek بقدرات أكبر — ضع مشاريعك في المقدمة.

button