يطلق مهندسو DeepSeek DeepSeek-V3.1-Terminus كتحسين تكراري لنموذجهم V3.1، لمعالجة المشكلات التي أبلغ عنها المستخدمون مع تعزيز نقاط القوة الأساسية. يركز هذا الإصدار على التحسينات العملية التي يقدرها المطورون في التطبيقات الواقعية، مثل مخرجات اللغة المتسقة ووظائف الوكيل القوية. مع تطور نماذج الذكاء الاصطناعي، تعطي فرق مثل DeepSeek الأولوية للتحسينات التي تعزز الموثوقية دون إعادة بناء الأساس. وبالتالي، يظهر DeepSeek-V3.1-Terminus كأداة مصقولة للمهام التي تتراوح من إنشاء التعليمات البرمجية إلى الاستدلال المعقد.

يؤكد هذا الإصدار التزام DeepSeek بالابتكار مفتوح المصدر. يتوفر النموذج الآن على Hugging Face، مما يتيح الوصول الفوري للتجربة. يبني المهندسون على أساس V3.1، ويقدمون تعديلات تعزز الأداء عبر المعايير. ونتيجة لذلك، يواجه المستخدمون إحباطات أقل، مثل الاستجابات المختلطة باللغتين الصينية والإنجليزية أو الأحرف غير المنتظمة، والتي كانت تعيق التفاعلات السلسة سابقًا.

فهم بنية DeepSeek-V3.1-Terminus

صمم مهندسو DeepSeek نموذج DeepSeek-V3.1-Terminus بإطار عمل هجين من مزيج الخبراء (MoE)، مما يعكس بنية سلفه، DeepSeek-V3. يجمع هذا النهج بين المكونات الكثيفة والمتفرقة، مما يسمح للنموذج بتنشيط الخبراء ذوي الصلة فقط للمهام المحددة. وبالتالي، يحقق كفاءة عالية، ويعالج الاستعلامات بتكلفة حسابية مخفضة مقارنة بالنماذج الكثيفة بالكامل.

في جوهره، يضم النموذج 685 مليار معلمة، موزعة عبر وحدات الخبراء. يستخدم المهندسون أنواع الموترات BF16 و F8_E4M3 و F32 لهذه المعلمات، مما يحقق أقصى قدر من الدقة والسرعة. ومع ذلك، هناك مشكلة ملحوظة تتعلق بعدم التزام إسقاط مخرجات الانتباه الذاتي بشكل كامل بتنسيق مقياس UE8M0 FP8، وهو ما تخطط DeepSeek لحله في التكرارات القادمة. هذا العيب الطفيف لا ينتقص بشكل كبير من الوظائف الكلية ولكنه يسلط الضوء على الطبيعة التكرارية لتطوير النموذج.

علاوة على ذلك، يدعم DeepSeek-V3.1-Terminus كلاً من وضع التفكير ووضع عدم التفكير. في وضع التفكير، ينخرط النموذج في استدلال متعدد الخطوات، مستفيدًا من المنطق الداخلي لمعالجة المشكلات المعقدة. أما وضع عدم التفكير، على النقيض من ذلك، فيعطي الأولوية للاستجابات السريعة للاستعلامات المباشرة. ينبع هذا الازدواج من التدريب اللاحق على نقطة فحص V3.1-Base ممتدة، والتي تتضمن طريقة تمديد السياق الطويل على مرحلتين. يجمع المطورون مستندات طويلة إضافية لتعزيز مجموعة البيانات، مما يوسع مراحل التدريب لتحسين معالجة السياق.

التحسينات الرئيسية في DeepSeek-V3.1-Terminus مقارنة بالإصدارات السابقة

يعمل مهندسو DeepSeek على تحسين DeepSeek-V3.1-Terminus من خلال معالجة الملاحظات الواردة من إصدار V3.1، مما أدى إلى تحسينات ملموسة. في المقام الأول، قاموا بتقليل عدم اتساق اللغة، والقضاء على الخلط المتكرر بين الصينية والإنجليزية والأحرف العشوائية التي كانت تعيق المخرجات السابقة. يضمن هذا التغيير استجابات أنظف وأكثر احترافية، خاصة في البيئات متعددة اللغات.

بالإضافة إلى ذلك، تبرز ترقيات الوكلاء كتقدم كبير. يتعامل وكلاء الكود الآن مع مهام البرمجة بدقة عالية، بينما يحسن وكلاء البحث كفاءة الاسترجاع. تنبع هذه التحسينات من بيانات التدريب المحسنة والقوالب المحدثة، مما يسمح للنموذج بدمج الأدوات بسلاسة أكبر.

تكشف مقارنات المعايير عن هذه المكاسب كميًا. على سبيل المثال، في وضع الاستدلال بدون استخدام الأدوات، ترتفع درجات MMLU-Pro من 84.8 إلى 85.0، ويتحسن GPQA-Diamond من 80.1 إلى 80.7. يشهد اختبار Humanity's Last Exam قفزة كبيرة من 15.9 إلى 21.7، مما يدل على أداء أقوى في التقييمات الصعبة. يظل LiveCodeBench مستقرًا تقريبًا عند 74.9، مع تقلبات طفيفة في Codeforces و Aider-Polyglot.

بالانتقال إلى استخدام الأدوات الوكيلة، يتفوق النموذج بشكل أكبر. يزداد BrowseComp من 30.0 إلى 38.5، ويصعد SimpleQA من 93.4 إلى 96.8. يتقدم SWE Verified إلى 68.4 من 66.0، و SWE-bench Multilingual إلى 57.8 من 54.5، و Terminal-bench إلى 36.7 من 31.3. على الرغم من انخفاض BrowseComp-zh قليلاً، إلا أن الاتجاهات العامة تشير إلى موثوقية فائقة.

علاوة على ذلك، يحقق DeepSeek-V3.1-Terminus هذه النتائج دون التضحية بالسرعة. يستجيب بشكل أسرع من بعض المنافسين مع الحفاظ على جودة مماثلة لـ DeepSeek-R1 في المعايير الصعبة. ينبع هذا التوازن من التدريب اللاحق المحسن، الذي يدمج بيانات السياق الطويل لتعميم أفضل.

معايير الأداء وتقييمات DeepSeek-V3.1-Terminus

يقوم المقيمون بتقييم DeepSeek-V3.1-Terminus عبر معايير متنوعة، كاشفين عن نقاط قوته في الاستدلال ودمج الأدوات. في الاستدلال بدون أدوات، يحرز النموذج 85.0 على MMLU-Pro، مما يدل على احتفاظ واسع بالمعرفة. يصل GPQA-Diamond إلى 80.7، مما يشير إلى الكفاءة في أسئلة مستوى الدراسات العليا.

علاوة على ذلك، يسلط اختبار Humanity's Last Exam عند 21.7 الضوء على تحسين التعامل مع الموضوعات الغامضة. توضح معايير الترميز مثل LiveCodeBench (74.9) و Aider-Polyglot (76.1) فائدة عملية، على الرغم من انخفاض Codeforces إلى 2046، مما يشير إلى مجالات لمزيد من الضبط.

بالانتقال إلى السيناريوهات الوكيلة، تعكس درجة BrowseComp البالغة 38.5 قدرات محسنة لتصفح الويب. تؤكد درجة SimpleQA شبه المثالية البالغة 96.8 دقتها في حل الاستعلامات. تؤكد مجموعات SWE-bench، بما في ذلك Verified (68.4) و Multilingual (57.8)، براعته في هندسة البرمجيات. يظهر Terminal-bench عند 36.7 الكفاءة في التفاعلات عبر سطر الأوامر.

مقارنةً، يتفوق DeepSeek-V3.1-Terminus على V3.1 في معظم المقاييس، محققًا ميزة تكلفة 68 ضعفًا مع الحد الأدنى من التنازلات في الأداء. ينافس النماذج ذات المصدر المغلق في الكفاءة، مما يجعله مثاليًا لتطبيقات الأعمال.

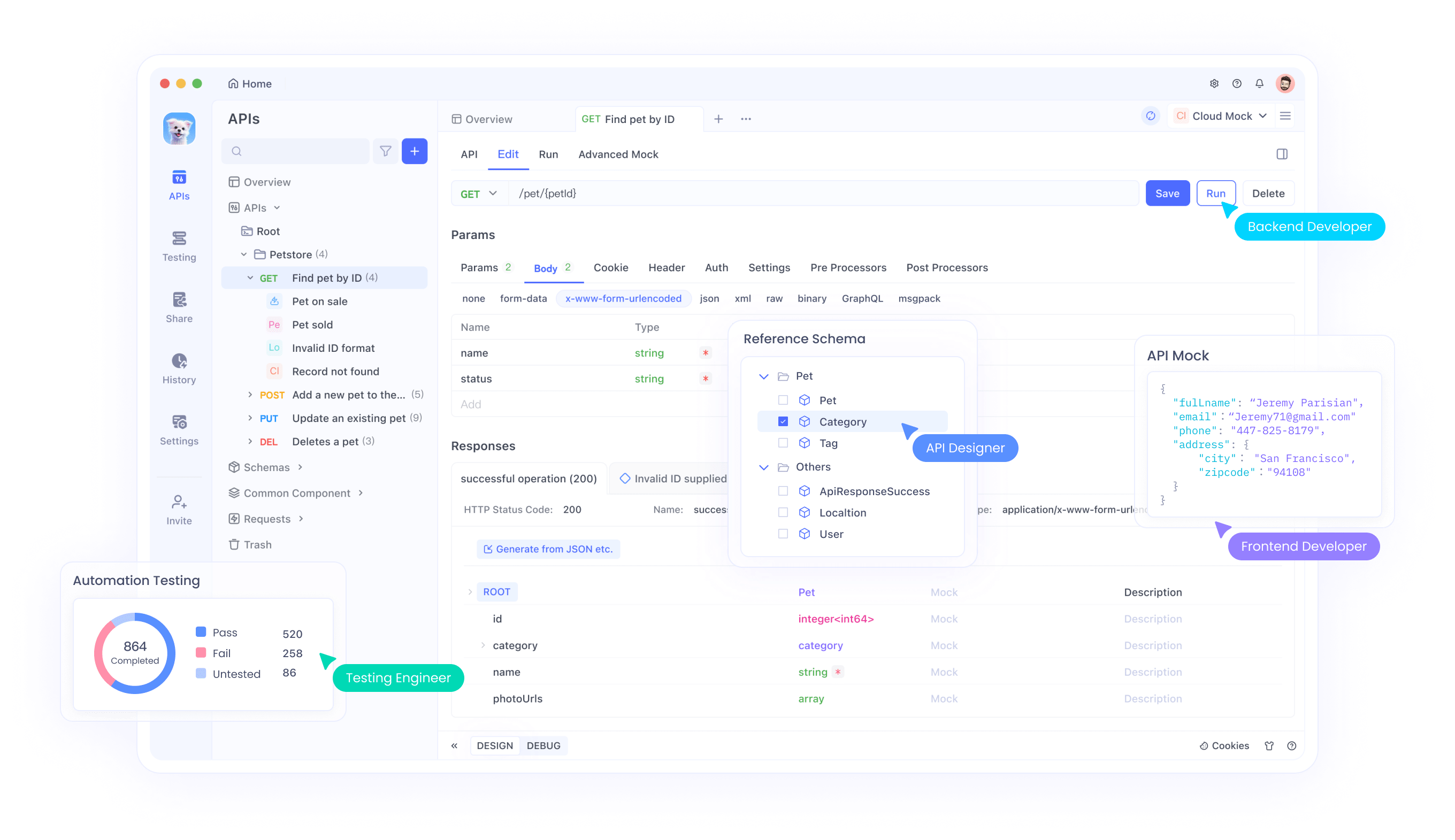

دمج DeepSeek-V3.1-Terminus مع واجهات برمجة التطبيقات والأدوات مثل Apidog

يقوم المطورون بدمج DeepSeek-V3.1-Terminus عبر واجهة برمجة التطبيقات المتوافقة مع OpenAI، مما يبسط عملية الاعتماد. يحددون 'deepseek-chat' لوضع عدم التفكير أو 'deepseek-reasoner' لوضع التفكير.

للبدء، ينشئ المستخدمون مفتاح API على منصة DeepSeek. باستخدام Apidog، يقومون بإعداد البيئات عن طريق إدخال عنوان URL الأساسي (https://api.deepseek.com) وتخزين المفتاح كمتغير. يسهل هذا الإعداد اختبار إكمال الدردشة واستدعاءات الوظائف.

علاوة على ذلك، يدعم Apidog تصحيح الأخطاء، مما يسمح للمطورين بالتحقق من الاستجابات بكفاءة. لاستدعاء الوظائف، يقومون بتعريف الأدوات في الطلبات، مما يمكن النموذج من استدعاء الوظائف الخارجية ديناميكيًا.

تظل الأسعار تنافسية عند 1.68 دولار لكل مليون رمز إخراج، مما يشجع على الاستخدام الواسع النطاق. تمتد عمليات التكامل إلى أطر عمل مثل Geneplore AI أو AI/ML API، مما يدعم أنظمة الوكلاء المتعددين.

مقارنات مع نماذج الذكاء الاصطناعي المنافسة

يتنافس DeepSeek-V3.1-Terminus بفعالية ضد نماذج مثل DeepSeek-R1، مطابقًا الجودة في الاستدلال مع الاستجابة بشكل أسرع. يتفوق على V3.1 في استخدام الأدوات، مع مكاسب BrowseComp قدرها 8.5 نقطة.

مقارنة بالخيارات الاحتكارية، فإنه يوفر إمكانية الوصول مفتوح المصدر وكفاءة التكلفة. على سبيل المثال، يقترب من أداء مستوى Sonnet في المعايير.

علاوة على ذلك، توفر أوضاعه الهجينة مرونة غائبة في بعض المنافسين. لذلك، فإنه يجذب المطورين المهتمين بالميزانية الذين يبحثون عن ميزات قوية.

استراتيجيات النشر لـ DeepSeek-V3.1-Terminus

ينشر المهندسون النموذج محليًا باستخدام مستودع DeepSeek-V3. بالنسبة للسحابة، تستضيفه منصات مثل AWS Bedrock.

يساعد رمز الاستدلال المحسن في المستودع على الإعداد. لذلك، فإن قابلية التوسع تناسب البيئات المختلفة.

الميزات المتقدمة: استدعاء الوظائف ودمج الأدوات

ينفذ المطورون استدعاء الوظائف عن طريق تحديد المخططات في طلبات API. يتيح ذلك التفاعلات الديناميكية، مثل استعلام قواعد البيانات.

يساعد Apidog في اختبار هذه الميزات، مما يضمن عمليات تكامل قوية.

تحليل التكلفة ونصائح التحسين

بتكاليف منخفضة لكل رمز، يقدم DeepSeek-V3.1-Terminus قيمة. قم بالتحسين عن طريق اختيار الأوضاع بحكمة — وضع عدم التفكير للمهام البسيطة.

راقب الاستخدام عبر Apidog لإدارة النفقات بفعالية.

ملاحظات المستخدمين واستقبال المجتمع

يحتفل المستخدمون بالإصدار، مشيرين إلى مكاسب الاستقرار. يتوقع البعض V4، مما يعكس توقعات عالية.

تضج المنتديات مثل Reddit بالمناقشات حول نقاط قوته الوكيلة.

الخلاصة: تبني DeepSeek-V3.1-Terminus في تطوير الذكاء الاصطناعي

يعمل DeepSeek-V3.1-Terminus على تحسين قدرات الذكاء الاصطناعي، ويوفر للمطورين أداة قوية وفعالة. تمهد تحسيناته في الوكلاء واللغة الطريق لتطبيقات مبتكرة. مع تبني الفرق له، يستمر النموذج في التطور، مدفوعًا بمدخلات المجتمع.