اعتمد فريق بشكل كبير على الذكاء الاصطناعي لتوليد كود تطبيقاتهم - وهي ممارسة تُعرف الآن باسم "البرمجة البديهية" (vibe coding). في غضون أسبوع واحد من النشر، تم اختراق خادمهم. تمكن المطور الذي شارك هذه الحادثة من تخمين ناقل الهجوم على الفور لأن الثغرات الأمنية كانت متوقعة. تشرح هذه المقالة ما حدث بشكل خاطئ، ولماذا يعتبر الكود الذي يولده الذكاء الاصطناعي عرضة بشكل فريد للاستغلال الأمني، وتقدم قائمة تحقق ملموسة لتأمين المشاريع المدعومة بالذكاء الاصطناعي قبل وصولها إلى مرحلة الإنتاج.

الحادثة: ماذا حدث

ظهرت القصة في مجتمع r/webdev على Reddit في يناير 2026، وسرعان ما حصدت أكثر من 400 إعجاب وأثارت نقاشًا حادًا. شارك مطور ما حدث في شركته عندما تبنى زميلان "البرمجة البديهية" (vibe coding) – وهي ممارسة بناء التطبيقات بسرعة باستخدام أدوات توليد الأكواد بالذكاء الاصطناعي مثل ChatGPT، Claude، أو Cursor مع مراجعة يدوية قليلة جدًا.

كان الفريق متحمسًا. أطلقوا المنتج بسرعة. تولى الذكاء الاصطناعي كل شيء من استعلامات قاعدة البيانات إلى تدفقات المصادقة. عندما حان وقت النشر، اقترح الذكاء الاصطناعي حتى رقم الإصدار "16.0.0" لإصدارهم الأول – وهو تفصيل سيبدو ساخرًا بشكل قاتم لاحقًا.

بعد أسبوع واحد من النشر، تم اختراق الخادم.

لم يتفاجأ المطور الذي شارك القصة. وبالنظر إلى قاعدة الكود، تمكن على الفور من تحديد العديد من الثغرات الأمنية التي أدخلها الذكاء الاصطناعي. وكان المهاجمون قد عثروا عليها أيضًا.

هذه ليست حادثة معزولة. وقد حذر باحثو الأمن مما يسمونه "الثغرات الاصطناعية" (synthetic vulnerabilities) — وهي عيوب أمنية تظهر بشكل شبه حصري في الكود الذي يولده الذكاء الاصطناعي بسبب طريقة تدريب نماذج اللغة وكيفية تعاملها مع مهام البرمجة.

لماذا الكود الذي يولده الذكاء الاصطناعي عرضة للخطر

يتم تدريب مساعدي البرمجة بالذكاء الاصطناعي على مستودعات ضخمة من الكود العام. وهذا يخلق العديد من النقاط العمياء الأمنية:

1. بيانات التدريب تتضمن كودًا ضعيفًا

تحتوي GitHub و Stack Overflow ومواقع الدروس التعليمية على ملايين الأسطر من الكود غير الآمن. غالبًا ما تتجاهل الأمثلة المكتوبة لأغراض التعلم اعتبارات الأمان. وتبقى الأنماط المهملة في بيانات التدريب. ويتعلم الذكاء الاصطناعي من كل ذلك على حد سواء.

عندما تطلب من الذكاء الاصطناعي كتابة كود مصادقة، فقد يعيد إنتاج نمط من درس تعليمي لعام 2018 كان يفتقر إلى حماية CSRF، أو إجابة من Stack Overflow قامت بتخزين كلمات المرور كنص عادي للتبسيط.

2. الذكاء الاصطناعي يحسن الأداء من أجل "العمل" وليس "الأمان"

تولد نماذج اللغة كودًا يلبي المطالبة. إذا طلبت نقطة نهاية تسجيل دخول، فإن الذكاء الاصطناعي ينشئ شيئًا يسجل دخول المستخدمين. أما ما إذا كان هذا التنفيذ يقاوم حقن SQL، أو يقوم بتجزئة كلمات المرور بشكل صحيح، أو يتحقق من صلاحية رموز الجلسة، فهو أمر ثانوي بالنسبة للهدف الأساسي.

يختلف هذا اختلافًا جوهريًا عن طريقة تفكير المطورين ذوي الخبرة. يسأل المطورون الواعون بالأمن "كيف يمكن استغلال هذا؟" في كل خطوة. لا تطبق مساعدات الذكاء الاصطناعي هذه العقلية العدائية بشكل طبيعي.

3. قيود نافذة السياق تمنع الأمن الشامل

غالبًا ما تنشأ الثغرات الأمنية من التفاعلات بين المكونات. قد يوجد فحص المصادقة في ملف واحد بينما يفترض استعلام قاعدة البيانات في ملف آخر أن المصادقة قد حدثت بالفعل. لا تستطيع أدوات الذكاء الاصطناعي التي تولد الكود ملفًا بملف أو دالة بدالة دائمًا الحفاظ على سياق الأمان هذا.

4. المطورون يثقون في مخرجات الذكاء الاصطناعي أكثر من اللازم

هذا هو العامل البشري. عندما يأتي الكود من ذكاء اصطناعي يبدو واثقًا وكفؤًا، غالبًا ما يتخطى المطورون المراجعة الدقيقة التي سيطبقونها على الكود من عضو فريق مبتدئ. يتبنى نهج "البرمجة البديهية" (vibe coding) هذا صراحةً: إنشاء سريع، نشر سريع، إصلاح لاحقًا.

المشكلة هي أن الثغرات الأمنية غالبًا ما لا يمكن "إصلاحها لاحقًا" بمجرد أن يكتشفها المهاجمون أولاً.

أكثر 7 ثغرات أمنية شيوعًا في واجهات برمجة التطبيقات (APIs) التي يولّدها الذكاء الاصطناعي

بناءً على تحليل مستودعات الكود التي تم إنشاؤها بواسطة الذكاء الاصطناعي وعمليات تدقيق الأمان، تظهر هذه الثغرات الأمنية بشكل متكرر:

1. التحقق من الإدخال مفقود أو ضعيف

غالبًا ما تقبل نقاط النهاية التي تم إنشاؤها بواسطة الذكاء الاصطناعي مدخلات المستخدم مباشرة دون تنظيفها:

// تم إنشاؤه بواسطة الذكاء الاصطناعي: عرضة للحقن

app.post('/search', (req, res) => {

const query = req.body.searchTerm;

db.query(`SELECT * FROM products WHERE name LIKE '%${query}%'`);

});

يتطلب الإصلاح استعلامات معلمات، وحدودًا لطول الإدخال، والتحقق من الأحرف - وهي خطوات غالبًا ما يتجاهلها الذكاء الاصطناعي.

2. تدفقات مصادقة معطلة

تشمل المشاكل الشائعة ما يلي:

- الرموز المميزة المخزنة في localStorage بدلاً من ملفات تعريف الارتباط httpOnly

- انتهاء صلاحية الرمز المميز مفقود

- معرفات جلسة ضعيفة أو يمكن التنبؤ بها

- لا يوجد تحديد لمعدل محاولات تسجيل الدخول

- رموز إعادة تعيين كلمة المرور التي لا تنتهي صلاحيتها

3. كشف البيانات الزائد

يميل الذكاء الاصطناعي إلى إرجاع كائنات قاعدة البيانات الكاملة بدلاً من تحديد حقول معينة:

// تم إنشاؤه بواسطة الذكاء الاصطناعي: يعيد حقولًا حساسة

app.get('/user/:id', async (req, res) => {

const user = await User.findById(req.params.id);

res.json(user); // يتضمن passwordHash، internalNotes، إلخ.

});

4. فحص التفويض مفقود

ينشئ الذكاء الاصطناعي نقاط نهاية تعمل ولكنه ينسى التحقق من أن المستخدم الطالب لديه الإذن:

// تم إنشاؤه بواسطة الذكاء الاصطناعي: لا يوجد تحقق من الملكية

app.delete('/posts/:id', async (req, res) => {

await Post.deleteOne({ _id: req.params.id });

res.json({ success: true });

});

// يمكن لأي مستخدم مصادق عليه حذف أي منشور

5. تبعيات غير آمنة

غالبًا ما يقترح الذكاء الاصطناعي حزمًا شائعة دون التحقق من الثغرات الأمنية المعروفة:

// يقترح الذكاء الاصطناعي حزمة قديمة تحتوي على CVEs

const jwt = require('jsonwebtoken'); // الإصدار غير محدد

بدون تثبيت إصدار صريح وفحص للثغرات الأمنية، ترث المشاريع دينًا أمنيًا منذ اليوم الأول.

6. الأسرار وبيانات الاعتماد المضمنة في الكود

يظهر هذا بشكل متكرر ومثير للدهشة في الكود الذي يولده الذكاء الاصطناعي:

// تم إنشاؤه بواسطة الذكاء الاصطناعي: سر في الكود المصدري

const stripe = require('stripe')('sk_live_abc123...');

يتعلم الذكاء الاصطناعي من الدروس والأمثلة حيث تكون المفاتيح المضمنة في الكود شائعة لأغراض التوضيح.

7. رؤوس الأمان مفقودة

تفتقر تطبيقات Express أو Flask أو Rails التي يتم إنشاؤها بواسطة الذكاء الاصطناعي عادةً إلى:

- تكوين CORS (أو CORS متساهل بشكل مفرط)

- رؤوس Content-Security-Policy

- X-Frame-Options

- برمجيات وسيطة لتحديد المعدل

- فرض HTTPS

قائمة تحقق لاختبار الأمان للمشاريع المدعومة بالذكاء الاصطناعي

قبل نشر أي مشروع يحتوي على كود تم إنشاؤه بواسطة الذكاء الاصطناعي، قم بمراجعة قائمة التحقق هذه:

المصادقة والتفويض

- [ ] تتطلب جميع نقاط النهاية المصادقة عند الاقتضاء

- [ ] تتحقق فحوصات التفويض من ملكية المستخدم للموارد المطلوبة/قدرته على الوصول إليها

- [ ] كلمات المرور مجزأة باستخدام bcrypt، Argon2، أو ما شابه (عامل التكلفة ≥10)

- [ ] رموز الجلسة عشوائية بشكل تشفيري وتنتهي صلاحيتها

- [ ] محاولات تسجيل الدخول الفاشلة تخضع لتحديد المعدل

- [ ] رموز إعادة تعيين كلمة المرور تستخدم لمرة واحدة ومحددة بوقت

- [ ] تتضمن JWTs تاريخ انتهاء صلاحية ويتم التحقق منها على جانب الخادم

التحقق من المدخلات

- [ ] يتم التحقق من جميع مدخلات المستخدم للنوع والطول والتنسيق

- [ ] تستخدم استعلامات قاعدة البيانات عبارات معلَمية (parameterized statements)

- [ ] تتحقق عمليات تحميل الملفات من النوع والحجم وتفحص بحثًا عن البرامج الضارة

- [ ] يتم التحقق من عناوين URL وعمليات إعادة التوجيه مقابل القوائم المسموح بها

- [ ] تم تكوين محاليل JSON/XML بحدود للحجم

حماية البيانات

- [ ] تعيد استجابات API فقط الحقول الضرورية

- [ ] البيانات الحساسة مشفرة في وضع السكون

- [ ] تستخدم بيانات اعتماد قاعدة البيانات متغيرات البيئة، وليس الكود

- [ ] يتم تخزين الأسرار في أنظمة إدارة الأسرار المناسبة

- [ ] لا تحتوي السجلات على كلمات مرور أو رموز مميزة أو معلومات شخصية يمكن تحديدها (PII)

أمان النقل

- [ ] يتم فرض HTTPS في الإنتاج

- [ ] تم تكوين رؤوس HSTS

- [ ] يتطلب TLS 1.2+

- [ ] تتميز ملفات تعريف الارتباط الآمنة بعلامتي Secure و HttpOnly

أمان خاص بواجهة برمجة التطبيقات (API)

- [ ] تحديد المعدل يمنع إساءة الاستخدام

- [ ] تم تكوين CORS لأصول محددة، وليس

* - [ ] يسمح ترقيم إصدارات API بإهمال نقاط النهاية غير الآمنة

- [ ] لا تسرب رسائل الخطأ تفاصيل داخلية

- [ ] لدى GraphQL حدود لعمق/تعقيد الاستعلامات

التبعيات

- [ ] جميع الحزم لها إصدارات محددة مثبتة

- [ ]

npm audit/pip check/ ما شابه لا تظهر ثغرات أمنية حرجة - [ ] تم تكوين التحديثات التلقائية للتبعيات

- [ ] لا توجد حزم مهجورة أو غير مصانة

كيف تختبر أمان واجهة برمجة التطبيقات (API) قبل النشر

المراجعة اليدوية ليست كافية. تحتاج إلى اختبار منهجي يكتشف الثغرات التي أدخلها الذكاء الاصطناعي والتي فاتتك في مراجعتك.

الخطوة 1: الفحص الأمني الآلي

استخدم الأدوات المصممة لاكتشاف الثغرات الأمنية الشائعة:

# For Node.js projects

npm audit --audit-level=high

# For Python projects

pip-audit

# For container images

trivy image your-app:latest

الخطوة 2: اختبار أمان واجهة برمجة التطبيقات (API)

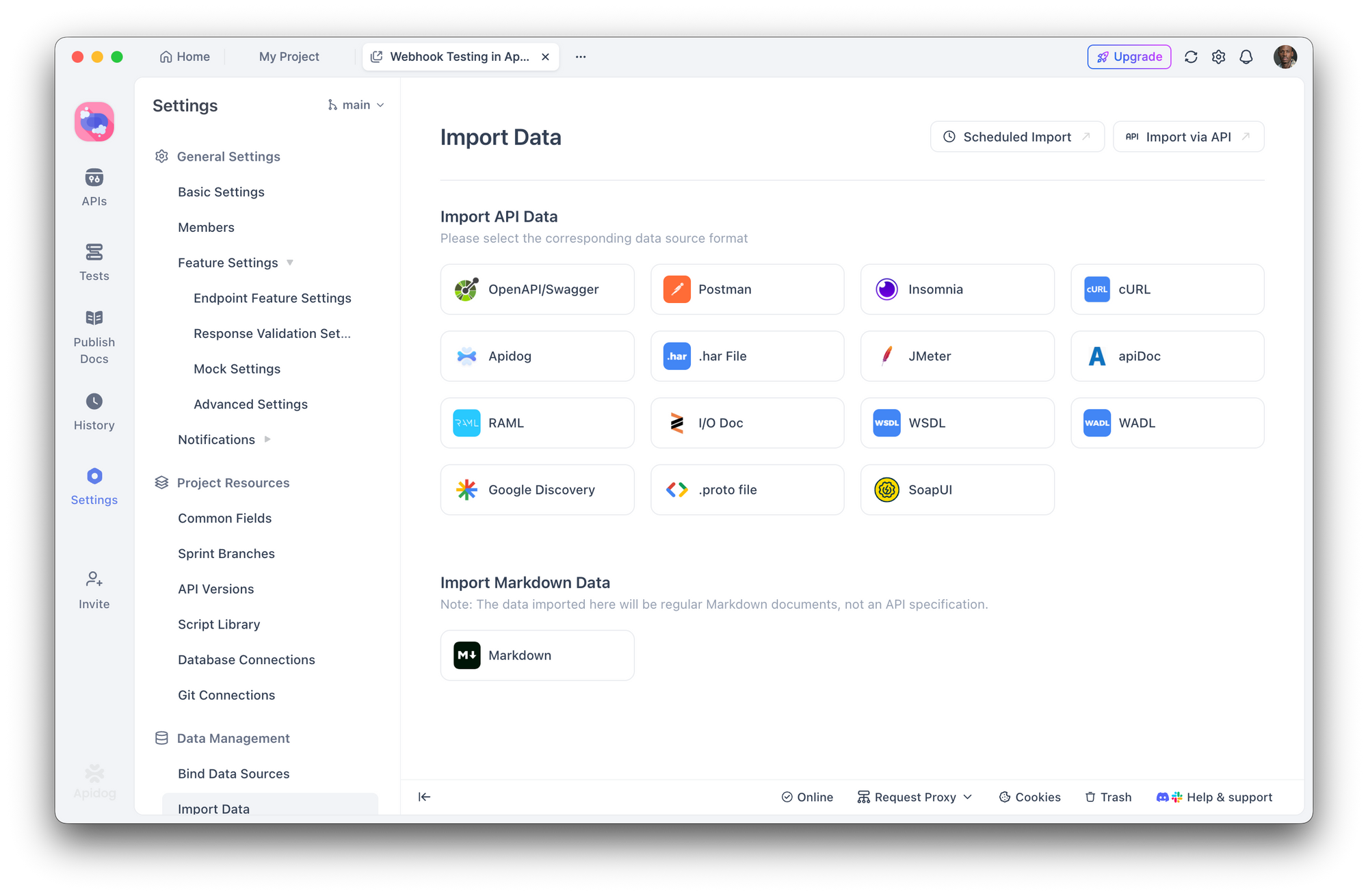

هنا يصبح Apidog ضروريًا. فبدلاً من اختبار كل نقطة نهاية يدويًا، يمكنك:

- استيراد مواصفات واجهة برمجة التطبيقات (API) الخاصة بك (OpenAPI/Swagger) أو دع Apidog يكتشف نقاط النهاية

2. إنشاء سيناريوهات اختبار أمان تتحقق مما يلي:

- المصادقة المفقودة تعيد 401

- المستخدم الخاطئ الذي يحاول الوصول إلى الموارد يعيد 403

- المدخلات غير الصالحة تعيد 400 مع رسائل خطأ آمنة

- محاولات حقن SQL محظورة

- تشغيل مجموعات الاختبار الآلية قبل كل عملية نشر

- الدمج مع CI/CD لاكتشاف الانحدارات

مع منشئ الاختبارات المرئي في Apidog، لا تحتاج إلى كتابة اختبارات الأمان من الصفر. حدد تأكيدات مثل "يجب ألا تحتوي الاستجابة على 'password'" أو "يجب أن يعيد الطلب بدون رمز مصادقة 401" وقم بتشغيلها عبر سطح واجهة برمجة التطبيقات بالكامل.

الخطوة 3: محاكاة اختبار الاختراق

اختبر واجهة برمجة التطبيقات (API) الخاصة بك كما يفعل المهاجم:

- تعداد نقاط النهاية - هل توجد مسارات مخفية أو غير موثقة؟

- اختبار تجاوز المصادقة - هل يمكنك الوصول إلى المسارات المحمية بدون رموز مميزة صالحة؟

- محاولة هجمات الحقن - SQL، NoSQL، حقن الأوامر في جميع حقول الإدخال

- التحقق من IDOR - هل يمكن للمستخدم A الوصول إلى بيانات المستخدم B عن طريق تغيير المعرفات؟

- إساءة استخدام حدود المعدل - ماذا يحدث عند 1000 طلب في الثانية؟

تتيح لك سيناريوهات اختبار Apidog محاكاة هذه الهجمات بشكل منهجي، مع حفظ النتائج للمقارنة عبر عمليات النشر.

الخطوة 4: تدقيق رؤوس الأمان

تحقق من رؤوس الاستجابة الخاصة بك:

curl -I https://your-api.com/endpoint

ابحث عن:

Strict-Transport-SecurityX-Content-Type-Options: nosniffX-Frame-Options: DENYContent-Security-Policy

بناء سير عمل يركز على الأمن أولاً باستخدام أدوات الذكاء الاصطناعي

مساعدات البرمجة بالذكاء الاصطناعي لن تختفي - بل تزداد قوة. الحل ليس في تجنبها، بل في بناء الأمن ضمن سير عملك.

هندسة المطالبات من أجل الأمن

عند استخدام الذكاء الاصطناعي لتوليد الكود، اطلب صراحة اعتبارات الأمان:

بدلاً من:

"أنشئ نقطة نهاية لتسجيل المستخدمين"

اسأل:

"أنشئ نقطة نهاية لتسجيل المستخدمين تتضمن التحقق من المدخلات، تجزئة كلمة المرور باستخدام bcrypt بعامل تكلفة 12، حماية ضد هجمات التوقيت، تحديد المعدل، ومعالجة الأخطاء المناسبة التي لا تسرب معلومات حول وجود عناوين البريد الإلكتروني"

مراحل المراجعة الإلزامية

أنشئ سير عمل يجب أن يمر فيه الكود الذي يولده الذكاء الاصطناعي عبر:

- مراجعة بشرية - هل يقوم هذا الكود بما قصدناه؟

- التدقيق الآلي (linting) - ESLint، Pylint مع إضافات الأمان

- فحص الأمان - Snyk، npm audit، فحص تبعيات OWASP

- اختبار واجهة برمجة التطبيقات (API) - مجموعات اختبار Apidog للتحقق من متطلبات الأمان

- نشر مرحلي - تشغيل اختبارات التكامل في بيئة واقعية

تعامل مع كود الذكاء الاصطناعي كمدخل غير موثوق به

هذا هو التحول الأساسي في التفكير. يجب التعامل مع الكود الناتج عن الذكاء الاصطناعي بنفس القدر من التشكك الذي تتعامل به مع الكود الوارد من مساهم غير معروف. هل ستنشر كودًا من طلب سحب عشوائي دون مراجعة؟ طبق نفس المعيار على الكود الذي يولده الذكاء الاصطناعي.

الخلاصة

لم يكن اختراق الخادم الذي حدث بعد أسبوع واحد من النشر بسبب مهاجمين متطورين أو استغلال ثغرات اليوم الصفري. لقد كان سببه ثغرات أمنية شائعة تقدمها أدوات الذكاء الاصطناعي بشكل روتيني وتغفلها ممارسات "البرمجة البديهية" (vibe coding) بشكل روتيني.

توليد الكود بالذكاء الاصطناعي قوي. إنه يسرع عملية التطوير ويجعل المهام المعقدة سهلة الوصول. ولكن بدون اختبار أمني منهجي، تصبح هذه السرعة عبئًا.

أدوات مثل Apidog تجعل اختبار الأمان عمليًا من خلال السماح لك بتحديد ومتطلبات الأمان عبر سطح واجهة برمجة التطبيقات (API) الخاصة بك. الهدف ليس إبطاء عملية التطوير المدعومة بالذكاء الاصطناعي - بل هو بناء طبقة التحقق التي يتطلبها الكود الذي يولده الذكاء الاصطناعي.

لا يهتم خادمك بما إذا كان الكود قد كتبه إنسان أم ذكاء اصطناعي. إنه يهتم فقط بما إذا كان هذا الكود آمنًا.