Los desarrolladores buscan constantemente herramientas avanzadas que optimicen las tareas de codificación, y OpenAI lo logra con GPT-5-Codex-Mini. Este modelo representa una evolución compacta de la serie GPT-5-Codex, ofreciendo un rendimiento rentable para flujos de trabajo de codificación agénticos. Los ingenieros lo integran para manejar tareas como la generación de código, la depuración y la gestión de repositorios sin sacrificar capacidades esenciales. Sin embargo, acceder a su API requiere pasos específicos, que esta guía detalla.

La transición de los asistentes de codificación tradicionales a los impulsados por IA marca un cambio significativo, pero pequeños ajustes en la configuración producen mejoras sustanciales en la productividad. Por lo tanto, comprender el fundamento del modelo resulta crucial.

Comprensión de GPT-5-Codex-Mini: Capacidades y Arquitectura

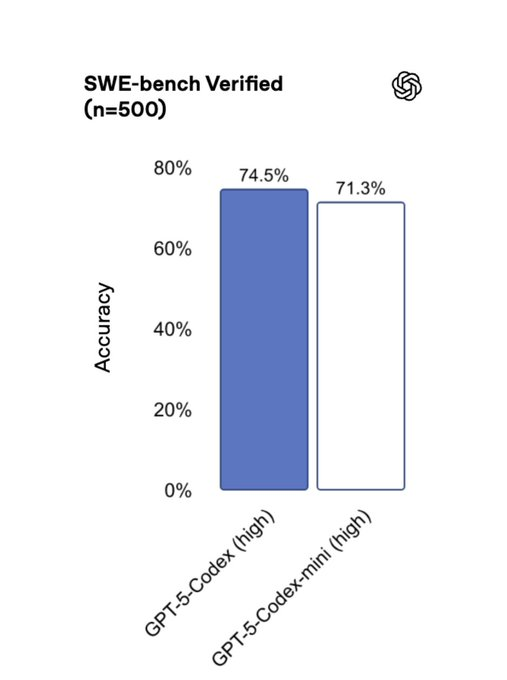

Los ingenieros de OpenAI diseñaron GPT-5-Codex-Mini como una variante más ligera de GPT-5-Codex, priorizando la eficiencia para escenarios de codificación bien definidos. El modelo destaca en la generación de código front-end, la depuración de grandes repositorios y la realización de refactorizaciones en lenguajes como Python, JavaScript y Go. A diferencia de su contraparte más grande, GPT-5-Codex-Mini consume menos recursos, lo que permite aproximadamente cuatro veces más uso por asignación de crédito.

Técnicamente, la arquitectura se basa en redes neuronales basadas en transformadores, optimizadas para la eficiencia de tokens. Procesa entradas con un tiempo de razonamiento dinámico, rápido para consultas simples pero extendido para tareas intrincadas que implican múltiples iteraciones. Por ejemplo, al refactorizar una base de código de 3.000 líneas, el modelo itera a través de implementaciones, ejecuta pruebas y valida dependencias de forma autónoma.

GPT-5-Codex-Mini se integra a la perfección con herramientas como Codex CLI y extensiones de IDE. Los desarrolladores lo activan en VS Code o Cursor para previsualizar cambios localmente, aprovechando fragmentos de código seleccionados para sugerencias conscientes del contexto. Este enfoque reduce la longitud de las indicaciones y acelera los tiempos de respuesta, lo que permite a los equipos mantener la continuidad del flujo de trabajo.

Sin embargo, los usuarios deben tener en cuenta la ligera compensación de capacidades: si bien maneja la mayoría de las tareas agénticas de manera efectiva, las integraciones complejas multilingües pueden requerir cambiar al GPT-5-Codex completo. En consecuencia, evaluar las necesidades de su proyecto de antemano garantiza una selección óptima del modelo.

Requisitos previos para acceder a la API de GPT-5-Codex-Mini

Acceder a la API de GPT-5-Codex-Mini exige una preparación cuidadosa. Primero, los desarrolladores verifican el estado de su cuenta de OpenAI. OpenAI estructura el acceso a través de niveles de uso, que van del 1 al 5, con modelos como GPT-5-Codex-Mini disponibles en todos los niveles, pero sujetos a la verificación de la organización para funciones avanzadas.

Comience creando una cuenta de OpenAI si no tiene una. Navegue a la plataforma de OpenAI y regístrese con un correo electrónico válido. A continuación, complete el proceso de verificación de la organización, que implica presentar detalles comerciales o prueba de identidad. Este paso desbloquea el acceso a modelos verificados, incluidas las capacidades de transmisión en la API de Respuestas.

Además, obtenga una clave API del panel de control. Inicie sesión, acceda a la sección de claves API y genere una nueva clave. Guárdela de forma segura, ya que autentica todas las solicitudes. Sin esta clave, los puntos finales permanecen inaccesibles.

Además, asegúrese de que su entorno de desarrollo sea compatible con las bibliotecas necesarias. Instale el SDK de Python de OpenAI a través de pip: pip install openai. Este paquete facilita las llamadas a la API, manejando la autenticación y el formato de la carga útil automáticamente.

Pasando a los requisitos de hardware, una conexión a internet estable y recursos computacionales suficientes resultan esenciales, especialmente para el procesamiento por lotes. Aunque GPT-5-Codex-Mini optimiza la eficiencia, el uso de alto volumen se beneficia de configuraciones basadas en la nube.

Registro en los planes de OpenAI y habilitación del acceso a la API

OpenAI ofrece planes escalonados que influyen en la disponibilidad de GPT-5-Codex-Mini. Los suscriptores de ChatGPT Plus obtienen acceso básico, adecuado para sesiones de codificación ocasionales. Sin embargo, para un uso extensivo, actualice a los planes Pro, Business o Enterprise. Estos proporcionan límites de tasa más altos —aumentados recientemente en un 50%— y procesamiento prioritario.

Para habilitar el acceso a la API, vincule su cuenta de ChatGPT a la plataforma de desarrollador. Inicie sesión con sus credenciales y el sistema sincronizará automáticamente los derechos. Para los usuarios solo de API, compren créditos directamente si superan los límites incluidos.

Además, esté atento a los anuncios de programas beta. Dado que el soporte de API para GPT-5-Codex-Mini se lanzó recientemente, únase a las listas de espera a través de los foros de la comunidad de OpenAI. Participe en las versiones preliminares para desarrolladores para obtener acceso anticipado, proporcionando comentarios que dan forma a futuras iteraciones.

Una vez activado, pruebe la conectividad. Envíe una solicitud simple al punto final /models para listar los modelos disponibles, confirmando que aparece GPT-5-Codex-Mini. Este paso de verificación evita problemas de integración posteriores.

En consecuencia, alinear su plan con la escala del proyecto maximiza el valor, ya que los niveles superiores ofrecen créditos ampliados y latencia reducida.

Generación y gestión de su clave API de OpenAI

La seguridad es la piedra angular de las interacciones con la API, así que genere su clave de forma responsable. Desde el panel de control de OpenAI, seleccione "API keys" y haga clic en "Create new secret key". Nómbrela de forma descriptiva, como "GPT-5-Codex-Mini-Project", para una fácil gestión.

Almacene la clave en variables de entorno en lugar de codificarla directamente. En Python, use os.environ['OPENAI_API_KEY'] para cargarla dinámicamente. Esta práctica mitiga los riesgos de exposición.

Además, rote las claves periódicamente. OpenAI permite revocar claves antiguas sin interrumpir las sesiones activas, garantizando el cumplimiento de los protocolos de seguridad.

Además, implemente la limitación de tasa en su aplicación. Supervise el uso a través del panel para evitar exceder los niveles, lo que podría desencadenar restricciones temporales.

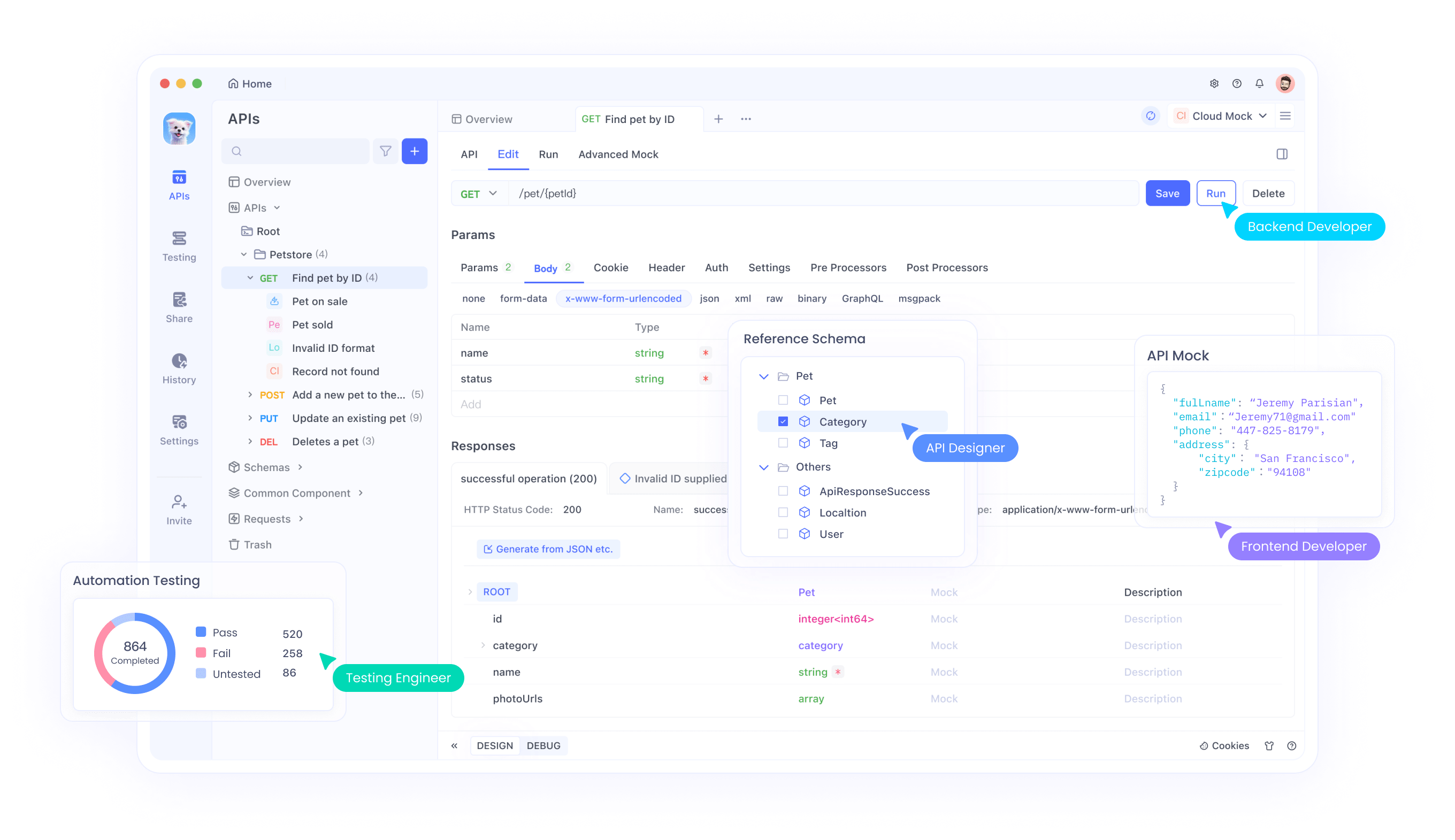

Pasando a las herramientas, Apidog simplifica la gestión de claves. Su bóveda segura almacena credenciales, automatizando la autenticación en entornos de prueba. Así, los desarrolladores se centran en la codificación en lugar de en las tareas administrativas.

Integración de GPT-5-Codex-Mini en su flujo de trabajo de desarrollo

La integración comienza con la selección del punto final adecuado. Use la API de Completions de Chat para consultas generales o la API de Respuestas para tareas agénticas. Especifique "gpt-5-codex-mini" como parámetro del modelo en el cuerpo de su solicitud.

Por ejemplo, cree un script de Python para generar código:

import openai

openai.api_key = os.getenv('OPENAI_API_KEY')

response = openai.ChatCompletion.create(

model="gpt-5-codex-mini",

messages=[

{"role": "system", "content": "You are a helpful coding assistant."},

{"role": "user", "content": "Write a Python function to sort a list using quicksort."}

]

)

print(response.choices[0].message['content'])

Esta llamada devuelve código optimizado, aprovechando la eficiencia del modelo.

Además, incorpore contexto de archivos. Adjunte fragmentos de código o diagramas a las indicaciones, mejorando la precisión para escenarios de depuración.

Sin embargo, optimice las indicaciones para la brevedad. GPT-5-Codex-Mini funciona mejor con instrucciones concisas, reduciendo el consumo de tokens.

Además, maneje las respuestas de forma asíncrona para aplicaciones en tiempo real. Utilice el modo de transmisión para recibir salidas parciales, mejorando la experiencia del usuario en las integraciones de IDE.

En consecuencia, las pruebas iterativas refinan la integración, revelando matices de rendimiento específicos de su caso de uso.

Uso de Apidog para probar y optimizar las llamadas a la API de GPT-5-Codex-Mini

Apidog se erige como un poderoso aliado para las pruebas de API. Descárguelo gratis e importe las especificaciones de la API de OpenAI. Cree colecciones para los puntos finales de GPT-5-Codex-Mini, definiendo solicitudes con variables para parámetros dinámicos.

Los ingenieros simulan escenarios enviando solicitudes simuladas. Por ejemplo, prueban los límites de tasa agrupando llamadas, analizando los tiempos de respuesta y las tasas de error.

Además, las funciones de colaboración de Apidog permiten a los equipos compartir conjuntos de pruebas, asegurando una integración consistente en todos los proyectos.

Pasando a la optimización, utilice sus análisis para identificar cuellos de botella. Supervise el uso de tokens y ajuste las indicaciones en consecuencia, extendiendo la vida útil de su crédito.

Además, integre Apidog con pipelines de CI/CD. Automatice pruebas para cambios en la API, detectando deprecaciones temprano.

Así, Apidog transforma el acceso a la API en un flujo de trabajo optimizado, amplificando los beneficios de GPT-5-Codex-Mini.

Mejores prácticas para la ingeniería de prompts con GPT-5-Codex-Mini

Los prompts efectivos generan resultados superiores. Estructurelos con roles claros: sistema para directrices, usuario para tareas. Incluya ejemplos para guiar el estilo, como "Siga los estándares PEP 8".

Además, divida tareas complejas en pasos. Instruya al modelo para que razone secuencialmente, mejorando la precisión en las refactorizaciones.

Sin embargo, evite sobrecargar los prompts. GPT-5-Codex-Mini prospera con entradas enfocadas, así que segmente las solicitudes grandes.

Además, aproveche la integración de herramientas. Habilite la búsqueda web o la ejecución de código en los prompts para respuestas dinámicas.

En consecuencia, la experimentación regular refina las técnicas, adaptándose a las fortalezas del modelo.

Gestión de límites de tasa y escalado de uso

OpenAI aplica límites de tasa para garantizar un acceso justo. Los usuarios Plus disfrutan de cuotas base, mientras que los niveles Pro ofrecen colas de prioridad.

Supervise el uso a través de los encabezados de la API, que informan las solicitudes restantes. Implemente una retirada exponencial para los reintentos, previniendo riesgos de prohibición.

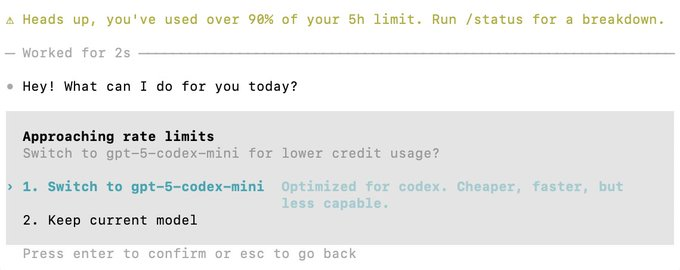

Además, cambie a GPT-5-Codex-Mini cuando se acerque a los límites, ya que extiende las sesiones sin interrupciones.

Pasando al escalado, distribuya las llamadas entre varias claves para aplicaciones de alto volumen. Los planes Enterprise lo soportan de forma nativa.

Así, la gestión proactiva mantiene el rendimiento, apoyando el crecimiento.

Conclusión: Maximizando el valor de GPT-5-Codex-Mini

Acceder e integrar GPT-5-Codex-Mini transforma los flujos de trabajo de codificación. Siga estos pasos para aprovechar su poder de manera eficiente.

Recuerde, herramientas como Apidog mejoran la experiencia: descárguelo gratis hoy mismo.

En última instancia, la aplicación consistente produce profundas ganancias de productividad.