Un equipo dependió en gran medida de la IA para generar el código de su aplicación, una práctica ahora llamada "programación intuitiva" (vibe coding). Una semana después de su despliegue, su servidor fue comprometido. El desarrollador que compartió este incidente pudo adivinar inmediatamente el vector de ataque porque las vulnerabilidades eran predecibles. Este artículo desglosa qué salió mal, por qué el código generado por IA es particularmente vulnerable a las exploits de seguridad y proporciona una lista de verificación concreta para asegurar proyectos asistidos por IA antes de que lleguen a producción.

El Incidente: Qué Sucedió

La historia surgió en la comunidad r/webdev de Reddit en enero de 2026, ganando rápidamente más de 400 votos positivos y provocando un intenso debate. Un desarrollador compartió lo que ocurrió en su empresa cuando dos colegas adoptaron la "programación intuitiva" (vibe coding), la práctica de construir aplicaciones rápidamente utilizando herramientas de generación de código de IA como ChatGPT, Claude o Cursor con una revisión manual mínima.

El equipo estaba emocionado. Lanzaron rápido. La IA se encargó de todo, desde consultas a bases de datos hasta flujos de autenticación. Cuando llegó el momento del despliegue, la IA incluso sugirió el número de versión "16.0.0" para su primera versión, un detalle que más tarde parecería oscuramente irónico.

Una semana después del despliegue, el servidor fue hackeado.

El desarrollador que compartió la historia no se sorprendió. Al analizar el código base, pudo identificar inmediatamente múltiples vulnerabilidades de seguridad que la IA había introducido. Los atacantes también las habían encontrado.

Este no es un incidente aislado. Los investigadores de seguridad han estado advirtiendo sobre lo que llaman "vulnerabilidades sintéticas", fallas de seguridad que aparecen casi exclusivamente en código generado por IA debido a cómo se entrenan los modelos de lenguaje y cómo abordan las tareas de codificación.

Por Qué el Código Generado por IA es Vulnerable

Los asistentes de codificación de IA se entrenan con vastos repositorios de código público. Esto crea varios puntos ciegos de seguridad:

1. Los Datos de Entrenamiento Incluyen Código Vulnerable

GitHub, Stack Overflow y los sitios web de tutoriales contienen millones de líneas de código inseguro. Los ejemplos escritos con fines de aprendizaje a menudo omiten consideraciones de seguridad. Los patrones obsoletos permanecen en los datos de entrenamiento. La IA aprende de todo por igual.

Cuando le pides a una IA que escriba código de autenticación, podría reproducir un patrón de un tutorial de 2018 que carecía de protección CSRF, o una respuesta de Stack Overflow que almacenaba contraseñas en texto plano por simplicidad.

2. La IA Optimiza para "Funcional" No para "Seguro"

Los modelos de lenguaje generan código que satisface la instrucción. Si pides un endpoint de inicio de sesión, la IA crea algo que permite a los usuarios iniciar sesión. Si esa implementación resiste la inyección SQL, hashea correctamente las contraseñas o valida los tokens de sesión es secundario al objetivo principal.

Esto es fundamentalmente diferente de cómo piensan los desarrolladores experimentados. Los desarrolladores conscientes de la seguridad se preguntan "¿cómo podría ser explotado esto?" en cada paso. Los asistentes de IA no aplican naturalmente esta mentalidad adversaria.

3. Las Limitaciones de la Ventana de Contexto Impiden la Seguridad Holística

Las vulnerabilidades de seguridad a menudo surgen de interacciones entre componentes. Una verificación de autenticación podría existir en un archivo, mientras que una consulta a la base de datos en otro archivo asume que la autenticación ya ocurrió. La IA que genera código archivo por archivo o función por función no siempre puede mantener este contexto de seguridad.

4. Los Desarrolladores Confían Demasiado en la Salida de la IA

Este es el factor humano. Cuando el código proviene de una IA que parece segura y competente, los desarrolladores a menudo omiten la revisión cuidadosa que aplicarían al código de un miembro junior del equipo. El enfoque de "programación intuitiva" (vibe coding) lo abraza explícitamente: generar rápido, lanzar rápido, arreglar después.

El problema es que las vulnerabilidades de seguridad a menudo no se pueden "arreglar después" una vez que los atacantes las encuentran primero.

Los 7 Agujeros de Seguridad Más Comunes en APIs Generadas por IA

Basado en el análisis de repositorios de código generado por IA y auditorías de seguridad, estas vulnerabilidades aparecen con mayor frecuencia:

1. Validación de Entrada Ausente o Débil

Los endpoints generados por IA a menudo aceptan la entrada del usuario directamente sin sanitización:

// Generado por IA: Vulnerable a la inyección

app.post('/search', (req, res) => {

const query = req.body.searchTerm;

db.query(`SELECT * FROM products WHERE name LIKE '%${query}%'`);

});

La solución requiere consultas parametrizadas, límites de longitud de entrada y validación de caracteres, pasos que la IA omite con frecuencia.

2. Flujos de Autenticación Rotos

Los problemas comunes incluyen:

- Tokens almacenados en localStorage en lugar de cookies httpOnly

- Caducidad de tokens ausente

- IDs de sesión débiles o predecibles

- Sin limitación de velocidad en intentos de inicio de sesión

- Tokens de restablecimiento de contraseña que no caducan

3. Exposición Excesiva de Datos

La IA tiende a devolver objetos completos de la base de datos en lugar de seleccionar campos específicos:

// Generado por IA: Devuelve campos sensibles

app.get('/user/:id', (req, res) => {

const user = await User.findById(req.params.id);

res.json(user); // Incluye passwordHash, internalNotes, etc.

});

4. Ausencia de Verificaciones de Autorización

La IA crea endpoints que funcionan pero olvida verificar que el usuario solicitante tenga permiso:

// Generado por IA: Sin verificación de propiedad

app.delete('/posts/:id', async (req, res) => {

await Post.deleteOne({ _id: req.params.id });

res.json({ success: true });

});

// Cualquier usuario autenticado puede eliminar cualquier publicación

5. Dependencias Inseguras

La IA a menudo sugiere paquetes populares sin verificar si tienen vulnerabilidades conocidas:

// La IA sugiere un paquete obsoleto con CVEs

const jwt = require('jsonwebtoken'); // Versión no especificada

Sin la fijación explícita de versiones y el escaneo de vulnerabilidades, los proyectos heredan deuda de seguridad desde el primer día.

6. Secretos y Credenciales Hardcodeados

Esto aparece sorprendentemente a menudo en el código generado por IA:

// Generado por IA: Secreto en el código fuente

const stripe = require('stripe')('sk_live_abc123...');

La IA aprende de tutoriales y ejemplos donde las claves hardcodeadas son comunes para fines de ilustración.

7. Encabezados de Seguridad Ausentes

Las aplicaciones Express, Flask o Rails generadas por IA suelen carecer de:

- Configuración CORS (o CORS excesivamente permisivo)

- Encabezados Content-Security-Policy

- X-Frame-Options

- Middleware de limitación de velocidad

- Aplicación de HTTPS

Una Lista de Verificación de Pruebas de Seguridad para Proyectos Asistidos por IA

Antes de desplegar cualquier proyecto con código generado por IA, revise esta lista de verificación:

Autenticación y Autorización

- [ ] Todos los endpoints requieren autenticación cuando sea apropiado

- [ ] Las verificaciones de autorización comprueban que el usuario posee/puede acceder a los recursos solicitados

- [ ] Las contraseñas están hasheadas con bcrypt, Argon2 o similar (factor de costo ≥10)

- [ ] Los tokens de sesión son criptográficamente aleatorios y caducan

- [ ] Los intentos de inicio de sesión fallidos están limitados por velocidad

- [ ] Los tokens de restablecimiento de contraseña son de un solo uso y tienen un tiempo limitado

- [ ] Los JWT incluyen caducidad y se validan en el lado del servidor

Validación de Entrada

- [ ] Toda la entrada del usuario se valida por tipo, longitud y formato

- [ ] Las consultas a la base de datos utilizan sentencias parametrizadas

- [ ] Las cargas de archivos validan tipo, tamaño y escanean en busca de malware

- [ ] Las URLs y redirecciones se validan contra listas blancas

- [ ] Los analizadores JSON/XML tienen límites de tamaño configurados

Protección de Datos

- [ ] Las respuestas de la API devuelven solo los campos necesarios

- [ ] Los datos sensibles están cifrados en reposo

- [ ] Las credenciales de la base de datos usan variables de entorno, no código

- [ ] Los secretos se almacenan en sistemas de gestión de secretos adecuados

- [ ] Los logs no contienen contraseñas, tokens o PII

Seguridad del Transporte

- [ ] HTTPS se aplica en producción

- [ ] Los encabezados HSTS están configurados

- [ ] Se requiere TLS 1.2+

- [ ] Las cookies seguras tienen las banderas Secure y HttpOnly

Seguridad Específica de la API

- [ ] La limitación de velocidad previene el abuso

- [ ] CORS está configurado para orígenes específicos, no para

* - [ ] El versionado de la API permite dejar de usar endpoints inseguros

- [ ] Los mensajes de error no filtran detalles internos

- [ ] GraphQL tiene límites de profundidad/complejidad de consulta

Dependencias

- [ ] Todos los paquetes tienen versiones específicas fijadas

- [ ]

npm audit/pip check/ similar no muestra vulnerabilidades críticas - [ ] Las actualizaciones automáticas de dependencias están configuradas

- [ ] Ningún paquete está abandonado o sin mantenimiento

Cómo Probar la Seguridad de su API Antes del Despliegue

La revisión manual no es suficiente. Necesita pruebas sistemáticas que detecten las vulnerabilidades que la IA introdujo y su revisión pasó por alto.

Paso 1: Escaneo de Seguridad Automatizado

Use herramientas diseñadas para encontrar vulnerabilidades comunes:

# Para proyectos Node.js

npm audit --audit-level=high

# Para proyectos Python

pip-audit

# Para imágenes de contenedor

trivy image your-app:latest

Paso 2: Pruebas de Seguridad de API

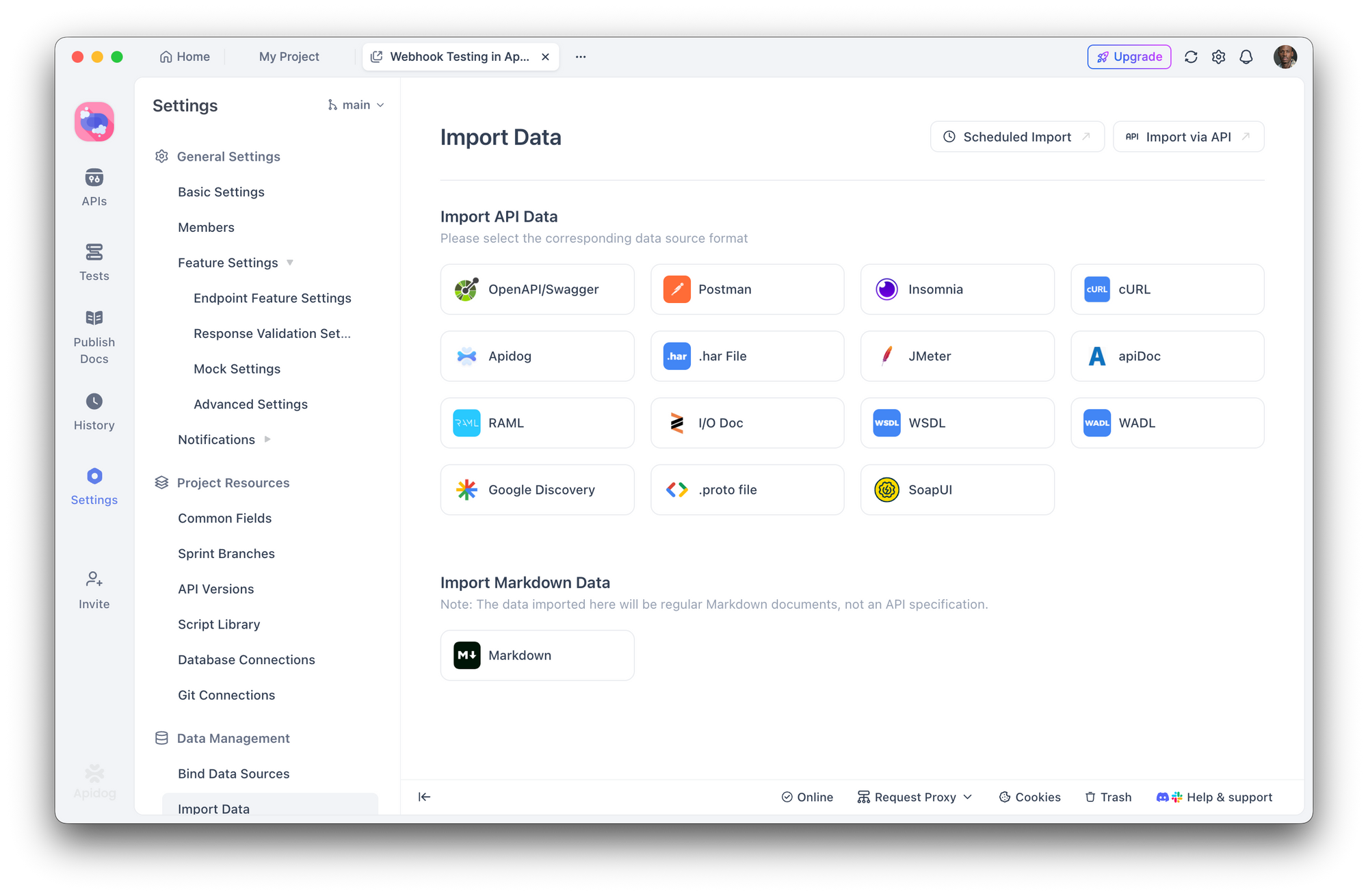

Aquí es donde Apidog se vuelve esencial. En lugar de probar manualmente cada endpoint, puede:

- Importar su especificación de API (OpenAPI/Swagger) o dejar que Apidog descubra los endpoints

2. Crear escenarios de prueba de seguridad que verifiquen:

- La autenticación ausente devuelve 401

- El usuario incorrecto que accede a recursos devuelve 403

- La entrada inválida devuelve 400 con mensajes de error seguros

- Los intentos de inyección SQL son bloqueados

- Ejecutar suites de pruebas automatizadas antes de cada despliegue

- Integrar con CI/CD para detectar regresiones

Con el constructor visual de pruebas de Apidog, no necesita escribir pruebas de seguridad desde cero. Defina aserciones como "la respuesta no debe contener 'password'" o "la solicitud sin token de autenticación debe devolver 401" y ejecútelas en toda la superficie de su API.

Paso 3: Simulación de Pruebas de Penetración

Pruebe su API como lo haría un atacante:

- Enumerar endpoints - ¿Existen rutas ocultas o indocumentadas?

- Probar el bypass de autenticación - ¿Puede acceder a rutas protegidas sin tokens válidos?

- Intentar ataques de inyección - SQL, NoSQL, inyección de comandos en todos los campos de entrada

- Verificar IDOR - ¿Puede el usuario A acceder a los datos del usuario B cambiando los IDs?

- Abusar de los límites de velocidad - ¿Qué sucede con 1000 solicitudes por segundo?

Los escenarios de prueba de Apidog le permiten simular estos ataques sistemáticamente, guardando los resultados para compararlos entre despliegues.

Paso 4: Auditoría de Encabezados de Seguridad

Verifique los encabezados de su respuesta:

curl -I https://your-api.com/endpoint

Busque:

Strict-Transport-SecurityX-Content-Type-Options: nosniffX-Frame-Options: DENYContent-Security-Policy

Construyendo un Flujo de Trabajo con Prioridad en la Seguridad con Herramientas de IA

Los asistentes de codificación de IA no van a desaparecer, y cada vez son más potentes. La solución no es evitarlos, sino integrar la seguridad en su flujo de trabajo.

Ingeniería de Prompts para la Seguridad

Al usar IA para generar código, solicite explícitamente consideraciones de seguridad:

En lugar de:

"Crea un endpoint de registro de usuario"

Pregunte:

"Crea un endpoint de registro de usuario con validación de entrada, hash de contraseña usando bcrypt con factor de costo 12, protección contra ataques de temporización, limitación de velocidad y manejo de errores adecuado que no filtre información sobre si los correos electrónicos existen"

Etapas de Revisión Obligatorias

Establezca un flujo de trabajo donde el código generado por IA debe pasar por:

- Revisión humana - ¿Este código hace lo que pretendemos?

- Linting automatizado - ESLint, Pylint con plugins de seguridad

- Escaneo de seguridad - Snyk, npm audit, OWASP dependency check

- Pruebas de API - Suites de pruebas de Apidog que validan los requisitos de seguridad

- Despliegue en staging - Ejecutar pruebas de integración en un entorno realista

Trate el Código de IA como Entrada No Confiable

Este es el cambio de mentalidad clave. El código de la IA debe tratarse con el mismo escepticismo que el código de un colaborador desconocido. ¿Desplegaría código de un pull request aleatorio sin revisión? Aplique el mismo estándar al código generado por IA.

Conclusión

El hackeo del servidor que ocurrió una semana después del despliegue no fue causado por atacantes sofisticados o exploits de día cero. Fue causado por vulnerabilidades comunes que las herramientas de IA introducen rutinariamente y que las prácticas de "programación intuitiva" (vibe coding) pasan por alto habitualmente.

La generación de código por IA es poderosa. Acelera el desarrollo y hace accesibles tareas complejas. Pero sin pruebas de seguridad sistemáticas, esa velocidad se convierte en una responsabilidad.

Herramientas como Apidog hacen que las pruebas de seguridad sean prácticas al permitirle definir y automatizar los requisitos de seguridad en toda la superficie de su API. El objetivo no es ralentizar el desarrollo asistido por IA, sino construir la capa de verificación que el código generado por IA requiere.

A su servidor no le importa si el código fue escrito por un humano o una IA. Solo le importa si ese código es seguro.