A medida que la IA se integra cada vez más en el desarrollo y las pruebas de API, la barrera de entrada para las pruebas automatizadas disminuye constantemente. Las tareas que antes requerían operaciones manuales repetitivas y preparación de datos ahora pueden ser gestionadas por la IA. Apidog también refleja este cambio en las pruebas de API.

En Apidog, las pruebas automatizadas giran principalmente en torno a dos enfoques: Pruebas de Endpoint y Escenarios de Prueba.

Si no ves el módulo Prueba de Endpoint, significa que tu versión de Apidog está desactualizada. Simplemente actualiza a la última versión.

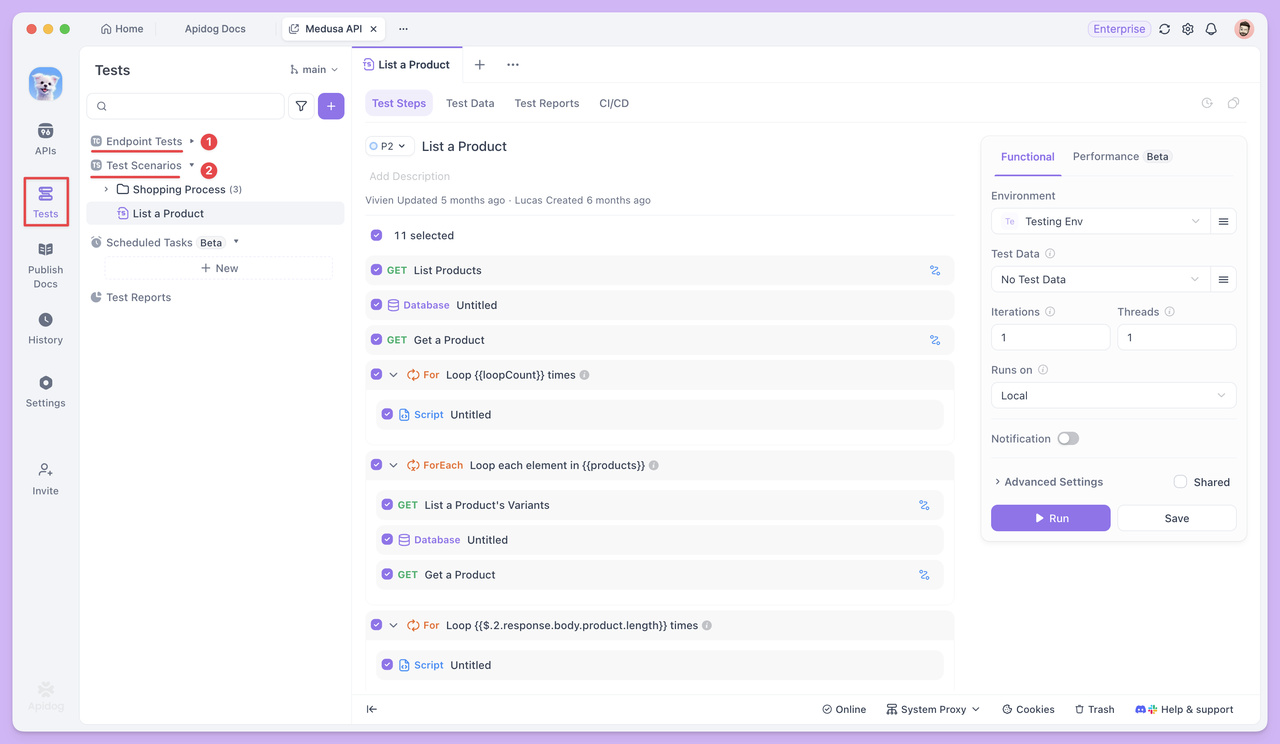

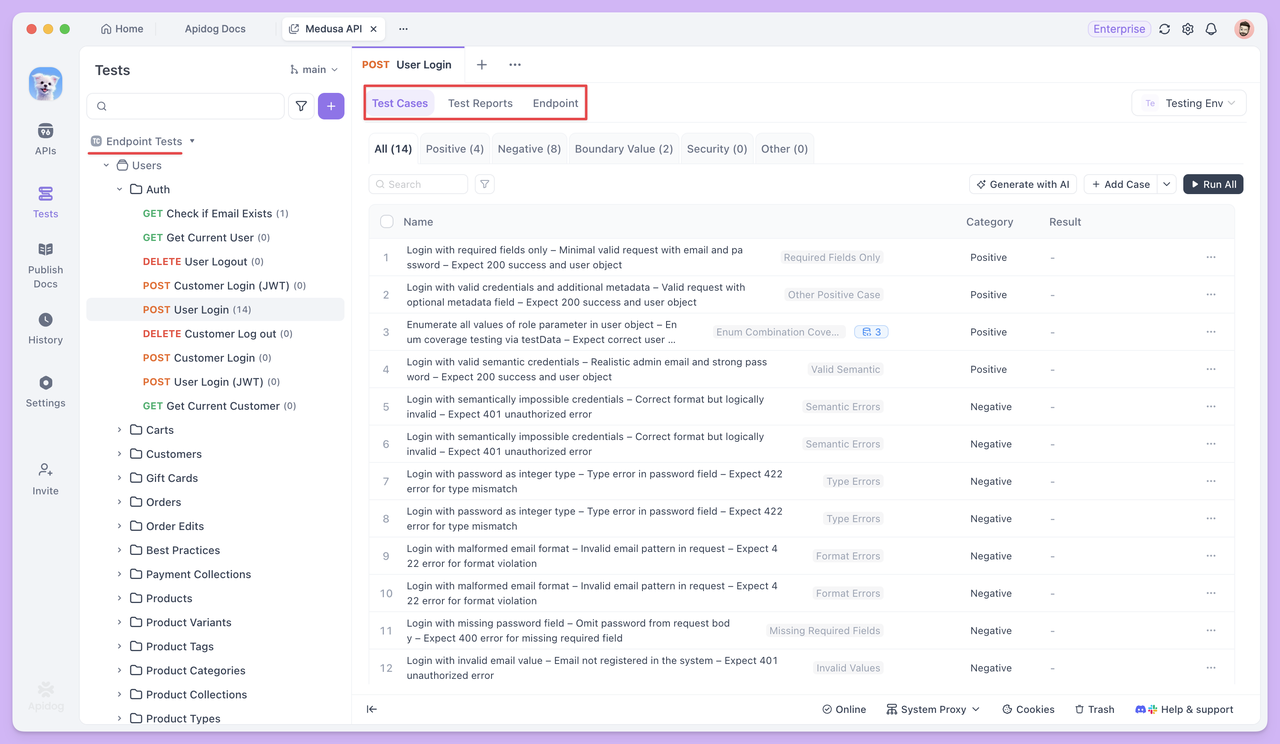

El módulo Pruebas de Endpoint muestra todos los endpoints HTTP de tus API, lo que permite a los desarrolladores de QA estar más concentrados. Incluye solo casos de prueba, informes de prueba y documentación, sin permitir la edición de endpoints. Este diseño asegura que los testers puedan concentrarse en crear y ejecutar casos de prueba de manera eficiente.

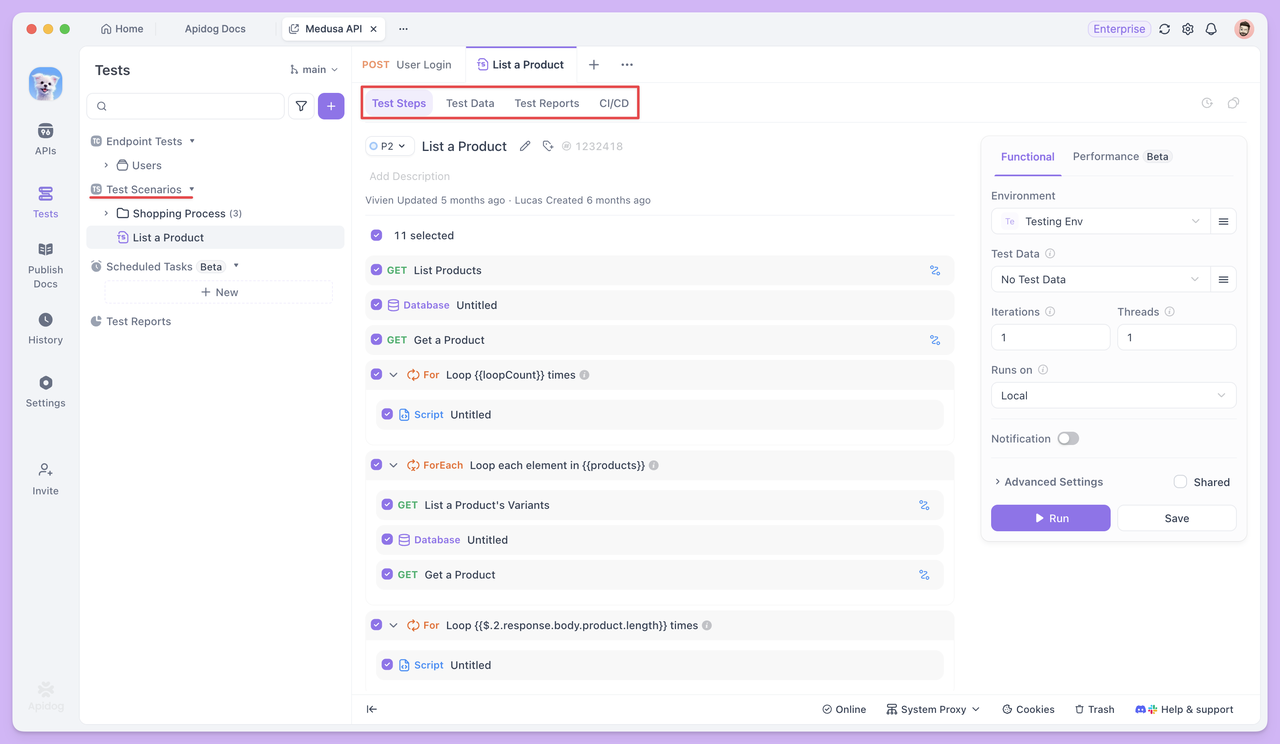

Los Escenarios de Prueba, en contraste, enlazan múltiples endpoints o casos de prueba. Permiten definir el orden de ejecución y las relaciones de transferencia de datos entre endpoints, simulando eficazmente un proceso de negocio completo.

Con la IA integrada tanto en las Pruebas de Endpoint como en los Escenarios de Prueba, las pruebas de API pueden evolucionar gradualmente hacia una ejecución más automatizada, reutilizable y eficiente. A continuación, exploraremos cómo estos dos métodos de prueba ayudan a resolver desafíos del mundo real.

Pruebas de Endpoint con Automatización

La Prueba de Endpoint se centra en si el endpoint en sí es estable y si la entrada/salida cumple las expectativas. Cada caso de prueba se ejecuta de forma independiente, con énfasis en verificar a fondo un único endpoint con diferentes datos.

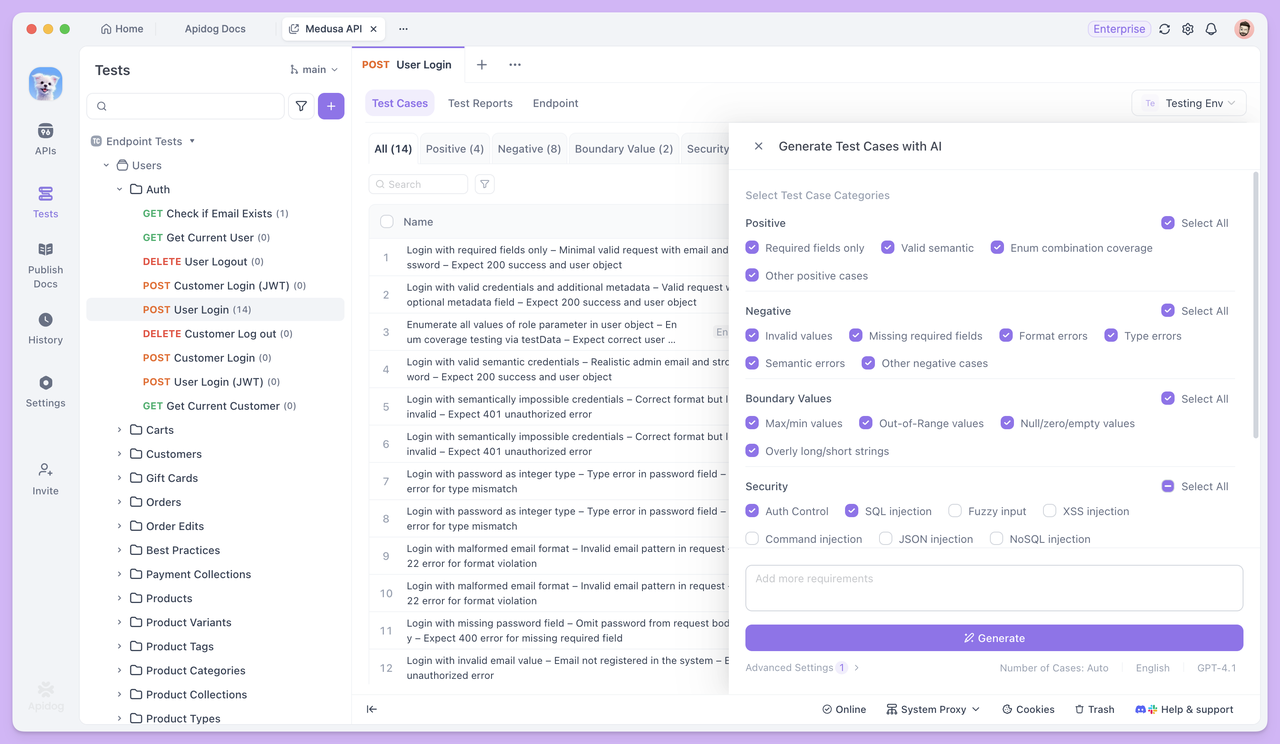

Casos de Prueba Generados por IA

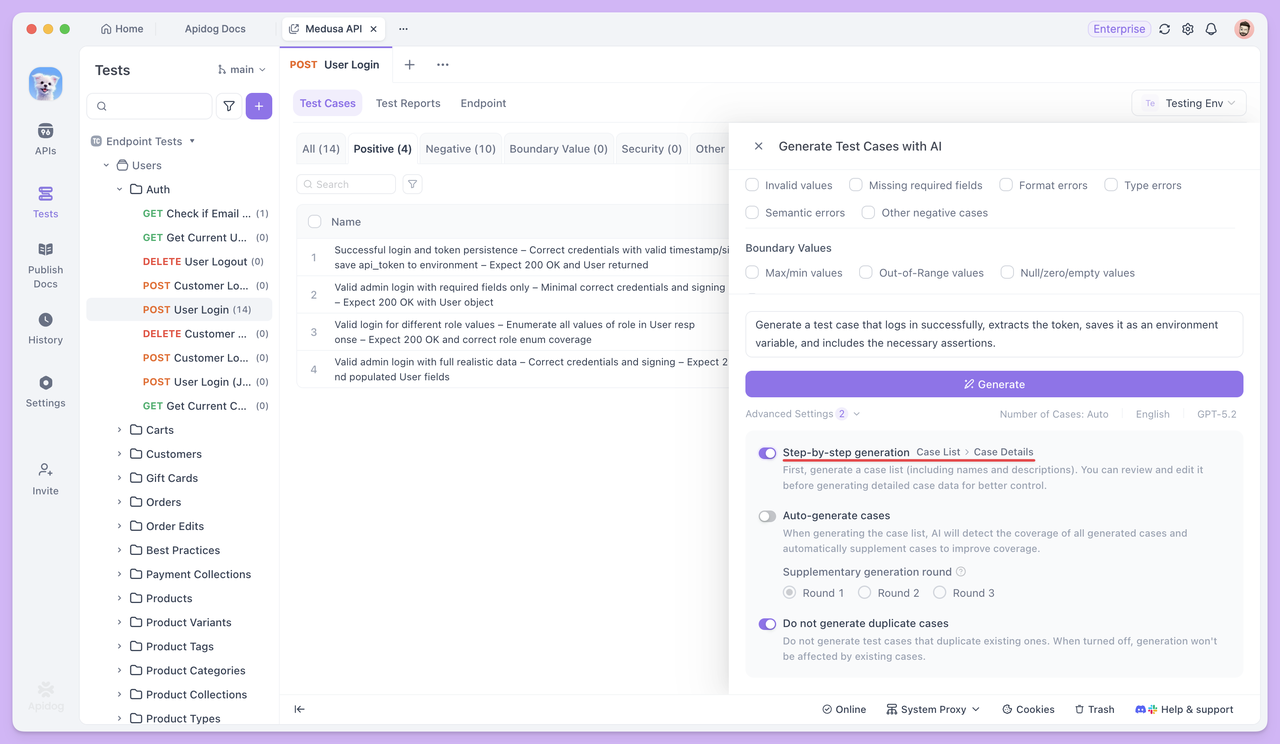

Abre cualquier endpoint en el módulo Prueba de Endpoint y haz clic en Generar con IA. La IA generará automáticamente un conjunto de casos de prueba basados en los parámetros del endpoint y la estructura de la respuesta.

Si solo necesitas casos de prueba específicos, no es necesario seleccionar los tipos predeterminados. Simplemente describe tus requisitos directamente a la IA, y esta generará el caso de prueba correspondiente. Por ejemplo, puedes pedirle a la IA que:

- Genera un caso de prueba para "iniciar sesión correctamente y extraer el token".

- Genera un caso de prueba para "crear el campo de firma

signbasado en parámetros existentes y enviarlo".

Para obtener resultados más precisos, puedes proporcionar condiciones y reglas detalladas, como:

Genera un caso de prueba positivo para este endpoint.

El endpoint requiere un parámetro de firma "sign", con las siguientes reglas de firmado:

1. Recopila todos los parámetros de solicitud no vacíos (excluyendo "sign"), ordénalos por nombre de parámetro en orden ASCII, concaténalos en el formato clave=valor unidos por &, y añade la clave secreta SECRET_KEY al final.

2. Aplica el hash MD5 a la cadena resultante y convierte el hash a mayúsculas. El resultado final se utiliza como el valor de "sign".

Requisitos del caso de prueba:

1. Antes de enviar la solicitud, usa un script de pre-solicitud para generar "sign", con comentarios claros incluidos.

2. Añade el "sign" generado a los parámetros de la solicitud y envía la solicitud.De esta manera, la IA generará casos estrictamente de acuerdo con tus reglas, sin omisiones ni malentendidos.

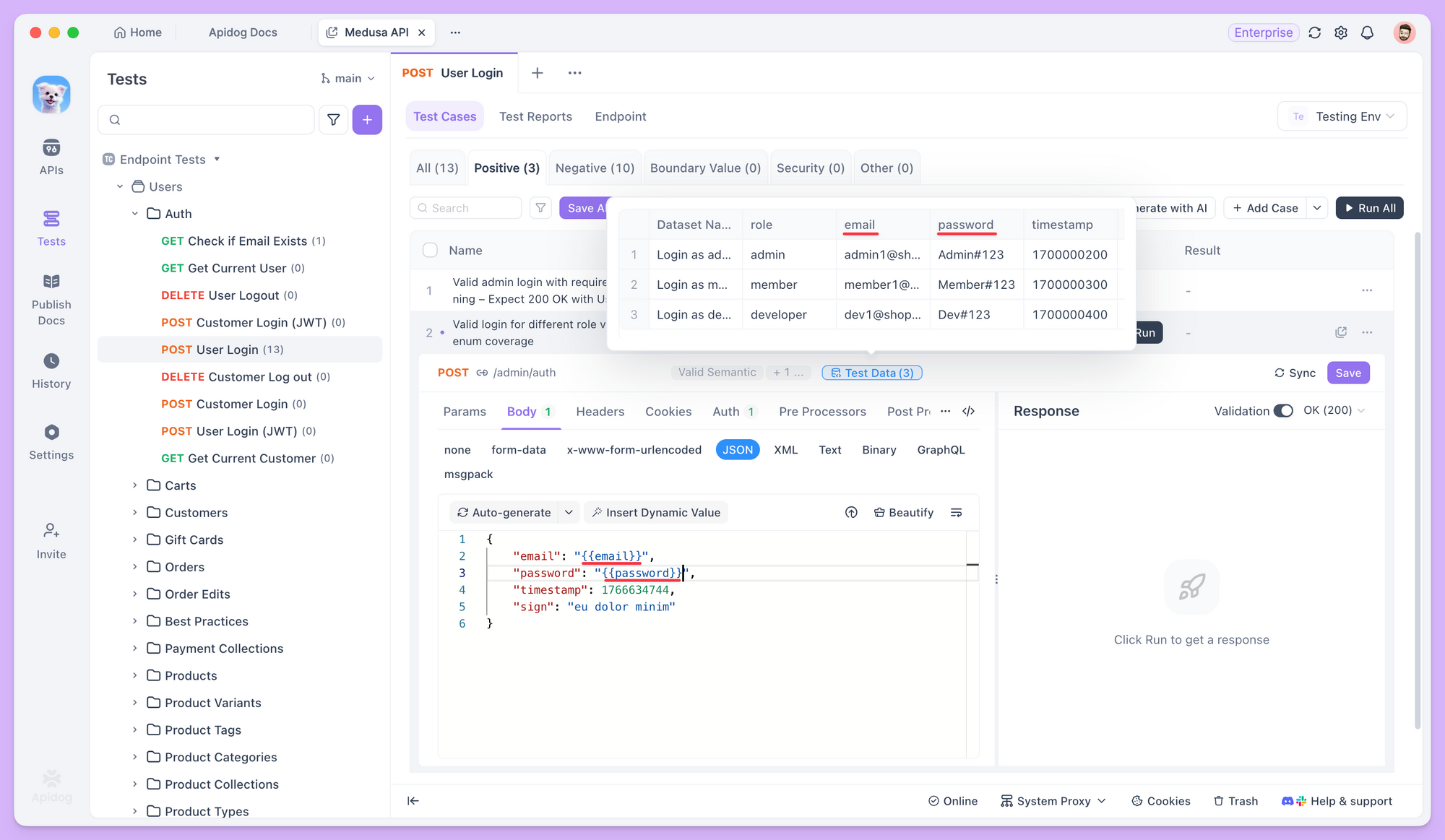

Generación de Datos de Prueba

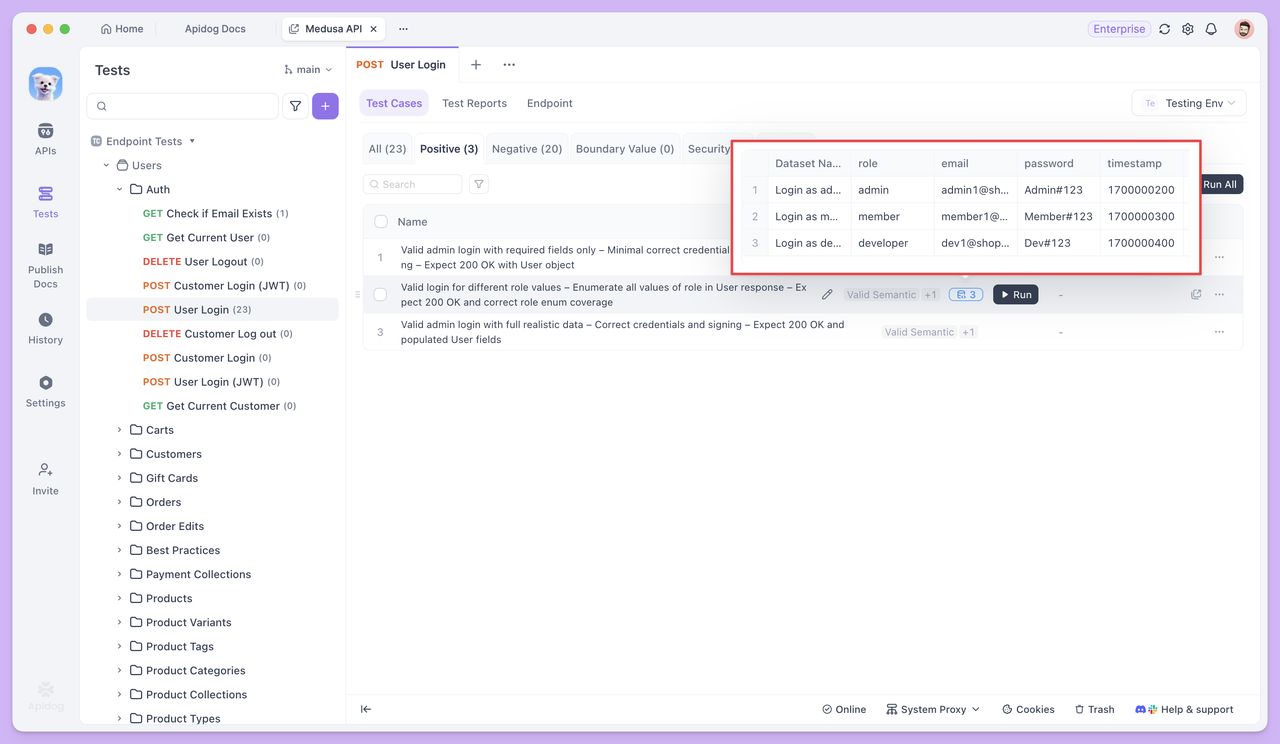

Al generar casos de prueba, la IA también prepara conjuntos de datos de prueba correspondientes para diferentes tipos de casos, a fin de cubrir diversas situaciones de entrada del mundo real.

En casos de escenarios de negocio estándar, los datos de prueba suelen consistir en múltiples conjuntos de valores de parámetros semánticamente válidos. Por ejemplo, en una prueba de endpoint de inicio de sesión, aunque todos los correos electrónicos y contraseñas sean válidos, el conjunto de datos incluirá varios formatos de correo electrónico comunes —como aquellos con puntos, signos de más, correos numéricos o correos corporativos— para verificar la compatibilidad y estabilidad del endpoint en escenarios de uso normal.

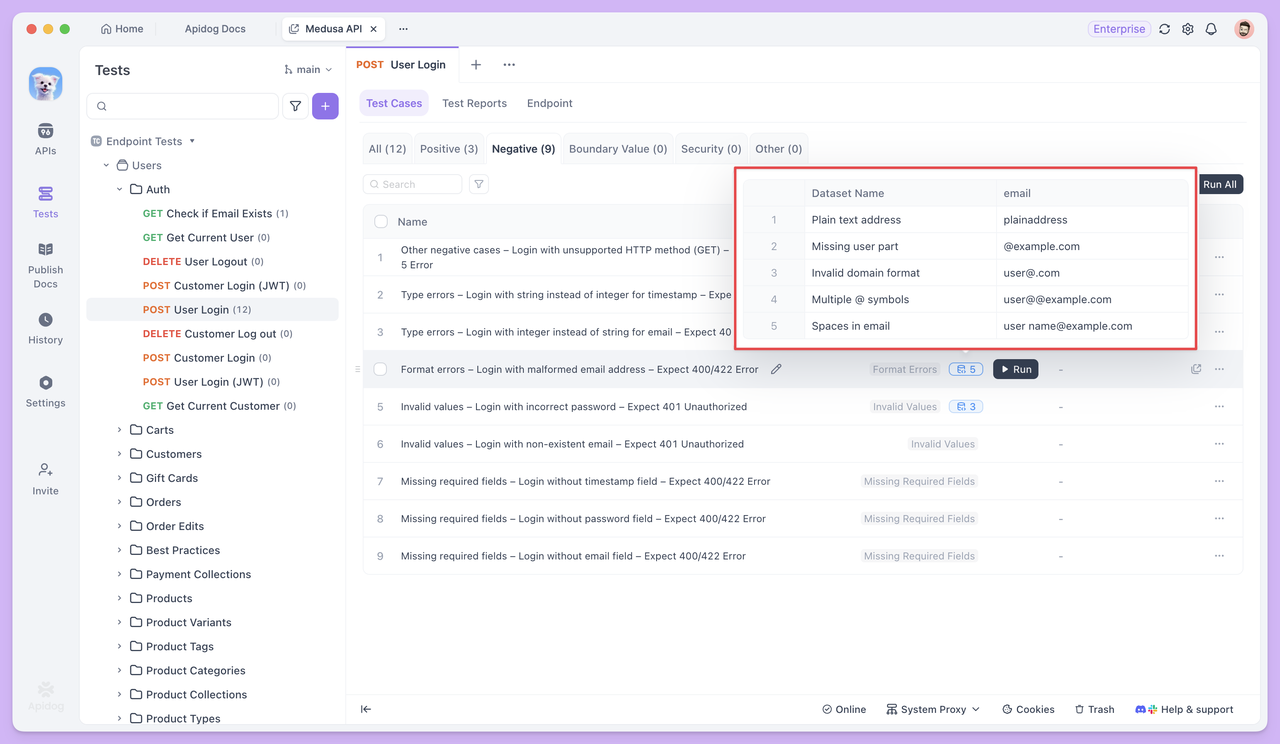

En casos de prueba anormales o de frontera, los datos de prueba están diseñados intencionadamente para incluir entradas que violan las reglas de validación.

Por ejemplo, en un caso de prueba como "Inicia sesión con un formato de correo electrónico no válido y espera un error 400", el conjunto de datos contendría diferentes tipos de direcciones de correo electrónico no válidas —como correos a los que les falta el símbolo @, un nombre de dominio o que contienen espacios. El objetivo es verificar si el endpoint de la API puede detectar correctamente estas entradas no válidas y rechazar la solicitud de forma apropiada.

Referencia de Datos de Prueba

En los casos de prueba, puedes usar la sintaxis {{variable_name}} para referenciar datos de prueba e insertar variables en los parámetros de la solicitud, cuerpos de la solicitud y otros campos.

Cuando se ejecuta la prueba, Apidog extrae automáticamente los valores del conjunto de datos uno por uno y envía solicitudes utilizando cada valor. Esto te permite probar el mismo endpoint varias veces con datos diferentes, sin tener que reescribir el caso de prueba.

Ejecución por Lotes e Informes de Prueba

Una vez que los casos de prueba y sus datos correspondientes están listos, puedes seleccionar varios casos de prueba y ejecutarlos juntos. Cada caso de prueba se ejecuta de forma independiente según su propia configuración, y todos los resultados se recopilan en un único informe de prueba para facilitar la revisión.

En aplicaciones del mundo real, los endpoints rara vez operan de forma aislada. Cuando la respuesta de una solicitud se utiliza como entrada para la siguiente, las pruebas ya no se tratan de un único endpoint, sino de toda la cadena de llamadas.

Aquí es donde entran en juego los Escenarios de Prueba.

Escenarios de Prueba

Un único endpoint no suele ser suficiente para completar una tarea de negocio. Por ejemplo, un usuario debe iniciar sesión antes de realizar un pedido, y solo después de que el pedido se haya creado con éxito se pueden consultar los detalles del pedido. La respuesta de un endpoint a menudo se convierte en la entrada para el siguiente.

Estas dependencias son difíciles de validar completamente con una prueba de endpoint única.

Los Escenarios de Prueba cambian el enfoque de verificar si un endpoint funciona correctamente a verificar si una cadena de llamadas completa se ejecuta sin problemas y según lo esperado.

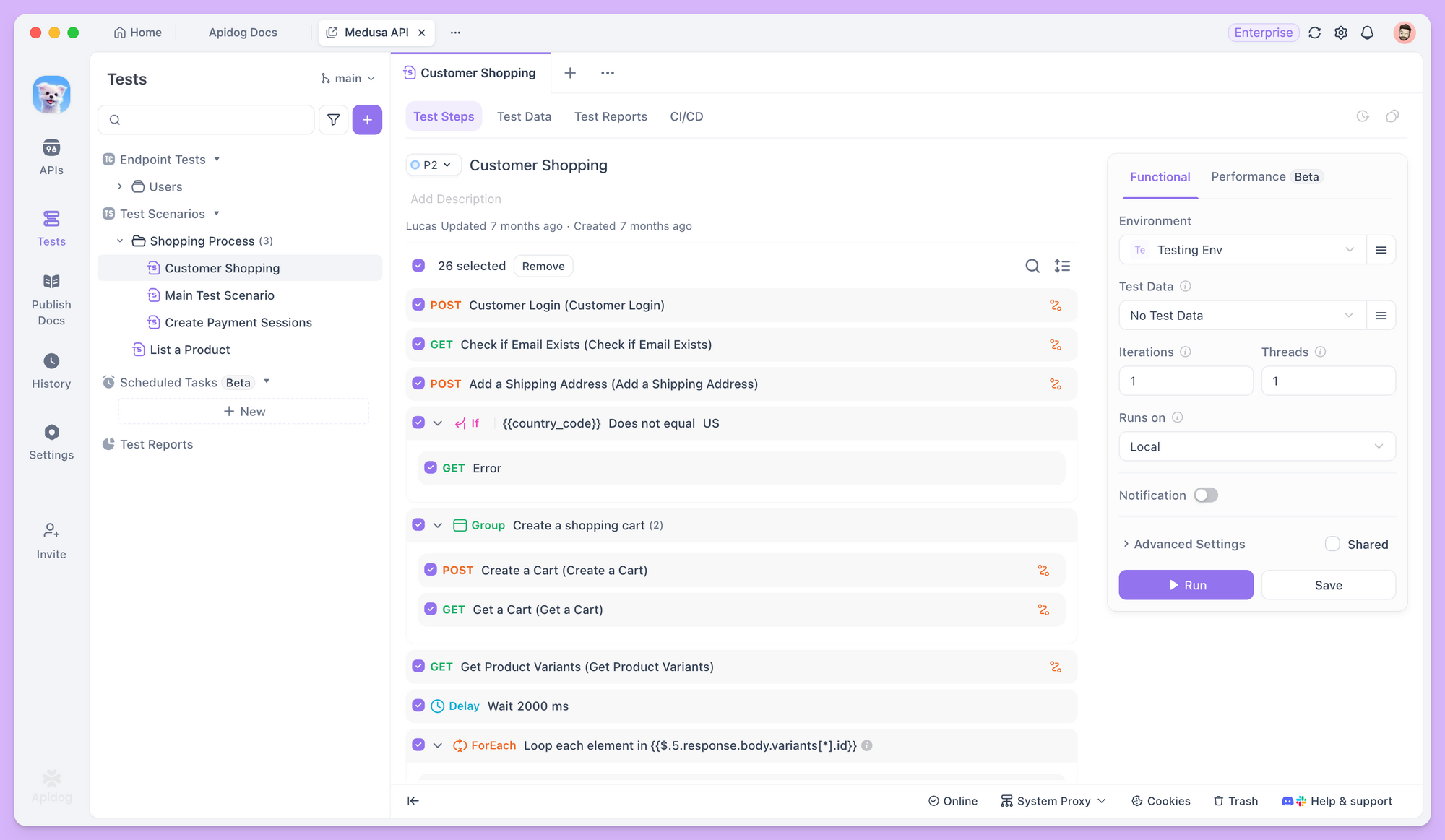

Orquestando Endpoints en un Flujo de Trabajo

En Apidog, después de crear un nuevo escenario de prueba, puedes añadir múltiples endpoints o casos de prueba existentes en un orden específico, definiendo claramente la secuencia de ejecución para cada paso.

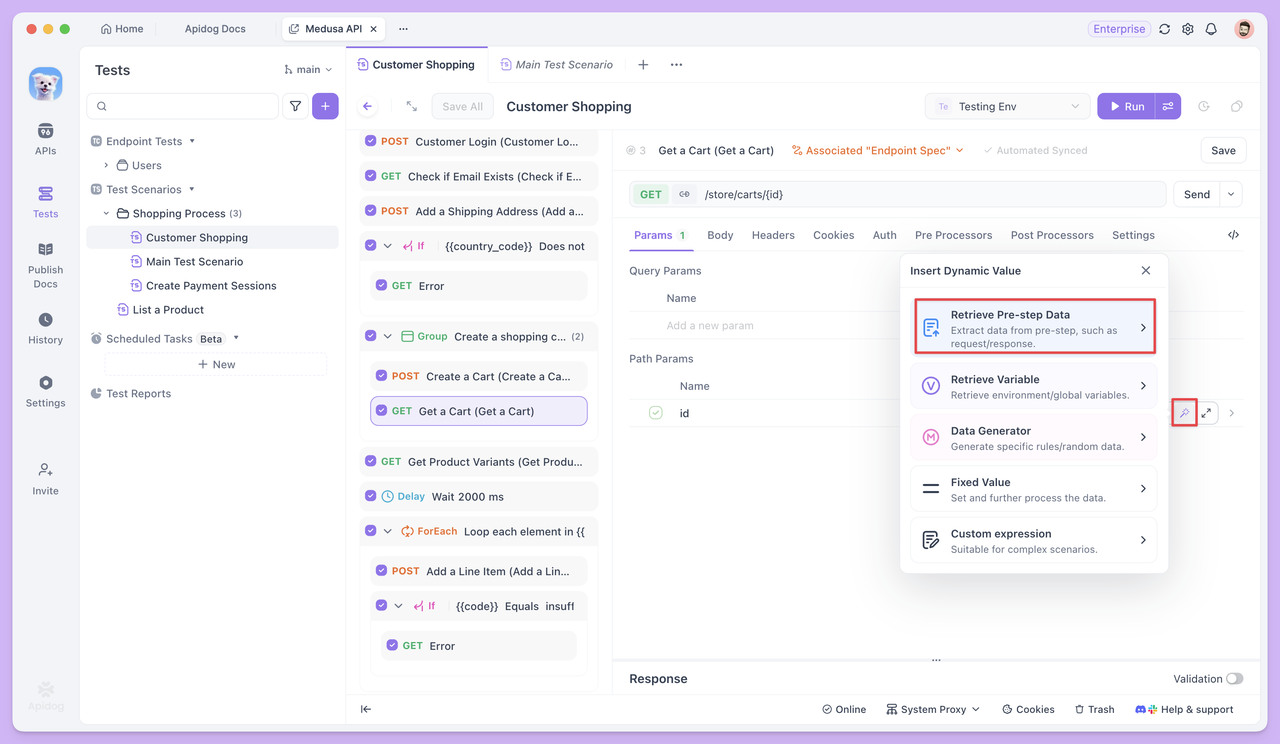

Transferencia de Datos entre los Pasos de Prueba

Cuando los endpoints dependen entre sí, los escenarios de prueba te permiten pasar datos de un paso al siguiente como variables. Por ejemplo, el id devuelto por el endpoint Crear Pedido puede reutilizarse directamente en pasos posteriores, como consultar o actualizar el pedido.

Esta transferencia de datos no requiere código adicional. En su lugar, se basa en la referencia de variables para definir claramente las relaciones ascendentes y descendentes entre los endpoints.

¿Qué sucede si Faltan Casos de Prueba?

Al orquestar escenarios de prueba, el primer objetivo suele ser asegurar que el flujo de trabajo principal se ejecute sin problemas —por ejemplo, Inicio de Sesión → Crear Pedido → Consultar Pedido, donde cada paso corresponde a un caso de prueba existente.

Sin embargo, en la práctica, puedes encontrarte con un desafío común: algunos pasos en el flujo de trabajo pueden no tener casos de prueba preestablecidos, o los casos existentes pueden no cumplir completamente los requisitos del flujo de trabajo.

Por ejemplo, en el paso de inicio de sesión, podrías necesitar no solo verificar un inicio de sesión exitoso, sino también extraer el token devuelto como una variable de entorno para solicitudes posteriores. Un caso de prueba de un solo endpoint existente podría solo realizar una validación básica de inicio de sesión sin manejar la extracción del token.

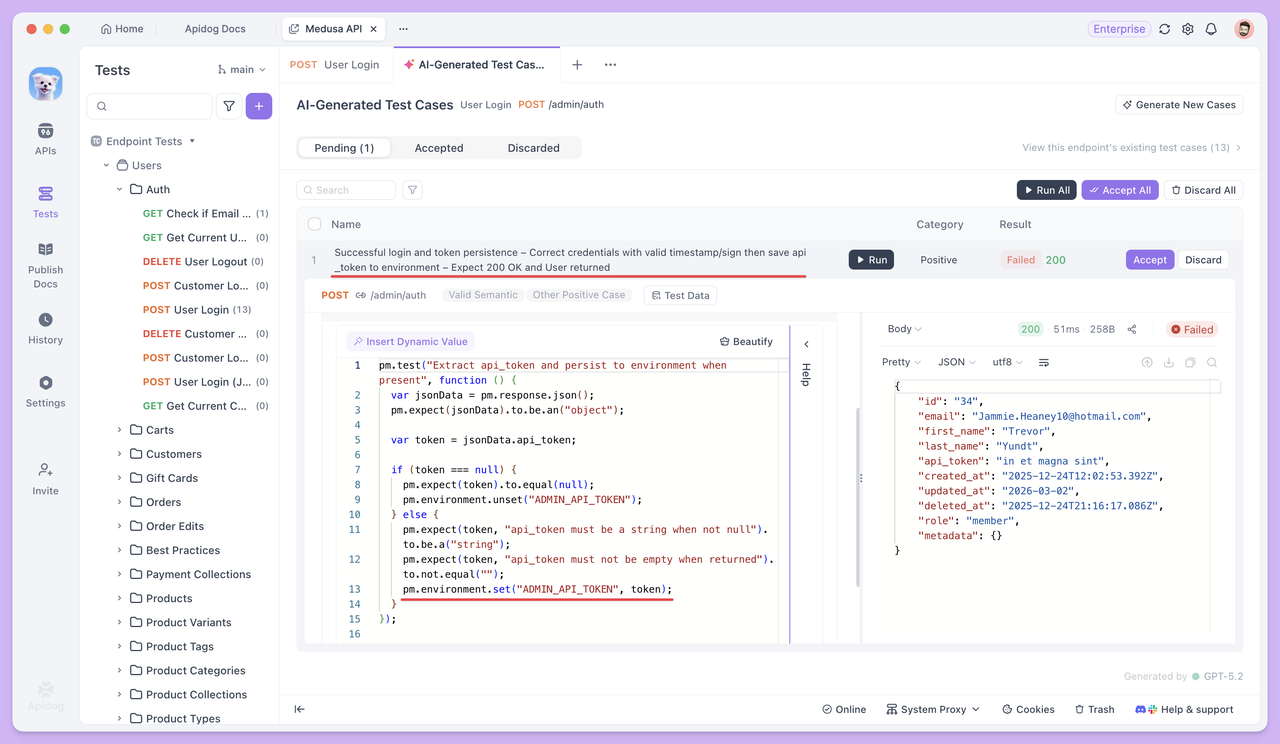

Si no estás seguro de cómo extraer campos devueltos como variables o no estás familiarizado con la programación de scripts, puedes pausar la orquestación del escenario. Luego, ve a la página de Prueba de Endpoint para ese endpoint y aprovecha la IA para manejar el requisito. Por ejemplo, podrías especificar:

"Genera un caso de prueba que extraiga el token y lo guarde como una variable de entorno después de un inicio de sesión exitoso, incluyendo las aserciones necesarias."

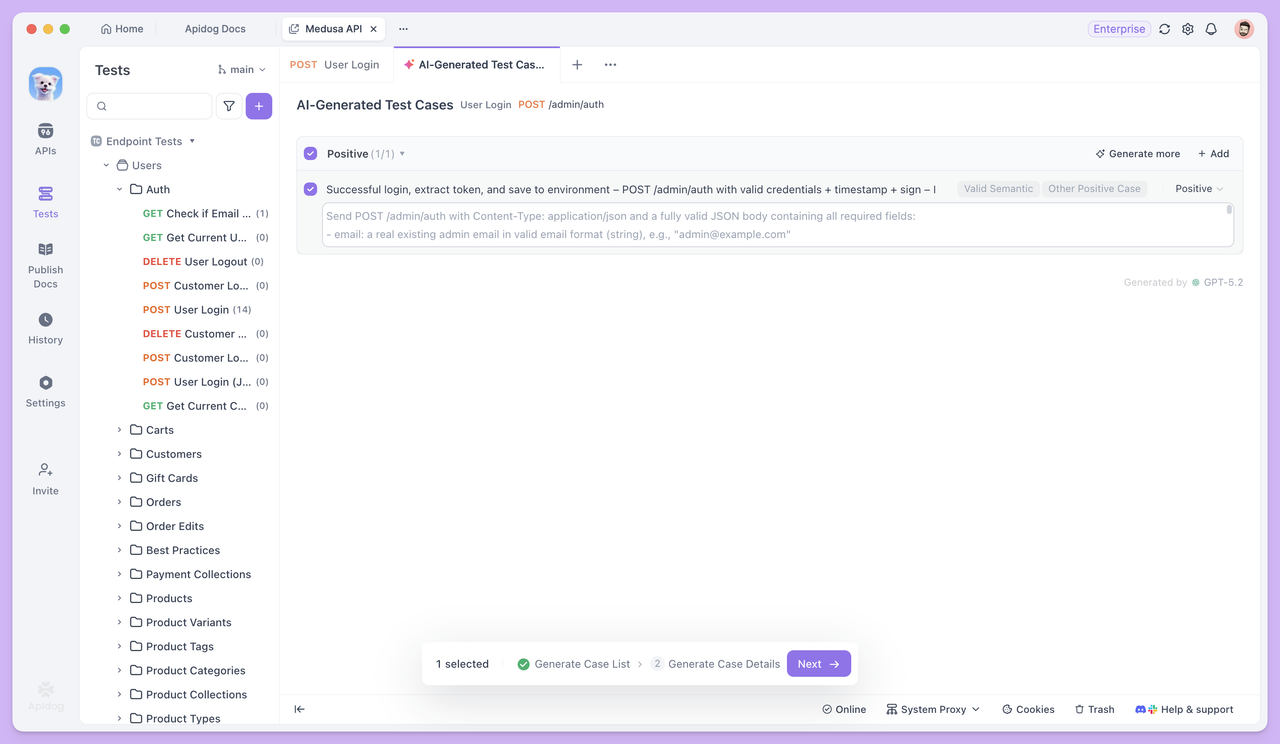

Si deseas un control más preciso sobre tus casos de prueba, puedes habilitar la generación Paso a Paso en la sección de Configuración Avanzada.

Una vez habilitado, Apidog generará primero una lista de casos de prueba, incluyendo sus nombres y descripciones. Luego podrás revisarlos, modificarlos y confirmarlos manualmente antes de generar los datos completos y detallados del caso de prueba.

Una vez generado el caso de prueba, regresa al escenario de prueba. Puedes usar este caso directamente como paso de inicio de sesión, y los endpoints posteriores pueden referenciar el token a través de Valores Dinámicos, permitiendo que el flujo de trabajo continúe sin interrupciones.

Si necesitas datos de prueba en tus Escenarios de Prueba, primero puedes hacer que la IA genere casos con Datos de Prueba en Prueba de Endpoint. Luego, copia el conjunto de datos con formato CSV en el escenario de prueba usando Edición Masiva, lo que hace que la configuración de datos sea mucho más rápida y conveniente.

Este enfoque garantiza que el escenario de prueba siempre se centre en el flujo de trabajo principal, mientras que la IA actúa como un asistente a medida que avanzas. Cada vez que falte un paso, simplemente usa la IA para generar el caso de prueba correspondiente para ese endpoint y luego vincúlalo de nuevo al flujo de trabajo de inmediato.

Resumen

La IA no ha cambiado lo que las pruebas de API necesitan verificar, pero ha reducido significativamente el esfuerzo requerido para iniciar y completar las pruebas.

Durante las Pruebas de Endpoint, la IA aborda principalmente la lenta creación de casos de prueba y la cobertura incompleta. Esto permite que las pruebas avancen más rápido hacia la fase de validación, en lugar de quedarse atascadas preparando datos y escribiendo casos manualmente.

Cuando las pruebas avanzan a los Escenarios de Prueba, el enfoque cambia de verificar un único endpoint a asegurar que los endpoints puedan trabajar juntos correctamente dentro de secuencias de llamadas reales.

En este flujo de trabajo, no necesitas preparar todos los casos de prueba de antemano. A medida que el escenario se construye gradualmente, puedes volver a las Pruebas de Endpoint Único en cualquier momento para que la IA genere los casos específicos necesarios para el flujo de trabajo actual, y luego continuar orquestando los pasos. Esto reduce el esfuerzo inicial innecesario y ahorra en el uso de créditos.

En general, Apidog integra Pruebas de Endpoint, Escenarios de Prueba y capacidades de IA dentro de un único flujo de trabajo, convirtiendo los cuellos de botella habituales de las pruebas de API —escribir casos, preparar datos y encadenar procesos— en tareas manejables.

Si aún piensas que las pruebas automatizadas significan "configuración compleja y una curva de aprendizaje pronunciada", empieza poco a poco: elige un único endpoint en Apidog, genera algunos casos y ejecuta un escenario de prueba. Rápidamente experimentarás lo mucho más fluido y rápido que puede ser el proceso en la práctica.