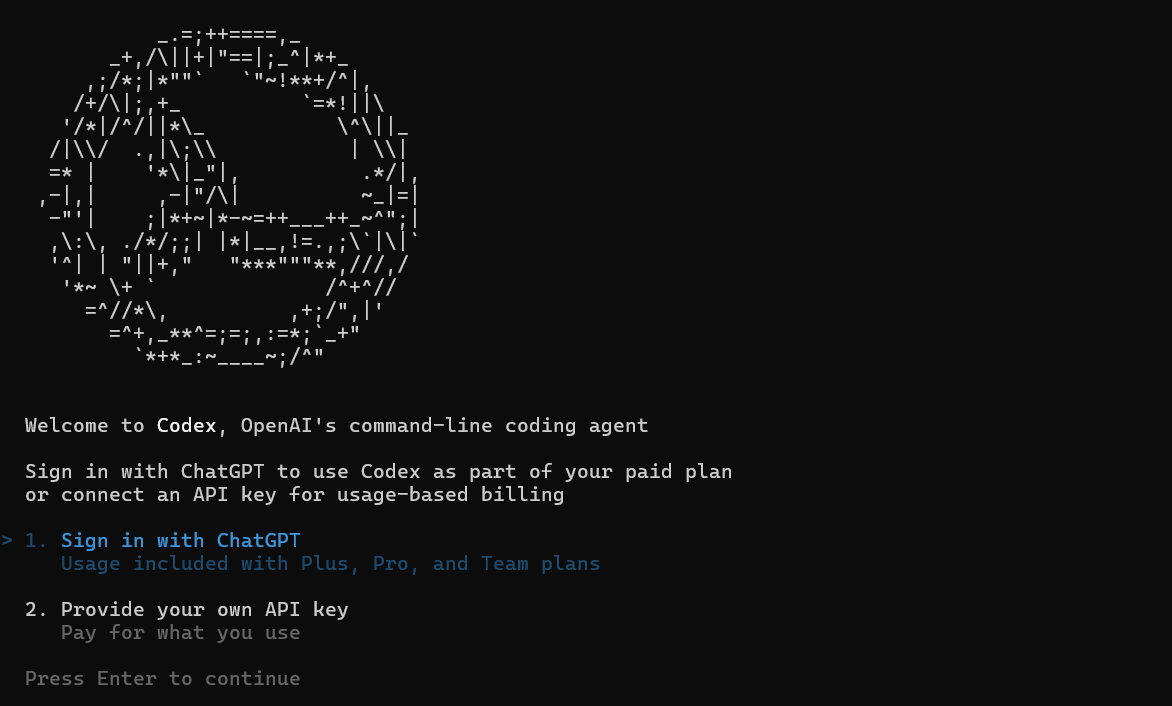

Hãy hình dung thế này: Bạn đang chìm đắm trong một cuộc chạy marathon code, cung cấp cho người bạn AI của bạn một codebase khổng lồ để tái cấu trúc, thì đột nhiên—bùm—nó bị nghẹn vì "vượt quá giới hạn token." Nghe quen chứ? Nếu bạn đang khai thác Codex, công cụ lập trình tinh vi của OpenAI, thì những giới hạn token của Codex đó có thể cảm thấy như một trở ngại giữa dòng chảy công việc. Nhưng đừng lo lắng, hỡi các nhà phát triển—đây không phải là một điểm dừng cứng nhắc; đó là lời mời để bạn thông minh hơn trong các lời nhắc của mình. Tính đến tháng 9 năm 2025, Codex (được hỗ trợ bởi các mô hình như GPT-5-Codex) tự hào có các cửa sổ token rộng rãi có thể xử lý mọi thứ từ các bản sửa lỗi nhanh đến việc đại tu kho lưu trữ đơn lẻ (mono-repo). Trong phân tích dễ hiểu này, chúng ta sẽ làm rõ ý nghĩa thực sự của những giới hạn token của Codex đó, cách tận dụng tối đa chúng và các mẹo để tăng cường việc sử dụng của bạn. Cho dù bạn là một lập trình viên độc lập hay trưởng nhóm, việc nắm vững điều này sẽ giúp các phiên AI của bạn hoạt động trơn tru. Hãy cùng giải mã các token và nâng cấp trò chơi Codex của bạn!

Bạn muốn một nền tảng tích hợp, tất cả trong một để nhóm phát triển của bạn làm việc cùng nhau với năng suất tối đa?

Apidog đáp ứng mọi yêu cầu của bạn và thay thế Postman với mức giá phải chăng hơn nhiều!

nút

Giải mã Giới hạn Token của Codex: Trò chơi con số

Về bản chất, giới hạn token của Codex xoay quanh cửa sổ ngữ cảnh—"không gian não" tổng thể mà yêu cầu của bạn có thể chiếm dụng. Không giống như các mô hình cũ hơn bị giới hạn ở 4K hoặc 8K token, Codex—ra mắt vào tháng 5 năm 2025 và được nâng cấp với codex-1—tự hào có độ dài ngữ cảnh lên tới 192.000 token. Điều đó đủ để "nuốt chửng" một kho lưu trữ có kích thước trung bình (tương đương khoảng 50 nghìn dòng mã) trong khi vẫn còn chỗ cho lời nhắc, lịch sử và đầu ra của bạn. Token đầu vào (mã của bạn + hướng dẫn) đạt tối đa khoảng 150K, với đầu ra giới hạn ở 42K để giữ cho phản hồi nhanh chóng—tổng cộng đạt điểm tối ưu 192K đó.

Tại sao lại rộng rãi đến vậy? Codex được xây dựng cho kỹ thuật thực tế: Gỡ lỗi một ứng dụng cũ? Hãy đưa toàn bộ module vào. Xây dựng một tính năng? Hãy bao gồm các thông số kỹ thuật, phụ thuộc và kiểm thử mà không cần cắt xén. Biến thể codex-mini-latest giảm xuống 128K cho các tác vụ nhẹ hơn (Hỏi đáp mã, chỉnh sửa nhanh), nhưng codex-1 đầy đủ lại tỏa sáng cho các công việc nặng nhọc. Giới hạn mỗi tin nhắn liên quan đến gói của bạn—người dùng Plus nhận được 30-150 tin nhắn/5 giờ, nhưng mỗi tin nhắn có thể tiêu thụ tới 192K nếu phức tạp. Không có giới hạn cứng cho mỗi yêu cầu ngoài cửa sổ; nó thiên về tổng thể việc sử dụng để ngăn chặn sự cố máy chủ.

Những giới hạn này không cố định—OpenAI đang lặp lại dựa trên phản hồi. Các bản xem trước đầu năm 2025 là "không giới hạn" để thử nghiệm, nhưng giờ đây chúng được phân cấp để đảm bảo tính bền vững. Đối với người dùng API, đó là trả tiền theo token: 1,50 đô la/1 triệu token đầu vào, 6 đô la/1 triệu token đầu ra trên codex-mini, với chiết khấu 75% cho việc lưu trữ cache đối với các lần lặp lại. Tóm lại: Giới hạn token của Codex rất hào phóng đối với hầu hết các nhà phát triển, nhưng việc nhắc nhở thông minh sẽ biến chúng thành siêu năng lực.

Cách tận dụng Giới hạn Token của Codex: Tối đa hóa cửa sổ của bạn

Đạt đến giới hạn 192K đó ư? Không, với các chiến lược thông minh, bạn sẽ hiếm khi chạm đến nó—và khi bạn chạm đến, bạn sẽ thích thú. Chìa khóa để làm chủ giới hạn token của Codex là coi chúng như RAM: Tải những gì quan trọng, loại bỏ những thứ không cần thiết và lặp lại một cách hiệu quả.

Đầu tiên, phân đoạn một cách khôn ngoan: Đối với các codebase lớn, hãy tóm tắt các tệp không cần thiết ("Đây là utils.py; tập trung vào logic xác thực") để giải phóng token cho các đường dẫn quan trọng. Các công cụ như git diff hoặc tải lên chọn lọc giúp giảm 50% đầu vào mà không làm mất ngữ cảnh. Trong CLI, sử dụng --context-file để tải trước các bản tóm tắt, giữ cho lời nhắc của bạn gọn gàng.

Tận dụng bộ nhớ đệm (caching): Lặp lại các mẫu? Chiết khấu 75% của OpenAI cho các lời nhắc được lưu vào bộ nhớ đệm có nghĩa là việc tạo lại một bộ kiểm thử mẫu sẽ tốn rất ít chi phí. Nhắc một lần với ngữ cảnh đầy đủ, sau đó tham chiếu nó: "Xây dựng dựa trên việc tái cấu trúc xác thực trước đó." Điều này nối chuỗi các phiên mà không cần tải lại mọi thứ, mở rộng cửa sổ của bạn qua các cuộc chạy marathon.

Sử dụng đa phương thức: GPT-5-Codex chấp nhận hình ảnh (ảnh chụp màn hình lỗi) mà không tốn token—mô tả lỗi UI bằng hình ảnh, tiết kiệm việc phình to văn bản. Đối với đầu ra, đặt --max-output 10K để tập trung vào các bản sửa lỗi, không phải các bài luận.

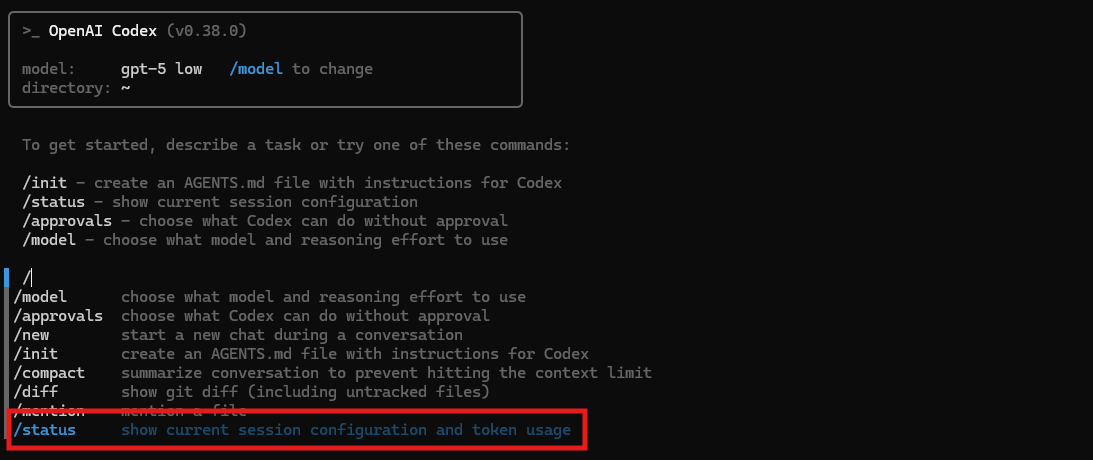

Theo dõi như diều hâu: Bảng điều khiển CLI hiển thị mức tiêu thụ theo thời gian thực (ví dụ: 486K đã sử dụng, 32% ngữ cảnh còn lại). Đặt cảnh báo khi đạt 80%—tạm dừng, tóm tắt tiến độ trong AGENTS.md và tiếp tục. Người dùng chuyên nghiệp có được độ chi tiết cao hơn, phát hiện những kẻ ngốn token như lập luận dài dòng.

Các trường hợp đặc biệt? Monorepo: Sử dụng tìm kiếm vector để truy xuất các đoạn liên quan ngay lập tức, chỉ cung cấp 20K mỗi lần. Việc tải động này bỏ qua các giới hạn tĩnh, lý tưởng cho sự phát triển của doanh nghiệp. Kết quả? Các tác vụ mà các mô hình cũ hơn sẽ bị tràn giờ đây chạy trơn tru, với các nhà phát triển báo cáo thông lượng tăng gấp 3 lần.

Các cách tốt nhất để tận dụng Codex: Vượt ra ngoài giới hạn

Giới hạn token của Codex chỉ là một bức tranh—sự thành thạo thực sự đến từ việc sử dụng nó như một con dao quân đội Thụy Sĩ cho cuộc sống phát triển. Bắt đầu với CLI cho những người làm việc với terminal: codex debug app.py --context 50K nạp một nửa giới hạn của bạn cho các bản sửa lỗi có mục tiêu, xuất ra các diff của PR. Kết hợp với tiện ích mở rộng VS Code để có các gợi ý nội tuyến—di chuột qua một hàm, nhấn "Test with Codex," và nó tạo ra các bộ kiểm thử trong vòng 10K token.

Đối với các nhóm, hãy ủy quyền: Gán các tác nhân thông qua chế độ đám mây (gần như không giới hạn cho các đợt bùng nổ) cho các tác vụ song song—một gỡ lỗi giao diện người dùng (20K token), một gỡ lỗi phần phụ trợ (cửa sổ riêng biệt). Tích hợp MCP để chuyển giao ngữ cảnh: Truyền trạng thái tóm tắt giữa các tác nhân, giảm thiểu việc tải lại.

Kỹ thuật nhắc nhở tăng cường sử dụng: "Ưu tiên hiệu quả: Giải thích bản sửa lỗi trong 500 token, mã trong 2K." Điều này vắt kiệt giá trị từ đầu ra. Nối chuỗi với các công cụ—sử dụng Tìm kiếm Tệp để lấy các đoạn mã (5K token), đưa vào Trình thông dịch để thực thi (không tốn thêm chi phí), sau đó tinh chỉnh.

Doanh nghiệp? Giới hạn tùy chỉnh thông qua tín dụng cho phép bạn tăng tốc lên hơn 500K mỗi tác vụ, hoàn hảo cho việc di chuyển. Gói miễn phí? Hãy sử dụng mô hình mini cho các tác vụ cơ bản 128K, nâng cấp khi bạn đã quen.

Cạm bẫy? Việc quá tải lời nhắc làm phình to đầu vào—hãy giữ chúng theo module. Luôn xác minh đầu ra; token tiết kiệm được từ việc tránh các lỗi ảo giác tốt hơn nhiều so với việc chạy lại lãng phí.

Kết luận: Token là đồng minh của bạn, không phải kẻ thù

Giới hạn token của Codex—sức mạnh 192K đó—không phải là rào cản; chúng là bản thiết kế cho sự thiên tài hiệu quả. Bằng cách phân đoạn, lưu vào bộ nhớ đệm và nối chuỗi, bạn biến những hạn chế thành sự sáng tạo, biến Codex thành người đồng hành tối thượng của bạn. Cho dù là các cuộc chạy nước rút CLI hay các cuộc chạy marathon IDE, hãy tối ưu hóa một cách triệt để và xem năng suất của bạn tăng vọt. Có mẹo tiết kiệm token nào không? Hãy chia sẻ trên bất kỳ nền tảng nhà phát triển nào—hãy cùng nhau vượt qua các giới hạn!

nút