Gặp khó khăn trong việc đánh giá và tối ưu hóa các quy trình mô hình ngôn ngữ lớn (LLM) của bạn? Hãy đến với LangWatch, một nền tảng thay đổi cuộc chơi giúp bạn dễ dàng giám sát, đánh giá và tinh chỉnh các quy trình LLM tùy chỉnh của mình. Trong hướng dẫn này, chúng ta sẽ tìm hiểu LangWatch là gì, tại sao nó tuyệt vời, và cách cài đặt cũng như sử dụng nó để tăng cường sức mạnh cho các dự án AI của bạn. Chúng ta sẽ cùng thiết lập một chatbot đơn giản, tích hợp LangWatch, và kiểm tra nó với một câu hỏi mẫu—tất cả đều được giữ cho dễ hiểu. Hãy bắt đầu nào!

Bạn muốn một nền tảng tích hợp, tất cả trong một để Đội ngũ Nhà phát triển của bạn làm việc cùng nhau với năng suất tối đa?

Apidog đáp ứng mọi yêu cầu của bạn, và thay thế Postman với mức giá phải chăng hơn nhiều!

LangWatch là gì và tại sao bạn nên quan tâm?

LangWatch là nền tảng tối ưu giúp bạn giải quyết vấn đề khó khăn trong việc đánh giá LLM. Không giống như các mô hình truyền thống với các chỉ số tiêu chuẩn như điểm F1 cho phân loại, BLEU cho dịch thuật, hoặc ROUGE cho tóm tắt, các LLM tạo sinh không xác định và khó đánh giá chính xác. Hơn nữa, mỗi công ty đều có dữ liệu, mô hình tinh chỉnh và quy trình tùy chỉnh riêng, khiến việc đánh giá trở thành một vấn đề đau đầu. Đó là lúc LangWatch tỏa sáng!

LangWatch cho phép bạn:

- Thử nghiệm và Tối ưu hóa: Dễ dàng kiểm tra và cải thiện các quy trình LLM của bạn.

- Giám sát Hiệu suất: Theo dõi cách AI của bạn hoạt động trong thời gian thực.

- Đánh giá Kết quả: Sử dụng các bộ dữ liệu và công cụ đánh giá để đo lường độ chính xác và chất lượng.

- Hỗ trợ các Quy trình Tùy chỉnh: Hoạt động với dữ liệu và mô hình độc đáo của bạn.

Dù bạn đang xây dựng một chatbot, một công cụ dịch thuật, hay một ứng dụng AI tùy chỉnh, LangWatch giúp bạn đảm bảo LLM của mình mang lại kết quả hàng đầu. Sẵn sàng để xem nó hoạt động chưa? Hãy cài đặt và sử dụng LangWatch!

Hướng dẫn từng bước để cài đặt và sử dụng LangWatch

Điều kiện tiên quyết

Trước khi bắt đầu, bạn sẽ cần:

- Python 3.8+: Để chạy dự án (python.org).

- Tài khoản LangWatch: Đăng ký tại app.langwatch.ai.

- Khóa API OpenAI: Dành cho bản demo chatbot (lấy tại platform.openai.com).

- Trình chỉnh sửa mã: VS Code, PyCharm, hoặc IDE yêu thích của bạn.

- Git và Docker: Tùy chọn, để thiết lập LangWatch cục bộ.

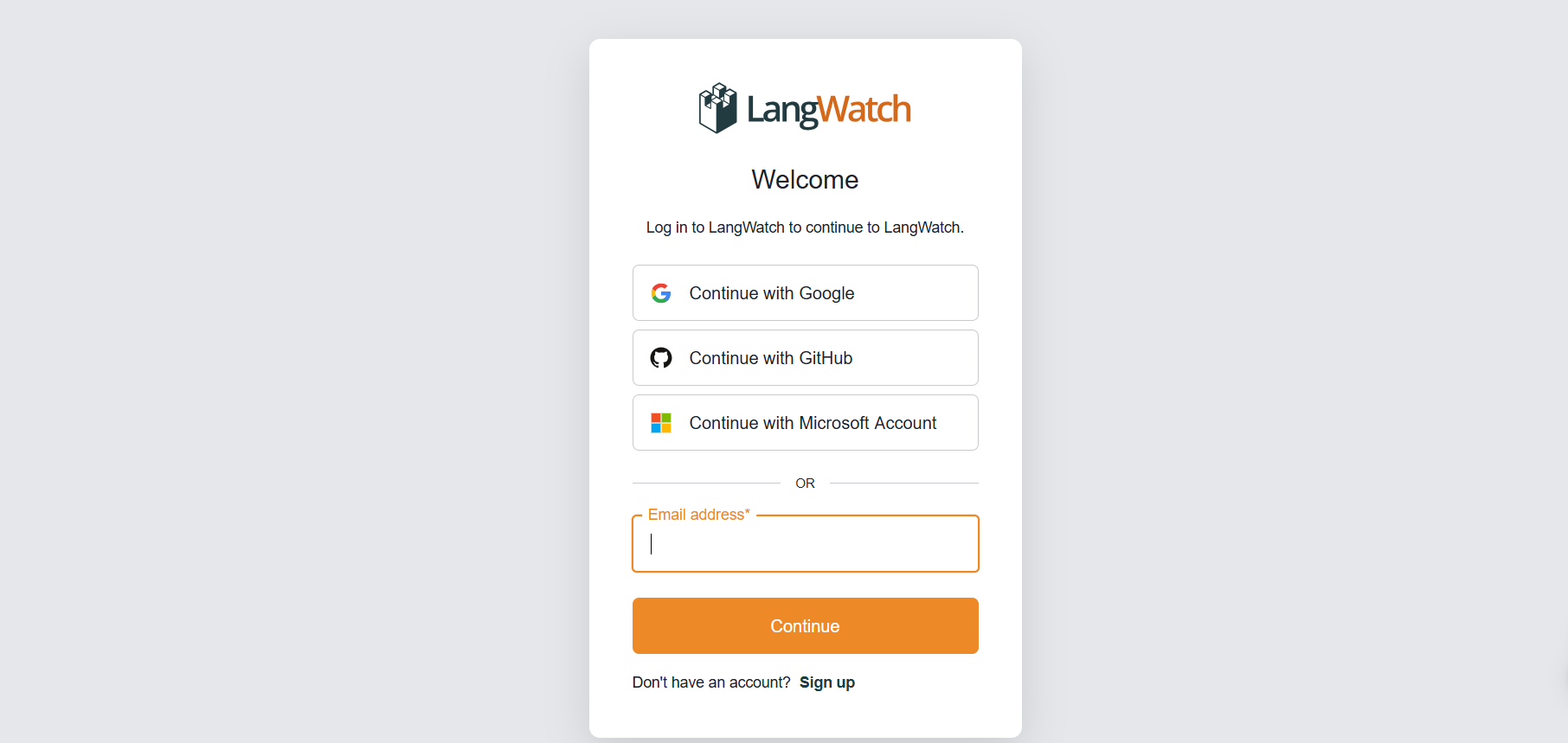

Bước 1: Đăng ký LangWatch

Tạo tài khoản:

- Truy cập app.langwatch.ai và đăng ký tài khoản miễn phí.

- Một dự án mặc định tên “AI Bites” sẽ được tạo cho bạn. Chúng ta sẽ sử dụng nó cho hướng dẫn này, nhưng bạn có thể tạo một dự án mới nếu muốn.

Lấy khóa API của bạn:

- Trong bảng điều khiển LangWatch của bạn, vào Project Settings để tìm

LANGWATCH_API_KEYcủa bạn. Bạn sẽ cần khóa này sau.

Bước 2: Thiết lập dự án Python với LangWatch

Hãy tạo một dự án Python và tích hợp LangWatch để theo dõi một chatbot đơn giản.

- Tạo thư mục dự án:

- Tạo một thư mục mới (ví dụ:

langwatch-demo) và điều hướng vào đó:

mkdir langwatch-demo

cd langwatch-demo

2. Thiết lập môi trường ảo:

- Tạo và kích hoạt môi trường ảo để giữ các phụ thuộc được cô lập:

python -m venv venv

source venv/bin/activate # Trên Windows: venv\Scripts\activate

3. Cài đặt LangWatch và các phụ thuộc:

- Cài đặt LangWatch và Chainlit (cho giao diện người dùng chatbot):

pip install langwatch chainlit openai

4. Tạo mã chatbot:

- Tạo một tệp có tên

app.pyvà dán đoạn mã này để xây dựng một chatbot đơn giản sử dụng mô hình GPT-4o-mini của OpenAI:

import os

import chainlit as cl

import asyncio

from openai import AsyncClient

openai_client = AsyncClient() # Giả định OPENAI_API_KEY được đặt trong môi trường

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

5. Đặt khóa API OpenAI của bạn:

- Thêm khóa API OpenAI của bạn dưới dạng biến môi trường:

export OPENAI_API_KEY="your-openai-api-key" # Trên Windows: set OPENAI_API_KEY=your-openai-api-key

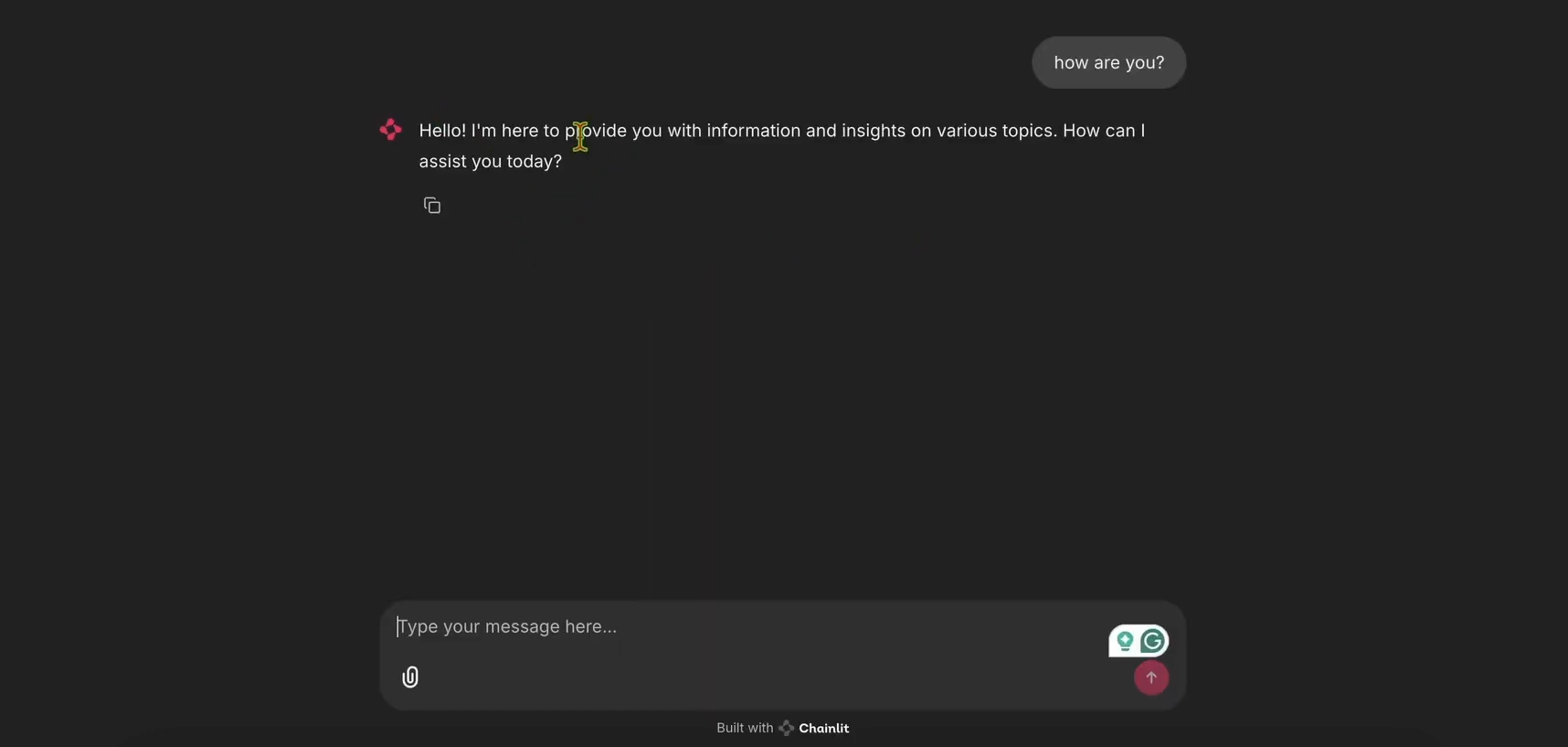

6. Chạy Chatbot:

- Khởi động ứng dụng Chainlit:

chainlit run app.py

- Mở http://localhost:8000 để xem giao diện người dùng chatbot. Hãy thử nó để đảm bảo nó hoạt động!

Bước 3: Tích hợp LangWatch để theo dõi

Bây giờ, hãy thêm LangWatch để theo dõi các tin nhắn của chatbot.

- Sửa đổi

app.pycho LangWatch:

- Cập nhật

app.pyđể bao gồm LangWatch và thêm decorator@langwatch.trace()vào hàmmain:

import os

import chainlit as cl

import asyncio

import langwatch

from openai import AsyncClient

openai_client = AsyncClient()

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

@langwatch.trace()

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

2. Kiểm tra tích hợp:

- Khởi động lại ứng dụng Chainlit:

chainlit run app.py

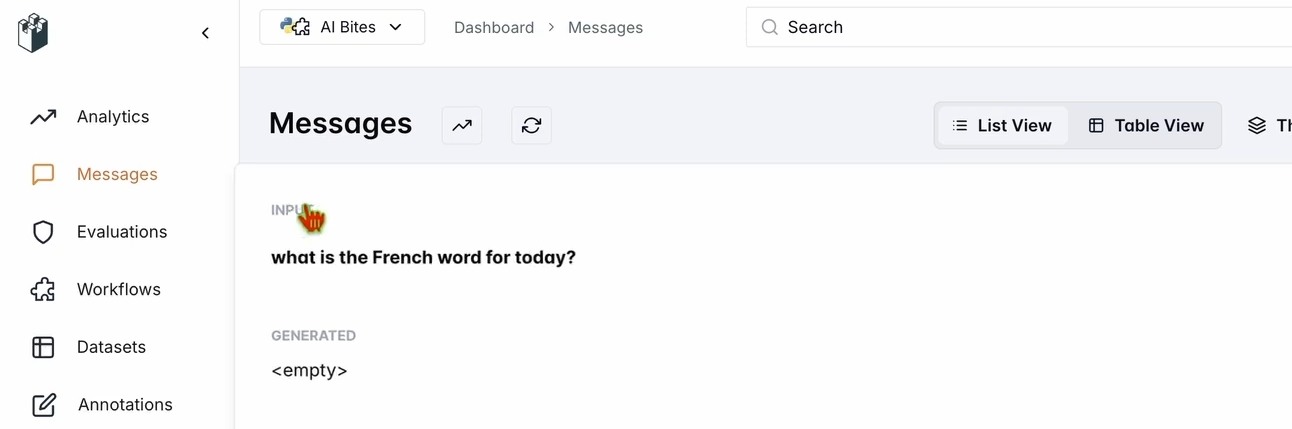

- Trong giao diện người dùng chatbot, hỏi: “Từ tiếng Pháp cho hôm nay là gì?”

- Kiểm tra bảng điều khiển LangWatch của bạn:

- Truy cập app.langwatch.ai.

- Chọn Messages từ thanh bên trái.

- Xác minh rằng câu hỏi của bạn và phản hồi của chatbot (ví dụ: “Aujourd’hui! 🇫🇷😊”) đã được theo dõi.

Bước 4: Thiết lập một quy trình để đánh giá Chatbot của bạn

Hãy tạo một bộ dữ liệu và công cụ đánh giá trong LangWatch để đánh giá hiệu suất của chatbot.

- Tạo bộ dữ liệu:

- Trong bảng điều khiển LangWatch, vào Datasets và nhấp vào New Dataset.

- Thêm một bộ dữ liệu đơn giản với ít nhất một câu hỏi và câu trả lời. Ví dụ:

| Question | Expected Answer |

|---|---|

| What’s the French word for today? | Aujourd’hui |

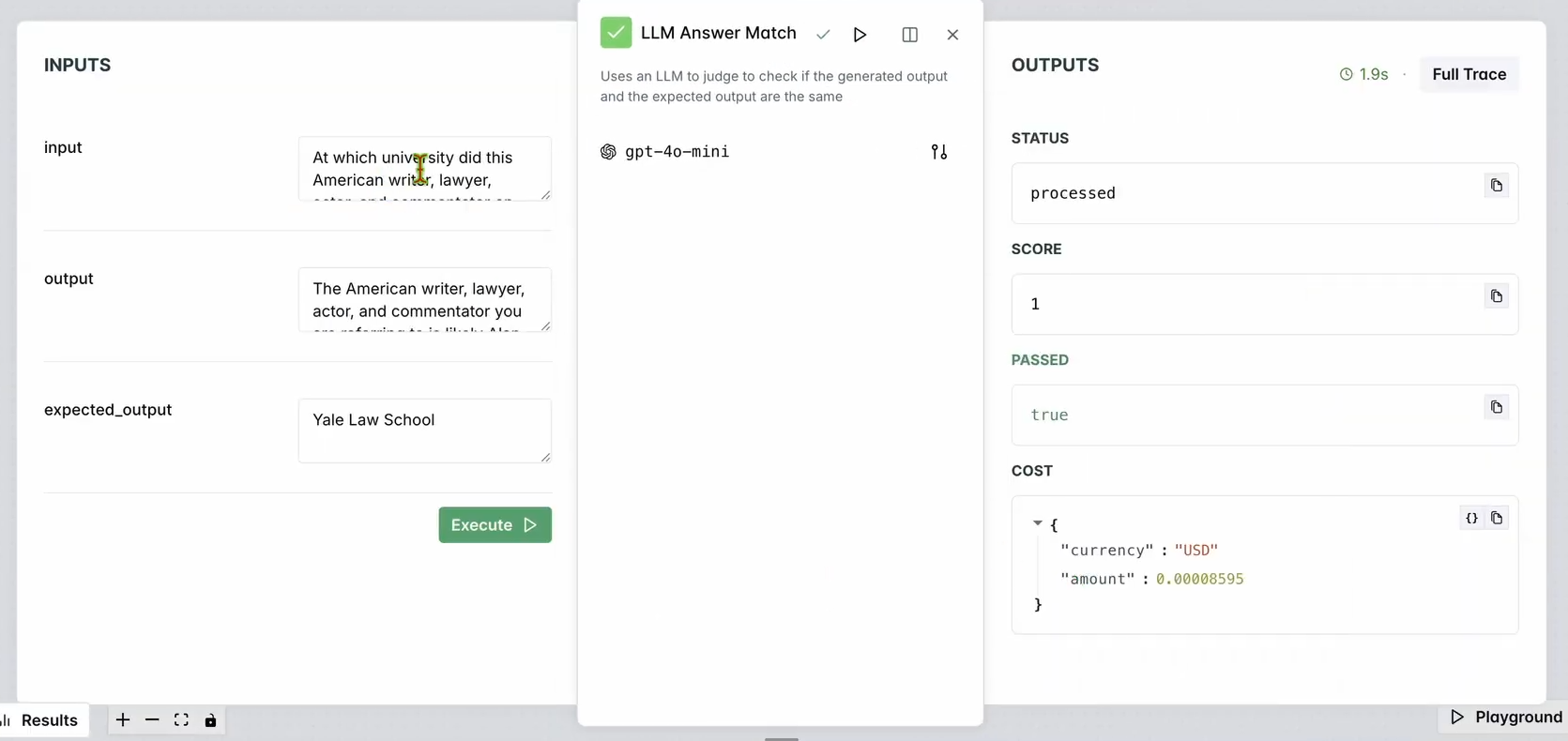

2. Thiết lập công cụ đánh giá:

- Truy cập Evaluators trong bảng điều khiển LangWatch.

- Kéo công cụ đánh giá LLM Answer Match vào không gian làm việc.

- Cấu hình nó:

- Đặt Input Question thành các câu hỏi đầu vào cơ sở dữ liệu của bạn (ví dụ: “What’s the French word for today?”).

- Đặt Expected Output cũng thành các phản hồi của cơ sở dữ liệu của bạn (ví dụ: “Aujourd’hui”).

- Tùy chọn, thay đổi mô hình LLM của công cụ đánh giá (ví dụ: Llama, Gemini, hoặc Claude Sonnet) để đa dạng.

3. Chạy công cụ đánh giá:

- Nhấp vào Run Workflow Until Here để kiểm tra công cụ đánh giá.

- Kiểm tra kết quả để đảm bảo phản hồi của chatbot khớp với đầu ra mong đợi.

Bạn sẽ thấy điều gì đó như sau:

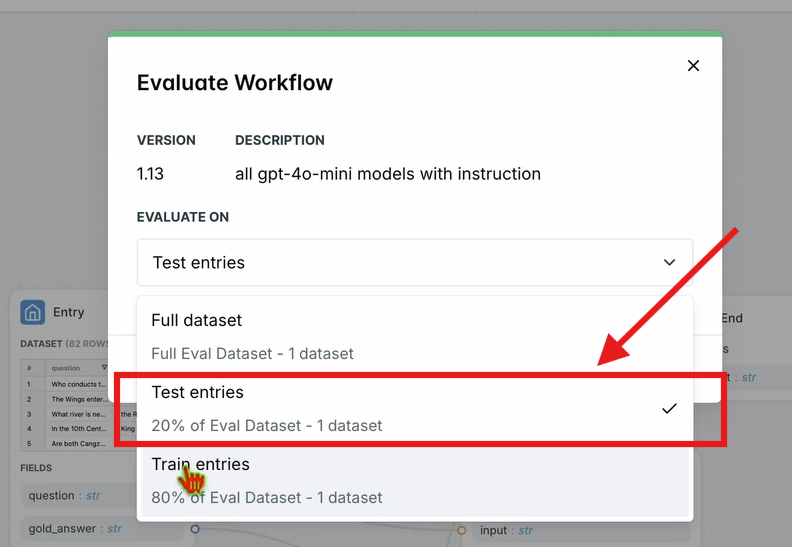

4. Đánh giá quy trình làm việc:

- Trong thanh điều hướng trên cùng, nhấp vào Evaluate Workflow và chọn Test Entries.

- Thao tác này sẽ đánh giá toàn bộ quy trình làm việc dựa trên bộ dữ liệu của bạn. Kết quả sẽ xuất hiện sau một thời gian xử lý ngắn.

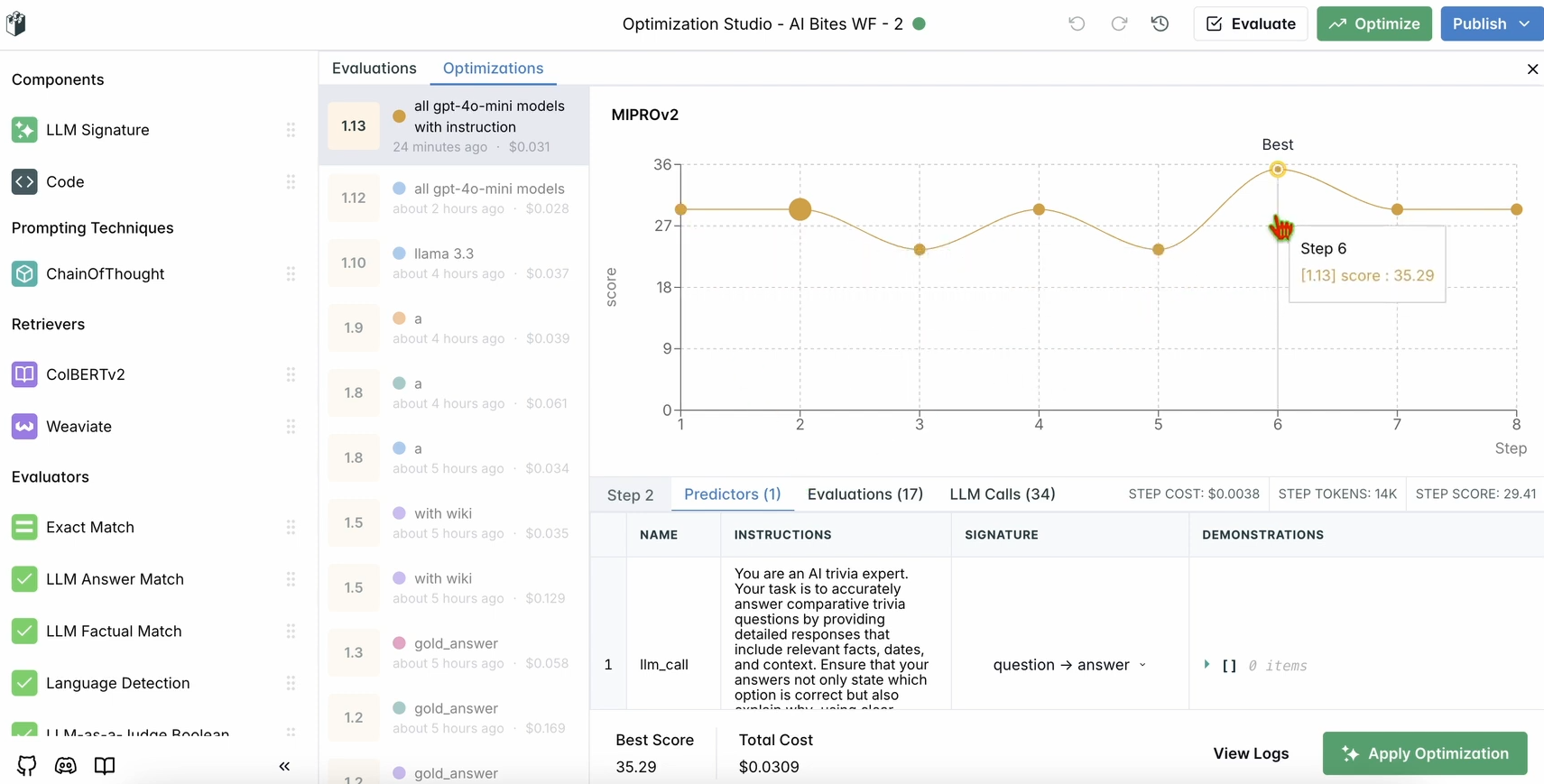

Bước 5: Tối ưu hóa quy trình làm việc của bạn

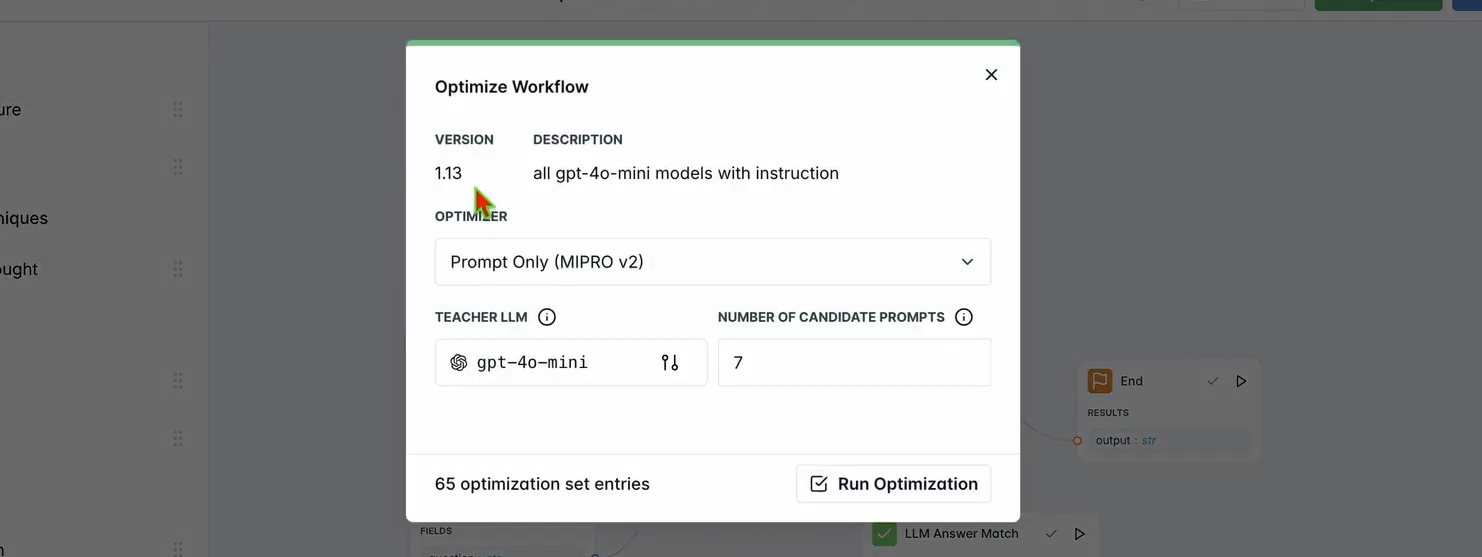

Sau khi quá trình đánh giá hoàn tất, hãy tối ưu hóa hiệu suất của chatbot.

1. Chạy Tối ưu hóa:

- Trong bảng điều khiển LangWatch, nhấp vào Optimize trên thanh điều hướng trên cùng.

- Chọn Prompt Only để tinh chỉnh lời nhắc của chatbot.

- Chờ vài phút để quá trình tối ưu hóa hoàn tất.

2. Kiểm tra cải tiến:

- Xem lại các kết quả tối ưu hóa trong bảng điều khiển. Bạn sẽ thấy độ chính xác hoặc chất lượng phản hồi được cải thiện dựa trên các đề xuất của LangWatch.

Bước 6: Tùy chọn thiết lập LangWatch cục bộ

Bạn muốn chạy LangWatch cục bộ để kiểm thử với dữ liệu nhạy cảm? Hãy làm theo các bước sau:

- Clone kho lưu trữ:

git clone https://github.com/langwatch/langwatch.git

cd langwatch

2. Thiết lập môi trường:

- Sao chép tệp môi trường ví dụ:

cp langwatch/.env.example langwatch/.env

3. Chạy với Docker:

- Khởi động máy chủ LangWatch:

docker compose up -d --wait --build

4. Tru cập bảng điều khiển:

- Mở http://localhost:5560 để vào quy trình khởi tạo của LangWatch.

- Làm theo các hướng dẫn để thiết lập phiên bản cục bộ của bạn.

Lưu ý: Thiết lập Docker chỉ dành cho mục đích kiểm thử và không thể mở rộng cho môi trường sản xuất. Để sản xuất, hãy sử dụng LangWatch Cloud hoặc Enterprise On-Premises.

Tại sao nên sử dụng LangWatch?

LangWatch giải quyết bài toán đánh giá LLM bằng cách cung cấp một nền tảng thống nhất để giám sát, đánh giá và tối ưu hóa các quy trình AI của bạn. Dù bạn đang tinh chỉnh lời nhắc, phân tích hiệu suất hay đảm bảo chatbot của bạn đưa ra câu trả lời chính xác (như “Aujourd’hui” cho “today” trong tiếng Pháp), LangWatch đều giúp mọi việc trở nên dễ dàng. Việc tích hợp của nó với Python và các công cụ như Chainlit và OpenAI có nghĩa là bạn có thể bắt đầu theo dõi và cải thiện các ứng dụng LLM của mình chỉ trong vài phút.

Ví dụ, chatbot demo của chúng ta hiện phản hồi bằng các đoạn tin nhắn ngắn giống tweet với biểu tượng cảm xúc, và LangWatch giúp đảm bảo nó chính xác và được tối ưu hóa. Muốn mở rộng quy mô? Thêm nhiều câu hỏi vào bộ dữ liệu của bạn hoặc thử nghiệm với các mô hình LLM khác nhau trong công cụ đánh giá.

Kết luận

Vậy là xong! Bạn đã tìm hiểu LangWatch là gì, cách cài đặt và cách sử dụng nó để giám sát và tối ưu hóa một chatbot. Từ việc thiết lập một dự án Python đến theo dõi tin nhắn và đánh giá hiệu suất với một bộ dữ liệu, LangWatch trao quyền cho bạn kiểm soát các quy trình LLM của mình. Câu hỏi kiểm thử của chúng ta—“Từ tiếng Pháp cho hôm nay là gì?”—đã cho thấy việc theo dõi và cải thiện phản hồi của AI dễ dàng như thế nào.

Sẵn sàng nâng cấp trò chơi AI của bạn? Hãy truy cập app.langwatch.ai, đăng ký và bắt đầu thử nghiệm với LangWatch ngay hôm nay.

Bạn muốn một nền tảng tích hợp, tất cả trong một để Đội ngũ Nhà phát triển của bạn làm việc cùng nhau với năng suất tối đa?

Apidog đáp ứng mọi yêu cầu của bạn, và thay thế Postman với mức giá phải chăng hơn nhiều!