Com dificuldades para avaliar e otimizar seus pipelines de modelos de linguagem grandes (LLM)? Apresentamos o LangWatch, uma plataforma revolucionária que facilita o monitoramento, a avaliação e o ajuste fino de seus fluxos de trabalho LLM personalizados. Neste guia, vamos nos aprofundar no que é o LangWatch, por que ele é incrível e como instalá-lo e usá-lo para impulsionar seus projetos de IA. Vamos configurar um chatbot simples, integrar o LangWatch e testá-lo com uma pergunta de exemplo — tudo isso de forma fácil de seguir. Vamos começar!

Quer uma plataforma integrada e completa para sua Equipe de Desenvolvedores trabalhar com produtividade máxima?

Apidog atende a todas as suas demandas e substitui o Postman por um preço muito mais acessível!

O Que É o LangWatch e Por Que Você Deveria Se Importar?

O LangWatch é a sua plataforma ideal para resolver o complexo problema da avaliação de LLMs. Ao contrário dos modelos tradicionais com métricas padrão como F1-score para classificação, BLEU para tradução ou ROUGE para sumarização, os LLMs generativos são não-determinísticos e difíceis de definir. Além disso, cada empresa tem seus próprios dados, modelos ajustados e pipelines personalizados, tornando a avaliação uma dor de cabeça. É aí que o LangWatch se destaca!

O LangWatch permite que você:

- Experimentar e Otimizar: Teste e melhore seus pipelines LLM com facilidade.

- Monitorar Desempenho: Acompanhe como sua IA se comporta em tempo real.

- Avaliar Resultados: Use conjuntos de dados e avaliadores para medir precisão e qualidade.

- Suportar Pipelines Personalizados: Funciona com seus dados e modelos exclusivos.

Seja você está construindo um chatbot, uma ferramenta de tradução ou um aplicativo de IA personalizado, o LangWatch ajuda a garantir que seu LLM entregue resultados de primeira linha. Pronto para vê-lo em ação? Vamos instalar e usar o LangWatch!

Guia Passo a Passo para Instalar e Usar o LangWatch

Pré-requisitos

Antes de começarmos, você precisará:

- Python 3.8+: Para executar o projeto (python.org).

- Conta LangWatch: Cadastre-se em app.langwatch.ai.

- Chave de API OpenAI: Para a demonstração do chatbot (obtenha uma em platform.openai.com).

- Editor de Código: VS Code, PyCharm ou seu IDE favorito.

- Git e Docker: Opcional, para configuração local do LangWatch.

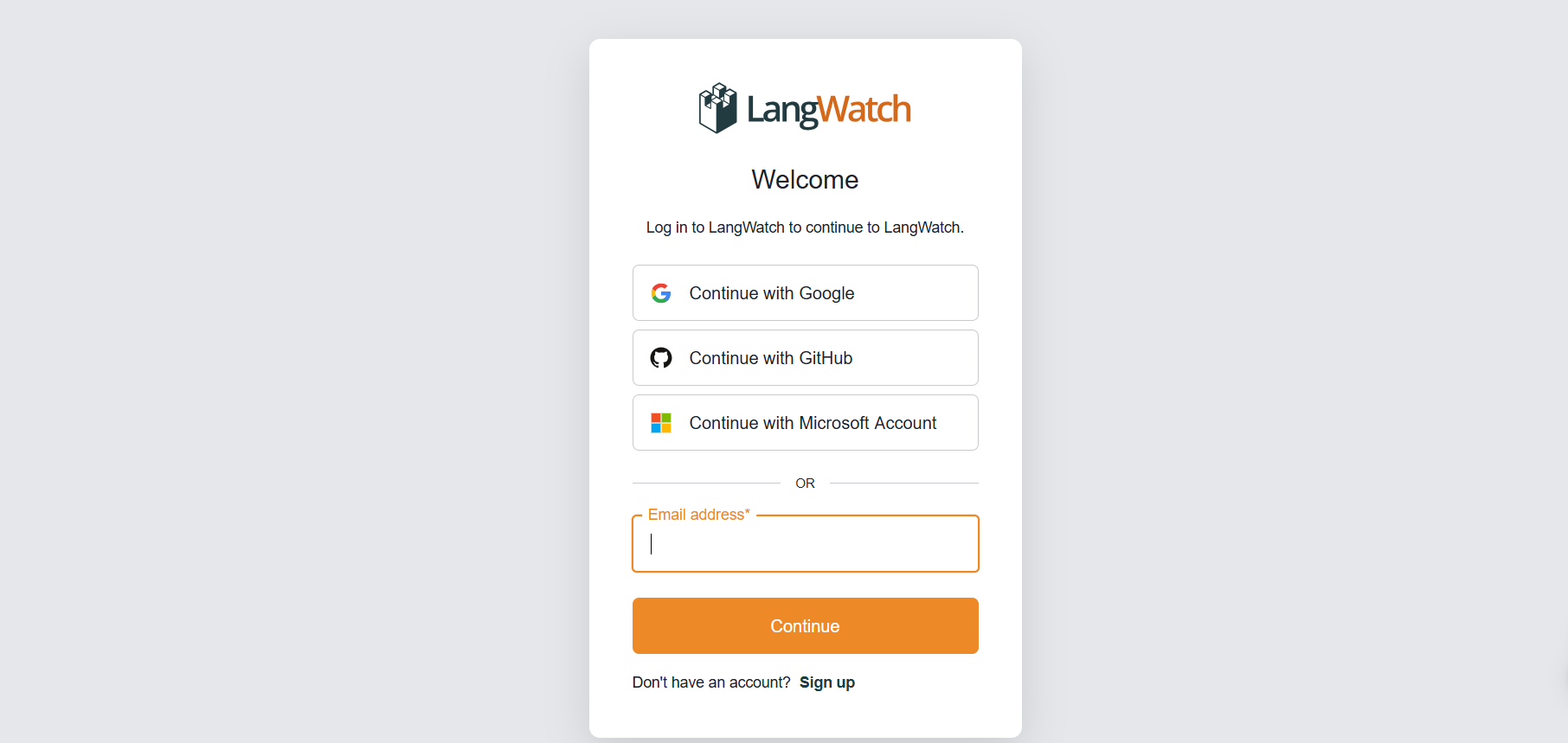

Passo 1: Cadastre-se no LangWatch

Criar uma Conta:

- Acesse app.langwatch.ai e cadastre-se para uma conta gratuita.

- Um projeto padrão chamado “AI Bites” é criado para você. Usaremos ele para este tutorial, mas você pode criar um novo se preferir.

Obter Sua Chave de API:

- No seu painel do LangWatch, vá para Project Settings (Configurações do Projeto) para encontrar sua

LANGWATCH_API_KEY. Você precisará dela mais tarde.

Passo 2: Configurar um Projeto Python com LangWatch

Vamos criar um projeto Python e integrar o LangWatch para rastrear um chatbot simples.

- Criar uma Pasta de Projeto:

- Crie um novo diretório (por exemplo,

langwatch-demo) e navegue até ele:

mkdir langwatch-demo

cd langwatch-demo

2. Configurar um Ambiente Virtual:

- Crie e ative um ambiente virtual para manter as dependências isoladas:

python -m venv venv

source venv/bin/activate # No Windows: venv\Scripts\activate

3. Instalar LangWatch e Dependências:

- Instale o LangWatch e o Chainlit (para a interface do usuário do chatbot):

pip install langwatch chainlit openai

4. Criar o Código do Chatbot:

- Crie um arquivo chamado

app.pye cole este código para construir um chatbot simples usando o modelo GPT-4o-mini da OpenAI:

import os

import chainlit as cl

import asyncio

from openai import AsyncClient

openai_client = AsyncClient() # Assumes OPENAI_API_KEY is set in environment

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

5. Definir Sua Chave de API OpenAI:

- Adicione sua chave de API OpenAI como uma variável de ambiente:

export OPENAI_API_KEY="your-openai-api-key" # No Windows: set OPENAI_API_KEY=your-openai-api-key

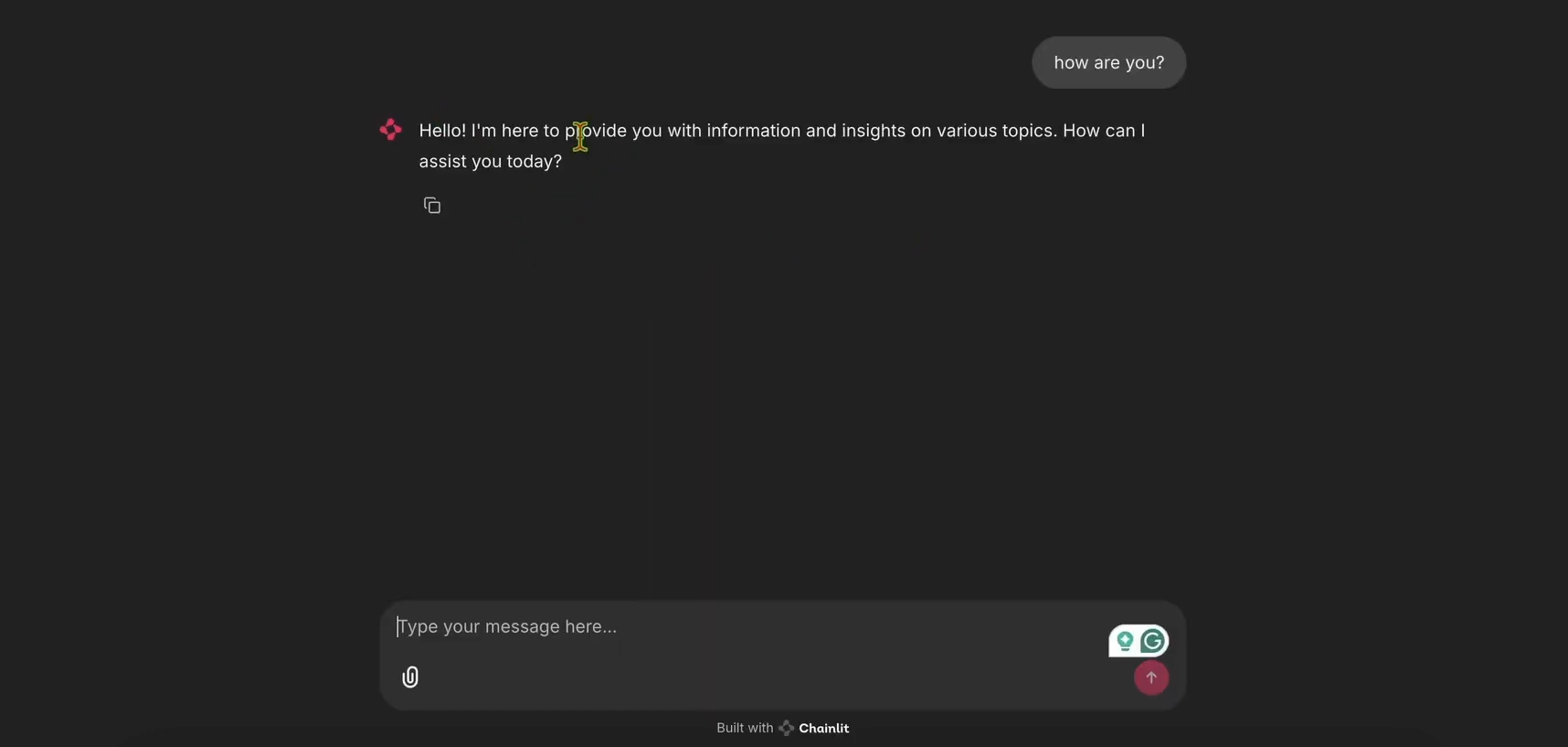

6. Executar o Chatbot:

- Inicie o aplicativo Chainlit:

chainlit run app.py

- Abra http://localhost:8000 para ver a interface do usuário do chatbot. Experimente para garantir que funciona!

Passo 3: Integrar o LangWatch para Rastreamento

Agora, vamos adicionar o LangWatch para rastrear as mensagens do chatbot.

- Modificar

app.pypara o LangWatch:

- Atualize

app.pypara incluir o LangWatch e adicione o decorador@langwatch.trace()à funçãomain:

import os

import chainlit as cl

import asyncio

import langwatch

from openai import AsyncClient

openai_client = AsyncClient()

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

@langwatch.trace()

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

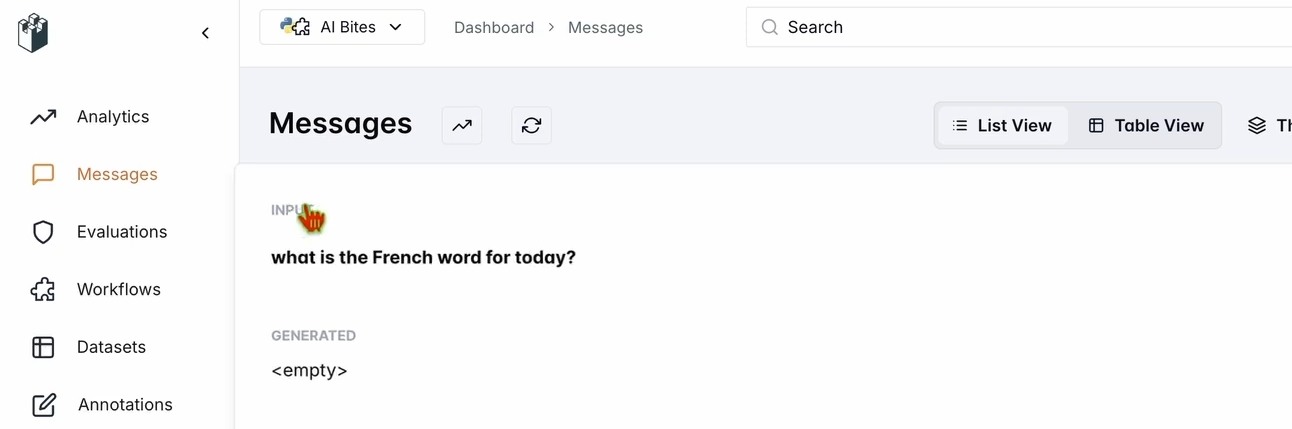

2. Testar a Integração:

- Reinicie o aplicativo Chainlit:

chainlit run app.py

- Na interface do usuário do chatbot, pergunte: “Qual é a palavra francesa para hoje?”

- Verifique seu painel do LangWatch:

- Vá para app.langwatch.ai.

- Selecione Messages (Mensagens) na barra lateral esquerda.

- Verifique se sua pergunta e a resposta do chatbot (por exemplo, “Aujourd’hui! 🇫🇷😊”) estão sendo rastreadas.

Passo 4: Configurar um Fluxo de Trabalho para Avaliar Seu Chatbot

Vamos criar um conjunto de dados e um avaliador no LangWatch para avaliar o desempenho do chatbot.

- Criar um Conjunto de Dados:

- No painel do LangWatch, vá para Datasets (Conjuntos de Dados) e clique em New Dataset (Novo Conjunto de Dados).

- Adicione um conjunto de dados simples com pelo menos uma pergunta e resposta. Por exemplo:

| Pergunta | Resposta Esperada |

|---|---|

| Qual é a palavra francesa para hoje? | Aujourd’hui |

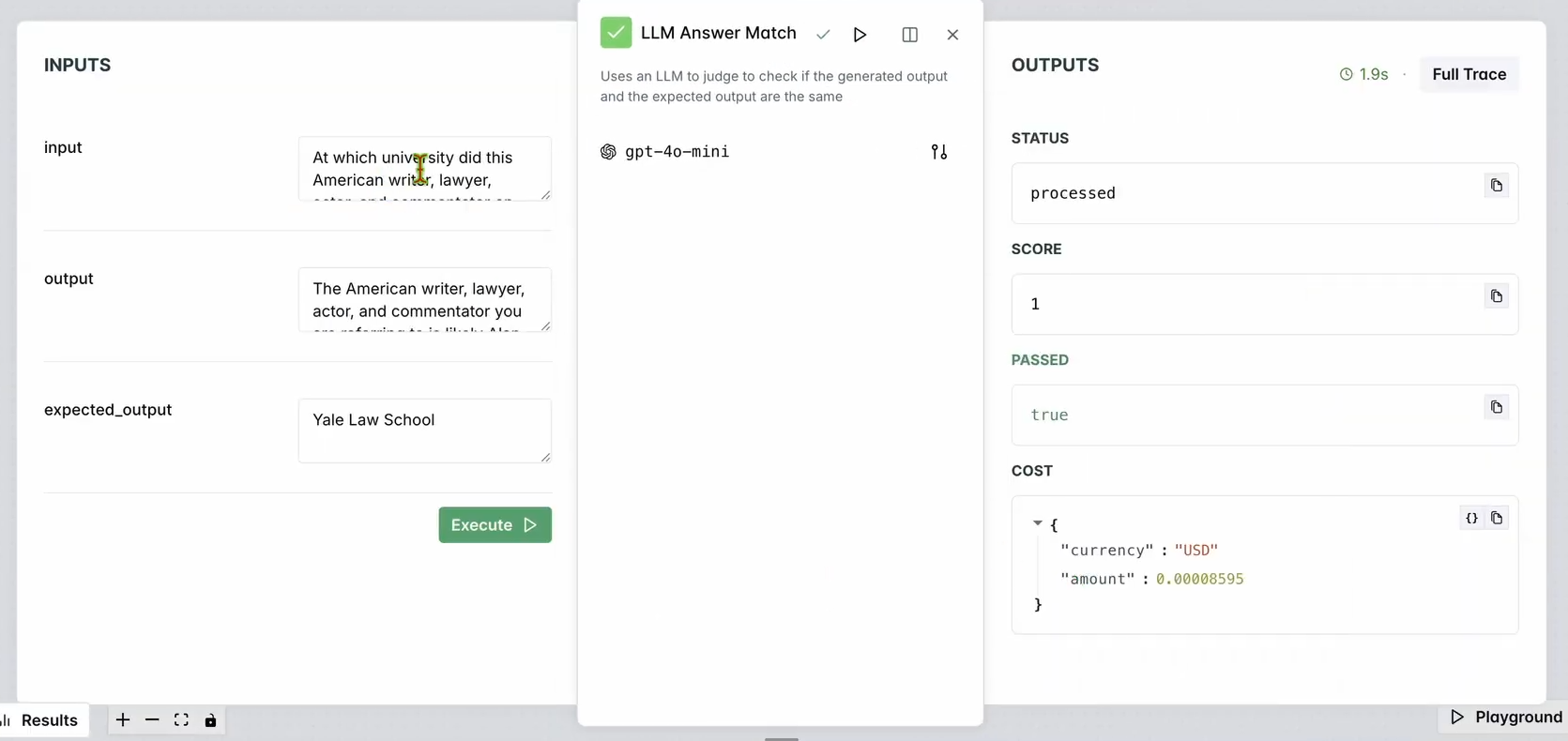

2. Configurar um Avaliador:

- Vá para Evaluators (Avaliadores) no painel do LangWatch.

- Arraste o avaliador LLM Answer Match (Correspondência de Resposta LLM) para a área de trabalho.

- Configure-o:

- Defina a Input Question (Pergunta de Entrada) para as perguntas de entrada do seu banco de dados (por exemplo, “Qual é a palavra francesa para hoje?”).

- Defina a Expected Output (Saída Esperada) também para as respostas do seu banco de dados (por exemplo, “Aujourd’hui”).

- Opcionalmente, altere o modelo LLM do avaliador (por exemplo, Llama, Gemini ou Claude Sonnet) para variar.

3. Executar o Avaliador:

- Clique em Run Workflow Until Here (Executar Fluxo de Trabalho Até Aqui) para testar o avaliador.

- Verifique os resultados para garantir que a resposta do chatbot corresponda à saída esperada.

Você deve ver algo como:

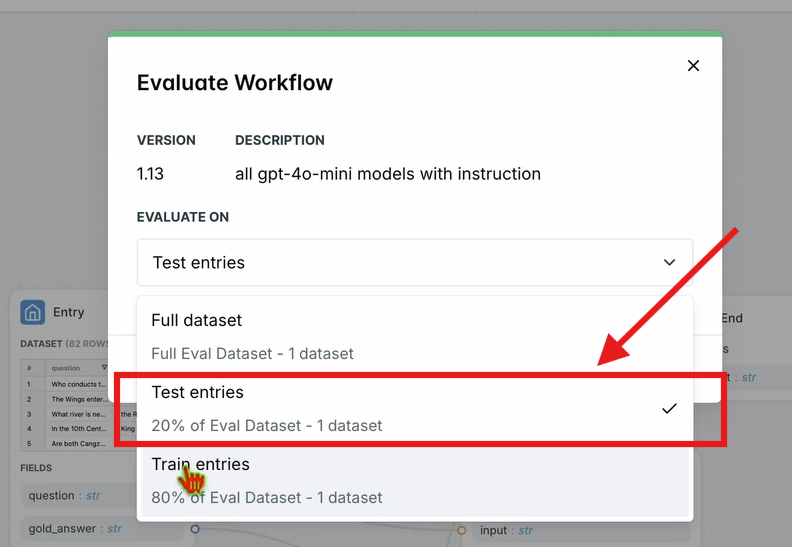

4. Avaliar o Fluxo de Trabalho:

- Na barra de navegação superior, clique em Evaluate Workflow (Avaliar Fluxo de Trabalho) e selecione Test Entries (Entradas de Teste).

- Isso avalia todo o fluxo de trabalho em relação ao seu conjunto de dados. Os resultados aparecerão após um curto tempo de processamento.

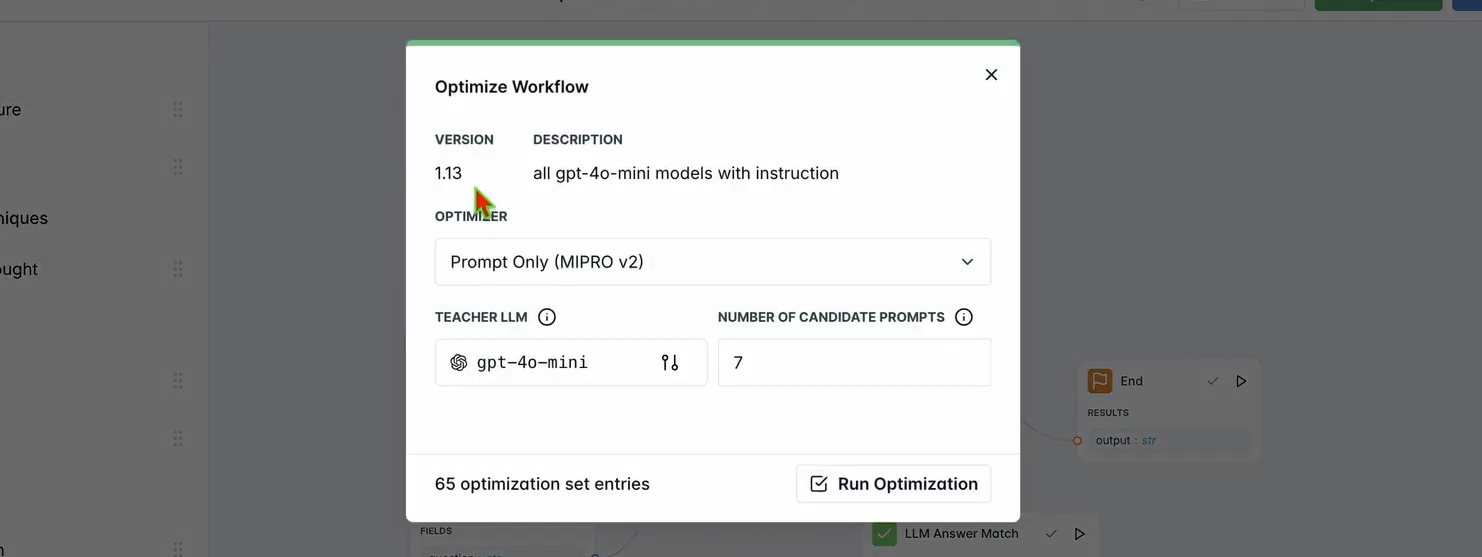

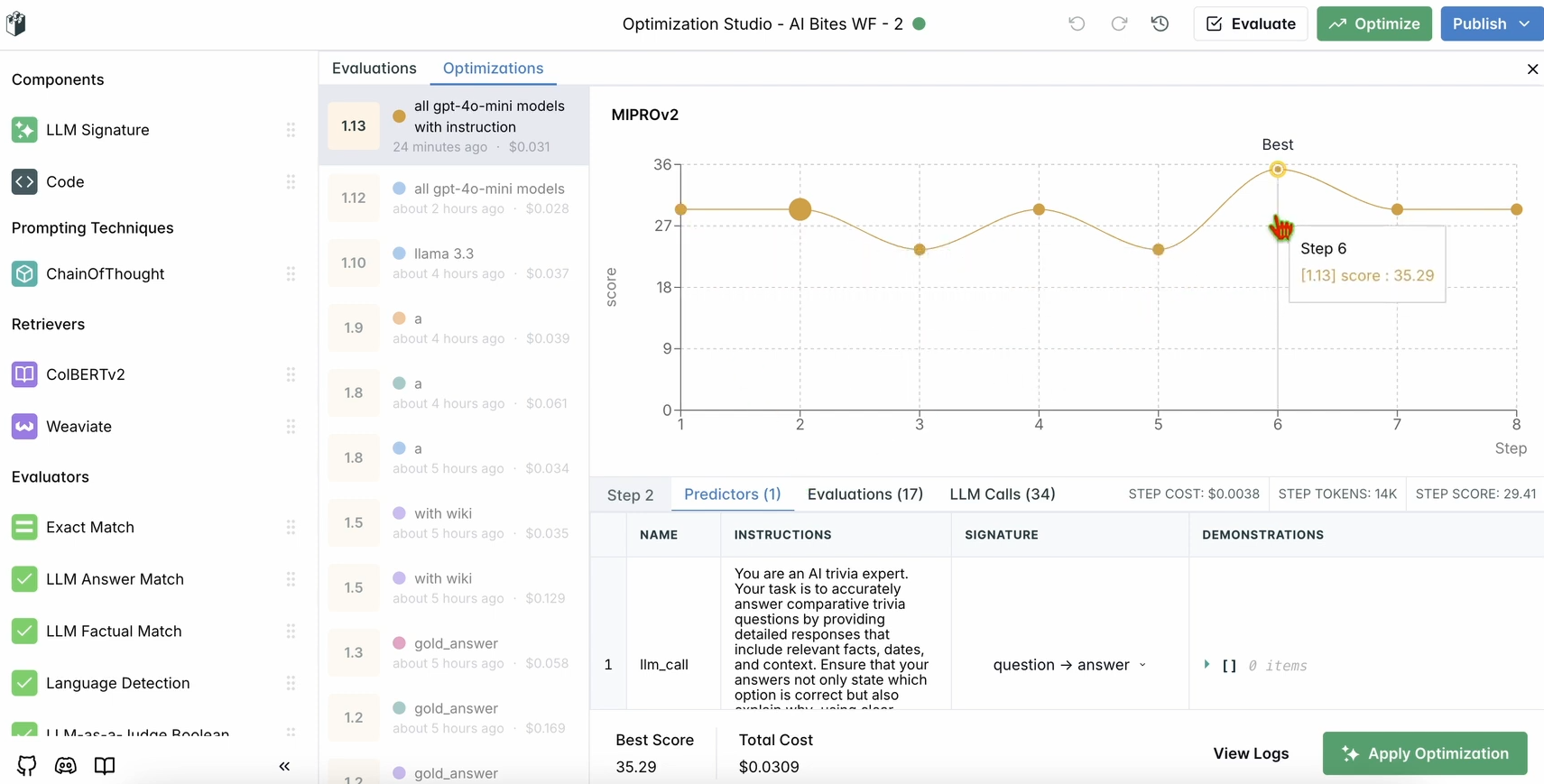

Passo 5: Otimizar Seu Fluxo de Trabalho

Uma vez concluída sua avaliação, vamos otimizar o desempenho do chatbot.

1. Executar Otimização:

- No painel do LangWatch, clique em Optimize (Otimizar) na barra de navegação superior.

- Selecione Prompt Only (Apenas Prompt) para ajustar o prompt do chatbot.

- Aguarde alguns minutos para que a otimização seja concluída.

2. Verificar Melhorias:

- Revise os resultados otimizados no painel. Você deve ver uma melhoria na precisão ou qualidade da resposta com base nas sugestões do LangWatch.

Passo 6: Configuração Opcional do LangWatch Local

Quer executar o LangWatch localmente para testes com dados sensíveis? Siga estes passos:

- Clonar o Repositório:

git clone https://github.com/langwatch/langwatch.git

cd langwatch

2. Configurar o Ambiente:

- Copie o arquivo de ambiente de exemplo:

cp langwatch/.env.example langwatch/.env

3. Executar com Docker:

- Inicie o servidor LangWatch:

docker compose up -d --wait --build

4. Acessar o Painel:

- Abra http://localhost:5560 para entrar no fluxo de integração do LangWatch.

- Siga as instruções para configurar sua instância local.

Nota: A configuração do Docker é apenas para testes e não é escalável para produção. Para produção, use o LangWatch Cloud ou Enterprise On-Premises.

Por Que Usar o LangWatch?

O LangWatch resolve o quebra-cabeça da avaliação de LLMs, fornecendo uma plataforma unificada para monitorar, avaliar e otimizar seus pipelines de IA. Seja ajustando prompts, analisando o desempenho ou garantindo que seu chatbot dê respostas precisas (como “Aujourd’hui” para “hoje” em francês), o LangWatch torna tudo mais fácil. Sua integração com Python e ferramentas como Chainlit e OpenAI significa que você pode começar a rastrear e melhorar seus aplicativos LLM em minutos.

Por exemplo, nosso chatbot de demonstração agora responde em explosões semelhantes a tweets com emojis, e o LangWatch ajuda a garantir que ele seja preciso e otimizado. Quer escalar? Adicione mais perguntas ao seu conjunto de dados ou experimente diferentes modelos LLM no avaliador.

Conclusão

Aí está! Você aprendeu o que é o LangWatch, como instalá-lo e como usá-lo para monitorar e otimizar um chatbot. Desde a configuração de um projeto Python até o rastreamento de mensagens e a avaliação de desempenho com um conjunto de dados, o LangWatch capacita você a assumir o controle de seus pipelines LLM. Nossa pergunta de teste — “Qual é a palavra francesa para hoje?” — mostrou como é fácil rastrear e melhorar as respostas da IA.

Pronto para elevar o nível do seu jogo de IA? Acesse app.langwatch.ai, cadastre-se e comece a experimentar o LangWatch hoje mesmo.

Quer uma plataforma integrada e completa para sua Equipe de Desenvolvedores trabalhar com produtividade máxima?

Apidog atende a todas as suas demandas e substitui o Postman por um preço muito mais acessível!