O desenvolvimento de software moderno enfrenta um desafio crítico: criar casos de teste abrangentes que realmente detectem bugs antes que eles cheguem à produção. As abordagens de teste tradicionais muitas vezes são insuficientes, deixando as equipes correndo para corrigir problemas após a implantação. No entanto, a inteligência artificial agora oferece uma solução poderosa que transforma a forma como abordamos a criação e execução de casos de teste.

Entendendo a Geração de Casos de Teste com IA

A inteligência artificial traz capacidades sem precedentes para o teste de software. Algoritmos de aprendizado de máquina analisam padrões de código, comportamento do usuário e dados históricos de bugs para gerar casos de teste que testadores humanos poderiam ignorar. Esta tecnologia não substitui a expertise humana, mas a amplifica, criando uma cobertura mais completa com menos esforço manual.

Sistemas de IA se destacam no reconhecimento de padrões e podem identificar potenciais pontos de falha examinando a estrutura do código, endpoints de API e fluxos de dados. Esses sistemas aprendem com ciclos de teste anteriores, melhorando continuamente sua capacidade de prever onde os problemas podem ocorrer. Consequentemente, as equipes alcançam uma melhor cobertura de teste enquanto reduzem o tempo gasto em tarefas de teste repetitivas.

Benefícios da IA no Desenvolvimento de Casos de Teste

Cobertura de Teste Aprimorada

Algoritmos de IA analisam sistematicamente os componentes de software para identificar lacunas de teste. O teste manual tradicional muitas vezes perde casos de borda devido a limitações humanas e restrições de tempo. Em contraste, sistemas alimentados por IA examinam cada caminho de código possível, gerando casos de teste para cenários que os desenvolvedores podem não considerar.

Modelos de aprendizado de máquina estudam padrões de comportamento de aplicativos e criam casos de teste que cobrem tanto casos de uso comuns quanto condições de borda incomuns. Essa abordagem abrangente reduz significativamente a probabilidade de bugs chegarem aos ambientes de produção.

Ciclos de Teste Acelerados

A velocidade se torna crucial nos fluxos de trabalho de desenvolvimento modernos. A IA reduz drasticamente o tempo necessário para criar e executar casos de teste. Enquanto testadores humanos podem passar horas escrevendo suítes de teste abrangentes, sistemas de IA geram centenas de casos de teste em minutos.

Além disso, os sistemas de IA atualizam automaticamente os casos de teste quando ocorrem alterações no código. Essa adaptação dinâmica garante que as suítes de teste permaneçam relevantes e eficazes durante todo o ciclo de vida de desenvolvimento, eliminando a necessidade de manutenção manual dos testes.

Qualidade de Teste Melhorada

Casos de teste gerados por IA frequentemente demonstram maior qualidade do que os criados manualmente. Algoritmos de aprendizado de máquina analisam vastas quantidades de dados de teste para identificar as estratégias de teste mais eficazes. Esses sistemas aprendem com casos de teste bem-sucedidos e incorporam padrões comprovados na nova geração de testes.

Além disso, a IA elimina erros humanos que ocorrem comumente na criação manual de testes. A consistência melhora em todos os casos de teste, garantindo que os padrões de teste permaneçam uniformes em todo o projeto.

Principais Ferramentas de IA para Geração de Casos de Teste

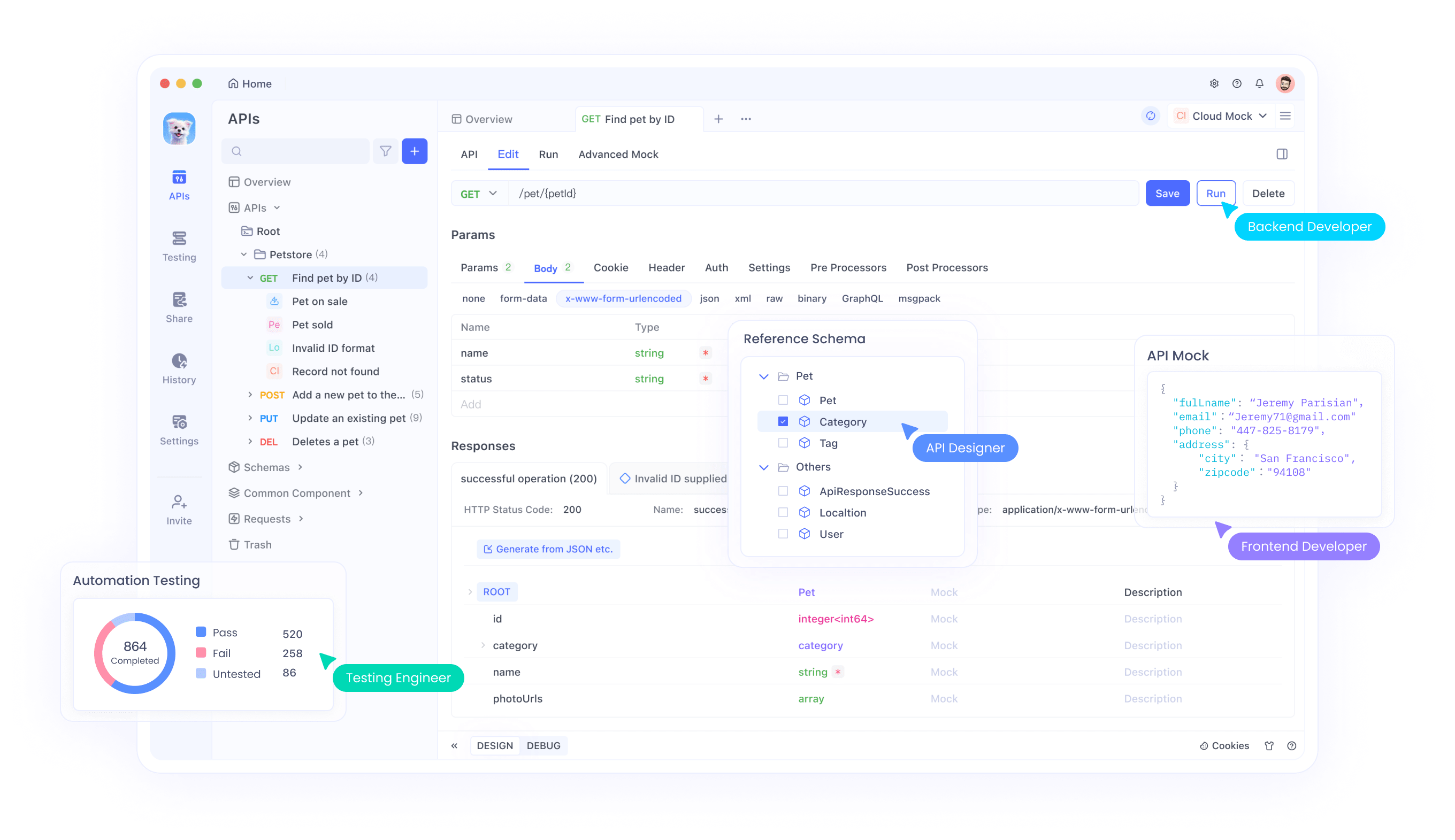

Apidog: Plataforma Abrangente de Teste de API

Apidog representa uma solução líder em testes de API com IA. Esta plataforma combina a geração inteligente de casos de teste com recursos robustos de execução. Os usuários podem gerar automaticamente casos de teste a partir de especificações de API, reduzindo o esforço manual e garantindo uma cobertura abrangente.

O motor de IA da plataforma analisa a documentação da API e cria automaticamente cenários de teste que validam funcionalidade, desempenho e segurança. As capacidades de aprendizado de máquina do Apidog melhoram continuamente a qualidade dos casos de teste com base nos resultados da execução e no feedback do usuário.

Ferramentas de Processamento de Linguagem Natural

Várias ferramentas de IA utilizam o processamento de linguagem natural para converter requisitos em casos de teste executáveis. Esses sistemas analisam histórias de usuários, critérios de aceitação e documentação para gerar suítes de teste abrangentes.

Ferramentas baseadas em PNL entendem o contexto e a intenção, criando casos de teste que se alinham com os requisitos de negócio. Essa abordagem preenche a lacuna entre as partes interessadas do negócio e as equipes técnicas, garantindo que os testes validem as necessidades reais do usuário.

Frameworks de Teste de Aprendizado de Máquina

Frameworks avançados integram algoritmos de aprendizado de máquina diretamente nos fluxos de trabalho de teste. Essas ferramentas analisam o comportamento da aplicação, identificam padrões e geram casos de teste que se adaptam às mudanças nos requisitos de software.

Frameworks de ML se destacam em testes de regressão, gerando automaticamente casos de teste que verificam se novas alterações de código não quebram a funcionalidade existente. Essa capacidade se mostra particularmente valiosa em ambientes de integração contínua.

Estratégias de Implementação para Testes com IA

Configurando Ambientes de Teste com IA

A implementação bem-sucedida de testes com IA requer planejamento e configuração cuidadosos. As equipes devem primeiro avaliar sua infraestrutura de teste atual e identificar áreas onde a IA pode fornecer o maior valor. Essa avaliação deve considerar as ferramentas existentes, a expertise da equipe e os requisitos do projeto.

A integração com ferramentas de desenvolvimento existentes torna-se crucial para uma adoção perfeita. As plataformas de teste de IA devem se conectar com sistemas de controle de versão, pipelines de integração contínua e ferramentas de gerenciamento de projetos. Essa integração garante que os casos de teste gerados por IA se encaixem naturalmente nos fluxos de trabalho estabelecidos.

Treinando Modelos de IA para Suas Necessidades Específicas

Sistemas de IA exigem dados de treinamento para gerar casos de teste eficazes. As equipes devem fornecer dados históricos de teste, relatórios de bugs e repositórios de código para treinar modelos de IA. Esse processo de treinamento ajuda os sistemas de IA a entender padrões e requisitos específicos do projeto.

Atualizações regulares de modelos garantem que os sistemas de IA permaneçam atualizados com bases de código em evolução e requisitos de negócios em mudança. As equipes devem estabelecer processos para alimentar novos dados de volta aos sistemas de IA, permitindo a melhoria contínua na qualidade dos casos de teste.

Estabelecendo Portões de Qualidade

Casos de teste gerados por IA requerem validação antes da execução. As equipes devem implementar processos de revisão que combinem a eficiência da IA com a expertise humana. Essa abordagem híbrida garante que os casos de teste gerados atendam aos padrões de qualidade, mantendo os benefícios de velocidade da geração de IA.

Os portões de qualidade devem incluir validação automatizada da sintaxe dos casos de teste, verificação de lógica e alinhamento com os requisitos de negócio. Esses pontos de verificação impedem que casos de teste de baixa qualidade entrem no pipeline de execução.

Melhores Práticas para o Desenvolvimento de Casos de Teste com IA

Combinando IA com Expertise Humana

As estratégias de teste mais eficazes combinam as capacidades da IA com a percepção humana. Os sistemas de IA se destacam na geração de casos de teste abrangentes, enquanto os testadores humanos fornecem contexto, criatividade e conhecimento de domínio.

As equipes devem estabelecer papéis claros onde a IA lida com tarefas repetitivas de geração de testes, e os humanos se concentram em cenários complexos, testes exploratórios e desenvolvimento de estratégia de teste. Essa divisão de trabalho maximiza os pontos fortes tanto da IA quanto dos testadores humanos.

Mantendo a Relevância dos Casos de Teste

Casos de teste gerados por IA exigem manutenção contínua para permanecerem eficazes. As equipes devem revisar e atualizar regularmente os casos de teste com base nas mudanças da aplicação, feedback do usuário e padrões de descoberta de bugs.

Sistemas automatizados de gerenciamento de casos de teste podem ajudar a manter a relevância rastreando os resultados da execução dos testes e identificando casos de teste desatualizados ou redundantes. Essa manutenção contínua garante que as suítes de teste continuem fornecendo valor ao longo do tempo.

Monitoramento e Otimização

O monitoramento contínuo do desempenho dos testes de IA permite otimização e melhoria. As equipes devem acompanhar métricas como porcentagem de cobertura de teste, taxas de detecção de bugs e taxas de falsos positivos para avaliar a eficácia da IA.

A análise regular dessas métricas ajuda a identificar áreas para melhoria e orienta ajustes nos algoritmos de IA e nos dados de treinamento. Essa abordagem iterativa garante que os sistemas de teste de IA evoluam e melhorem continuamente.

Desafios Comuns e Soluções

Problemas de Qualidade dos Dados

Sistemas de IA dependem de dados de treinamento de alta qualidade para gerar casos de teste eficazes. A má qualidade dos dados leva a casos de teste ineficazes que perdem bugs ou geram falsos positivos. As equipes devem investir em processos de limpeza e validação de dados para garantir que os sistemas de IA recebam dados de treinamento precisos.

As soluções incluem a implementação de pipelines de validação de dados, o estabelecimento de padrões de qualidade de dados e a auditoria regular de conjuntos de dados de treinamento. Essas medidas ajudam a manter a qualidade dos casos de teste gerados por IA.

Complexidade da Integração

A integração de ferramentas de teste de IA com fluxos de trabalho de desenvolvimento existentes pode apresentar desafios técnicos. Sistemas legados podem não ter APIs ou pontos de integração necessários para a conectividade da ferramenta de IA.

As equipes devem avaliar os requisitos de integração no início do processo de seleção e escolher ferramentas de IA que se alinhem com sua infraestrutura técnica. Abordagens de implementação gradual podem ajudar a minimizar a interrupção, permitindo que as equipes se adaptem a novos fluxos de trabalho.

Gerenciamento da Lacuna de Habilidades

Ferramentas de teste de IA exigem novas habilidades e conhecimentos que muitas equipes podem não possuir. As organizações devem investir em treinamento e desenvolvimento de habilidades para maximizar os benefícios dos testes alimentados por IA.

Os programas de treinamento devem cobrir o uso de ferramentas de IA, processos de revisão de casos de teste e gerenciamento de modelos de IA. Além disso, as equipes devem estabelecer práticas de compartilhamento de conhecimento para distribuir a expertise em testes de IA por toda a organização.

Medindo o Sucesso com Testes de IA

Indicadores Chave de Desempenho

A medição eficaz requer KPIs claros que demonstrem o valor dos testes de IA. Métricas importantes incluem porcentagem de cobertura de teste, taxas de detecção de bugs, tempo do ciclo de teste e custo por caso de teste.

As equipes devem estabelecer medições de linha de base antes da implementação da IA para avaliar com precisão a melhoria. A medição e o relatório regulares ajudam a demonstrar o ROI e a guiar futuros investimentos em testes de IA.

Cálculo de ROI

O cálculo do retorno sobre o investimento para testes de IA envolve a medição da economia de custos decorrente da redução do esforço de teste manual, melhor detecção de bugs e ciclos de lançamento mais rápidos.

Os cálculos de economia de custos devem incluir a redução do tempo da equipe de teste, a diminuição dos custos de correção de bugs e a melhoria da satisfação do cliente com lançamentos de maior qualidade. Esses cálculos abrangentes de ROI ajudam a justificar os investimentos em testes de IA e a guiar as decisões de expansão.

Tendências Futuras em Testes de IA

Integração Avançada de Aprendizado de Máquina

Futuras ferramentas de teste de IA incorporarão algoritmos de aprendizado de máquina mais sofisticados que fornecerão insights mais profundos sobre o comportamento do software. Esses sistemas preverão potenciais pontos de falha com maior precisão e gerarão casos de teste mais direcionados.

Avanços em aprendizado profundo e redes neurais permitirão que os sistemas de IA compreendam interações complexas de software e gerem casos de teste que validem o comportamento de todo o sistema, em vez de apenas componentes individuais.

Sistemas de Teste Autônomos

O futuro promete sistemas de teste totalmente autônomos que exigirão mínima intervenção humana. Esses sistemas gerarão, executarão e manterão automaticamente os casos de teste, adaptando-se continuamente às mudanças do software.

O teste autônomo permitirá a validação contínua durante todo o ciclo de vida de desenvolvimento, fornecendo feedback imediato sobre a qualidade e funcionalidade do código. Essa capacidade de teste em tempo real revolucionará a forma como as equipes abordam a garantia de qualidade de software.

Conclusão

A geração de casos de teste com IA representa uma mudança fundamental nas abordagens de teste de software. Ao alavancar algoritmos de aprendizado de máquina e automação inteligente, as equipes podem alcançar melhor cobertura de teste, ciclos de teste mais rápidos e qualidade de software aprimorada.

O sucesso com testes de IA requer implementação cuidadosa, otimização contínua e a combinação certa de capacidades de IA com expertise humana. Equipes que abraçam essas tecnologias, mantendo o foco na qualidade e nas necessidades do usuário, obterão vantagens competitivas significativas no desenvolvimento de software.

O futuro dos testes de software reside na combinação inteligente da automação de IA e da criatividade humana. Organizações que investem em capacidades de teste de IA hoje estarão melhor posicionadas para entregar software de alta qualidade em um mercado cada vez mais competitivo.