현대 애플리케이션에서 텍스트 프롬프트로부터 고품질 이미지를 생성하려면 효율적인 도구가 필요합니다. Z-Image API는 이러한 요구를 직접적으로 충족시킵니다. 개발자는 포토리얼리스틱한 결과를 빠르게 제공하는 무료 인터페이스를 통해 강력한 텍스트-이미지 모델에 접근할 수 있습니다. 이 API는 Alibaba의 Tongyi-MAI 팀에서 Apache 2.0 라이선스 하에 운영되는 오픈 소스 Z-Image-Turbo 모델을 활용합니다. 적합한 하드웨어에서 1초 미만의 추론 속도를 제공하여 웹 앱, 모바일 도구 또는 자동화된 워크플로의 실시간 기능에 이상적입니다.

다음으로, Z-Image-Turbo의 오픈 소스 기반을 살펴봅니다. 그런 다음 API 접근 방식에 대한 통찰력을 얻고 무료 가격 구조를 확인합니다. 마지막으로, 실제 통합을 구현합니다. 이 단계들을 통해 이미지 생성 기능을 효과적으로 배포할 준비를 갖추게 됩니다.

Z-Image-Turbo 오픈 소스 모델 이해하기

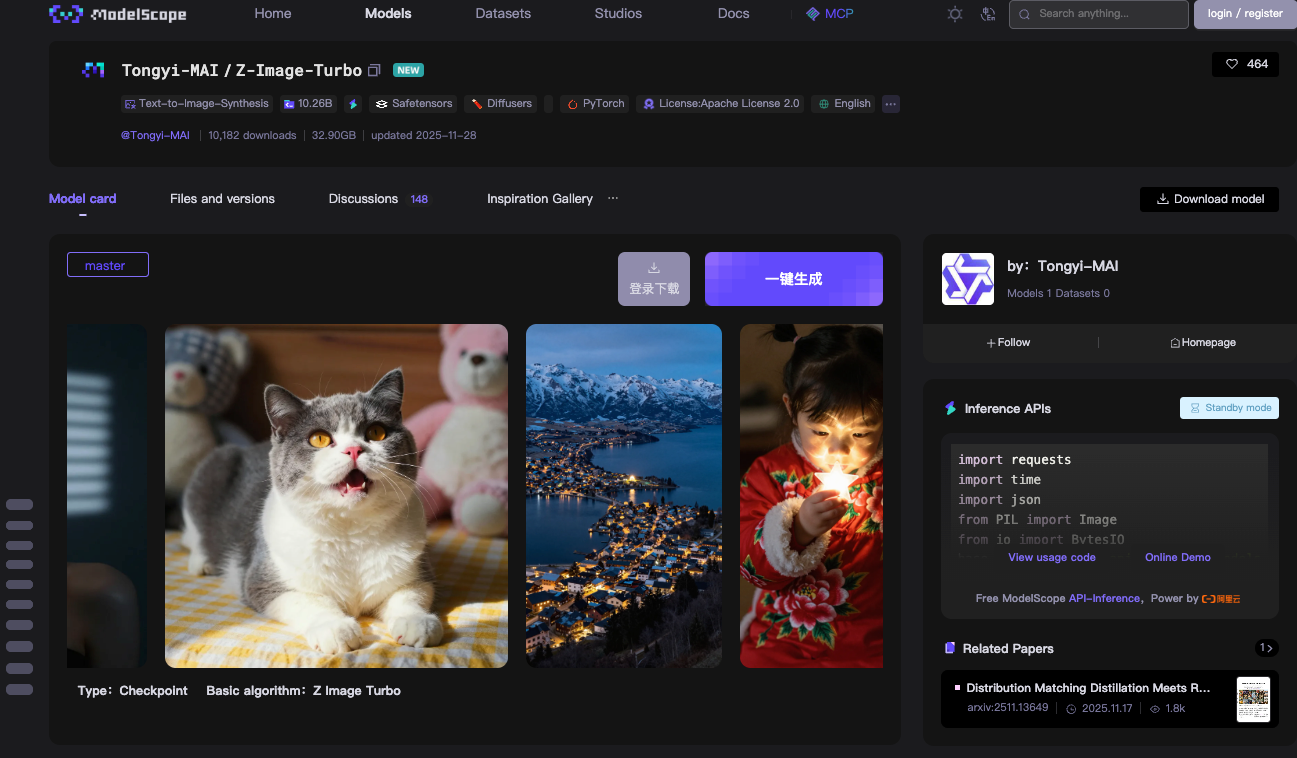

Z-Image API의 핵심 기술인 Z-Image-Turbo 모델부터 시작합니다. Alibaba의 Tongyi-MAI 팀은 이 60억 개의 매개변수를 가진 모델을 Apache 2.0 라이선스 하에 완전한 오픈 소스로 공개했습니다. 이 라이선스는 상업적 사용, 수정 및 배포를 제한 없이 허용하여, 프로덕션 환경에서의 도입을 가속화합니다.

Z-Image-Turbo는 Scalable Single-Stream Diffusion Transformer (S3-DiT) 아키텍처를 기반으로 합니다. 기존의 듀얼 스트림 모델은 텍스트 및 이미지 처리를 분리하여 매개변수를 낭비했습니다. 그러나 S3-DiT는 텍스트 토큰, 시각적 의미 토큰 및 이미지 VAE 토큰을 하나의 통합 스트림으로 연결합니다. 이 설계는 효율성을 극대화합니다. 결과적으로 이 모델은 NVIDIA RTX 40 시리즈 카드와 같은 소비자용 GPU의 16GB VRAM 내에서 작동합니다. 이를 통해 출력 품질을 희생하지 않고도 이룰 수 있습니다.

이 모델은 포토리얼리스틱한 이미지 합성에 탁월합니다. 묘사적인 프롬프트로부터 상세한 장면, 인물 사진 및 풍경을 생성합니다. 예를 들어, "해 질 녘 고요한 산속 호수와 영어 및 중국어 이중 언어 표지판"과 같은 프롬프트는 선명하고 문맥을 인지하는 시각 자료를 생성합니다. Z-Image-Turbo는 통합된 프롬프트 인핸서(Prompt Enhancer) 덕분에 복잡한 지시를 잘 처리합니다. 이 구성 요소는 더 나은 준수를 위해 입력을 정제하여 초기 확산 모델에서 흔히 발생하는 아티팩트를 줄입니다.

추론 속도는 Z-Image-Turbo의 강점입니다. 실제로 9단계 추론과 동일한 단 8개의 함수 평가 수(NFE)만 필요합니다. 엔터프라이즈 H800 GPU에서는 1초 미만의 대기 시간(종종 이미지당 500ms 미만)을 볼 수 있습니다. 소비자용 설정에서는 하드웨어에 따라 2-5초가 소요됩니다. 이러한 효율성은 Decoupled-DMD 및 DMDR과 같은 증류(distillation) 기술에서 비롯되며, 이는 기본 Z-Image 모델의 성능을 유지하면서 압축합니다.

모델 가중치는 ModelScope 또는 Hugging Face 리포지토리에서 다운로드할 수 있습니다. 마스터 브랜치에는 총 약 24GB의 체크포인트 파일이 포함되어 있습니다. PyTorch 호환성은 광범위한 통합을 보장합니다. 로컬 테스트를 위해서는 pip를 통해 `torch`, `torchvision`, `modelscope>=1.18.0`와 같은 의존성을 설치해야 합니다. 기본적인 파이프라인 스크립트는 10줄 미만의 코드로 모델을 로드하고 이미지를 생성합니다.

로컬 추론을 위한 다음 예시를 살펴보세요:

from modelscope.pipelines import pipeline

from modelscope.utils.constant import Tasks

import torch

device = "cuda" if torch.cuda.is_available() else "cpu"

pipe = pipeline(Tasks.text_to_image_synthesis, model="Tongyi-MAI/Z-Image-Turbo", device=device)

output = pipe({

"text": "A photorealistic golden retriever playing in a sunlit park, 1024x1024",

"width": 1024,

"height": 1024,

"num_inference_steps": 9

})

output["output_imgs"][0].save("generated_image.png")

이 코드는 파이프라인을 초기화하고, 프롬프트를 처리하며, 결과를 저장합니다. `num_inference_steps: 9` 매개변수는 최적의 속도를 위한 8단계 증류(distillation)를 트리거합니다. Turbo 변형은 속도를 유지하기 위해 classifier-free guidance를 건너뛰므로 guidance scale은 0.0으로 유지됩니다.

벤치마크는 Z-Image-Turbo의 경쟁력을 입증합니다. Alibaba의 AI 아레나에서 Elo 기반 인간 선호도 평가에서 높은 점수를 얻었으며, 포토리얼리즘과 텍스트 충실도 면에서 많은 오픈 소스 동종 모델들을 능가합니다. Stable Diffusion 3와 같은 모델과 비교할 때, 더 적은 단계와 메모리를 사용하면서도 유사한 수준의 디테일을 제공합니다.

그러나 한계점도 존재합니다. 이 모델은 극단적인 해상도보다 속도를 우선시합니다. 1536x1536을 초과하는 해상도는 미세 조정 없이 흐릿함을 유발할 수 있습니다. 또한 Turbo 변형에는 기본 이미지-투-이미지 편집 기능이 없습니다. 이는 향후 Z-Image-Edit 릴리스에서 다룰 예정입니다. 그럼에도 불구하고 텍스트-이미지 작업에서 Z-Image-Turbo는 견고하고 접근 가능한 기반을 제공합니다.

ModelScope의 인프라에서 호스팅되는 Z-Image API를 통해 이 모델을 확장할 수 있습니다. 로컬에서 클라우드로의 전환은 설정 부담을 없애줍니다. 결과적으로 하드웨어 최적화보다는 애플리케이션 로직에 집중할 수 있습니다.

무료 Z-Image API 접근하기: 단계별 설정

API 통합으로 원활하게 전환할 수 있습니다. Z-Image API는 원격 호출을 위해 Z-Image-Turbo를 호스팅하는 ModelScope의 추론 서비스를 통해 작동합니다. 이 설정은 최소한의 구성만 필요하지만, 엔터프라이즈급 안정성을 제공합니다.

먼저, ModelScope 플랫폼에 등록합니다. 이메일 또는 GitHub 자격 증명으로 계정을 생성하세요. 로그인한 후, 프로필 아래의 API 섹션으로 이동합니다. ModelScope 토큰을 생성하세요. 이 토큰은 Bearer 인증 키 역할을 합니다. 모든 요청에 Authorization 헤더에 필요하므로 안전하게 보관하세요.

API 엔드포인트는 높은 처리량 요구 사항에 적합한 비동기 처리 방식을 중심으로 합니다. POST 요청을 `https://api-inference.modelscope.cn/v1/images/generations`로 보내 생성 작업을 제출합니다. 응답은 즉시 `task_id`를 반환합니다. 그런 다음, 완료될 때까지 `https://api-inference.modelscope.cn/v1/tasks/{task_id}`를 5-10초마다 폴링합니다. 이 설계는 긴 생성 과정에서 타임아웃을 방지하며, Z-Image-Turbo의 속도 덕분에 대기 시간은 짧습니다(일반적으로 처음부터 끝까지 5-15초).

주요 헤더는 다음과 같습니다:

Authorization: Bearer {your_token}Content-Type: application/jsonX-ModelScope-Async-Mode: true(제출용)X-ModelScope-Task-Type: image_generation(상태 확인용)

요청 본문은 모델 ID, 프롬프트, 치수 및 단계와 같은 매개변수를 지정합니다. 이 변형을 대상으로 하려면 `"model": "Tongyi-MAI/Z-Image-Turbo"`로 설정합니다. 기본 치수는 1024x1024이지만, 사용자 정의 종횡비를 위해 `height`와 `width`를 조정할 수 있습니다. 최상의 결과를 위해 `guidance_scale: 0.0`과 `num_inference_steps: 9`를 유지하세요.

완전한 curl 예시가 이 과정을 보여줍니다:

# Step 1: Submit task

curl -X POST "https://api-inference.modelscope.cn/v1/images/generations" \

-H "Authorization: Bearer YOUR_TOKEN" \

-H "Content-Type: application/json" \

-H "X-ModelScope-Async-Mode: true" \

-d '{

"model": "Tongyi-MAI/Z-Image-Turbo",

"prompt": "A futuristic cityscape at night with neon signs in Chinese and English",

"height": 1024,

"width": 1024,

"num_inference_steps": 9,

"guidance_scale": 0.0

}'

# Extract task_id from response, e.g., {"task_id": "abc123"}

# Step 2: Poll status

curl -X GET "https://api-inference.modelscope.cn/v1/tasks/abc123" \

-H "Authorization: Bearer YOUR_TOKEN" \

-H "X-ModelScope-Task-Type: image_generation"

성공 시, 상태 응답에는 `"task_status": "SUCCEED"`와 다운로드 가능한 URL을 포함하는 `output_images` 배열이 포함됩니다. GET을 통해 이미지를 가져와 PNG 또는 JPEG로 저장합니다.

동기식 대안으로, ModelScope는 modelscope.cn/aigc/imageGeneration에서 온라인 데모를 제공합니다. Z-Image-Turbo를 기본 모델로 선택하세요. 빠른 모드(Quick Mode)는 매개변수 없이 이미지를 생성하며, 고급 모드(Advanced Mode)는 모든 제어 기능을 노출합니다. 이 인터페이스는 프로토타이핑에 사용되지만, 자동화를 위해서는 API를 선호할 것입니다.

오류 처리는 필수적입니다. 일반적인 코드로는 401 (유효하지 않은 토큰), 429 (속도 제한), 500 (서버 문제) 등이 있습니다. 프로덕션 코드에서는 지수 백오프(exponential backoff)를 사용하여 재시도를 구현하세요. 무료 계정의 속도 제한은 계정마다 정확한 할당량이 다르지만, 분당 약 10-20 요청 수준입니다.

이 API를 다양한 환경에 통합할 수 있습니다. Python 개발자는 이전에 보여준 것처럼 HTTP 호출에 `requests`를 사용합니다. Node.js 사용자는 프라미스 기반 폴링을 위해 `axios`를 활용합니다. 가벼운 페이로드를 고려하면 AWS Lambda 또는 Vercel의 서버리스 함수도 쉽게 배포할 수 있습니다.

Apidog는 이 접근 단계를 향상시킵니다. API 사양을 Apidog로 가져오면 문서와 테스트 케이스가 자동으로 생성됩니다. 응답을 시뮬레이션하고, 폴링을 위한 요청을 연결하며, 팀 공유를 위해 컬렉션을 내보낼 수 있습니다. 이 플랫폼은 디버깅 시간을 줄여 프롬프트 엔지니어링에 집중할 수 있도록 돕습니다.

이러한 단계를 통해 Z-Image API에 대한 신뢰할 수 있는 연결을 설정했습니다. 이제 비용 효율성을 확인하기 위해 가격 정책을 살펴보겠습니다.

Z-Image API의 가격 및 할당량

다음으로 경제성을 확인합니다. Z-Image API는 추론에 대한 비용을 부과하지 않습니다. ModelScope는 공식 X 게시물에서 발표했듯이 Z-Image-Turbo 호출에 대해 무제한 무료 컴퓨팅을 제공합니다. 이 무료 모델에는 호스팅, 대역폭 및 GPU 리소스가 포함되는데, 이는 AI 서비스 중에서는 드문 경우입니다.

그러나 남용을 방지하기 위해 할당량이 적용됩니다. 무료 계정은 약한 제한(소프트 리밋)이 있으며, 시간당 약 50-100회의 생성이 가능하며 주기적으로 재설정됩니다. ModelScope 대시보드를 통해 사용량을 모니터링할 수 있습니다. 제한을 초과하면 일시적인 스로틀링이 발생하지만, 필요한 경우 더 많은 볼륨을 위해 프로 티어로 업그레이드할 수 있습니다. 프로 플랜은 낮은 요금부터 시작하지만, 대부분의 개발자와 취미 사용자에게는 무료 티어로 충분합니다.

Z-Image API 성능 최적화를 위한 모범 사례

대상 전략을 통해 사용법을 개선합니다. 먼저, 최적의 매개변수를 선택하세요. 균형을 위해 1024x1024를 고수하고, 필요하면 생성 후 업스케일링하세요. 단계를 9로 제한하세요. 더 높은 값은 이득 없이 추론 속도만 늦춥니다.

하드웨어 가속은 로컬 하이브리드 성능을 향상시킵니다. Diffusers에서 Flash Attention을 활성화하세요: `pipe.transformer.set_attention_backend("flash")`. 이는 Ampere GPU에서 메모리를 20-30% 절감합니다.

프롬프트 엔지니어링은 품질을 향상시킵니다. "주제 + 행동 + 환경 + 스타일"과 같이 입력을 구성하세요. Apidog의 모의 모드에서 다양한 변형을 테스트하여 빠르게 반복 작업을 수행하세요.

보안 관행은 통합을 보호합니다. 클라이언트 측 코드에 토큰을 노출하지 말고, 서버 프록시를 사용하세요. 주입 공격을 방지하기 위해 입력을 검증하세요.

모니터링 도구는 지표를 추적합니다. 생성 시간, 성공률 및 토큰 사용량을 기록하세요. Prometheus와 같은 도구는 대시보드를 위해 쉽게 통합됩니다.

결론

이제 Z-Image API를 완전히 숙달했습니다. Z-Image-Turbo의 오픈 소스 아키텍처를 이해하는 것부터 API 호출을 실행하고 워크플로를 최적화하는 것까지, 이 가이드는 여러분의 성공을 위한 준비를 갖추게 합니다. 무료 가격 모델은 고급 이미지 생성을 대중화하며, Apidog와 같은 도구는 개발을 간소화합니다.

다음 프로젝트에서 이러한 기술을 구현해 보세요. 프롬프트를 실험하고, 통합을 확장하며, 생태계에 기여하세요. AI가 발전함에 따라 Z-Image-Turbo는 효율적이고 창의적인 도구의 선두에 여러분을 자리매김하게 할 것입니다.