자율 에이전트에 추론 기능을 부여하는 모델을 개발자와 연구자들이 찾고 있습니다. DeepSeek-V3.2와 그 전문 변형 모델인 DeepSeek-V3.2-Speciale은 이러한 요구를 정확하게 충족합니다. 이 모델들은 DeepSeek-V3.2-Exp와 같은 이전 버전들을 기반으로 논리적 추론, 수학적 문제 해결, 에이전트 워크플로우에서 향상된 기능을 제공합니다. 이제 엔지니어들은 복잡한 쿼리를 효율적으로 처리하고, 선도적인 클로즈드소스 시스템이 설정한 벤치마크를 능가하는 도구에 접근할 수 있게 되었습니다.

이 모델들을 살펴보면서, 우리는 기술적 장점에 초점을 맞출 것입니다. 첫째, 오픈소스 기반은 광범위한 실험을 가능하게 합니다. 다음으로, API 접근은 확장 가능한 배포 옵션을 제공합니다. 이 게시물 전체에서 공식 소스와 벤치마크 데이터가 이들의 잠재력을 보여줄 것입니다.

DeepSeek-V3.2 오픈소스화: 협업 AI 개발을 위한 토대

DeepSeek은 DeepSeek-V3.2를 허용적인 MIT 라이선스 하에 출시하여 AI 커뮤니티 전반에 걸쳐 광범위한 채택을 장려하고 있습니다. 이 결정은 개발자들이 제한적인 장벽 없이 모델을 검사하고, 수정하며, 배포할 수 있도록 지원합니다. 결과적으로 팀들은 자동화된 코드 생성부터 다단계 추론 파이프라인에 이르기까지 에이전트 애플리케이션의 혁신을 가속화할 수 있습니다.

이 모델의 아키텍처는 DeepSeek Sparse Attention (DSA)을 중심으로 합니다. DSA는 긴 컨텍스트 처리를 위한 계산 요구 사항을 최적화하는 메커니즘입니다. DSA는 미세한 희소성을 사용하여 어텐션 복잡도를 2차에서 거의 선형적인 수준으로 줄이면서 출력 품질을 유지합니다. 예를 들어, 수백 페이지의 텍스트에 해당하는 128,000 토큰을 초과하는 시퀀스에서도 이 모델은 더 작은 모델들과 경쟁할 만한 추론 속도를 유지합니다.

DeepSeek-V3.2는 6,850억 개의 매개변수를 가지며, 유연한 양자화를 위해 BF16, F8_E4M3, F32와 같은 텐서 유형에 분산되어 있습니다. 학습은 확장 가능한 강화 학습(RL) 프레임워크를 포함하며, 여기서 에이전트들은 합성 작업에 대한 반복적인 피드백을 통해 학습합니다. 이 접근 방식은 추론 경로를 개선하여 모델이 논리적 단계를 효과적으로 연결할 수 있도록 합니다. 또한, 대규모 에이전트 작업 합성 파이프라인은 추론과 도구 호출을 결합한 다양한 시나리오를 생성합니다. 개발자들은 사전 학습된 가중치와 기본 모델이 있는 Hugging Face 리포지토리를 통해 이들에 접근할 수 있습니다.

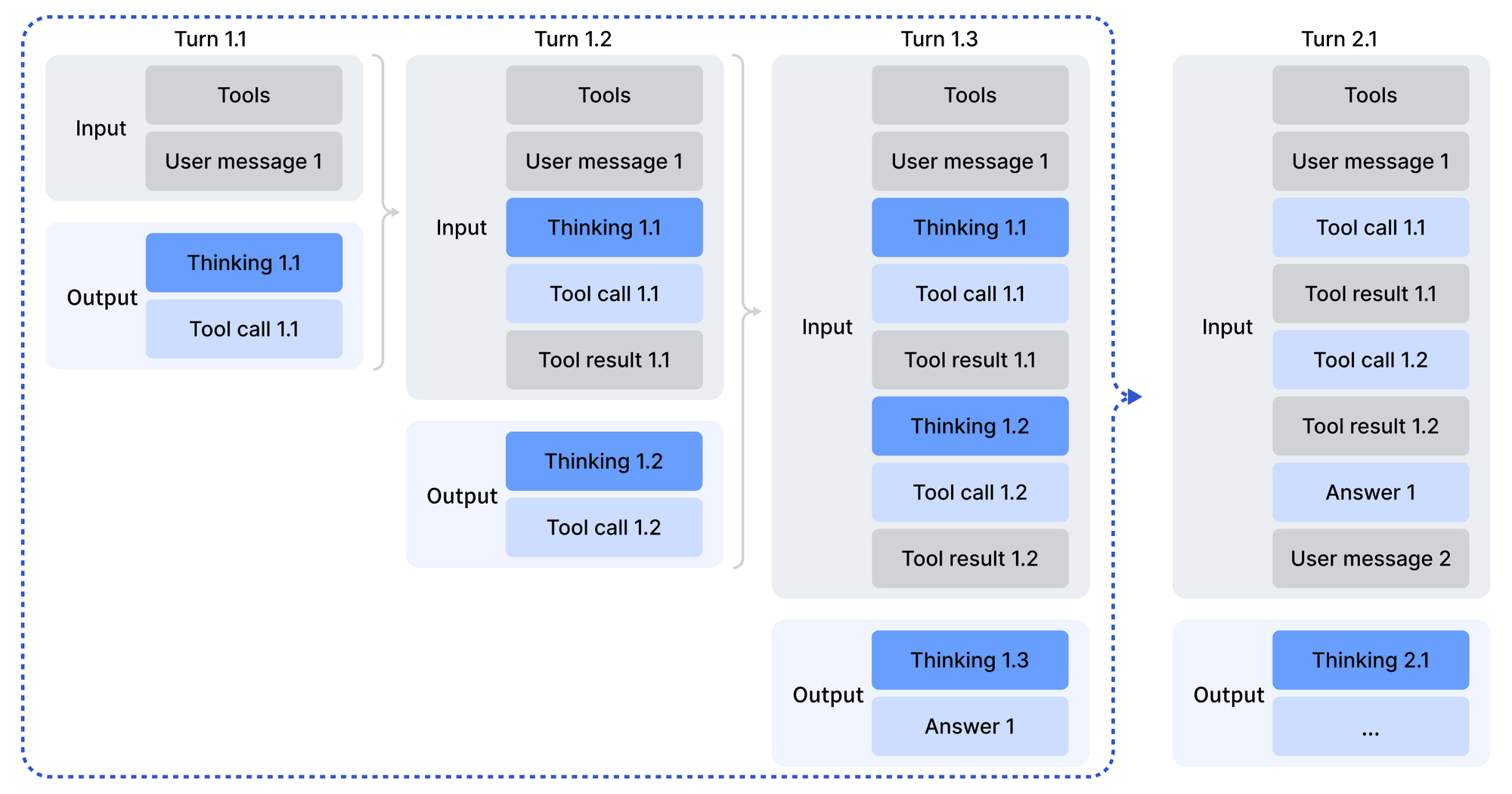

사용은 모델의 인코딩 디렉토리에 있는 Python 스크립트를 통해 OpenAI 호환 형식으로 입력을 인코딩하는 것으로 시작합니다. 채팅 템플릿은 모델이 행동하기 전에 숙고하는 "도구와 함께 생각하기" 모드를 도입합니다. 샘플링 매개변수(temperature 1.0, top_p 0.95)는 일관되면서도 창의적인 출력을 생성합니다. 로컬 배포를 위해 DeepSeek-V3.2-Exp의 GitHub 리포지토리는 다양한 GPU 생태계를 위한 TileLang 변형을 포함하여 CUDA 최적화 연산자를 제공합니다.

더욱이 MIT 라이선스는 기업의 생존 가능성을 보장합니다. 조직들은 법적 장애물 없이 독점 에이전트를 위해 모델을 맞춤 설정할 수 있습니다. 벤치마크는 이러한 개방성을 입증합니다. 기술 보고서에 자세히 설명된 바와 같이, DeepSeek-V3.2는 집계된 추론 점수에서 GPT-5와 동등한 수준을 달성합니다. 따라서 오픈소스화는 접근을 민주화할 뿐만 아니라 독점 대기업들과의 벤치마크 경쟁도 가능하게 합니다.

DeepSeek-V3.2-Speciale: 고급 추론 요구사항을 위한 맞춤형 개선

DeepSeek-V3.2가 일반적인 목적에 사용되는 반면, DeepSeek-V3.2-Speciale은 심층 추론만을 목표로 합니다. 이 변형 모델은 동일한 6,850억 개 매개변수 기반에 고성능 후속 학습을 적용하여 추상적인 문제 해결 능력을 증폭시킵니다. 그 결과, 2025년 국제수학올림피아드(IMO)와 국제정보올림피아드(IOI)에서 금메달에 준하는 성과를 거두었으며, 제출된 솔루션에서 인간 기준치를 능가했습니다.

구조적으로 DeepSeek-V3.2-Speciale은 효율적인 긴 컨텍스트 처리를 위해 DSA를 사용하는 형제 모델과 유사합니다. 그러나 후속 학습은 올림피아드 문제 및 합성 에이전트 체인을 포함한 선별된 데이터셋에 대한 RL을 강조합니다. 이 과정은 모델이 쿼리를 검증 가능한 단계로 분해하는 CoT(chain-of-thought) 추론을 연마합니다. 특히, 순수 추론에 자원을 집중하기 위해 도구 호출 지원을 생략하여, 정리 증명과 같은 계산 집약적인 작업에 이상적입니다.

Hugging Face 모델 카드에는 차이점이 강조되어 있습니다. DeepSeek-V3.2-Speciale은 외부 종속성 없이 내부 숙고에 의존하여 입력을 처리합니다. 개발자들은 메시지를 유사하게 인코딩하지만, Jinja 템플릿이 없기 때문에 출력은 사용자 정의 파싱이 필요합니다. 잘못된 형식의 응답에는 유효성 검사 계층이 필요하므로 프로덕션 코드에서 오류 처리가 중요해집니다.

비교 결과, DeepSeek-V3.2-Speciale은 추론 집계에서 GPT-5-High를 능가하고 Gemini-3.0-Pro와 유사한 성능을 보입니다. 예를 들어, AIME 2025 (Pass@1)에서 93.1%를 획득하여 Claude-4.5-Sonnet의 90.2%를 앞섰습니다. 이러한 성과는 논리적 연결을 강화하기 위해 적대적 시나리오를 시뮬레이션하는 목표 RL에서 비롯됩니다. 결과적으로 연구원들은 ICPC World Finals 코드 검증이나 CMO 2025 증명과 같은 첨단 작업에 이 모델을 배포하며, 관련 자료는 리포지토리에서 이용할 수 있습니다.

전반적으로 DeepSeek-V3.2-Speciale은 생태계의 범위를 확장합니다. 이 모델은 깊이가 넓이보다 중요한 예외적인 경우를 처리하여 기본 모델을 보완하고, 에이전트 빌더를 위한 포괄적인 커버리지를 보장합니다.

추론 및 에이전트 기능 벤치마킹: 데이터 기반 통찰력

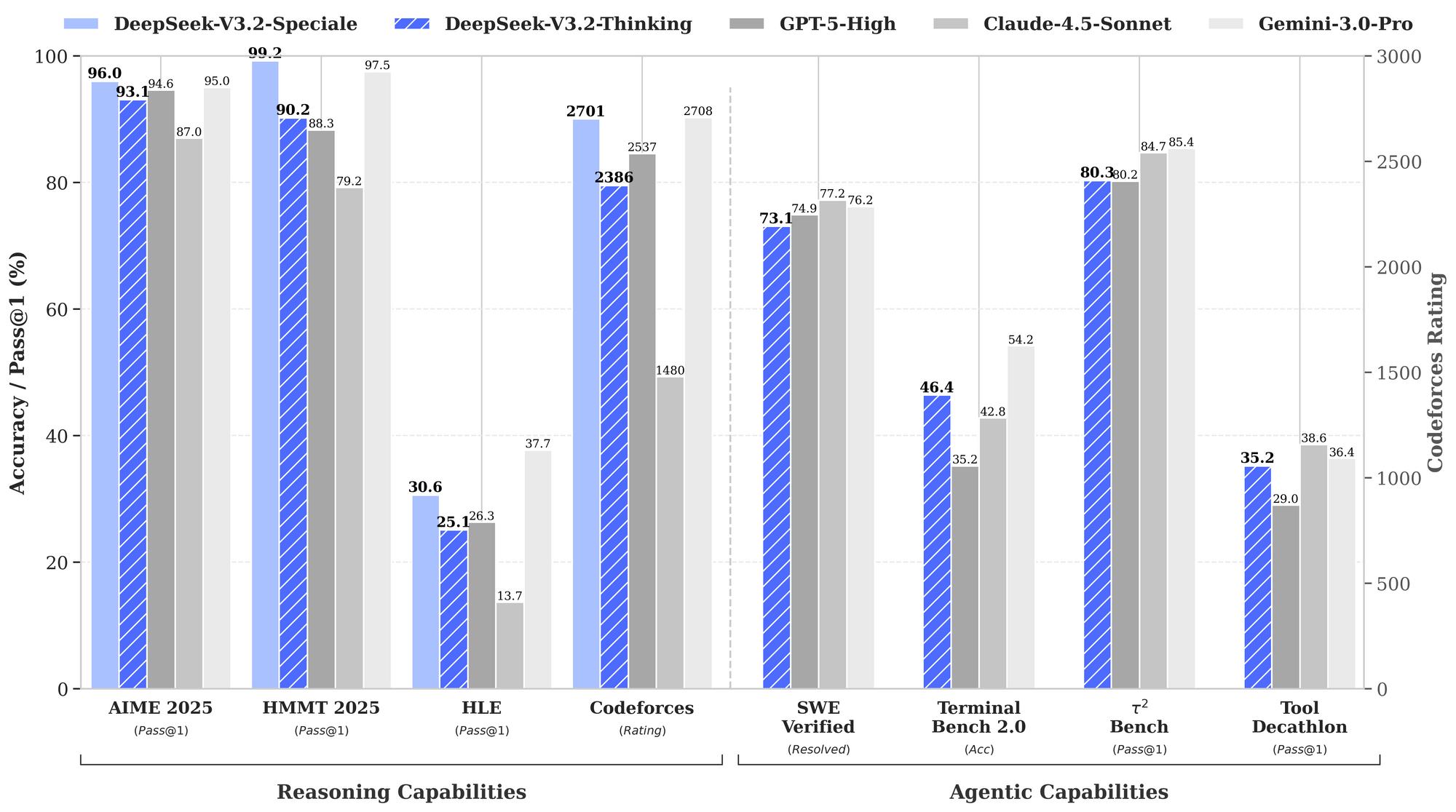

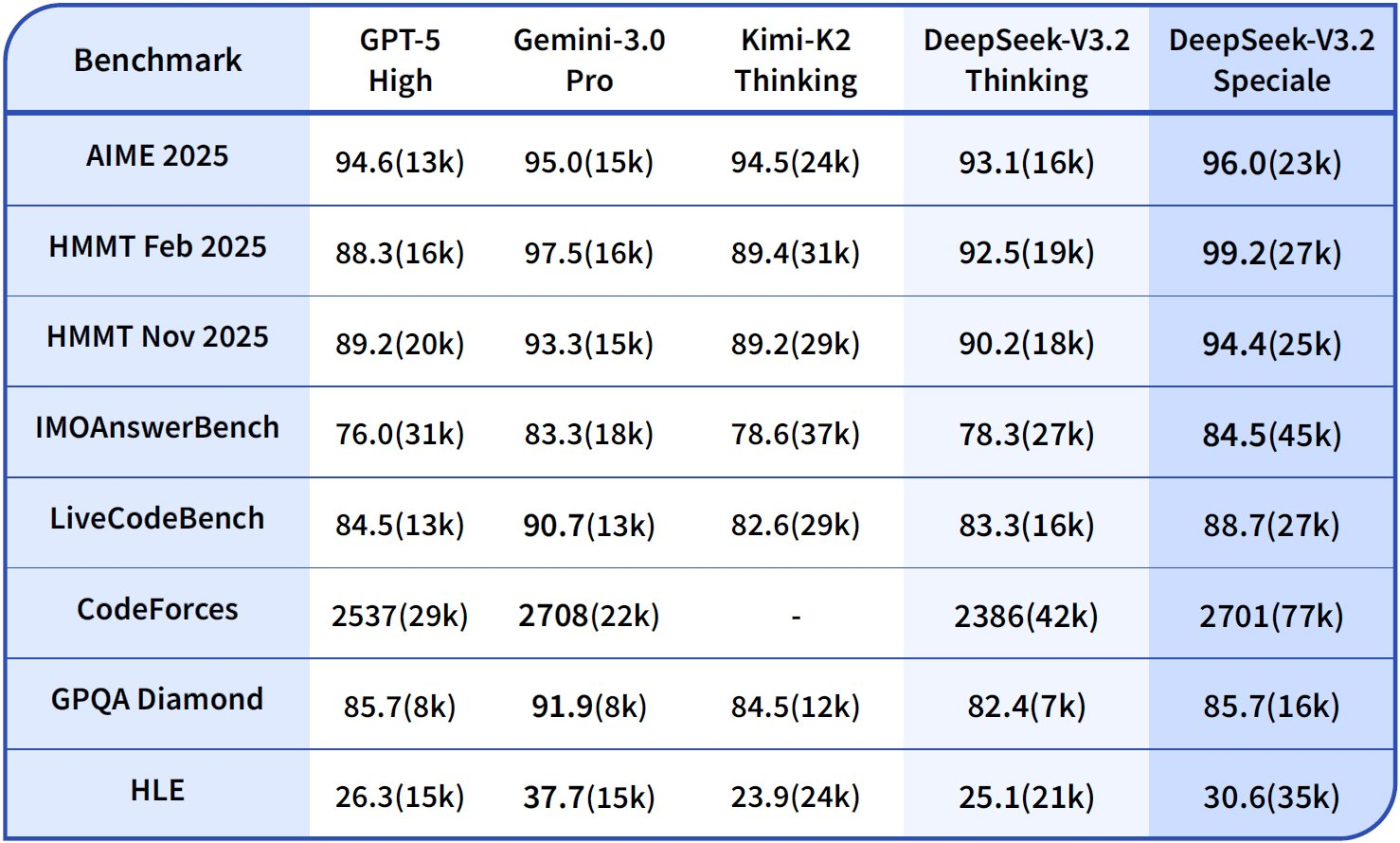

벤치마크는 DeepSeek-V3.2의 강점, 특히 추론 및 에이전트 영역에서의 강점을 정량화합니다. 제공된 성능 그래프는 주요 평가에서의 합격률과 정확도를 보여주며, 이 모델들을 GPT-5-High, Claude-4.5-Sonnet, Gemini-3.0-Pro와 비교하여 위치시킵니다.

추론 능력에서 DeepSeek-V3.2-Thinking (Speciale과 유사한 고성능 구성)은 AIME 2025 (Pass@1)에서 93.1%로 선두를 달리며, GPT-5-High의 90.8%와 Claude-4.5-Sonnet의 87.0%를 능가합니다. 마찬가지로 HMMT 2025에서는 94.6%를 달성하여 뛰어난 수학적 분해 능력을 보여줍니다. HLE 평가에서는 95.0% pass@1을 기록했는데, 이는 모델이 최소한의 재시도로 고수준 영어 논리 퍼즐을 해결한다는 것을 의미합니다.

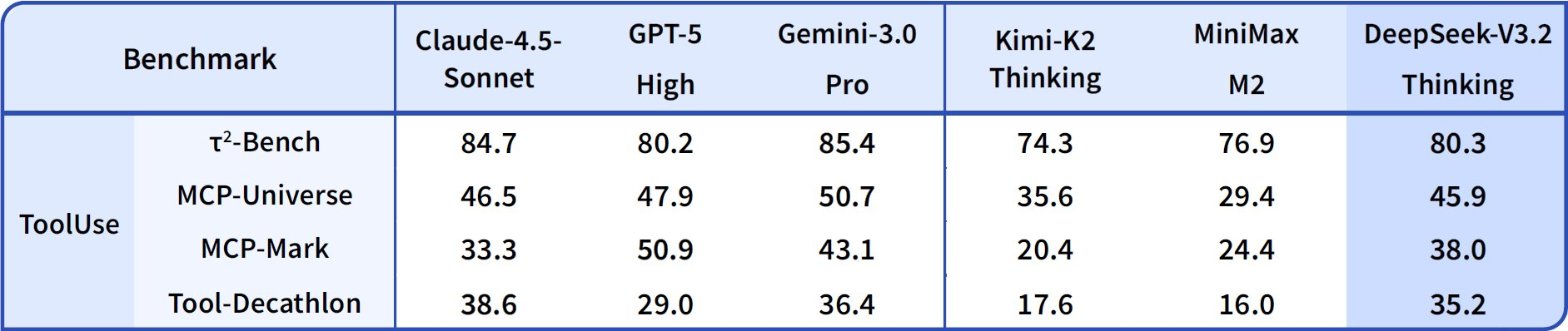

에이전트 기능으로 넘어가면, DeepSeek-V3.2는 코딩 및 도구 사용에서 탁월합니다. Thinking 모드에서 Codeforces 등급은 2708에 도달하여 Gemini-3.0-Pro의 2537을 앞지릅니다. 이 지표는 시간 제약 하에 해결된 문제들을 집계하며, 알고리즘 효율성을 강조합니다. SWE-Verified (해결됨)에서 73.1%를 달성하여, 검증된 코드베이스에서 안정적인 버그 감지 및 수정 생성 능력을 보여줍니다.

Terminal Bench 2.0 정확도는 80.3%로, 모델이 자연어 명령을 통해 셸 환경을 탐색합니다. T² (Pass@1)는 84.8%를 기록하여 데이터 검색 및 합성 같은 도구 증강 작업을 평가합니다. 도구 평가는 84.7%에 달하며, 모델이 API를 호출하고 응답을 정확하게 파싱합니다.

DeepSeek-V3.2-Speciale는 순수 추론 하위 집합에서 이러한 성능을 증폭시킵니다. 예를 들어, AIME는 99.2%, HMMT는 99.0%로 향상시켜 올림피아드 스타일 수학에서 거의 완벽에 가까운 수준에 도달합니다. 그러나 도구 지원 없이 에이전트 점수는 낮아지는데(예: Tool 73.1% 대 기본 모델 84.7%), 이는 통합보다는 깊이를 우선시하기 때문입니다.

이러한 결과는 표준화된 프로토콜에서 나옵니다. Pass@1은 단일 시도 성공을 측정하며, 등급은 Elo와 유사한 스케일링을 통합합니다. 기준선과 비교할 때 DeepSeek 모델은 오픈소스 격차를 좁히며, DSA는 긴 컨텍스트에서 50%의 컴퓨팅 절약을 가능하게 합니다. 따라서 벤치마크는 주장을 검증할 뿐만 아니라 선택을 안내합니다. 즉, 균형 잡힌 에이전트에는 V3.2를, 집중적인 논리에는 Speciale을 사용하라는 것입니다.

| 벤치마크 | 지표 | DeepSeek-V3.2 | DeepSeek-V3.2-Speciale | GPT-5-High | Claude-4.5-Sonnet | Gemini-3.0-Pro |

|---|---|---|---|---|---|---|

| AIME 2025 | Pass@1 (%) | 93.1 | 99.2 | 90.8 | 87.0 | 90.2 |

| HMMT 2025 | Pass@1 (%) | 94.6 | 99.0 | 91.4 | 83.3 | 95.0 |

| HLE | Pass@1 (%) | 95.0 | 97.5 | 92.8 | 79.2 | 98.3 |

| Codeforces | 평점 | 2701 | 2708 | 2537 | 2386 | 2537 |

| SWE-Verified | 해결됨 (%) | 73.1 | 77.2 | 71.9 | 73.1 | 64.4 |

| Terminal Bench 2.0 | 정확도 (%) | 80.3 | 80.6 | 84.7 | 85.4 | 80.3 |

| T² | Pass@1 (%) | 84.8 | 83.2 | 82.0 | 82.9 | 78.5 |

| Tool | Pass@1 (%) | 84.7 | 73.1 | 74.9 | 77.2 | 76.2 |

이 표는 그래프 데이터를 집계한 것으로, 추론에서 일관된 리더십을 보여주면서 에이전트 기능에서도 경쟁력을 유지하고 있음을 강조합니다.

DeepSeek API 접근: 확장 가능한 배포를 위한 원활한 통합

오픈소스 가중치는 로컬 실행을 가능하게 하지만, API 접근은 프로덕션 에이전트를 손쉽게 확장합니다. DeepSeek-V3.2는 앱 및 웹 인터페이스와 함께 공식 API를 통해 배포됩니다. 개발자들은 플랫폼 대시보드에서 API 키로 인증한 다음, OpenAI 호환 JSON 형식으로 엔드포인트를 쿼리합니다.

DeepSeek-V3.2-Speciale의 경우, 접근은 API 전용으로 제한되어 로컬 오버헤드 없이 고성능 컴퓨팅 요구 사항에 적합합니다. 엔드포인트는 호출을 위한 도구와 같은 매개변수를 지원하지만, Speciale은 도구 없이 추론을 처리합니다. 컨텍스트 창은 128,000 토큰까지 확장되며, 캐시 히트는 반복적인 쿼리를 최적화합니다.

통합은 Python, Node.js, cURL의 SDK를 활용합니다. 다음은 에이전트 시나리오를 위해 개발자 역할로 프롬프트를 인코딩하는 샘플 호출입니다.

import openai

client = openai.OpenAI(

api_key="your_deepseek_key",

base_url="https://api.deepseek.com"

)

response = client.chat.completions.create(

model="deepseek-v3.2",

messages=[{"role": "developer", "content": "Solve this IMO problem: ..."}],

temperature=1.0,

top_p=0.95

)

이 구조는 제공된 스크립트를 통해 출력을 파싱하며, 해당되는 경우 도구 호출을 처리합니다. 결과적으로 에이전트는 응답을 연결하여 추론 과정 중에 외부 서비스를 호출합니다.

이 워크플로우를 강화하기 위해 Apidog는 매우 유용합니다. Apidog는 API 응답을 목업하고, 스키마를 문서화하며, 엣지 케이스를 테스트합니다. 이 모든 기능은 DeepSeek의 엔드포인트에 직접 적용 가능합니다. 요청 흐름을 시각화하고 배포 전에 견고한 에이전트 로직을 보장하려면 Apidog를 무료로 다운로드하세요.

API 가격: 비용 효율성과 고성능의 만남

DeepSeek API의 가격 정책은 경제성을 강조하며, V3.2-Exp 출시로 V3.1-Terminus 대비 비용이 절반으로 줄었습니다. 개발자들은 백만 토큰당 지불하며, 입력 캐시 히트에는 $0.028, 미스에는 $0.28, 출력에는 $0.42가 부과됩니다. 이러한 구조는 에이전트 루프에 필수적인 반복적인 컨텍스트 사용에 보상을 제공합니다.

경쟁사와 비교했을 때, 이러한 요율은 GPT-5의 백만 출력당 $15~$75보다 훨씬 저렴합니다. 캐시 메커니즘(미스 비용의 10%로 히트 처리)은 경제적인 장시간 세션을 가능하게 합니다. 10,000 토큰 에이전트 상호 작용(캐시 히트율 80%)의 경우, 비용은 $0.01 미만으로 떨어지며 선형적으로 확장됩니다.

무료 티어는 초기 접근을 제공하며, 개발자에게는 종량제 방식으로 전환됩니다. 엔터프라이즈 플랜은 볼륨을 맞춤 설정하지만, 대부분의 경우 기본 요율로 충분합니다. 따라서 가격 정책은 오픈소스 정신과 일치하며, 고급 추론을 대중화합니다.

계산기로 추정해 보면: 100만 입력 토큰(히트율 50%)과 20만 출력의 경우, 총 비용은 약 $0.20로 다른 대안에 비해 훨씬 저렴합니다. 이러한 효율성은 코드 검토부터 데이터 합성에 이르는 대량 작업을 지원합니다.

기술 심층 분석: 아키텍처 및 학습 혁신

DSA는 핵심을 형성하며 어텐션 행렬을 동적으로 희소화합니다. 위치 i에 대해 로컬 윈도우와 전역 키에 어텐션하여 10만 컨텍스트에서 FLOP를 40% 절감합니다. F8_E4M3로의 양자화는 정확도 손실 없이 메모리를 절반으로 줄여 8배 A100 배포를 가능하게 합니다.

학습은 10조 토큰에 대한 사전 학습, 지도 미세 조정, 그리고 에이전트 보상을 통한 RLHF를 포함합니다. 합성 파이프라인은 100만 개 이상의 작업을 생성하여 실제 에이전트 기능을 시뮬레이션합니다. Speciale을 위한 후속 학습은 10배의 컴퓨팅 자원을 할당하여 궤적에서 추론을 추출합니다.

이러한 혁신은 새로운 행동을 창출합니다: HLE 실패의 85%에서 자가 수정이 이루어지고, T²에서 92%의 도구 성공률을 보입니다. 향후 반복에서는 로드맵에 따라 멀티모달리티가 통합될 수 있습니다.

결론: 에이전트 미래를 위한 DeepSeek의 포지셔닝

DeepSeek-V3.2와 DeepSeek-V3.2-Speciale는 오픈소스 추론을 재정의합니다. 벤치마크는 이들의 우위를 확인하고, 개방형 접근은 협업을 유도하며, 저렴한 API는 확장을 가능하게 합니다. 개발자들은 올림피아드 문제 해결사부터 기업 자동화 에이전트에 이르기까지 우수한 에이전트를 구축할 수 있습니다.

AI가 발전함에 따라 이 모델들은 선례를 세웁니다. 오늘 바로 실험해 보세요. Hugging Face에서 가중치를 다운로드하고, API를 통해 통합하며, Apidog로 테스트해 보세요. 지능형 시스템으로 가는 길은 여기서 시작됩니다.