Los desarrolladores buscan herramientas eficientes que manejen tanto texto como imágenes sin quebrar el banco. NVIDIA Nemotron Nano 12B v2 VL se destaca como un modelo de visión-lenguaje compacto pero potente, y acceder a él a través del nivel gratuito de la API de NVIDIA mediante plataformas como OpenRouter facilita la experimentación.

Esta publicación te guía a través del proceso de aprovechar la API gratuita de NVIDIA Nemotron Nano 12B v2 VL. Aprenderás sobre la arquitectura del modelo, los requisitos de configuración, los pasos prácticos de implementación y los patrones de uso avanzados. Al final, poseerás el conocimiento para implementar este modelo en tus aplicaciones, desde la subtitulación de imágenes hasta la respuesta a preguntas visuales.

Entendiendo NVIDIA Nemotron Nano 12B v2 VL: Arquitectura y Capacidades Clave

Los ingenieros de NVIDIA diseñaron el modelo Nemotron Nano 12B v2 VL para abordar la creciente demanda de procesamiento eficiente de visión-lenguaje. Este modelo de 12 mil millones de parámetros combina la comprensión del lenguaje basada en transformadores con codificadores visuales, lo que le permite procesar secuencias intercaladas de texto e imágenes. A diferencia de los modelos más grandes que requieren recursos sustanciales de GPU, Nemotron Nano 12B v2 VL se optimiza para la implementación en el borde y la inferencia de baja latencia, lo que lo hace ideal para aplicaciones en tiempo real.

En su esencia, el modelo emplea un transformador de visión (ViT) para extraer características de las imágenes de entrada, seguido de un proyector multimodal que alinea estas características con el espacio de incrustación de texto. El componente de lenguaje se basa en la arquitectura Nemotron de NVIDIA, que incorpora incrustaciones posicionales rotativas para un manejo extendido del contexto. Esta configuración admite una longitud de contexto de hasta 4,096 tokens, suficiente para la mayoría de las tareas prácticas que implican descripciones cortas o consultas emparejadas con elementos visuales.

Las capacidades clave incluyen:

- Alineación Imagen-Texto: El modelo genera subtítulos descriptivos para imágenes o responde preguntas basadas en contenido visual.

- Razonamiento Multimodal: Realiza tareas como la respuesta a preguntas visuales (VQA), donde los usuarios consultan detalles específicos de una imagen, como "¿De qué color es el coche en primer plano?"

- Comprensión de Documentos: Procesa documentos escaneados o gráficos combinando la extracción de texto tipo OCR con la interpretación semántica.

Los puntos de referencia revelan un rendimiento sólido: En el conjunto de datos VQAv2, Nemotron Nano 12B v2 VL logra aproximadamente un 75% de precisión, rivalizando con modelos más grandes mientras consume mucho menos cómputo. Para los desarrolladores, esto se traduce en ciclos de prototipado más rápidos, especialmente al utilizar el acceso gratuito a la API de NVIDIA.

Además, las opciones de cuantificación del modelo —como pesos de 4 o 8 bits— reducen la huella de memoria sin una pérdida significativa de precisión. NVIDIA las proporciona a través de su catálogo NGC, pero para el uso basado en API, plataformas como OpenRouter se encargan del trabajo pesado, exponiendo el modelo a través de endpoints HTTP estandarizados.

Acceso al Nivel Gratuito de la API de NVIDIA: Integración con OpenRouter

Para usar la API gratuita de NVIDIA Nemotron Nano 12B v2 VL, enrutas las solicitudes a través de OpenRouter, una pasarela unificada para modelos de IA. OpenRouter ofrece un generoso nivel gratuito para esta variante de modelo específica, permitiendo hasta 10 solicitudes por minuto y 1,000 tokens por minuto sin cargos. Esta limitación es adecuada para pruebas y desarrollo a pequeña escala, y puedes actualizar a planes de pago para un mayor rendimiento si es necesario.

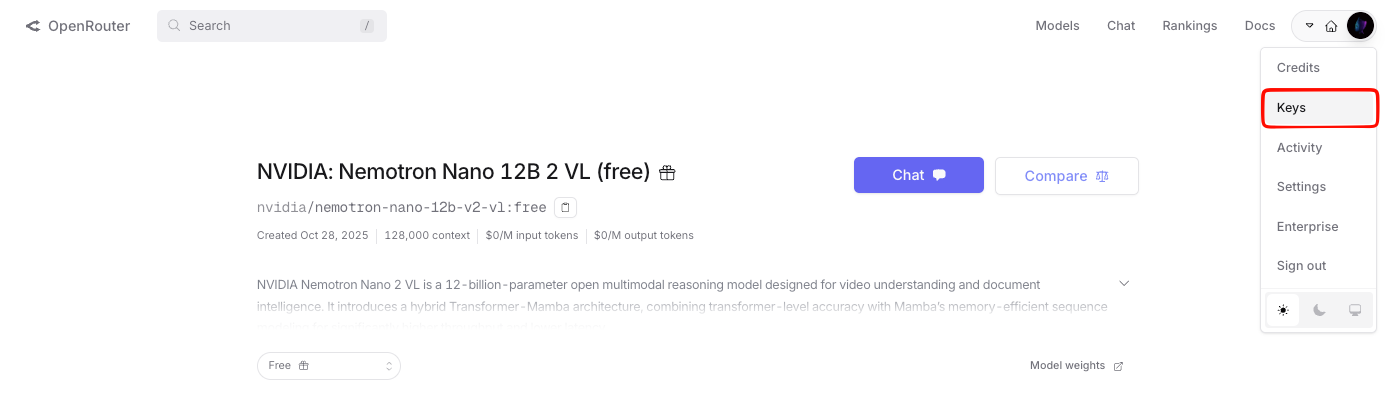

Primero, crea una cuenta en OpenRouter. Navega a su panel de control y regístrate usando tu correo electrónico o credenciales de GitHub. Una vez iniciada la sesión, genera una clave API desde la sección "Keys". Esta clave autentica todas las llamadas posteriores, siguiendo un esquema simple de token Bearer.

OpenRouter estandariza la interfaz de la API para imitar el formato de OpenAI, lo que simplifica la migración para los desarrolladores familiarizados con los endpoints de GPT. La URL base para las solicitudes es https://openrouter.ai/api/v1, y especificas el modelo como nvidia/nemotron-nano-12b-v2-vl:free. Esta etiqueta asegura que accedes al endpoint del nivel gratuito, evitando cualquier cargo inadvertido.

Para las entradas de visión, codificas las imágenes como cadenas base64 dentro de la carga útil JSON. La API soporta formatos JPEG y PNG, con una resolución máxima de 1024x1024 píxeles por imagen; resoluciones más altas activan un redimensionamiento automático para evitar desbordamientos. Las entradas de texto siguen siendo cadenas UTF-8 estándar, y el modelo genera respuestas con formato JSON que contienen texto generado.

Pasando de la configuración a la implementación, ahora preparas tu entorno de desarrollo. Instala Python 3.8 o posterior, junto con la biblioteca requests para el manejo de HTTP. Para pruebas más avanzadas, Apidog se integra perfectamente, permitiéndote visualizar los ciclos de solicitud/respuesta y exportar colecciones para la colaboración en equipo.

Configuración Paso a Paso: Prerrequisitos y Configuración del Entorno

Comienzas verificando la preparación de tu sistema. Asegúrate de que Python reside en tu máquina; verifica mediante python --version en la terminal. Si no está presente, descárgalo del sitio web oficial de Python.

A continuación, crea un entorno virtual para aislar las dependencias:

python -m venv nemotron_env

source nemotron_env/bin/activate # On Windows: nemotron_env\Scripts\activate

Instala el paquete necesario:

pip install requests

Almacena tu clave API de OpenRouter de forma segura. Utiliza variables de entorno para este propósito: crea un archivo .env en tu directorio de proyecto con OPENROUTER_API_KEY=tu_clave_aquí. Cárgala usando la biblioteca python-dotenv:

pip install python-dotenv

En tu código, impórtalo y úsalo de la siguiente manera:

import os

from dotenv import load_dotenv

load_dotenv()

api_key = os.getenv('OPENROUTER_API_KEY')

Esta configuración evita codificar datos sensibles directamente, una buena práctica para entornos de producción. Con estas bases establecidas, procedes a crear tu primera llamada a la API.

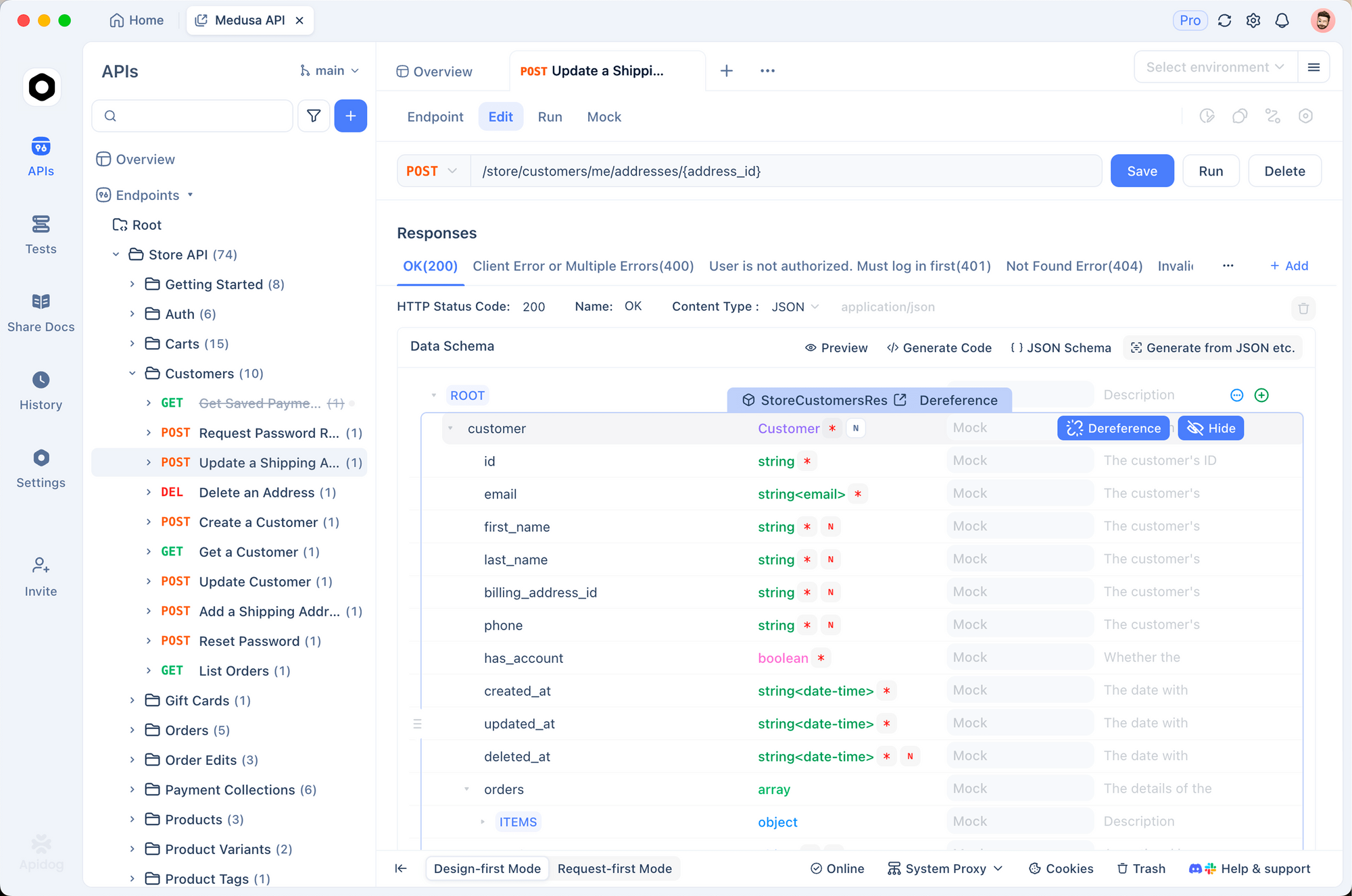

Además, si prefieres las pruebas basadas en GUI, Apidog brilla aquí. Importa el esquema de OpenRouter directamente en Apidog, configura tu clave gratuita de la API de NVIDIA y ejecuta simulaciones sin escribir código. Este enfoque acelera la depuración, particularmente para cargas útiles multimodales donde la estructura JSON es importante.

Implementando Llamadas Básicas a la API: Ejemplos Solo de Texto y Solo de Imagen

Comienzas con solicitudes simples para generar confianza. El endpoint principal es /chat/completions, un método POST que acepta un cuerpo JSON con model, messages y parámetros opcionales como temperature (0-2 para control de creatividad) y max_tokens (hasta 2048).

Considera una consulta solo de texto para familiarizarte con el modelo:

import requests

import json

import base64

url = "https://openrouter.ai/api/v1/chat/completions"

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

payload = {

"model": "nvidia/nemotron-nano-12b-v2-vl:free",

"messages": [

{"role": "user", "content": "Explain the basics of vision-language models in 100 words."}

],

"max_tokens": 150,

"temperature": 0.7

}

response = requests.post(url, headers=headers, json=payload)

result = response.json()

print(result['choices'][0]['message']['content'])

Este script envía un prompt y recupera una explicación concisa. La respuesta se transmite en menos de 2 segundos en promedio, gracias al enrutamiento optimizado de OpenRouter.

Ahora, extiéndete al procesamiento solo de imágenes. Codifica un archivo de imagen a base64:

with open("sample_image.jpg", "rb") as image_file:

base64_image = base64.b64encode(image_file.read()).decode('utf-8')

content = [

{

"type": "text",

"text": "Describe this image in detail."

},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

}

]

payload["messages"] = [{"role": "user", "content": content}]

# Repeat the POST request as above

El modelo analiza la imagen, generando descripciones como "Un coche deportivo rojo aparcado en una calle de la ciudad al atardecer, con peatones borrosos al fondo." Dichas salidas demuestran la fusión VL de manera efectiva.

Sin embargo, para escenarios complejos, combinas modalidades, como se explorará a continuación.

Uso Avanzado: Consultas Multimodales con NVIDIA Nemotron Nano 12B v2 VL

La combinación de texto e imágenes desbloquea todo el potencial del modelo. Construyes mensajes con matrices de contenido intercaladas, donde cada elemento especifica el tipo ("text" o "image_url") y el valor.

Ejemplo para respuesta a preguntas visuales:

content = [

{"type": "image_url", "image_url": {"url": f"data:image/png;base64,{base64_chart_image}"}},

{"type": "text", "text": "What is the trend in sales from Q1 to Q4 in this chart?"}

]

payload["messages"] = [{"role": "user", "content": content}]

response = requests.post(url, headers=headers, json=payload)

La API devuelve respuestas razonadas, como "Las ventas aumentan constantemente de $100K en el Q1 a $400K en el Q4, lo que indica un crecimiento del 300%." Esta capacidad resulta invaluable para herramientas de visualización de datos o sistemas de informes automatizados.

Para mejorar la fiabilidad, incorporas prompts de sistema para la simulación de roles:

payload["messages"] = [

{"role": "system", "content": "You are a precise image analyst."},

{"role": "user", "content": content}

]

Los mensajes del sistema guían el comportamiento del modelo, reduciendo las alucinaciones en las salidas. Además, establece top_p en 0.9 para el muestreo por núcleo, lo que equilibra la diversidad y la coherencia.

Para el procesamiento por lotes, OpenRouter admite llamadas asíncronas a través de WebSockets, pero mantente en las solicitudes POST síncronas para la simplicidad del nivel gratuito. Monitorea el uso a través del panel para mantenerte dentro de los límites; excederlos provoca errores 429, que debes manejar con retroceso exponencial:

import time

try:

response = requests.post(url, headers=headers, json=payload)

if response.status_code == 429:

time.sleep(60) # Wait 1 minute

response = requests.post(url, headers=headers, json=payload)

except Exception as e:

print(f"Error: {e}")

Esta resiliencia asegura flujos de trabajo ininterrumpidos. A medida que escalas, las funciones de simulación de Apidog simulan respuestas, ayudando al desarrollo sin conexión.

Aprovechando Apidog para Pruebas y Documentación Gratuitas de la API de NVIDIA

Apidog eleva tus interacciones con la API más allá de los scripts puros. Esta herramienta de código abierto admite la importación de especificaciones OpenAPI, y OpenRouter proporciona una para los endpoints de Nemotron.

Descarga Apidog gratis, como se mencionó anteriormente, y sigue estos pasos:

- Inicia Apidog y crea un nuevo proyecto.

- Importa la colección de OpenRouter desde su repositorio de GitHub o pega el JSON del esquema.

- Agrega tu clave gratuita de la API de NVIDIA en las variables de entorno.

- Diseña solicitudes: Las cargas de imágenes de arrastrar y soltar se convierten a base64 automáticamente.

- Ejecuta pruebas y visualiza trazas—Apidog resalta picos de latencia o errores de carga útil.

Documentas endpoints sin esfuerzo, generando informes Markdown con ejemplos. Por ejemplo, exporta un comando curl para tu consulta VQA:

curl -X POST https://openrouter.ai/api/v1/chat/completions \

-H "Authorization: Bearer $OPENROUTER_API_KEY" \

-H "Content-Type: application/json" \

-d '{"model":"nvidia/nemotron-nano-12b-v2-vl:free","messages":[{"role":"user","content":[{"type":"image_url","image_url":{"url":"data:image/jpeg;base64,..."},"type":"text","text":"Analyze this."}]}]}'

Tales exportaciones facilitan el intercambio con equipos. Además, el modo de colaboración de Apidog rastrea los cambios, controlando la versión de tus experimentos con NVIDIA Nemotron Nano 12B v2 VL.

En la práctica, los desarrolladores reportan ciclos de iteración un 40% más rápidos con Apidog, ya que abstrae el código repetitivo. Realiza la transición a producción exportando a Postman o integrando directamente a través de SDKs.

Manejo de Errores, Mejores Prácticas y Estrategias de Optimización

Los errores surgen al usar la API, por lo que debes anticiparlos de forma proactiva. Los problemas comunes incluyen 401 (clave inválida): verifica tu token Bearer. Para 400 (JSON mal formado), valida las cargas útiles con herramientas como JSONLint. Los errores específicos de imágenes, como cadenas base64 demasiado grandes, se resuelven comprimiendo los archivos de antemano usando Pillow:

from PIL import Image

img = Image.open("large_image.jpg")

img = img.resize((512, 512))

img.save("resized.jpg", quality=85)

Las mejores prácticas incluyen la limitación de velocidad por tu parte con time.sleep(6) entre llamadas para respetar el límite de 10 RPM. Almacena en caché las respuestas frecuentes usando Redis para minimizar los accesos a la API.

La optimización se centra en la ingeniería de prompts. Usa consultas concisas: "Identifica objetos y sus relaciones en esta foto" produce mejores resultados que las vagas. Experimenta con los valores de temperature —más bajos para tareas fácticas, más altos para generación creativa.

Para una escalabilidad sin costo dentro de los límites, agrupa las consultas lógicas en mensajes únicos, maximizando la eficiencia de los tokens. Monitorea el uso de tokens a través de los metadatos de respuesta: result['usage']['total_tokens'].

Además, integra el registro con el módulo logging para rastrear el rendimiento:

import logging

logging.basicConfig(level=logging.INFO)

logging.info(f"Response tokens: {result['usage']['total_tokens']}")

Estos hábitos construyen aplicaciones robustas. A medida que refines, considera configuraciones híbridas que combinen Nemotron con preprocesamiento local para una latencia ultra baja.

Conclusión

Ahora posees las herramientas para aprovechar la API gratuita de NVIDIA Nemotron Nano 12B v2 VL. Desde la configuración inicial hasta las implementaciones avanzadas, esta guía te equipa para el éxito. Experimenta con audacia: comienza con llamadas simples e itera hacia aplicaciones sofisticadas. Recuerda que pequeños ajustes constantes, como prompts refinados o pruebas asistidas por Apidog, producen ganancias sustanciales.

Para lecturas adicionales, explora los foros de desarrolladores de NVIDIA o el changelog de OpenRouter. Descarga Apidog hoy mismo si aún no lo has hecho, y transforma tus flujos de trabajo de API. ¿Qué proyecto abordarás primero?