¿Le cuesta evaluar y optimizar sus pipelines de modelos de lenguaje grandes (LLM)? Presentamos LangWatch, una plataforma revolucionaria que facilita la monitorización, evaluación y ajuste fino de sus flujos de trabajo LLM personalizados. En esta guía, profundizaremos en qué es LangWatch, por qué es increíble y cómo instalarlo y usarlo para potenciar sus proyectos de IA. Le guiaremos a través de la configuración de un chatbot simple, la integración de LangWatch y la prueba con una pregunta de ejemplo, todo mientras mantenemos las cosas fáciles de seguir. ¡Empecemos!

¿Quiere una plataforma integrada y todo en uno para que su equipo de desarrolladores trabaje con máxima productividad?

¡Apidog satisface todas sus demandas y reemplaza a Postman a un precio mucho más asequible!

¿Qué es LangWatch y por qué debería importarle?

LangWatch es su plataforma de referencia para abordar el complicado problema de la evaluación de LLM. A diferencia de los modelos tradicionales con métricas estándar como la puntuación F1 para clasificación, BLEU para traducción o ROUGE para resumen, los LLM generativos no son deterministas y son difíciles de precisar. Además, cada empresa tiene sus propios datos, modelos ajustados y pipelines personalizados, lo que hace que la evaluación sea un dolor de cabeza. ¡Ahí es donde LangWatch brilla!

LangWatch le permite:

- Experimente y optimice: Pruebe y mejore sus pipelines LLM con facilidad.

- Monitorice el rendimiento: Rastree cómo se comporta su IA en tiempo real.

- Evalúe resultados: Use conjuntos de datos y evaluadores para medir la precisión y la calidad.

- Soporte para pipelines personalizados: Funciona con sus datos y modelos únicos.

Ya sea que esté construyendo un chatbot, una herramienta de traducción o una aplicación de IA personalizada, LangWatch le ayuda a garantizar que su LLM ofrezca resultados de primera. ¿Listo para verlo en acción? ¡Instalemos y usemos LangWatch!

Guía paso a paso para instalar y usar LangWatch

Requisitos previos

Antes de empezar, necesitará:

- Python 3.8+: Para ejecutar el proyecto (python.org).

- Cuenta de LangWatch: Regístrese en app.langwatch.ai.

- Clave API de OpenAI: Para la demostración del chatbot (obtenga una en platform.openai.com).

- Editor de código: VS Code, PyCharm o su IDE favorito.

- Git y Docker: Opcional, para la configuración local de LangWatch.

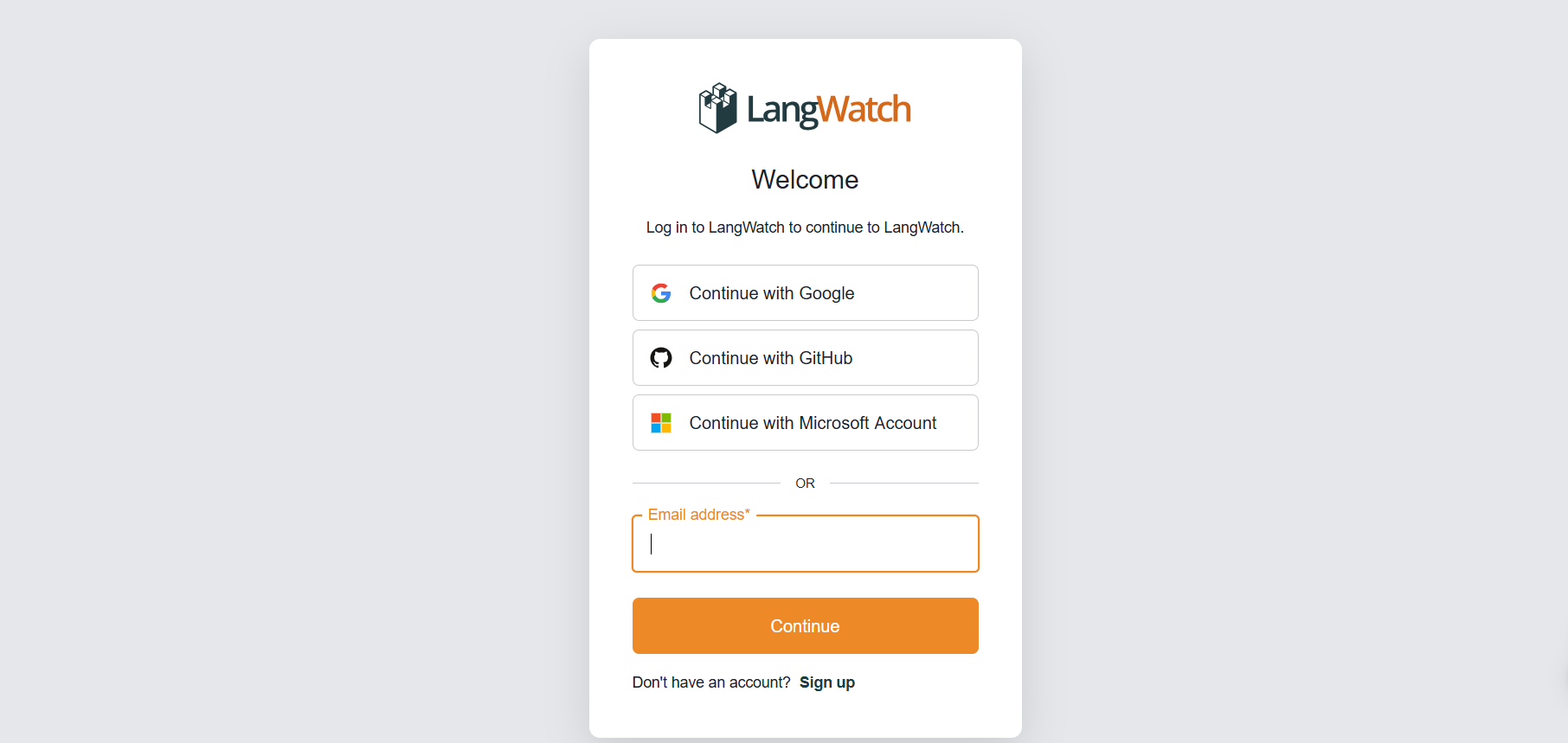

Paso 1: Regístrese en LangWatch

Crear una cuenta:

- Vaya a app.langwatch.ai y regístrese para obtener una cuenta gratuita.

- Se creará un proyecto predeterminado llamado “AI Bites”. Lo usaremos para este tutorial, pero puede crear uno nuevo si lo prefiere.

Obtenga su clave API:

- En su panel de control de LangWatch, vaya a Configuración del proyecto para encontrar su

LANGWATCH_API_KEY. La necesitará más tarde.

Paso 2: Configure un proyecto de Python con LangWatch

Creemos un proyecto de Python e integremos LangWatch para rastrear un chatbot simple.

- Cree una carpeta de proyecto:

- Cree un nuevo directorio (por ejemplo,

langwatch-demo) y navegue hasta él:

mkdir langwatch-demo

cd langwatch-demo

2. Configure un entorno virtual:

- Cree y active un entorno virtual para mantener las dependencias aisladas:

python -m venv venv

source venv/bin/activate # On Windows: venv\Scripts\activate

3. Instale LangWatch y las dependencias:

- Instale LangWatch y Chainlit (para la interfaz de usuario del chatbot):

pip install langwatch chainlit openai

4. Cree el código del Chatbot:

- Cree un archivo llamado

app.pyy pegue este código para construir un chatbot simple usando el modelo GPT-4o-mini de OpenAI:

import os

import chainlit as cl

import asyncio

from openai import AsyncClient

openai_client = AsyncClient() # Assumes OPENAI_API_KEY is set in environment

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

5. Configure su clave API de OpenAI:

- Agregue su clave API de OpenAI como una variable de entorno:

export OPENAI_API_KEY="your-openai-api-key" # On Windows: set OPENAI_API_KEY=your-openai-api-key

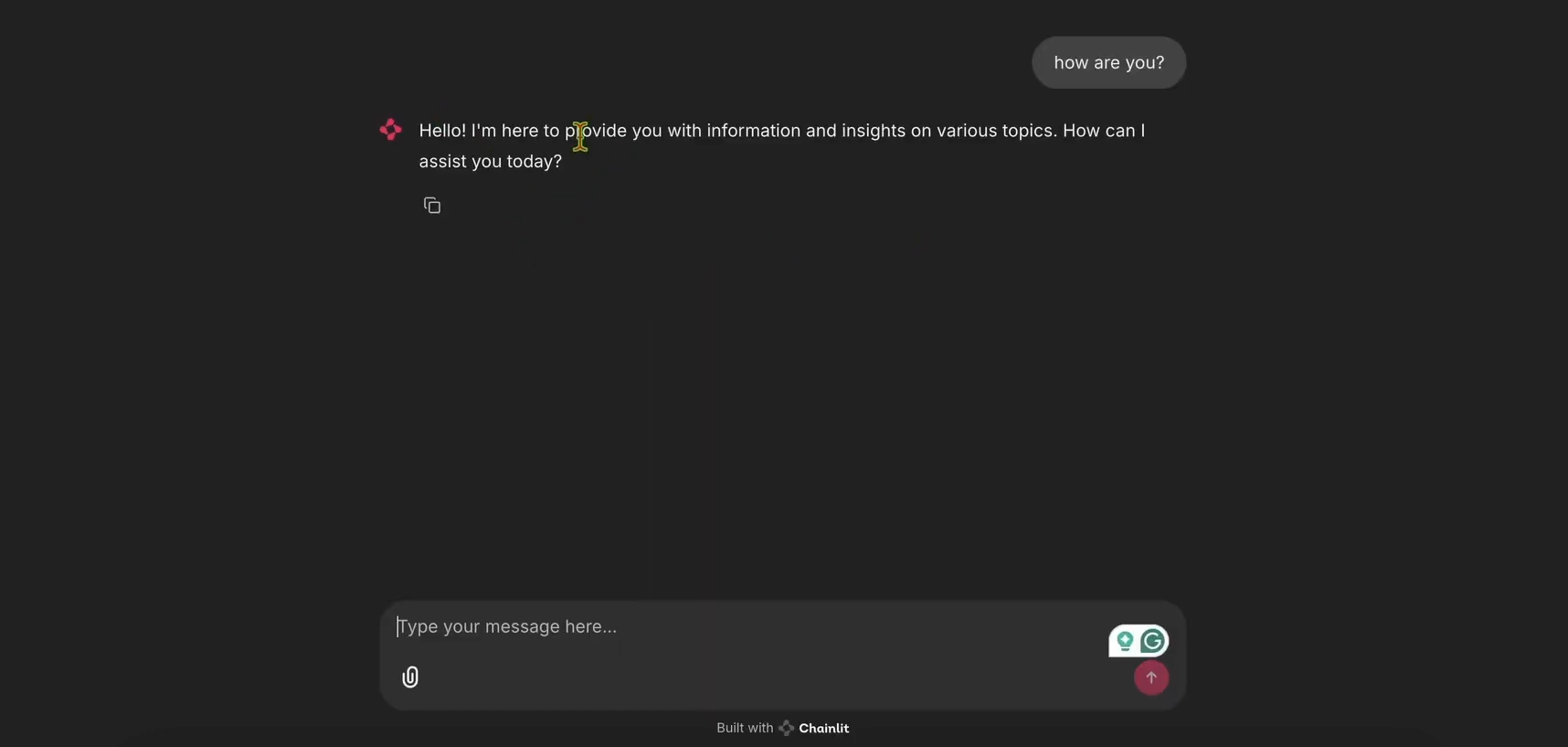

6. Ejecute el Chatbot:

- Inicie la aplicación Chainlit:

chainlit run app.py

- Abra http://localhost:8000 para ver la interfaz de usuario del chatbot. ¡Pruébelo para asegurarse de que funciona!

Paso 3: Integre LangWatch para el seguimiento

Ahora, agreguemos LangWatch para rastrear los mensajes del chatbot.

- Modifique

app.pypara LangWatch:

- Actualice

app.pypara incluir LangWatch y agregue el decorador@langwatch.trace()a la funciónmain:

import os

import chainlit as cl

import asyncio

import langwatch

from openai import AsyncClient

openai_client = AsyncClient()

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

@langwatch.trace()

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

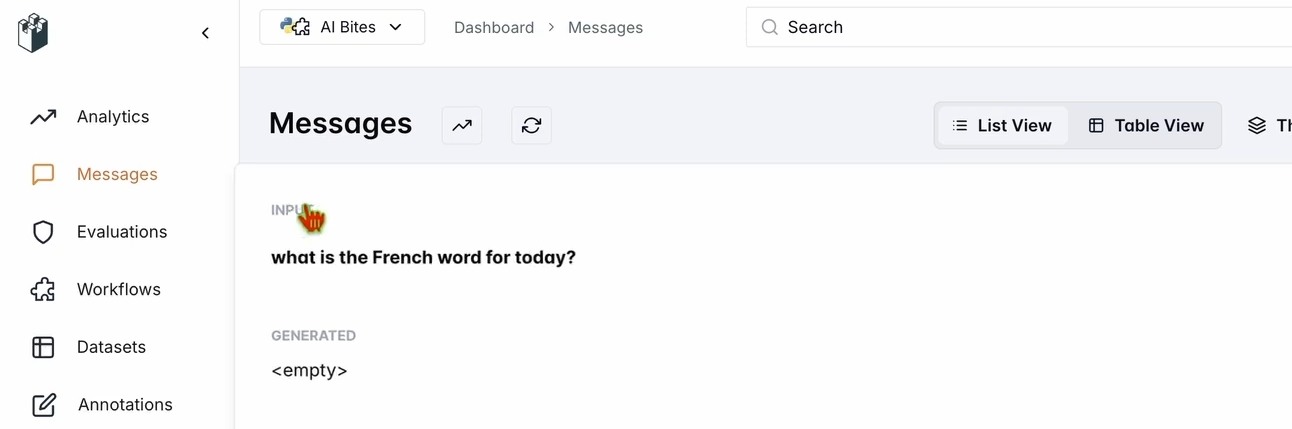

2. Pruebe la integración:

- Reinicie la aplicación Chainlit:

chainlit run app.py

- En la interfaz de usuario del chatbot, pregunte: “¿Cuál es la palabra francesa para hoy?”

- Revise su panel de control de LangWatch:

- Vaya a app.langwatch.ai.

- Seleccione Mensajes en la barra lateral izquierda.

- Verifique que su pregunta y la respuesta del chatbot (por ejemplo, “Aujourd’hui! 🇫🇷😊”) estén siendo rastreadas.

Paso 4: Configure un flujo de trabajo para evaluar su Chatbot

Creemos un conjunto de datos y un evaluador en LangWatch para evaluar el rendimiento del chatbot.

- Cree un conjunto de datos:

- En el panel de control de LangWatch, vaya a Conjuntos de datos y haga clic en Nuevo conjunto de datos.

- Agregue un conjunto de datos simple con al menos una pregunta y respuesta. Por ejemplo:

| Pregunta | Respuesta esperada |

|---|---|

| ¿Cuál es la palabra francesa para hoy? | Aujourd’hui |

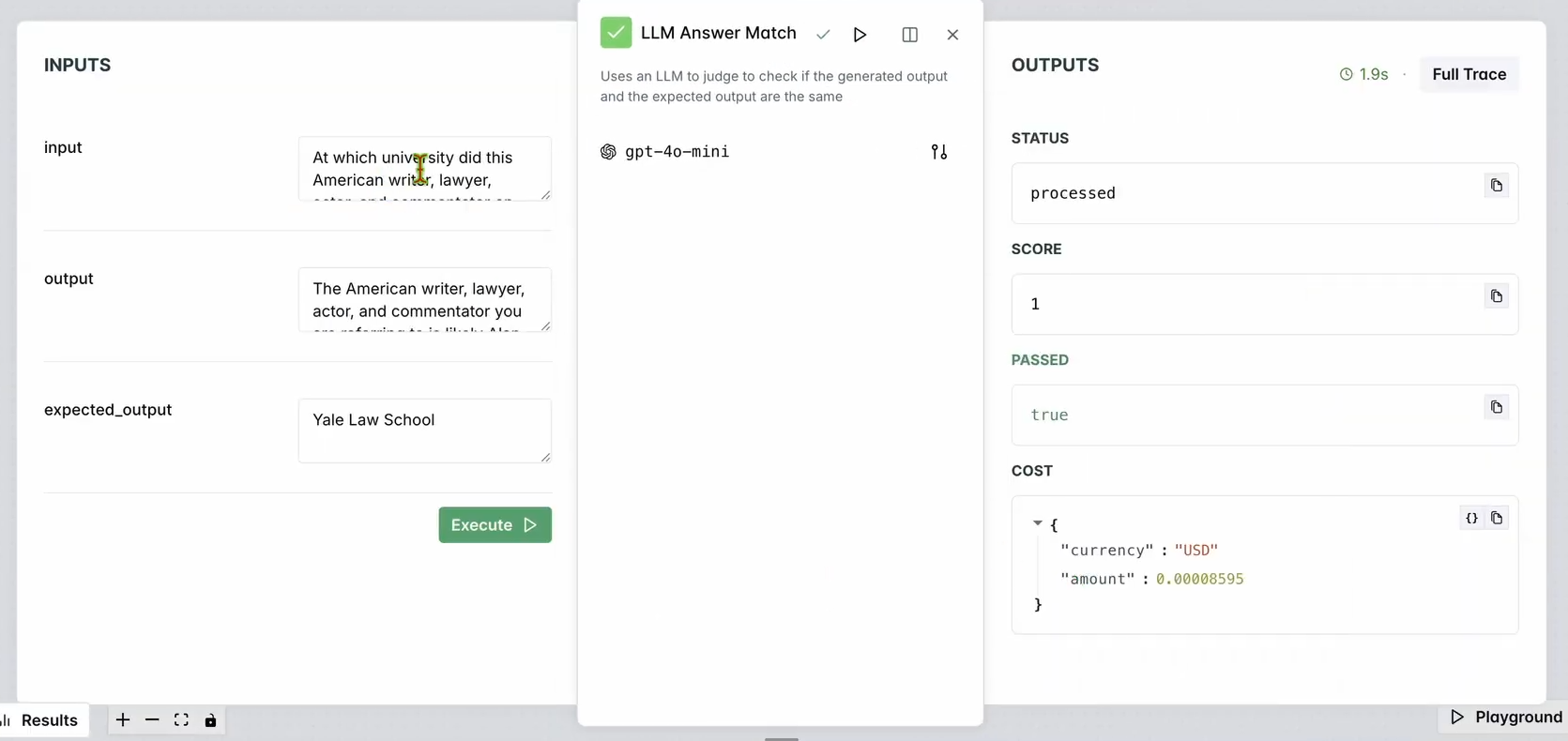

2. Configure un evaluador:

- Vaya a Evaluadores en el panel de control de LangWatch.

- Arrastre el evaluador LLM Answer Match al espacio de trabajo.

- Configúrelo:

- Establezca la Pregunta de entrada a las preguntas de entrada de su base de datos (por ejemplo, “¿Cuál es la palabra francesa para hoy?”).

- Establezca la Salida esperada también a las respuestas de su base de datos (por ejemplo, “Aujourd’hui”).

- Opcionalmente, cambie el modelo LLM del evaluador (por ejemplo, Llama, Gemini o Claude Sonnet) para variar.

3. Ejecute el evaluador:

- Haga clic en Ejecutar flujo de trabajo hasta aquí para probar el evaluador.

- Verifique los resultados para asegurarse de que la respuesta del chatbot coincida con la salida esperada.

Debería ver algo como:

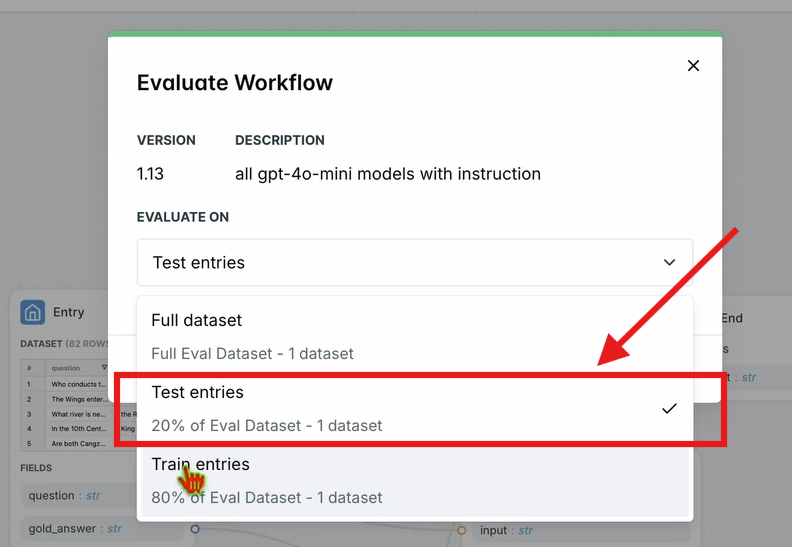

4. Evalúe el flujo de trabajo:

- En la barra de navegación superior, haga clic en Evaluar flujo de trabajo y seleccione Entradas de prueba.

- Esto evalúa todo el flujo de trabajo contra su conjunto de datos. Los resultados aparecerán después de un breve tiempo de procesamiento.

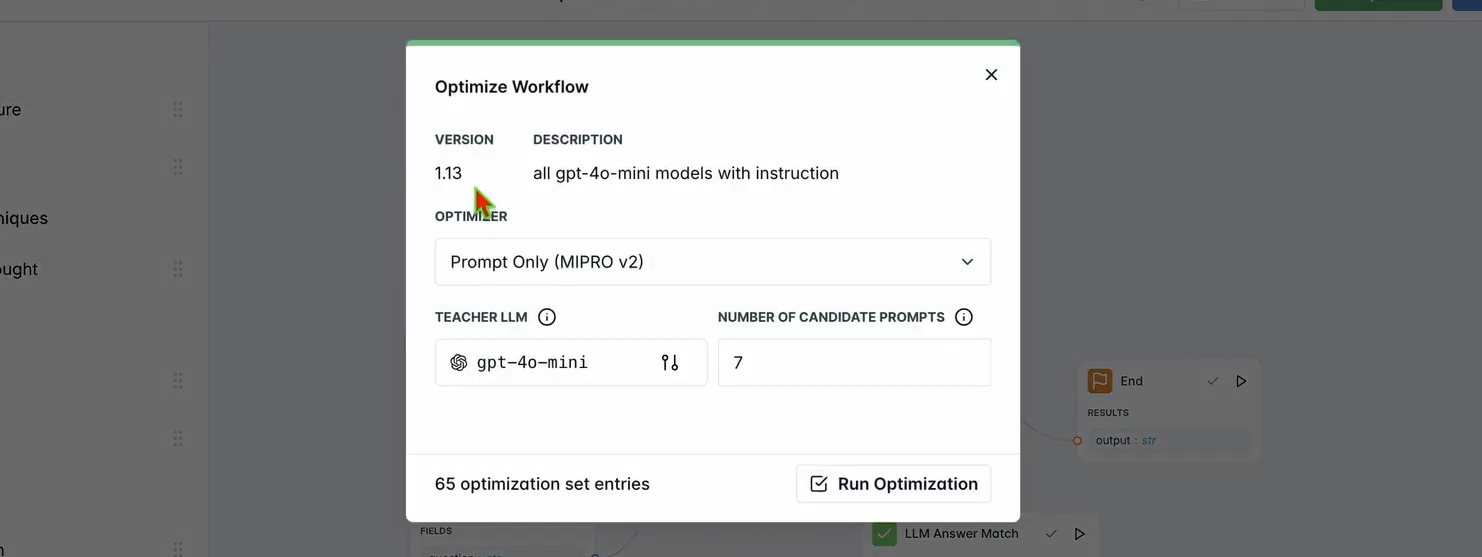

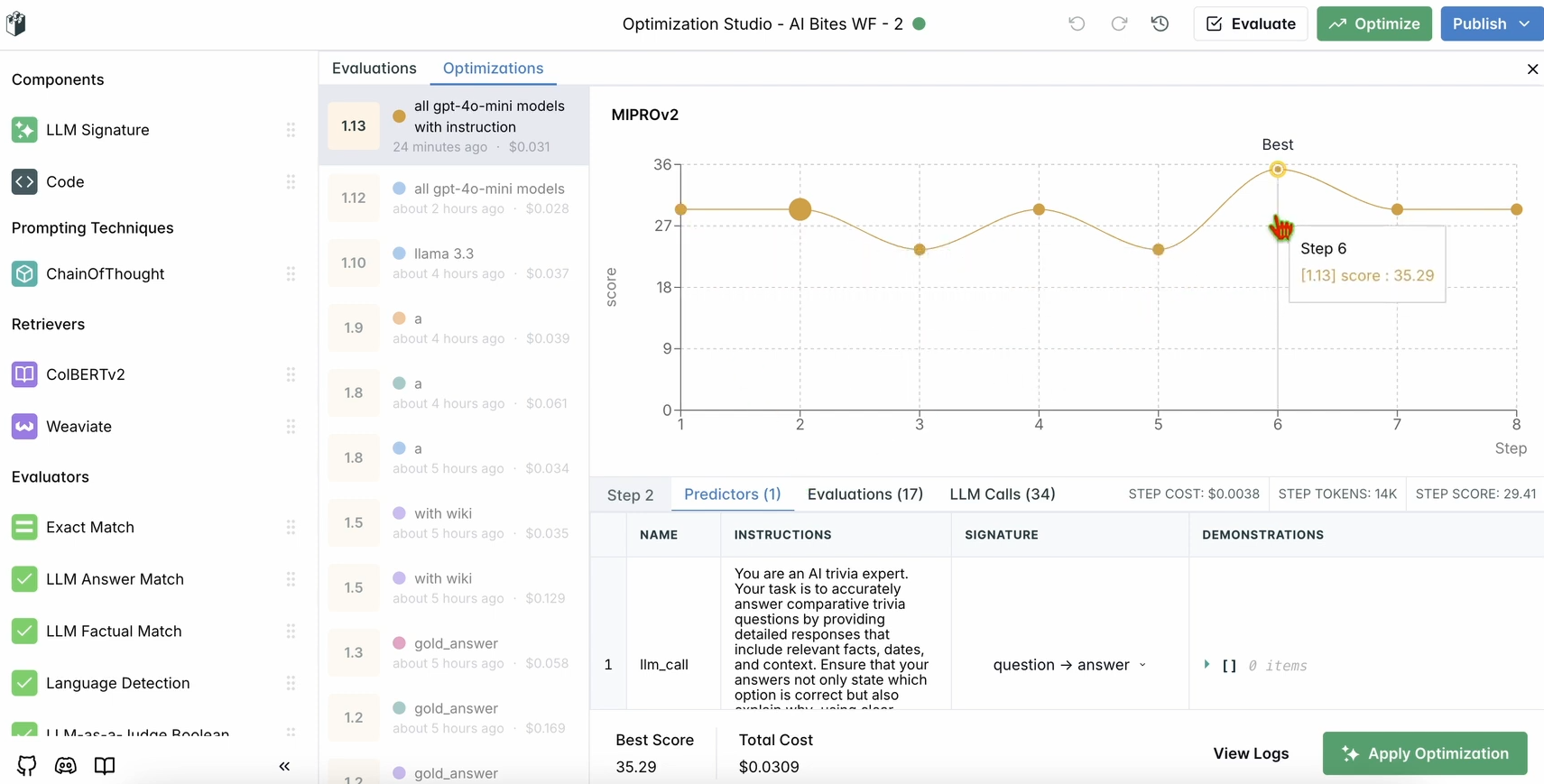

Paso 5: Optimice su flujo de trabajo

Una vez que su evaluación esté completa, optimicemos el rendimiento del chatbot.

1. Ejecute la optimización:

- En el panel de control de LangWatch, haga clic en Optimizar en la barra de navegación superior.

- Seleccione Solo prompt para ajustar el prompt del chatbot.

- Espere unos minutos para que la optimización se complete.

2. Verifique las mejoras:

- Revise los resultados optimizados en el panel de control. Debería ver una mejora en la precisión o calidad de la respuesta según las sugerencias de LangWatch.

Paso 6: Configuración local opcional de LangWatch

¿Quiere ejecutar LangWatch localmente para pruebas con datos sensibles? Siga estos pasos:

- Clone el repositorio:

git clone https://github.com/langwatch/langwatch.git

cd langwatch

2. Configure el entorno:

- Copie el archivo de entorno de ejemplo:

cp langwatch/.env.example langwatch/.env

3. Ejecute con Docker:

- Inicie el servidor de LangWatch:

docker compose up -d --wait --build

4. Acceda al panel de control:

- Abra http://localhost:5560 para ingresar al flujo de incorporación de LangWatch.

- Siga las indicaciones para configurar su instancia local.

Nota: La configuración de Docker es solo para pruebas y no es escalable para producción. Para producción, use LangWatch Cloud o Enterprise On-Premises.

¿Por qué usar LangWatch?

LangWatch resuelve el rompecabezas de la evaluación de LLM al proporcionar una plataforma unificada para monitorear, evaluar y optimizar sus pipelines de IA. Ya sea que esté ajustando prompts, analizando el rendimiento o asegurándose de que su chatbot dé respuestas precisas (como “Aujourd’hui” para “hoy” en francés), LangWatch lo hace muy fácil. Su integración con Python y herramientas como Chainlit y OpenAI significa que puede comenzar a rastrear y mejorar sus aplicaciones LLM en minutos.

Por ejemplo, nuestro chatbot de demostración ahora responde en ráfagas tipo tuit con emojis, y LangWatch ayuda a garantizar que sea preciso y optimizado. ¿Quiere escalar? Agregue más preguntas a su conjunto de datos o experimente con diferentes modelos LLM en el evaluador.

Conclusión

¡Ahí lo tiene! Ha aprendido qué es LangWatch, cómo instalarlo y cómo usarlo para monitorear y optimizar un chatbot. Desde la configuración de un proyecto de Python hasta el seguimiento de mensajes y la evaluación del rendimiento con un conjunto de datos, LangWatch le permite tomar el control de sus pipelines LLM. Nuestra pregunta de prueba —“¿Cuál es la palabra francesa para hoy?”— mostró lo fácil que es rastrear y mejorar las respuestas de la IA.

¿Listo para mejorar su juego de IA? Vaya a app.langwatch.ai, regístrese y comience a experimentar con LangWatch hoy mismo.

¿Quiere una plataforma integrada y todo en uno para que su equipo de desarrolladores trabaje con máxima productividad?

¡Apidog satisface todas sus demandas y reemplaza a Postman a un precio mucho más asequible!