Los desarrolladores buscan herramientas que mejoren la productividad sin introducir complejidad innecesaria. DeepSeek-V3.2 y DeepSeek-V3.2-Speciale emergen como potentes modelos de código abierto optimizados para tareas de razonamiento y agentic, ofreciendo una alternativa convincente a los sistemas propietarios. Estos modelos sobresalen en la generación de código, la resolución de problemas y el procesamiento de contextos largos, lo que los hace ideales para la integración en entornos de codificación basados en terminal como Claude Code.

botón

Comprendiendo DeepSeek-V3.2: Una Potencia de Código Abierto para Tareas de Razonamiento

Los desarrolladores valoran los modelos de código abierto por su transparencia y flexibilidad. DeepSeek-V3.2 se destaca como un modelo de lenguaje grande (LLM) que prioriza el razonamiento, la síntesis de código y las capacidades agentic. Lanzado bajo una licencia MIT, este modelo se basa en iteraciones anteriores como DeepSeek-V3.1, incorporando avances en mecanismos de atención dispersa para manejar contextos extendidos de hasta 128.000 tokens.

Puedes acceder a DeepSeek-V3.2 principalmente a través de Hugging Face, donde el repositorio en deepseek-ai/DeepSeek-V3.2 aloja los pesos del modelo, archivos de configuración y detalles del tokenizador. Para cargar el modelo localmente, instala la biblioteca Transformers a través de pip y ejecuta un script simple:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

model_name = "deepseek-ai/DeepSeek-V3.2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype=torch.float16, device_map="auto")

# Example inference

inputs = tokenizer("Write a Python function to compute Fibonacci sequence:", return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=100)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

Esta configuración requiere una GPU con al menos 16 GB de VRAM para una inferencia eficiente, aunque las técnicas de cuantificación a través de bibliotecas como bitsandbytes reducen la huella de memoria. La arquitectura de DeepSeek-V3.2 emplea un diseño de mezcla de expertos (MoE) con 236 mil millones de parámetros, activando solo un subconjunto por token para optimizar el cómputo. En consecuencia, logra un alto rendimiento en hardware de consumo manteniendo un rendimiento competitivo.

La transición de la experimentación local al uso a escala de producción a menudo requiere acceso a la API. Este cambio proporciona escalabilidad sin gestión de hardware, allanando el camino para integraciones como Claude Code.

DeepSeek-V3.2-Speciale: Capacidades Mejoradas para Flujos de Trabajo Agentic Avanzados

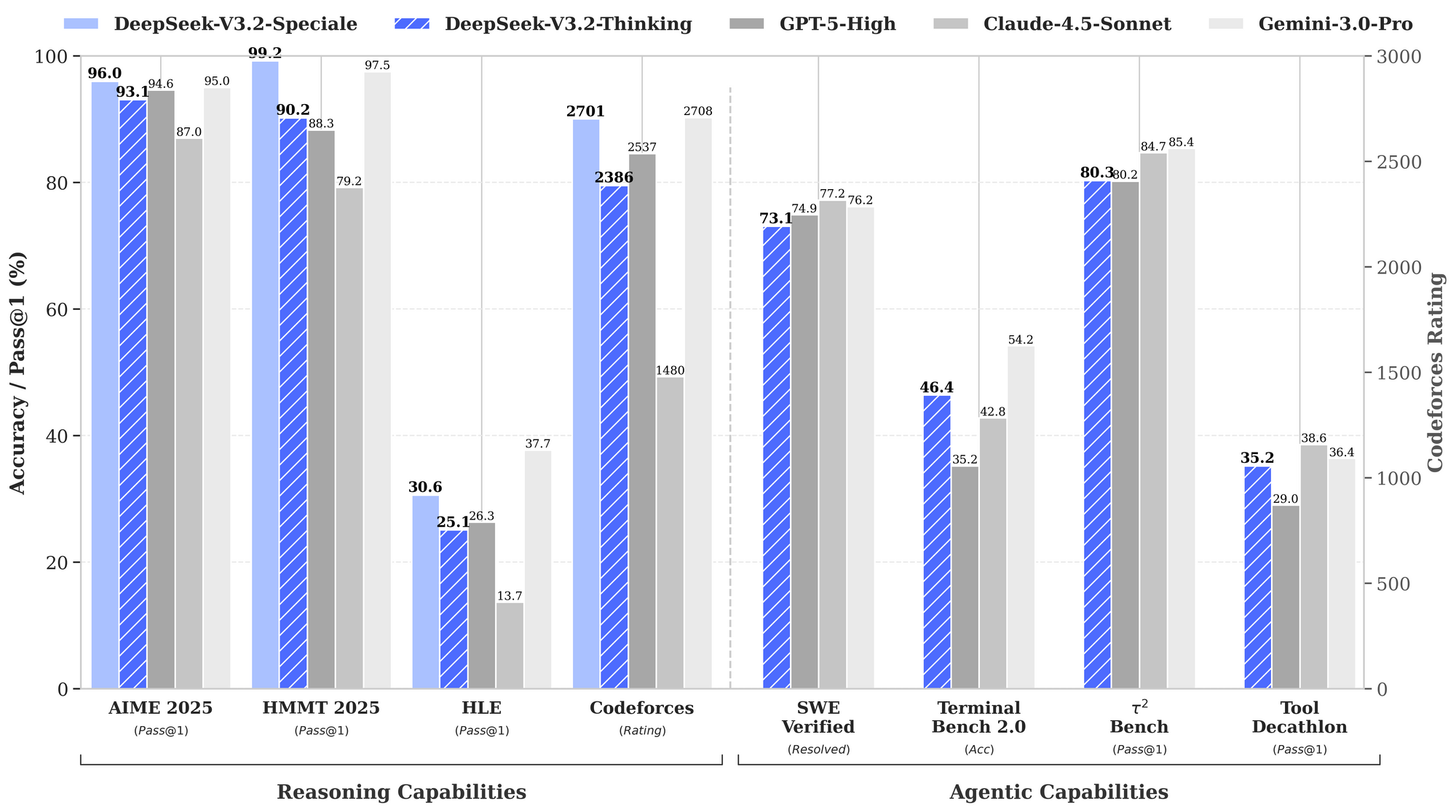

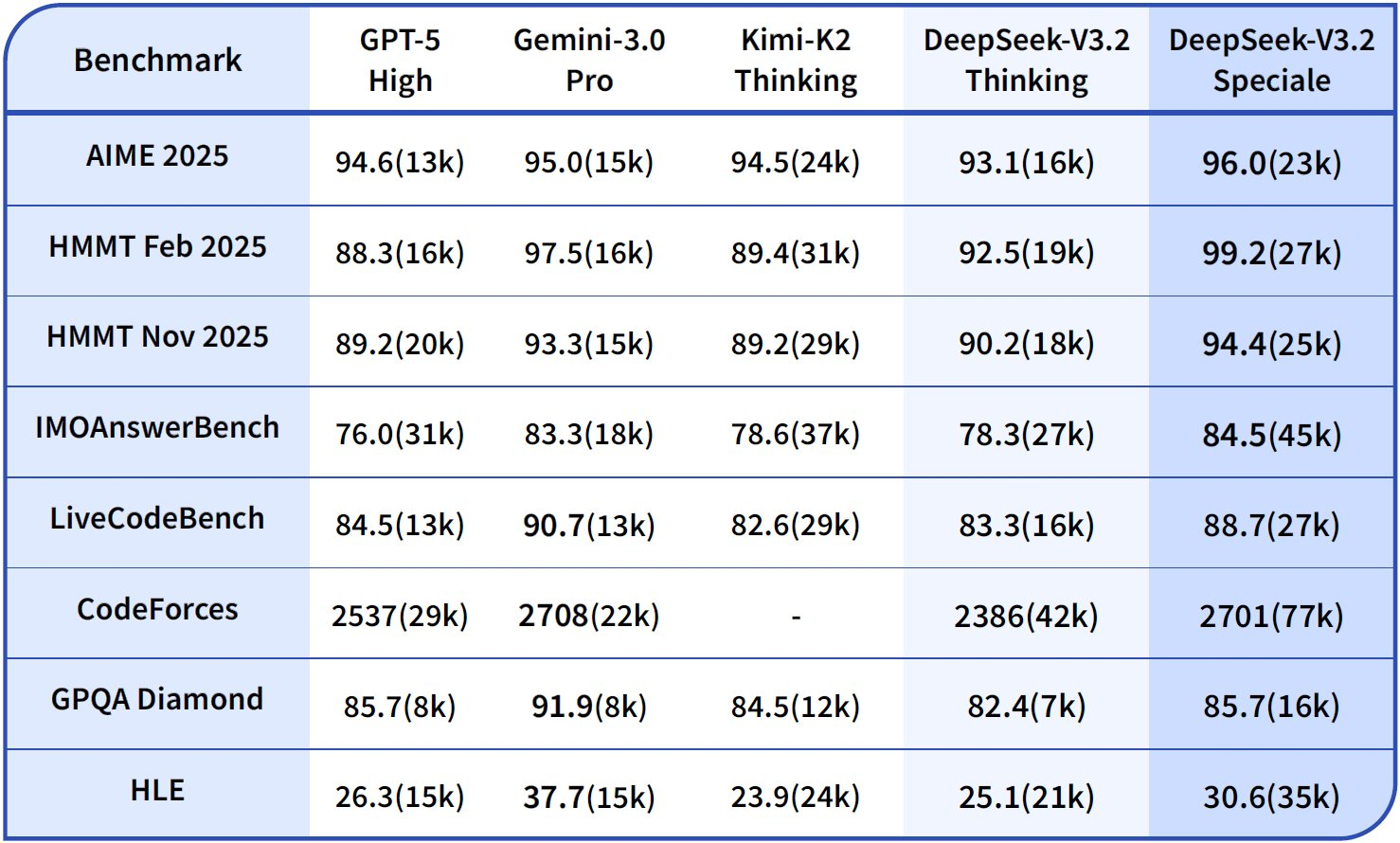

Mientras que DeepSeek-V3.2 ofrece una amplia utilidad, DeepSeek-V3.2-Speciale refina estas bases para demandas especializadas. Esta variante, ajustada para el razonamiento a nivel de concurso y simulaciones de alto riesgo, supera los límites en matemáticas, competiciones de codificación y tareas de agentes de varios pasos. Disponible a través del repositorio de Hugging Face en deepseek-ai/DeepSeek-V3.2-Speciale, comparte la arquitectura MoE central pero incorpora alineaciones post-entrenamiento adicionales para mayor precisión.

Carga DeepSeek-V3.2-Speciale de manera similar:

model_name = "deepseek-ai/DeepSeek-V3.2-Speciale"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype=torch.bfloat16, device_map="auto")

Su número de parámetros es similar al del modelo base, pero las optimizaciones en la atención dispersa —DeepSeek Sparse Attention (DSA)— producen una inferencia hasta un 50% más rápida en secuencias largas. DSA emplea una dispersión de grano fino, preservando la calidad al tiempo que reduce la complejidad cuadrática en las capas de atención.

En la práctica, DeepSeek-V3.2-Speciale brilla en escenarios que requieren razonamiento encadenado, como la optimización de algoritmos para la programación competitiva. Por ejemplo, se le puede pedir: "Resuelve este problema difícil de LeetCode: [descripción]. Explica tu enfoque paso a paso." El modelo genera soluciones estructuradas con análisis de complejidad temporal, a menudo superando a los modelos generalistas en un 15-20% en casos límite.

Sin embargo, las ejecuciones locales demandan más recursos; se recomiendan más de 24 GB de VRAM para una precisión completa. Para configuraciones más ligeras, aplica cuantificación de 4 bits:

from transformers import BitsAndBytesConfig

quant_config = BitsAndBytesConfig(load_in_4bit=True)

model = AutoModelForCausalLM.from_pretrained(model_name, quantization_config=quant_config)

Esta configuración mantiene el 90% de la fidelidad original al tiempo que reduce a la mitad el uso de memoria. Al igual que con el modelo base, habilita los modos de pensamiento para aprovechar sus rastros metacognitivos, donde se autocorrige las suposiciones a mitad del razonamiento.

El acceso de código abierto permite la personalización, pero para entornos colaborativos o escalados, los puntos finales de la API brindan confiabilidad. A continuación, examinaremos cómo conectar estos modelos con interacciones basadas en la nube.

Accediendo a la API de DeepSeek: Integración Perfecta para un Desarrollo Escalable

Los modelos de código abierto como DeepSeek-V3.2 y DeepSeek-V3.2-Speciale prosperan en configuraciones locales, pero el acceso a la API desbloquea aplicaciones más amplias. La plataforma de DeepSeek ofrece una interfaz compatible, que admite los SDK de OpenAI y Anthropic para una migración sin esfuerzo.

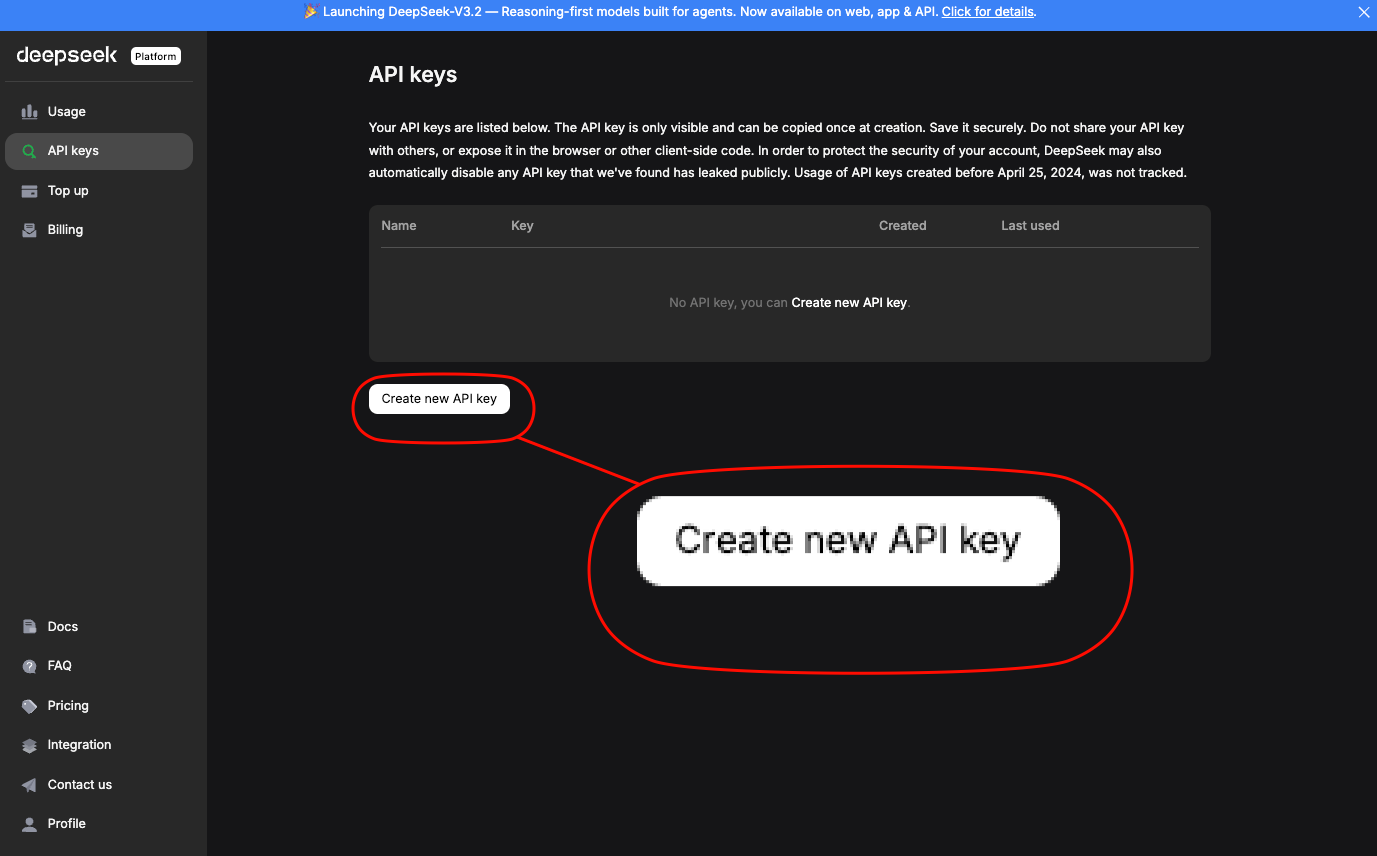

Regístrate en platform.deepseek.com para obtener una clave de API.

El panel proporciona análisis de uso y controles de facturación. Invoca modelos a través de endpoints estándar; para DeepSeek-V3.2, usa el alias deepseek-chat. DeepSeek-V3.2-Speciale requiere una URL base específica: https://api.deepseek.com/v3.2_speciale_expires_on_20251215 —ten en cuenta que este enrutamiento temporal expira el 15 de diciembre de 2025.

Una solicitud curl básica demuestra el acceso:

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $DEEPSEEK_API_KEY" \

-d '{

"model": "deepseek-chat",

"messages": [{"role": "user", "content": "Generate a REST API endpoint in Node.js for user authentication."}],

"max_tokens": 500,

"temperature": 0.7

}'

Esto devuelve un JSON con código generado, incluyendo manejo de errores e integración de JWT. Para compatibilidad con Anthropic —clave para Claude Code— establece la URL base en https://api.deepseek.com/anthropic y usa el SDK de Python de anthropic:

import anthropic

client = anthropic.Anthropic(base_url="https://api.deepseek.com/anthropic", api_key="your_deepseek_key")

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

messages=[{"role": "user", "content": "Explain quantum entanglement in code terms."}]

)

print(message.content[0].text)

Tal compatibilidad garantiza reemplazos directos. Los límites de velocidad se sitúan en 10.000 tokens por minuto para los niveles estándar, escalables a través de planes empresariales.

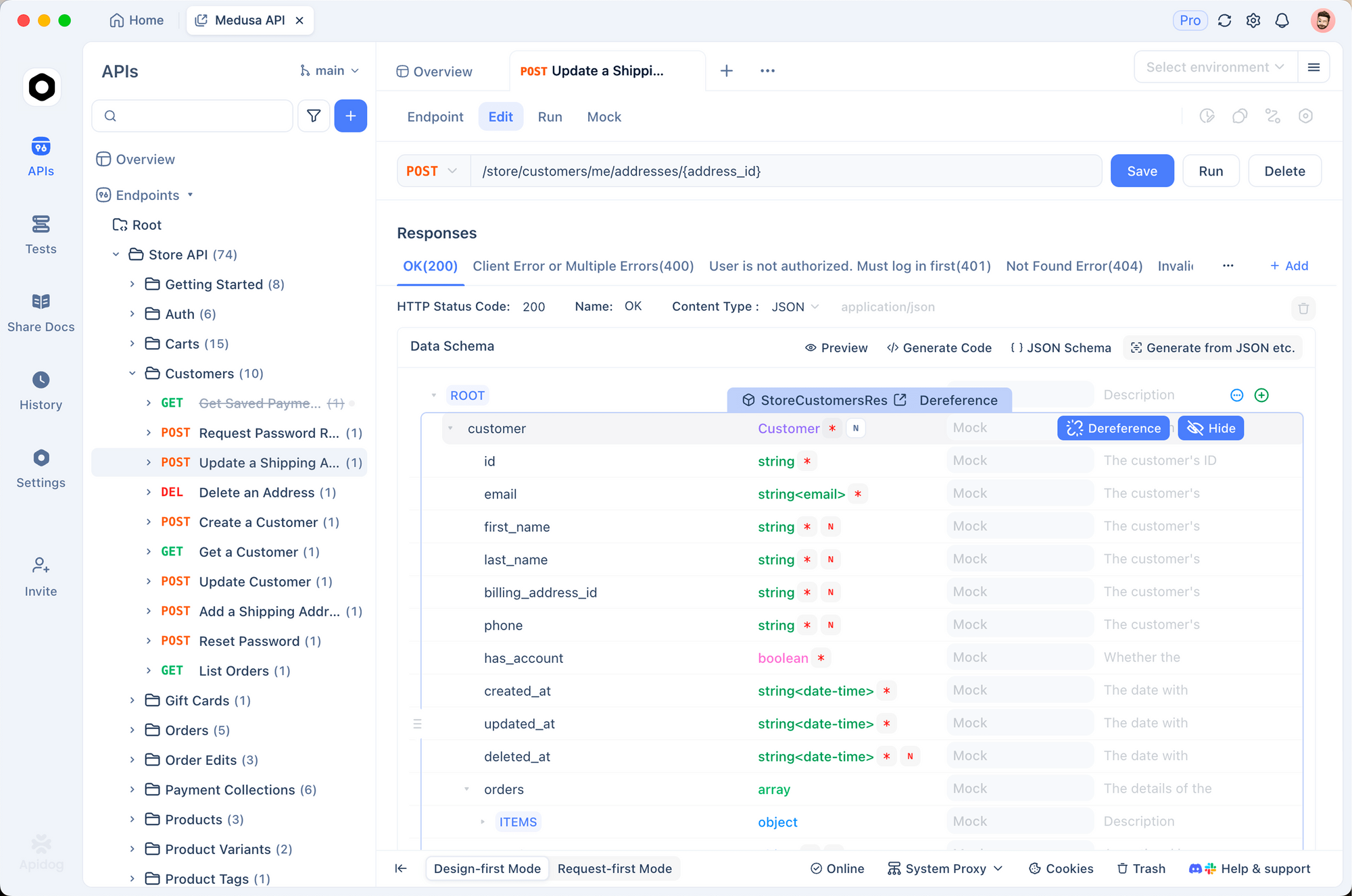

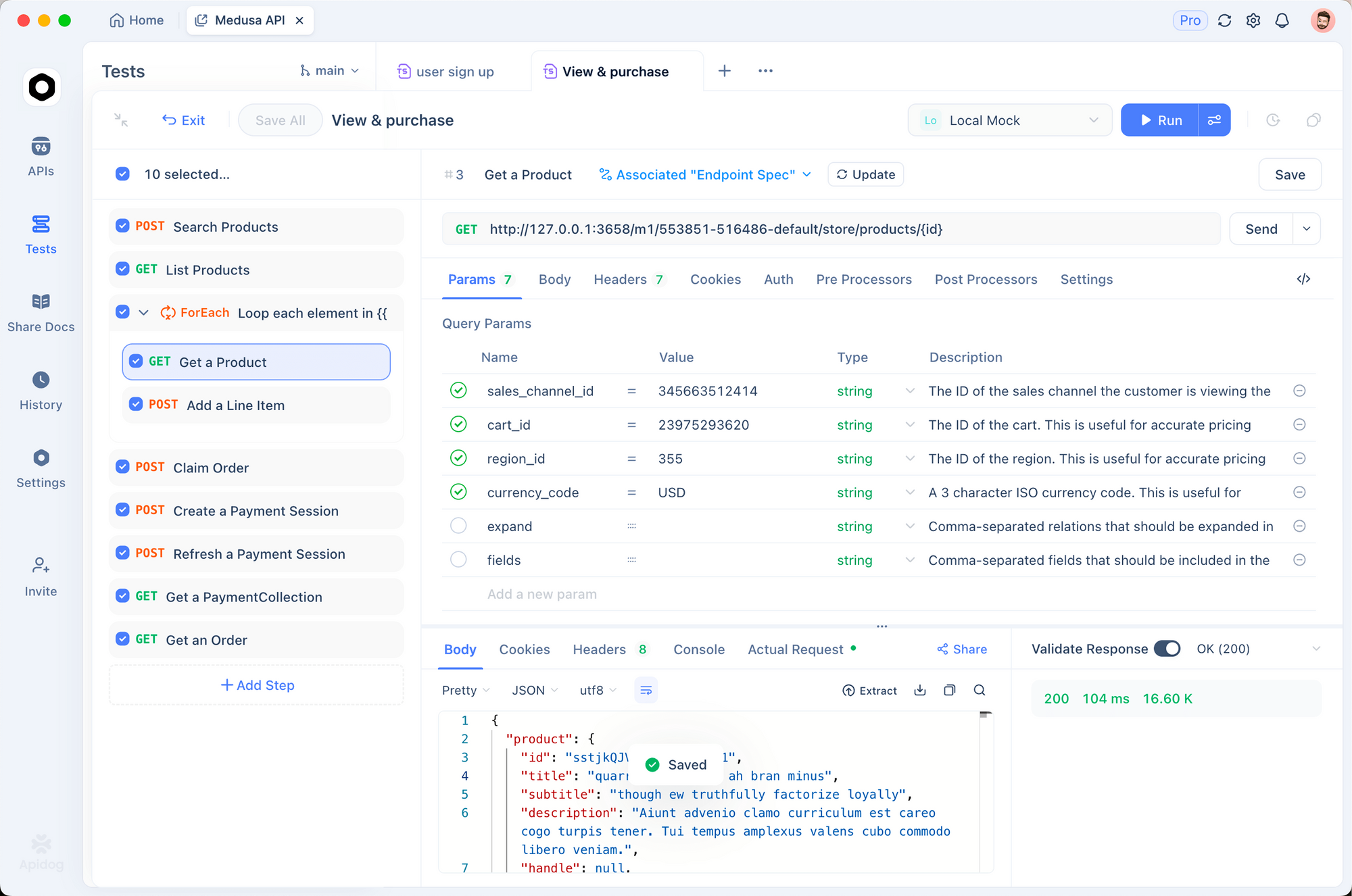

Usa Apidog para prototipar estas llamadas. Importa la especificación OpenAPI de la documentación de DeepSeek a Apidog, luego simula solicitudes con cargas útiles variables. Esta herramienta genera automáticamente conjuntos de pruebas, validando las respuestas contra los esquemas, lo cual es esencial para asegurar que las salidas del modelo se alineen con los estándares de tu base de código.

Con el acceso a la API asegurado, integra estos puntos finales en las herramientas de desarrollo. Claude Code, en particular, se beneficia de esta configuración, como se explora a continuación.

Desglose de Precios: Estrategias Rentables para el Uso de la API de DeepSeek

Los desarrolladores conscientes del presupuesto aprecian los costos predecibles. El modelo de precios de DeepSeek recompensa la eficiencia en la formulación de preguntas y el almacenamiento en caché, impactando directamente en las sesiones de Claude Code.

Desglose de la estructura: Los aciertos de caché se aplican a prefijos repetidos, ideal para codificación iterativa donde se refinan las indicaciones a lo largo de las sesiones. Los errores cobran tarifas de entrada completas, así que estructura las conversaciones para maximizar la reutilización. Las salidas escalan linealmente con la longitud de la generación; limita max_tokens para controlar los gastos.

| Variante del Modelo | Acierto de caché de entrada ($/1M Tokens) | Fallo de caché de entrada ($/1M Tokens) | Salida ($/1M Tokens) | Longitud del Contexto |

|---|---|---|---|---|

| DeepSeek-V3.2 | 0.028 | 0.28 | 0.42 | 128K |

| DeepSeek-V3.2-Speciale | 0.028 | 0.28 | 0.42 | 128K |

Los usuarios empresariales negocian descuentos por volumen, pero los niveles gratuitos ofrecen 1 millón de tokens mensuales para pruebas. Monitoriza a través del panel de control; integra el registro en Claude Code para rastrear el uso de tokens:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=$DEEPSEEK_API_KEY

claude --log-tokens

Este comando muestra métricas después de la sesión, ayudando a optimizar las indicaciones. Para la codificación de contexto largo, DSA en las variantes V3.2 mantiene los costos estables incluso con más de 100K tokens, a diferencia de los modelos densos que escalan cuadráticamente.

Integrando DeepSeek-V3.2 y V3.2-Speciale en Claude Code: Configuración Paso a Paso

Claude Code revoluciona el desarrollo basado en terminal como una herramienta de agente de Anthropic. Interpreta comandos de lenguaje natural, ejecuta operaciones de git, explica bases de código y automatiza rutinas, todo dentro de tu shell. Al enrutar las solicitudes a los modelos DeepSeek, aprovechas el razonamiento rentable sin sacrificar la interfaz intuitiva de Claude Code.

Comienza con los requisitos previos: Instala Claude Code a través de pip (pip install claude-code) o desde GitHub anthropics/claude-code. Asegúrate de que Node.js y git residan en tu PATH.

Configura las variables de entorno para la compatibilidad con DeepSeek:

export ANTHROPIC_BASE_URL="https://api.deepseek.com/anthropic"

export ANTHROPIC_API_KEY="sk-your_deepseek_key_here"

export ANTHROPIC_MODEL="deepseek-chat" # Para V3.2

export ANTHROPIC_SMALL_FAST_MODEL="deepseek-chat"

export API_TIMEOUT_MS=600000 # 10 minutos para razonamiento largo

export CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC=1 # Optimizar para API

Para DeepSeek-V3.2-Speciale, añade la base personalizada: export ANTHROPIC_BASE_URL="https://api.deepseek.com/v3.2_speciale_expires_on_20251215/anthropic". Verifica la configuración ejecutando claude --version; detecta el punto final automáticamente.

Inicia Claude Code en el directorio de tu proyecto:

cd /ruta/a/tu/repositorio

claude

Interactúa a través de comandos. Para la generación de código: "/generar Implementar un árbol de búsqueda binario en C++ con balanceo AVL." DeepSeek-V3.2 lo procesa, generando archivos con explicaciones. Su modo de pensamiento se activa implícitamente para tareas complejas, trazando la lógica antes del código.

Manejo de flujos de trabajo de agente: "/agente Depura este conjunto de pruebas fallido y sugiere soluciones." El modelo analiza los rastros de pila, propone parches y realiza commits a través de git, todo impulsado por la puntuación de DeepSeek de 84.8% en SWE-Bench. El uso de herramientas paralelas brilla aquí; especifica "/usar-herramienta pytest" para ejecutar pruebas en línea.

Personaliza con plugins. Extiende la configuración YAML de Claude Code (~/.claude-code/config.yaml) para priorizar DeepSeek en prompts que requieran mucho razonamiento:

models:

default: deepseek-chat

fallback: deepseek-chat # Para V3.2-Speciale, sobrescribe por sesión

reasoning_enabled: true

max_context: 100000 # Aprovecha la ventana de 128K

Prueba las integraciones utilizando Apidog. Exporta las sesiones de Claude Code como archivos HAR, impórtalas en Apidog y reprodúcelas contra los endpoints de DeepSeek. Esto valida la latencia (típicamente <2s para 1K tokens) y las tasas de error, refinando las indicaciones para producción.

Solución de problemas comunes: Si la autenticación falla, regenera tu clave API. Para los límites de tokens, divide grandes bases de código con "/resumir estructura del repositorio primero." Estos ajustes aseguran un funcionamiento sin problemas.

Técnicas Avanzadas: Aprovechando DeepSeek en Claude Code para un Rendimiento Óptimo

Más allá de lo básico, los usuarios avanzados explotan las fortalezas de DeepSeek. Habilita explícitamente la cadena de pensamiento (CoT): "/piensa Resuelve este problema de programación dinámica: [detalles]." V3.2-Speciale genera rastros metacognitivos, autocorrige mediante simulaciones cuasi-Monte Carlo en texto, lo que aumenta la precisión al 94.6% en HMMT.

Para ediciones de varios archivos, usa "/editar --archivos main.py utils.py Añadir decoradores de registro". El agente navega por las dependencias, aplicando cambios de forma atómica. Los puntos de referencia muestran un éxito del 80.3% en Terminal-Bench 2.0, superando a Gemini-3.0-Pro.

Integra herramientas externas: Configura "/herramienta npm run build" para la validación post-generación. El benchmark de uso de herramientas de DeepSeek (84.7%) asegura una orquestación fiable.

Supervisa la ética: DeepSeek se alinea con la seguridad a través de RLHF, pero audita las salidas en busca de sesgos en las suposiciones del código. Utiliza la validación de esquemas de Apidog para aplicar patrones seguros, como la sanitización de entradas.

Escala a equipos: Comparte configuraciones a través de repositorios de dotfiles. En CI/CD, incrusta scripts de Claude Code con DeepSeek para revisiones automáticas de PR, reduciendo el tiempo de revisión en un 40%.

Aplicaciones en el Mundo Real: Claude Code Impulsado por DeepSeek en Acción

Considera un proyecto de tecnología financiera: "/generar API segura para el procesamiento de transacciones usando GraphQL." DeepSeek-V3.2 genera esquemas, resolvers y middleware de limitación de velocidad, validados según los estándares OWASP.

En pipelines de ML: "/agente Optimiza este modelo PyTorch para despliegue en edge." Refactoriza para cuantificación, prueba en hardware simulado y documenta las compensaciones.

Estos casos demuestran ganancias de productividad de 2 a 3 veces, corroboradas por informes de usuarios en los problemas de GitHub.

Conclusión

DeepSeek-V3.2 y DeepSeek-V3.2-Speciale transforman Claude Code en una potencia centrada en el razonamiento. Desde la carga de código abierto hasta la escalabilidad impulsada por la API, estos modelos ofrecen un rendimiento líder en el mercado a una fracción del costo. Implementa los pasos descritos, comenzando con Apidog para el prototipado de API, y sé testigo de flujos de trabajo optimizados.

Experimenta hoy: Configura tu entorno, ejecuta un comando de ejemplo e itera. La integración no solo acelera el desarrollo, sino que fomenta una comprensión más profunda del código a través de un razonamiento transparente. A medida que la IA evoluciona, herramientas como estas aseguran que los desarrolladores permanezcan a la vanguardia.

botón