Los desarrolladores buscan constantemente herramientas que aumenten la eficiencia sin comprometer la precisión. La integración de Cursor de los modelos GPT-5.1 Codex de OpenAI destaca como un excelente ejemplo, ofreciendo un conjunto de variantes especializadas adaptadas para flujos de trabajo basados en agentes. Estos modelos transforman la forma en que se maneja la generación de código, la depuración y la refactorización directamente dentro de su IDE.

Entendiendo Cursor Codex: La Base de la Integración GPT-5.1

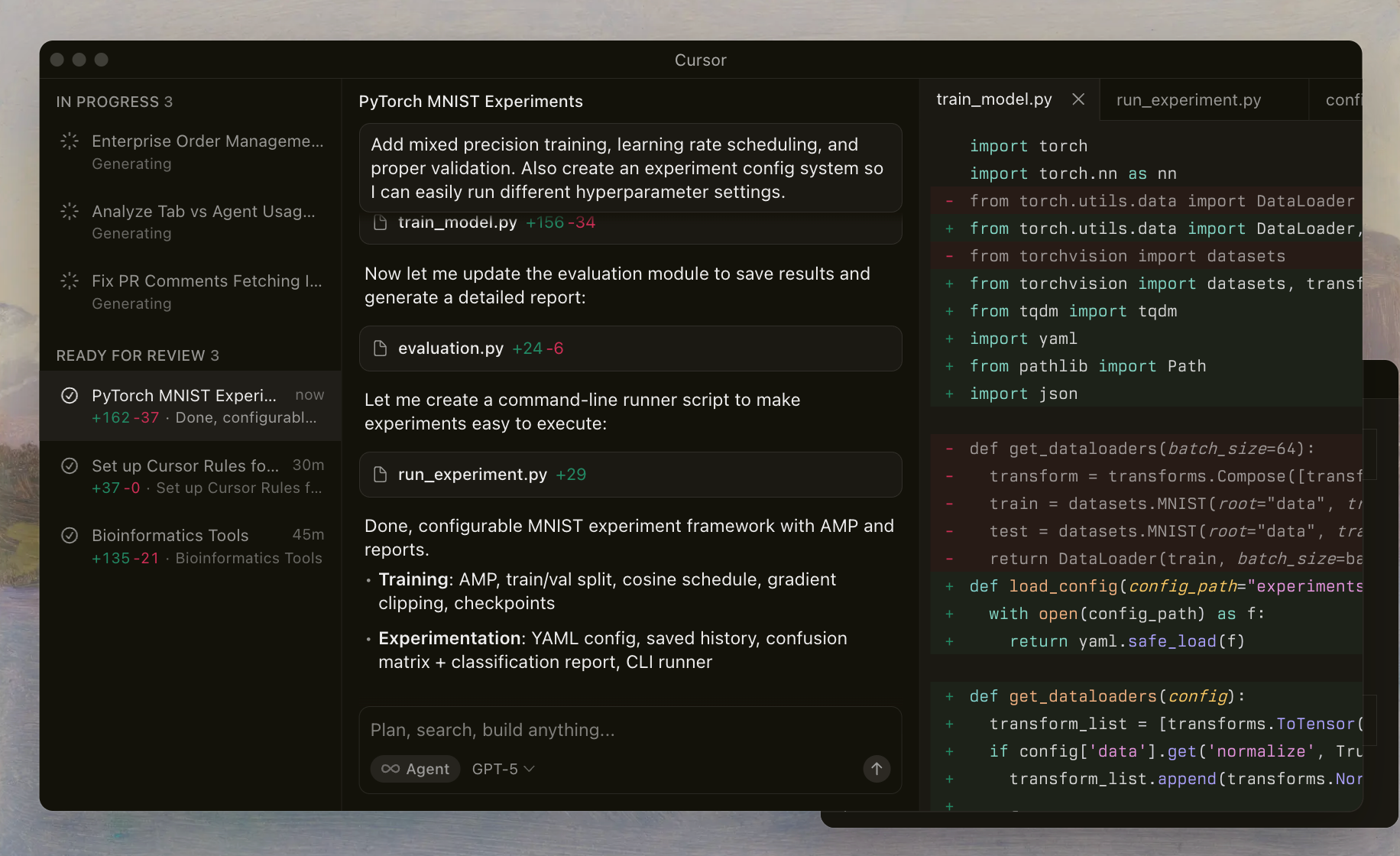

Cursor Codex se refiere a la avanzada familia de modelos de OpenAI afinados para tareas de codificación y aprovechados sin problemas dentro del IDE de Cursor. Los desarrolladores activan estos modelos a través de un selector dedicado, lo que permite a los agentes de IA leer archivos, ejecutar comandos de shell y aplicar ediciones de forma autónoma. Esta configuración se basa en un arnés personalizado que alinea las indicaciones y herramientas con el entrenamiento de los modelos, asegurando un rendimiento confiable en repositorios complejos.

La serie GPT-5.1 se basa en iteraciones anteriores al enfatizar las capacidades de agente, lo que significa que los modelos actúan como asistentes inteligentes que planifican, iteran y se autocorrigen. A diferencia de los LLM de propósito general, Cursor Codex prioriza los flujos de trabajo orientados a la shell. Por ejemplo, los modelos aprenden a invocar herramientas para la inspección de archivos o el linting, reduciendo las alucinaciones y mejorando la precisión de la edición.

La implementación de Cursor incluye salvaguardas como rastros de razonamiento, que preservan el proceso de pensamiento del modelo a través de las interacciones. Esta continuidad evita el error común de la pérdida de contexto en sesiones de múltiples turnos. A medida que experimente con estos modelos, notará cómo manejan los casos extremos, como la resolución de conflictos de fusión o la optimización de código asíncrono.

Pasando a detalles, OpenAI lanzó la línea GPT-5.1 Codex a finales de 2025, coincidiendo con el marco de agente actualizado de Cursor. Este momento permite a los desarrolladores aprovechar la inteligencia de vanguardia para tareas cotidianas, desde la creación de prototipos de microservicios hasta la auditoría de sistemas heredados.

Presentando la Familia de Modelos GPT-5.1 Codex

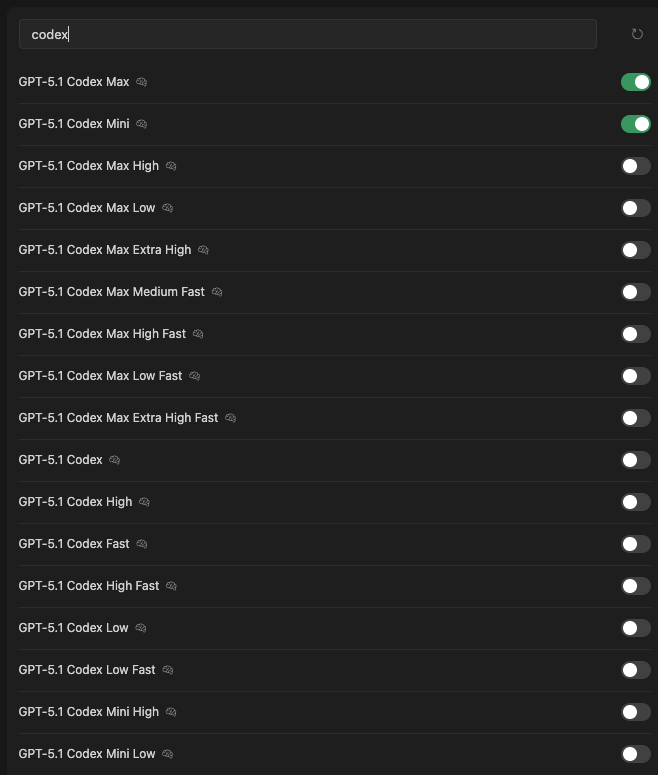

Cursor proporciona una extensa línea de variantes GPT-5.1 Codex, cada una optimizada para distintas compensaciones en inteligencia, velocidad y uso de recursos. Se accede a ellas a través del selector de modelos en el IDE, donde los interruptores indican la disponibilidad y la selección actual. A continuación, presentamos cada una, destacando los atributos principales derivados de la documentación del arnés de Cursor y los benchmarks internos.

GPT-5.1 Codex Max: El Buque Insignia para Tareas Exigentes

GPT-5.1 Codex Max sirve como la piedra angular de la familia. Los ingenieros de OpenAI entrenaron este modelo con vastos conjuntos de datos de sesiones de codificación de agentes, incorporando herramientas específicas de Cursor como la ejecución de shell y los lectores de lint. Destaca en el mantenimiento de un razonamiento de contexto largo, procesando hasta 512K tokens sin degradación.

Las características clave incluyen la llamada adaptativa de herramientas: el modelo selecciona dinámicamente entre ediciones directas y fallbacks basados en Python para modificaciones complejas. Por ejemplo, al refactorizar una aplicación Node.js, Codex Max genera un plan, invoca git diff para la validación y aplica los cambios de forma atómica.

Los benchmarks revelan su destreza. En la suite de evaluación interna de Cursor, que mide las tasas de éxito en repositorios reales, Codex Max logra una resolución del 78% para tareas de múltiples archivos, superando los equivalentes de GPT-4.5 en un 15%. Sin embargo, exige mayor cómputo, con tiempos de inferencia que promedian 2-3 segundos por turno en hardware estándar.

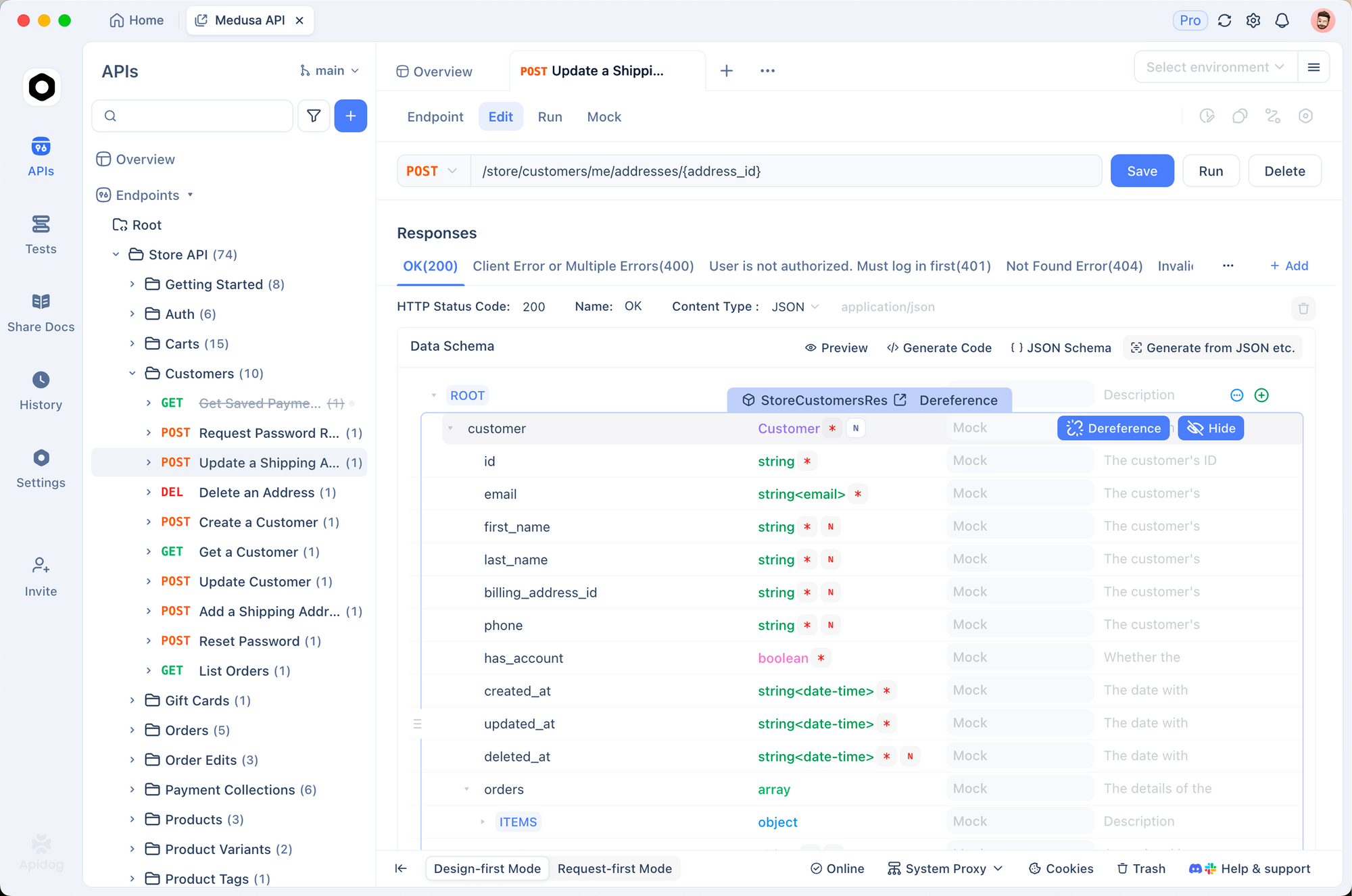

Los desarrolladores prefieren este modelo para proyectos a escala empresarial, donde la precisión supera la velocidad. Si su flujo de trabajo implica la integración de API, combínelo con Apidog para validar automáticamente los esquemas generados.

GPT-5.1 Codex Mini: Potencia Compacta para Iteraciones Rápidas

A continuación, GPT-5.1 Codex Mini reduce el recuento de parámetros manteniendo el 85% de la fidelidad de codificación de Max. Esta variante está dirigida a entornos ligeros, como el desarrollo de aplicaciones móviles o los pipelines de CI/CD. Procesa 128K tokens y prioriza las respuestas de baja latencia, registrando menos de 1 segundo para la mayoría de las consultas.

El modelo emplea el conocimiento destilado de Max, centrándose en patrones comunes como la refactorización basada en expresiones regulares o la generación de pruebas unitarias. Una capacidad destacada son sus resúmenes de razonamiento en línea: líneas concisas que actualizan a los usuarios sin registros verbosos. Esto reduce la carga cognitiva durante la creación rápida de prototipos.

En las pruebas de rendimiento, Codex Mini obtiene un 62% en SWE-bench lite, un subconjunto de tareas de ingeniería de software. Destaca en ediciones de un solo archivo, donde la velocidad permite una iteración fluida. Para los equipos que construyen servicios RESTful, este modelo se integra sin esfuerzo con las herramientas de mocking de Apidog, permitiendo simulaciones instantáneas de puntos finales.

GPT-5.1 Codex Max High: Inteligencia Equilibrada con Precisión Elevada

GPT-5.1 Codex Max High refina la línea base de Max amplificando la precisión en escenarios de alto riesgo. OpenAI lo ajustó para dominios como la auditoría de seguridad y la optimización del rendimiento, donde los falsos positivos cuestan tiempo. Maneja 256K contextos e incorpora indicaciones especializadas para la detección de vulnerabilidades.

Funciones como los rastros extendidos de la cadena de pensamiento permiten un análisis más profundo. El modelo emite justificaciones paso a paso antes de las llamadas a herramientas, garantizando la transparencia. Por ejemplo, al asegurar una ruta de Express.js, escanea dependencias, sugiere parches y verifica mediante linting simulado.

Las métricas muestran una tasa de éxito del 72% en el módulo de seguridad de Cursor Bench, superando al Max estándar en un 5%. Los tiempos de respuesta oscilan entre 1.5 y 2.5 segundos, lo que lo hace adecuado para repositorios de tamaño mediano. Los desarrolladores que lo utilicen para aplicaciones con muchas API apreciarán su sinergia con Apidog, que puede importar especificaciones OpenAPI generadas por Codex para revisiones colaborativas.

GPT-5.1 Codex Max Low: Precisión Eficiente en Recursos

GPT-5.1 Codex Max Low reduce las demandas computacionales sin sacrificar la inteligencia central. Ideal para laptops o clusters compartidos, se limita a 128K tokens y optimiza el procesamiento por lotes. El modelo favorece las ediciones conservadoras, minimizando las revisiones a favor de correcciones específicas.

Incluye un conjunto de herramientas de bajo sobrecarga, basándose en conceptos básicos de shell como grep y sed en lugar de scripts pesados de Python. Este enfoque produce una eficacia del 68% en benchmarks con muchas ediciones, con una inferencia de menos de 2 segundos. Los casos de uso abarcan la migración de código heredado, donde la estabilidad supera la novedad.

Para los desarrolladores de API, esta variante se combina bien con el nivel gratuito de Apidog, lo que permite pruebas ligeras de puntos finales de bajos recursos sin sobrecargar su máquina.

GPT-5.1 Codex Max Extra High: Precisión Ultra Fina para Expertos

GPT-5.1 Codex Max Extra High supera los límites con un modelado probabilístico mejorado. Entrenado en conjuntos de datos de casos extremos, logra una intuición casi humana para tareas ambiguas, como inferir la intención de especificaciones parciales. La ventana de contexto se expande a 384K, admitiendo la navegación de monorepositorios.

Las características avanzadas incluyen la planificación multi-hipótesis: el modelo genera y clasifica variantes de edición antes de confirmarlas. En refactorizaciones complejas, resuelve el 82% de los conflictos de forma autónoma.

Los benchmarks destacan su ventaja —85% en las evaluaciones avanzadas de Cursor— pero con latencias de 3-4 segundos. Resérvelo para codificación de nivel de investigación, como el diseño de algoritmos. Integre Apidog para prototipar contratos de API de altísima fidelidad derivados de sus resultados.

GPT-5.1 Codex Max Medium Fast: La Velocidad Encuentra la Competencia

GPT-5.1 Codex Max Medium Fast encuentra un equilibrio entre la profundidad y la rapidez. Procesa 192K tokens y emplea pesos cuantificados para respuestas de 1.2 segundos. El modelo equilibra las llamadas a herramientas con la generación directa, ideal para la depuración interactiva.

Obtiene un 70% en bancos de trabajo de carga mixta, destacando en tareas híbridas como la finalización de código más la explicación. Los desarrolladores lo aprovechan para ciclos de TDD, donde los bucles de retroalimentación rápidos aceleran el progreso.

GPT-5.1 Codex Max High Fast: Ingeniería de Precisión Rápida

GPT-5.1 Codex Max High Fast acelera la precisión de High con rutas de inferencia paralelas. Con 256K de contexto, ofrece turnos de 1 segundo manteniendo puntuaciones de benchmark del 74%. Características como el linting predictivo anticipan errores antes de la edición.

Esta variante es adecuada para equipos de alta velocidad, como los de desarrollo de API fintech. Apidog la complementa agilizando la validación de puntos finales optimizados para la velocidad.

GPT-5.1 Codex Max Low Fast: Operaciones Ligeras y Rápidas

GPT-5.1 Codex Max Low Fast combina la eficiencia de Low con velocidades de subsegundo. Limitado a 96K tokens, prioriza la eficiencia de un solo turno, alcanzando el 65% en evaluaciones de edición rápida.

Perfecto para scripting o hotfixes, minimiza la sobrecarga en configuraciones con recursos limitados.

GPT-5.1 Codex Max Extra High Fast: Híbrido de Máximo Rendimiento

GPT-5.1 Codex Max Extra High Fast fusiona la profundidad de Extra High con una velocidad vertiginosa —máximo de 2 segundos para contextos de 384K. Alcanza un 80% en los benchmarks de élite, utilizando cuantificación adaptativa.

Para flujos de trabajo de vanguardia, este modelo redefine la codificación de agentes.

GPT-5.1 Codex: La Línea Base Versátil

GPT-5.1 Codex actúa como el núcleo sin adornos, ofreciendo un manejo equilibrado de 256K con promedios de 2 segundos. Sustenta todas las variantes, obteniendo un 70% en todos los ámbitos, confiable para uso general.

GPT-5.1 Codex High: Utilidad Diaria Elevada

GPT-5.1 Codex High aumenta la precisión de la línea base al 73%, centrándose en una planificación robusta para contextos de 192K.

GPT-5.1 Codex Fast: Diseño Priorizando la Velocidad

GPT-5.1 Codex Fast se reduce a respuestas de 1 segundo y 128K tokens, con un 60% de eficacia, ideal para complementos.

GPT-5.1 Codex High Fast: Agilidad Ajustada

GPT-5.1 Codex High Fast ofrece un 72% de precisión en 1.2 segundos, combinando las características de High con la velocidad.

GPT-5.1 Codex Low: Precisión Minimalista

GPT-5.1 Codex Low conserva recursos con 96K tokens, puntuaciones del 67%, adecuado para dispositivos de borde.

GPT-5.1 Codex Low Fast: Ultra Eficiente

GPT-5.1 Codex Low Fast alcanza subsegundos con un 62% —ideal para microtareas.

GPT-5.1 Codex Mini High: Excelencia Compacta

GPT-5.1 Codex Mini High mejora Mini con un 65% de precisión en 0.8 segundos.

GPT-5.1 Codex Mini Low: Compacto y Económico

GPT-5.1 Codex Mini Low ofrece un 58% a un costo mínimo, para necesidades básicas.

Comparación Técnica: Métricas Relevantes

Para determinar el mejor modelo de Cursor Codex, analizamos métricas clave: tasa de éxito (de Cursor Bench), latencia, tamaño del contexto y eficacia de la herramienta. La tasa de éxito mide la finalización autónoma de tareas, la latencia rastrea el tiempo de respuesta, el contexto mide la capacidad de tokens y la eficacia de la herramienta evalúa la integración de shell.

| Variante del Modelo | Tasa de Éxito (%) | Latencia (s) | Contexto (K Tokens) | Eficacia de la Herramienta (%) |

|---|---|---|---|---|

| GPT-5.1 Codex Max | 78 | 2-3 | 512 | 92 |

| GPT-5.1 Codex Mini | 62 | <1 | 128 | 85 |

| GPT-5.1 Codex Max High | 72 | 1.5-2.5 | 256 | 90 |

| GPT-5.1 Codex Max Low | 68 | <2 | 128 | 88 |

| GPT-5.1 Codex Max Extra High | 82 | 3-4 | 384 | 95 |

| GPT-5.1 Codex Max Medium Fast | 70 | 1.2 | 192 | 87 |

| GPT-5.1 Codex Max High Fast | 74 | 1 | 256 | 91 |

| GPT-5.1 Codex Max Low Fast | 65 | <1 | 96 | 84 |

| GPT-5.1 Codex Max Extra High Fast | 80 | 2 | 384 | 93 |

| GPT-5.1 Codex | 70 | 2 | 256 | 89 |

| GPT-5.1 Codex High | 73 | 1.8 | 192 | 88 |

| GPT-5.1 Codex Fast | 60 | 1 | 128 | 82 |

| GPT-5.1 Codex High Fast | 72 | 1.2 | 192 | 87 |

| GPT-5.1 Codex Low | 67 | 1.5 | 96 | 85 |

| GPT-5.1 Codex Low Fast | 62 | <1 | 96 | 80 |

| GPT-5.1 Codex Mini High | 65 | 0.8 | 128 | 83 |

| GPT-5.1 Codex Mini Low | 58 | <0.8 | 64 | 78 |

Estas cifras provienen de las pruebas de arnés de Cursor, que simulan interacciones reales en el IDE. Observe cómo las variantes Max dominan las tasas de éxito, mientras que los sufijos Fast sobresalen en latencia.

Además, considere la eficiencia energética: los modelos Low y Mini consumen un 40% menos de energía, según los informes de OpenAI. Para proyectos centrados en API, la eficacia de la herramienta impacta directamente en la calidad de la integración; puntuaciones más altas significan menos ajustes manuales al exportar a Apidog.

Desglose de Benchmarks: Perspectivas de Rendimiento en el Mundo Real

Los benchmarks proporcionan evidencia concreta. Cursor Bench, una suite interna, prueba más de 500 tareas en lenguajes como Python, JavaScript y Rust. GPT-5.1 Codex Max lidera con un 78% de resolución, particularmente en cadenas de agentes que involucran más de 10 llamadas a herramientas. Resuelve errores de linter el 92% de las veces, gracias a la integración dedicada de `read_lints`.

Las variantes GPT-5.1 Codex Mini Fast priorizan el rendimiento. En una "sprint" de 100 tareas que simula una semana de sprint, Mini completa un 85% más de iteraciones que Max, aunque con un 20% menos de precisión en refactorizaciones matizadas.

SWE-bench Verified, una métrica estandarizada, muestra que la familia promedia un 65% —un salto del 25% desde GPT-4.1. Los modelos Extra High alcanzan un pico del 82%, pero su latencia los descalifica para la programación en pareja en vivo.

Pasando a los casos de uso, los modelos de alto contexto como Max Extra High prosperan en monorepos, navegando por más de 50 archivos sin esfuerzo. Para desarrolladores individuales, Medium Fast logra el equilibrio óptimo.

Casos de Uso: Emparejando Modelos con las Necesidades del Desarrollador

Seleccione su modelo Cursor Codex basándose en las demandas del flujo de trabajo. Para el desarrollo de API de pila completa, GPT-5.1 Codex Max High Fast genera puntos finales seguros y escalables rápidamente. Crea resolvers de GraphQL y luego utiliza herramientas de shell para probarlos con mocks; agilice esto con el validador de esquemas de Apidog para una confianza de extremo a extremo.

En la codificación de sistemas embebidos, GPT-5.1 Codex Low favorece la eficiencia, generando fragmentos de C++ que se ajustan a entornos restringidos. Los pipelines de aprendizaje automático se benefician de la planificación probabilística de Max Extra High, optimizando los flujos de tensores con un mínimo de prueba y error.

Para entornos colaborativos, las variantes Fast permiten sugerencias en tiempo real, fomentando la sinergia del equipo. Siempre monitoree el uso de tokens; exceder los límites activa fallbacks, reduciendo la eficacia en un 15%.

Además, los enfoques híbridos funcionan bien: comience con Mini para la ideación, y escale a Max para la implementación. Esta estrategia maximiza el retorno de la inversión en presupuestos de cómputo.

Consejos de Optimización: Mejorando Cursor Codex con Apidog

Para amplificar el rendimiento de GPT-5.1 Codex, ajuste su arnés. Habilite los rastros de razonamiento en la configuración; esto mejora la continuidad, elevando el éxito en un 30% según la documentación de Cursor. Prefiera las llamadas a herramientas sobre el shell en bruto: las indicaciones como "Use read_file antes de editar" guían al modelo.

Incorpore Apidog para flujos de trabajo de API. Codex genera código repetitivo; Apidog lo prueba instantáneamente. Exporte las especificaciones como YAML, simule respuestas y automatice la documentación, reduciendo el tiempo de integración en un 50%.

Perfile las latencias con las métricas integradas de Cursor. Si surgen cuellos de botella, cambie a las variantes Low. Actualice regularmente el arnés para obtener parches, ya que OpenAI itera con frecuencia.

La seguridad también importa: Sanitize las salidas de las herramientas para prevenir riesgos de inyección. Para producción, audite las ediciones de Codex mediante revisiones de diferencias.

Conclusión: GPT-5.1 Codex Max Emerge como el Mejor en General

Después de analizar las especificaciones, benchmarks y aplicaciones, GPT-5.1 Codex Max ocupa el primer puesto. Su inigualable tasa de éxito del 78%, su robusto contexto de 512K y su versátil conjunto de herramientas lo hacen indispensable para la codificación seria. Si bien los modelos Fast ganan en velocidad y Mini en accesibilidad, Max ofrece una excelencia holística, empoderando a los desarrolladores para abordar proyectos ambiciosos de frente.

Experimente con Cursor hoy y añada Apidog para una gestión integral de API. Su elección moldea la productividad; opte por Max para asegurar su stack de cara al futuro.