El desarrollo de software moderno se enfrenta a un desafío crítico: crear casos de prueba exhaustivos que realmente detecten errores antes de que lleguen a producción. Los enfoques de prueba tradicionales a menudo se quedan cortos, dejando a los equipos luchando por solucionar problemas después del despliegue. Sin embargo, la inteligencia artificial ofrece ahora una solución poderosa que transforma la forma en que abordamos la creación y ejecución de casos de prueba.

Comprendiendo la Generación de Casos de Prueba Impulsada por IA

La inteligencia artificial aporta capacidades sin precedentes a las pruebas de software. Los algoritmos de aprendizaje automático analizan patrones de código, comportamiento del usuario y datos históricos de errores para generar casos de prueba que los probadores humanos podrían pasar por alto. Esta tecnología no reemplaza la experiencia humana, sino que la amplifica, creando una cobertura más exhaustiva con menos esfuerzo manual.

Los sistemas de IA sobresalen en el reconocimiento de patrones y pueden identificar posibles puntos de fallo examinando la estructura del código, los puntos finales de la API y los flujos de datos. Estos sistemas aprenden de ciclos de prueba anteriores, mejorando continuamente su capacidad para predecir dónde podrían ocurrir problemas. En consecuencia, los equipos logran una mejor cobertura de pruebas al tiempo que reducen el tiempo dedicado a tareas de prueba repetitivas.

Beneficios de la IA en el Desarrollo de Casos de Prueba

Cobertura de Pruebas Mejorada

Los algoritmos de IA analizan sistemáticamente los componentes de software para identificar brechas en las pruebas. Las pruebas manuales tradicionales a menudo pasan por alto casos extremos debido a limitaciones humanas y restricciones de tiempo. En contraste, los sistemas impulsados por IA examinan cada ruta de código posible, generando casos de prueba para escenarios que los desarrolladores podrían no considerar.

Los modelos de aprendizaje automático estudian los patrones de comportamiento de las aplicaciones y crean casos de prueba que cubren tanto casos de uso comunes como condiciones extremas inusuales. Este enfoque integral reduce significativamente la probabilidad de que los errores lleguen a los entornos de producción.

Ciclos de Prueba Acelerados

La velocidad se vuelve crucial en los flujos de trabajo de desarrollo modernos. La IA reduce drásticamente el tiempo necesario para crear y ejecutar casos de prueba. Mientras que los probadores humanos podrían pasar horas escribiendo suites de prueba exhaustivas, los sistemas de IA generan cientos de casos de prueba en minutos.

Además, los sistemas de IA actualizan automáticamente los casos de prueba cuando se producen cambios en el código. Esta adaptación dinámica garantiza que las suites de prueba sigan siendo relevantes y efectivas a lo largo del ciclo de vida del desarrollo, eliminando la necesidad de mantenimiento manual de las pruebas.

Calidad de Prueba Mejorada

Los casos de prueba generados por IA a menudo demuestran una mayor calidad que los creados manualmente. Los algoritmos de aprendizaje automático analizan grandes cantidades de datos de prueba para identificar las estrategias de prueba más efectivas. Estos sistemas aprenden de casos de prueba exitosos e incorporan patrones probados en la generación de nuevas pruebas.

Además, la IA elimina los errores humanos que comúnmente ocurren en la creación manual de pruebas. La consistencia mejora en todos los casos de prueba, asegurando que los estándares de prueba permanezcan uniformes en todo el proyecto.

Herramientas Clave de IA para la Generación de Casos de Prueba

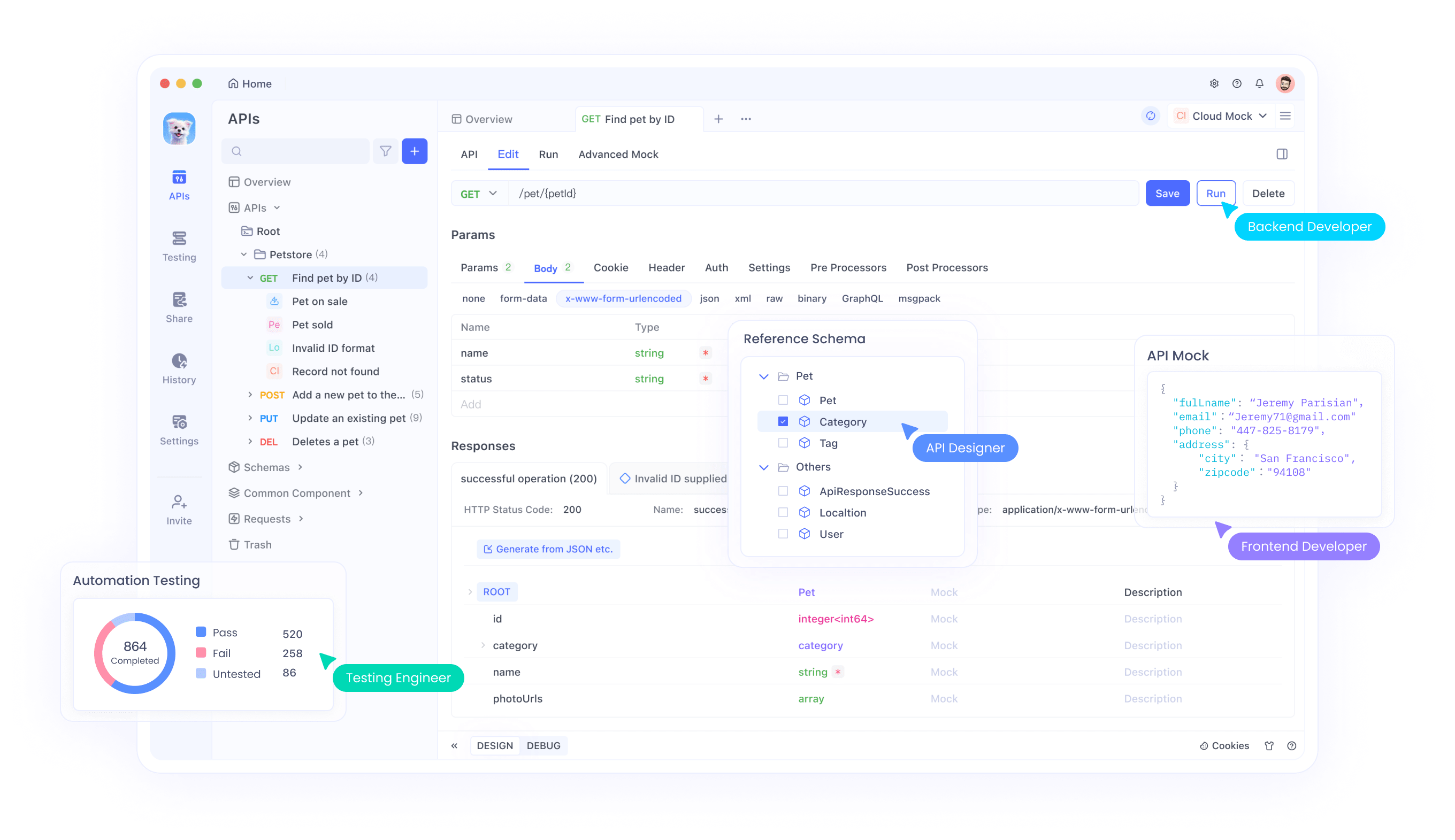

Apidog: Plataforma Integral de Pruebas de API

Apidog representa una solución líder en pruebas de API impulsadas por IA. Esta plataforma combina la generación inteligente de casos de prueba con sólidas capacidades de ejecución. Los usuarios pueden generar automáticamente casos de prueba a partir de especificaciones de API, reduciendo el esfuerzo manual y garantizando una cobertura exhaustiva.

El motor de IA de la plataforma analiza la documentación de la API y crea automáticamente escenarios de prueba que validan la funcionalidad, el rendimiento y la seguridad. Las capacidades de aprendizaje automático de Apidog mejoran continuamente la calidad de los casos de prueba basándose en los resultados de ejecución y los comentarios de los usuarios.

Herramientas de Procesamiento de Lenguaje Natural

Varias herramientas de IA aprovechan el procesamiento de lenguaje natural para convertir los requisitos en casos de prueba ejecutables. Estos sistemas analizan historias de usuario, criterios de aceptación y documentación para generar suites de prueba exhaustivas.

Las herramientas impulsadas por PNL (Procesamiento de Lenguaje Natural) comprenden el contexto y la intención, creando casos de prueba que se alinean con los requisitos del negocio. Este enfoque cierra la brecha entre las partes interesadas del negocio y los equipos técnicos, asegurando que las pruebas validen las necesidades reales del usuario.

Marcos de Pruebas de Aprendizaje Automático

Los marcos avanzados integran algoritmos de aprendizaje automático directamente en los flujos de trabajo de prueba. Estas herramientas analizan el comportamiento de la aplicación, identifican patrones y generan casos de prueba que se adaptan a los requisitos cambiantes del software.

Los marcos de ML (Aprendizaje Automático) sobresalen en las pruebas de regresión, generando automáticamente casos de prueba que verifican que los nuevos cambios de código no rompan la funcionalidad existente. Esta capacidad resulta particularmente valiosa en entornos de integración continua.

Estrategias de Implementación para Pruebas de IA

Configuración de Entornos de Pruebas Impulsados por IA

La implementación exitosa de pruebas de IA requiere una planificación y configuración cuidadosas. Los equipos deben primero evaluar su infraestructura de pruebas actual e identificar áreas donde la IA puede proporcionar el mayor valor. Esta evaluación debe considerar las herramientas existentes, la experiencia del equipo y los requisitos del proyecto.La integración con las herramientas de desarrollo existentes se vuelve crucial para una adopción sin problemas. Las plataformas de pruebas de IA deben conectarse con sistemas de control de versiones, pipelines de integración continua y herramientas de gestión de proyectos. Esta integración garantiza que los casos de prueba generados por IA se ajusten naturalmente a los flujos de trabajo establecidos.

Entrenamiento de Modelos de IA para tus Necesidades Específicas

Los sistemas de IA requieren datos de entrenamiento para generar casos de prueba efectivos. Los equipos deben proporcionar datos históricos de pruebas, informes de errores y repositorios de código para entrenar los modelos de IA. Este proceso de entrenamiento ayuda a los sistemas de IA a comprender los patrones y requisitos específicos del proyecto.

Las actualizaciones regulares del modelo aseguran que los sistemas de IA se mantengan al día con las bases de código en evolución y los requisitos comerciales cambiantes. Los equipos deben establecer procesos para alimentar nuevos datos a los sistemas de IA, permitiendo una mejora continua en la calidad de los casos de prueba.Establecimiento de Puertas de Calidad

Los casos de prueba generados por IA requieren validación antes de su ejecución. Los equipos deben implementar procesos de revisión que combinen la eficiencia de la IA con la experiencia humana. Este enfoque híbrido garantiza que los casos de prueba generados cumplan con los estándares de calidad mientras se mantienen los beneficios de velocidad de la generación por IA.

Las puertas de calidad deben incluir la validación automatizada de la sintaxis de los casos de prueba, la verificación lógica y la alineación con los requisitos del negocio. Estos puntos de control evitan que los casos de prueba de baja calidad entren en el pipeline de ejecución.

Mejores Prácticas para el Desarrollo de Casos de Prueba con IA

Combinando la IA con la Experiencia Humana

Las estrategias de prueba más efectivas combinan las capacidades de la IA con la perspicacia humana. Los sistemas de IA sobresalen en la generación de casos de prueba exhaustivos, mientras que los probadores humanos aportan contexto, creatividad y conocimiento del dominio.

Los equipos deben establecer roles claros donde la IA se encargue de las tareas repetitivas de generación de pruebas, y los humanos se centren en escenarios complejos, pruebas exploratorias y el desarrollo de la estrategia de pruebas. Esta división del trabajo maximiza las fortalezas tanto de la IA como de los probadores humanos.

Manteniendo la Relevancia de los Casos de Prueba

Los casos de prueba generados por IA requieren un mantenimiento continuo para seguir siendo efectivos. Los equipos deben revisar y actualizar regularmente los casos de prueba basándose en los cambios de la aplicación, los comentarios de los usuarios y los patrones de descubrimiento de errores.

Los sistemas automatizados de gestión de casos de prueba pueden ayudar a mantener la relevancia mediante el seguimiento de los resultados de la ejecución de pruebas y la identificación de casos de prueba obsoletos o redundantes. Este mantenimiento continuo asegura que las suites de prueba sigan aportando valor con el tiempo.

Monitoreo y Optimización

El monitoreo continuo del rendimiento de las pruebas de IA permite la optimización y mejora. Los equipos deben rastrear métricas como la cobertura de pruebas, las tasas de detección de errores y las tasas de falsos positivos para evaluar la efectividad de la IA.

El análisis regular de estas métricas ayuda a identificar áreas de mejora y guía los ajustes a los algoritmos de IA y los datos de entrenamiento. Este enfoque iterativo asegura que los sistemas de pruebas de IA evolucionen y mejoren continuamente.

Desafíos Comunes y Soluciones

Problemas de Calidad de Datos

Los sistemas de IA dependen de datos de entrenamiento de alta calidad para generar casos de prueba efectivos. La mala calidad de los datos conduce a casos de prueba ineficaces que no detectan errores o generan falsos positivos. Los equipos deben invertir en procesos de limpieza y validación de datos para asegurar que los sistemas de IA reciban datos de entrenamiento precisos.Las soluciones incluyen la implementación de pipelines de validación de datos, el establecimiento de estándares de calidad de datos y la auditoría regular de los conjuntos de datos de entrenamiento. Estas medidas ayudan a mantener la calidad de los casos de prueba generados por IA.

Complejidad de la Integración

La integración de herramientas de pruebas de IA con los flujos de trabajo de desarrollo existentes puede presentar desafíos técnicos. Los sistemas heredados pueden carecer de las API o los puntos de integración necesarios para la conectividad de las herramientas de IA.

Los equipos deben evaluar los requisitos de integración al principio del proceso de selección y elegir herramientas de IA que se alineen con su infraestructura técnica. Los enfoques de implementación gradual pueden ayudar a minimizar las interrupciones al tiempo que permiten a los equipos adaptarse a nuevos flujos de trabajo.

Gestión de la Brecha de Habilidades

Las herramientas de pruebas de IA requieren nuevas habilidades y conocimientos que muchos equipos pueden no poseer. Las organizaciones deben invertir en capacitación y desarrollo de habilidades para maximizar los beneficios de las pruebas impulsadas por IA.

Los programas de capacitación deben cubrir el uso de herramientas de IA, los procesos de revisión de casos de prueba y la gestión de modelos de IA. Además, los equipos deben establecer prácticas de intercambio de conocimientos para distribuir la experiencia en pruebas de IA en toda la organización.

Midiendo el Éxito con las Pruebas de IA

Indicadores Clave de Rendimiento

La medición efectiva requiere KPIs claros que demuestren el valor de las pruebas de IA. Las métricas importantes incluyen el porcentaje de cobertura de pruebas, las tasas de detección de errores, el tiempo del ciclo de pruebas y el costo por caso de prueba.

Los equipos deben establecer mediciones de referencia antes de la implementación de la IA para evaluar con precisión la mejora. La medición y el informe regulares ayudan a demostrar el ROI y a guiar futuras inversiones en pruebas de IA.

Cálculo del ROI

El cálculo del retorno de la inversión (ROI) para las pruebas de IA implica medir el ahorro de costos por la reducción del esfuerzo de pruebas manuales, la mejora en la detección de errores y ciclos de lanzamiento más rápidos.

Los cálculos de ahorro de costos deben incluir la reducción del tiempo del personal de pruebas, la disminución de los costos de corrección de errores y la mejora de la satisfacción del cliente a partir de lanzamientos de mayor calidad. Estos cálculos completos de ROI ayudan a justificar las inversiones en pruebas de IA y a guiar las decisiones de expansión.

Tendencias Futuras en las Pruebas de IA

Integración Avanzada de Aprendizaje Automático

Las futuras herramientas de pruebas de IA incorporarán algoritmos de aprendizaje automático más sofisticados que proporcionarán conocimientos más profundos sobre el comportamiento del software. Estos sistemas predecirán posibles puntos de fallo con mayor precisión y generarán casos de prueba más específicos.

Los avances en el aprendizaje profundo y las redes neuronales permitirán a los sistemas de IA comprender interacciones de software complejas y generar casos de prueba que validen el comportamiento de todo el sistema en lugar de solo componentes individuales.Sistemas de Pruebas Autónomas

El futuro promete sistemas de pruebas completamente autónomos que requieran una intervención humana mínima. Estos sistemas generarán, ejecutarán y mantendrán automáticamente los casos de prueba, adaptándose continuamente a los cambios del software.

Las pruebas autónomas permitirán la validación continua a lo largo del ciclo de vida del desarrollo, proporcionando retroalimentación inmediata sobre la calidad y funcionalidad del código. Esta capacidad de prueba en tiempo real revolucionará la forma en que los equipos abordan la garantía de calidad del software.

Conclusión

La generación de casos de prueba impulsada por IA representa un cambio fundamental en los enfoques de pruebas de software. Al aprovechar los algoritmos de aprendizaje automático y la automatización inteligente, los equipos pueden lograr una mejor cobertura de pruebas, ciclos de prueba más rápidos y una calidad de software mejorada.

El éxito con las pruebas de IA requiere una implementación cuidadosa, una optimización continua y la combinación adecuada de capacidades de IA con experiencia humana. Los equipos que adopten estas tecnologías, manteniendo el enfoque en la calidad y las necesidades del usuario, obtendrán ventajas competitivas significativas en el desarrollo de software.

El futuro de las pruebas de software reside en la combinación inteligente de la automatización de IA y la creatividad humana. Las organizaciones que inviertan hoy en capacidades de pruebas de IA estarán mejor posicionadas para entregar software de alta calidad en un mercado cada vez más competitivo.